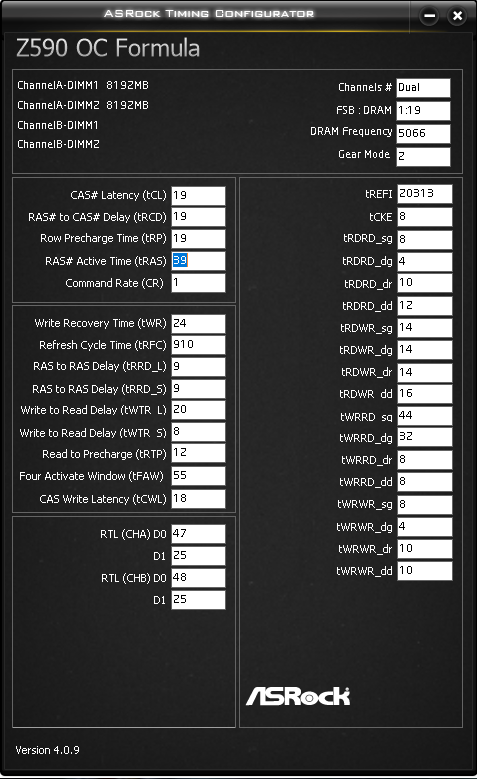

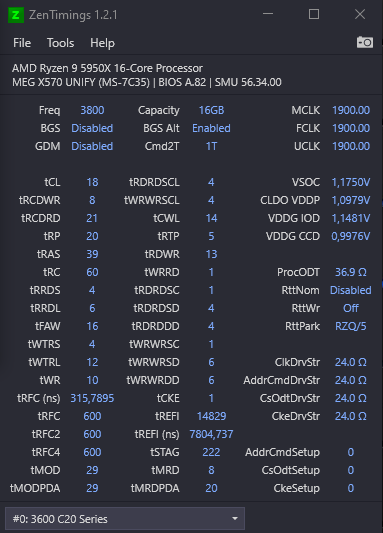

Vertrauen ist gut, Kontrolle ist besser – Asrock Timing Configurator (Intel) / Zentimings (AMD)

Wie bei jedem OC ist es wichtig zu überprüfen, ob die geänderten Einstellungen auch tatsächlich übernommen wurden und ob es keine unvorhergesehenen Wechselwirkungen mit anderen Einstellungen gibt, zumal viele Boards heutzutage über eingebaute Recovery-Funktionen verfügen, die nach mehreren erfolglosen Speichertrainingsversuchen anspringen. Aus diesem Grund ist es unabdingbar, ein Tool zu verwenden, das alle Speichertimings in einem Zustand ausliest, in dem der PC vollständig gebootet und das OS geladen ist. Die besten Tools für diese Aufgabe sind der ASRock Timing Configurator (AsrTC), der für alle Mainboards einer bestimmten CPU-Generation auf Intel funktioniert, und Zentimings für AMD Ryzen basierte Systeme.

Der AsrTC ist eigentlich gar kein Tool, um die Timings zu konfigurieren, d.h. sie in Echtzeit zu ändern, während das System läuft. Stattdessen liest es die Timings nur aus und stellt sie auf einer Seite recht übersichtlich dar, was auch besonders praktisch für Screenshots ist. Es kann sein, dass man spezielle Versionen des Tools für bestimmte CPU-Generationen und Mainboards suchen muss, wie z.B. 4.0.9 für Z590, 4.0.3 für Z490 usw., wenn man kein ASRock-Board hast, bei dem die Software mitgeliefert wird. Auch wenn es ein wenig Zeit und Recherche braucht, um die richtige Version zu finden, ist dieses Tool definitiv sehr praktisch und sehr empfehlenswert für RAM OC auf Intel Plattformen.

AMD Ryzen-Besitzer haben es etwas einfacher, da Zentimings ein herstellerunabhängiges Tool ist, das in der Regel auf jedem Ryzen-Mainboard und jeder CPU funktioniert, wenn man nur die neueste verfügbare Version verwendet. Neben den Speichertimings zeigt das Tool auch einige weitere Parameter wie Spannungen und Widerstände an, von denen die meisten ebenfalls angepasst werden müssen, um das Setup zu optimieren.

Eine lobende Erwähnung geht auch an MemTweakIt, ein Tool von Asus, mit dem man die meisten Speichertimings in Echtzeit ändern kann! Ja, man kannst die Timings ändern, während das System läuft und die Auswirkungen während eines Stabilitätstests beobachten. Allerdings funktioniert dies nur auf Intel-Plattformen und eine kompatible Version für ein jeweiliges Mainboard zu finden ist eine Herausforderung für sich, sogar wenn es sich um ein Asus-Mainboard handelt.

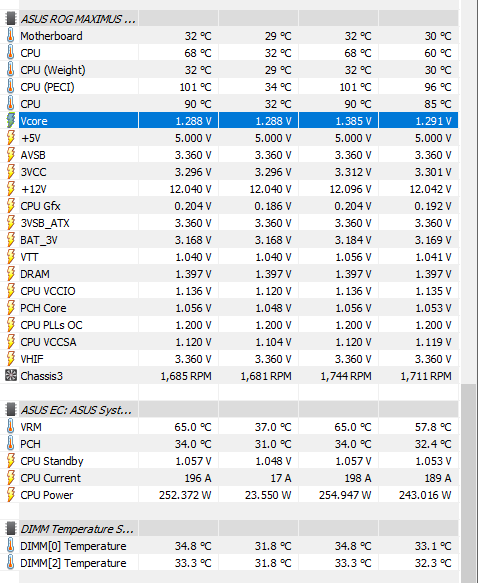

Spannungen und Temperaturen – Hwinfo

Da Spannungen und Temperaturen ebenfalls wichtige Parameter für jede Übertaktung sind, ist es natürlich wichtig, auch diese zu überwachen. Vor allem, wenn man nicht auf der AMD-Plattform ist, wo Zentimings bereits die meisten für den Speicher wichtigen Spannungen ausliest, kann HWinfo sehr nützlich sein. Interessant ist hier oft, welche Spannungs-Werte das Mainboard mit „Auto“-Einstellungen gewählt hat oder ob die manuellen Einstellungen auch tatsächlich übernommen wurden. Neben der eigentlichen RAM-Spannung, auch bekannt als DRAM Voltage oder Vdimm, sind auch andere Spannungen von Bedeutung, wie z.B. die SOC Voltage bei AMD oder die SA Voltage bei Intel, von der der IMC der CPU ausgeht, sowie unterstützende Spannungen wie VDDG bei AMD oder IO Mem (IO 2) bei Intel.

Da diese Spannungen plattform- und oft auch generationsspezifisch sind, ist es schwer, hier konkrete Empfehlungen für sichere Spannungswerte zu geben, so dass auch hier wieder ein wenig eigene Recherche von jedem gefragt ist. In jedem Fall ist es aber wichtig, die Spannungen zu überwachen, während das System läuft, um sicherzustellen, dass die Einstellungen auch tatsächlich angewendet werden oder, falls man sie auf Auto belassen hat, worauf sie gesetzt wurden. Einige BIOS haben auch eine integrierte Auslesefunktion für Auto-Spannungen, die hierfür ebenfalls nützlich sein kann.

Die Temperatur der RAM-Sticks kann auch einen Einfluss auf die Stabilität haben, besonders bei höheren Spannungen. Das kann deutlich werden, wenn der RAM OC stabil ist, wenn man nur den Speicher selbst testet, aber nach ein paar Minuten Spielbetrieb instabil wird, weil die GPU und CPU Wärme in das Gehäuse abgeben und so den Speicher indirekt aufheizen. Für die Stabilität ist es also wichtig, auf eine repräsentative Art und Weise zu testen, die tatsächlich dem späteren Anwendungsfall entspricht.

Einige Speichermodule haben sogar eingebaute Temperatursensoren, die in HWinfo angezeigt werden und die Diagnose von hitzebedingter Instabilität erheblich erleichtern können. Wenn man Module ohne Temperatursensor hat und einer vermeintlichen Temperatur-bedingten Instabilität auf den Grund gehen möchte, hilft nur ein externer Temperatursensor. Da hitzebedingte Instabilitäten ein häufiges Problem sind, weisen wir in unseren Testberichten immer darauf hin, ob das getestete Kit über eingebaute Sensoren verfügt und machen dem Hersteller den Vorschlag, solche Sensoren hinzuzufügen, insbesondere wenn es sich um ein auf Übertaktung ausgerichtetes Kit handelt.

Leistungstest – ist es tatsächlich schneller?

Wie bereits erwähnt, sollte man die Leistung vor, während und nach dem Speicher-OC überprüfen. Ich mache das gerne an bestimmten „Checkpoints“, also Zuständen von Speichereinstellungen, von denen ich weiß, dass sie reproduzierbar stabil sind. Hier sind die Benchmarks, die ich erfahrungsgemäß hierfür gerne verwende:

- Aida64 Cache und Memory Benchmark: Synthetisch, aber schneller Test um etwaige größere Probleme zu finden , z.B. wenn die Lese- oder Schreibperformance plötzlich stark abgenommen haben, meist verursacht durch Auto-Tertiäre.

- Geekbench 3 Multicore Memory Score: Mittelweg zwischen synthetisch und real-world. Berechnet gewichteten Performance-Score, der die Taktrate und Latenz berücksichtigt. Nützlich als eine einzige Metrik, um verschiedene Speicher-Setups einer Plattform miteinander zu vergleichen.

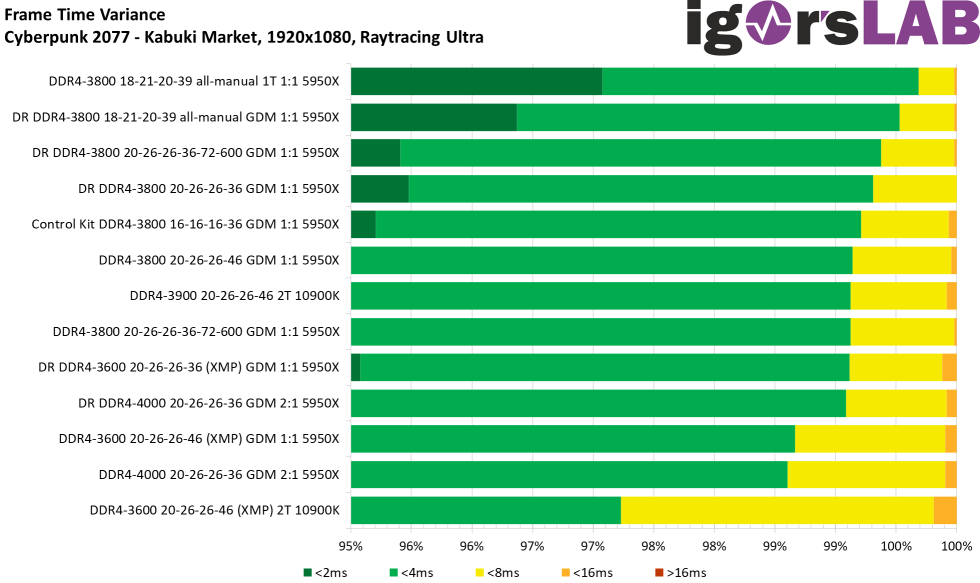

- Spiele-/Anwendungsleistung: Wie bereits erwähnt, ist der repräsentativste Anwendungsfall zum Testen ein tatsächlicher Anwendungsfall. Wir verwenden hier gerne einen bestimmten Gameplay-Abschnitt in Cyberpunk 2077, von dem wir wissen, dass er empfindlich auf die Speicher-Performance reagiert. Durch die mit Nvidia Frameview aufgezeichneten FPS und Frametimes können wir dann verschiedene Speicher-Setups miteinander vergleichen. Dieses Spiel hat auch die nützliche Eigenart, dass es sehr leicht beim Laden eines Savegames abstürzt, wenn dein Speicher nur ein wenig instabil ist, also dient er indirekt auch als Stabilitäts-Stichprobe.

Natürlich gibt es auch eine Menge anderer Spiele, einige mit eingebauten Benchmarks, wie Shadow of the Tomb Raider, die sich als nützliche Metriken für die Speicherleistung etabliert haben. Wenn man vorhat, sein System für Arbeiten wie Rendering zu nutzen, kann der Vergleich der Exportzeit eines Projekts auch eine nützliche Benchmark-Metrik sein. Es kommt wirklich darauf an, für was man sein System optimieren will.

Stabilitätstests – 1 Fehler ist 1 zu viel

Um die Stabilität einer RAM-Übertaktung zu testen, gibt es eine Menge verschiedener Tools, die diese Aufgabe übernehmen. Grundsätzlich ist die Funktionsweise immer gleich, da sie versuchen, alle verschiedenen Kombinationen von Lese-, Schreib- und Kopierbefehlssequenzen in den Speicher abzudecken, um sicherzustellen, dass das System in allen Fällen stabil ist. Da buchstäblich jede Kombination für jedes Stückchen Speicher getestet werden muss, steigt die für den Test benötigte Zeit proportional mit der Größe des Systemspeichers und sinkt mit der Geschwindigkeit, mit der der Speicher läuft. Viel, langsamer Arbeitsspeicher braucht also viel Zeit zum Testen, wenig, schneller Arbeitsspeicher ist viel schneller zu testen, eigentlich intuitiv.

Alle der folgenden Tools haben ihre Vor- und Nachteile, vor allem in der Benutzerfreundlichkeit und ob sie kostenlos sind oder gekauft werden müssen.

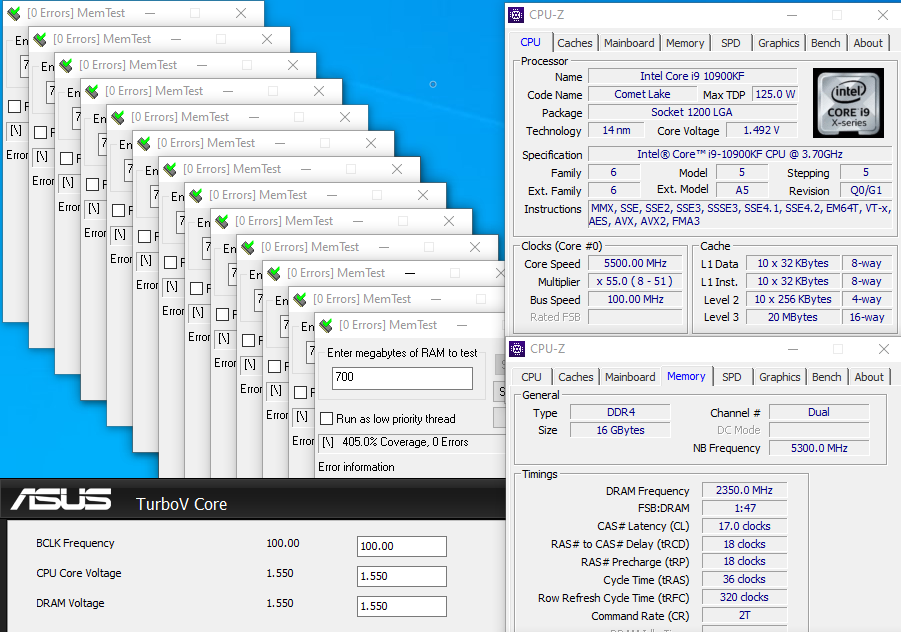

- HCI Memtest: Kostenlose Version verfügbar, kann aber nur 2000 MB pro Instanz testen. Automatisches oder Batch-Starten von mehreren Instanzen ist nur in der kostenpflichtigen Pro-Version verfügbar. Eine Abdeckung von 400 % wird als stabil angesehen.

- Karhu Memtest: Nur als kostenpflichtige Version verfügbar, aber sehr einfach und leicht zu bedienen, kann den gesamten Systemspeicher auf einmal testen. Eine Abdeckung von 4000 % wird als stabil angesehen.

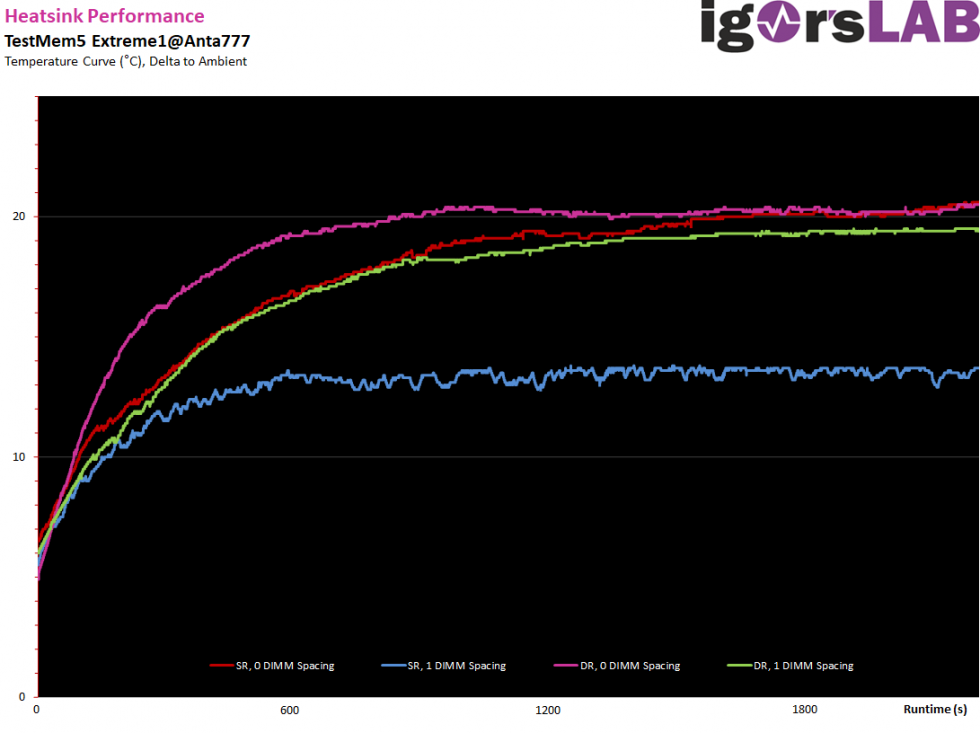

- TestMem5 (TM5): Kostenlos, aber umständlich in der Bedienung, kann aber den gesamten Systemspeicher auf einmal testen. Hat auch Unterstützung für verschiedene Testprofile. Wir verwenden das Profil „Extreme1@Anta777“ für RAM-Tests und sehen einen kompletten Durchlauf, bestehend aus 3 Zyklen, als stabil an.

- Google Stress App Test (GSAT): Kostenlos, benötigt Windows Subsystem für Linux auf Windows-Systemen, läuft nativ unter Linux oder mit einer Live-DVD. Kann auch andere Teile des Systems auf Stabilität testen. Ein „warmer“ Lauf mit 3600 Sekunden Dauer (1 Stunde) pro 16 GB RAM wird als stabil angesehen.

Wenn andere Teile des Systems übertaktet sind, wie z.B. die CPU, Infinity Fabric, Cache etc. kann deren Instabilität einen Einfluss auf die Stabilität des Speichers haben. Bevor man also die Stabilität des Arbeitsspeichers überprüft, solltest man sich sicher sein, dass auch alle anderen Komponenten stabil sind. Auch wenn dies den Rahmen dieses Leitfadens sprengen würde, sind gängige Tools zum gemeinsamen Testen von CPU, Cache und Speicher LinX bzw. LinpackXtreme oder Prime95 mit Einstellungen, die den gesamten oder einen Großteil des Systemspeichers belegen.

Aber zurück zu unserem RAM-OC. Um die Stabilität zu überprüfen, startet man einfach eines der genannten Programm und lässt es so lange laufen, bis es sein Ende oder einen „als stabil angesehenen“ Fortschritt erreicht hat. Wenn keine Fehler aufgetreten sind, ist die Speicherübertaktung stabil, super! Wenn jedoch nur 1 einziger Fehler aufgetreten ist, ist die Speicherübertaktung als instabil anzusehen und die Einstellungen müssen angepasst werden. Je nachdem, wann und wie viele Fehler aufgetreten sind, kann man ggf. ableiten, welche Einstellungen geändert werden müssen. Aber unter keinen Umständen sollte man sein tägliches Betriebssystem oder irgendeine wichtige Datenverarbeitung mit einem Speicher-Setup laufen lassen, das in Stabilitätstest auch nur 1 Fehler pro Durchlauf wirft.

Das bedeutet, dass man zurück ans metaphorische Zeichenbrett gehen und die Speichereinstellungen anpassen muss, bis man ein Setup gefunden hast, das einen Stresstest in einem als stabil angesehenen Zustand beendet. Für den abschließenden Stabilitätstest empfehle ich daher auch, Stresstests mit zwei verschiedenen Tools durchzuführen, um auf absolute Nummer sicher zu gehen. So würde ich zum Beispiel wollen, dass mein System einen Lauf von TM5 mit Extreme1@Anta777 und dann 400% mit HCI memtest mit 0 Fehlern besteht, bevor ich es als sicher für den täglichen Gebrauch betrachte. Klingt vielleicht ein bisschen paranoid, aber wenn man darüber nachdenkt, kann ein System nie zu stabil sein.

63 Antworten

Kommentar

Lade neue Kommentare

Urgestein

Veteran

Urgestein

Mitglied

Urgestein

Urgestein

Urgestein

Mitglied

Veteran

Urgestein

Mitglied

Urgestein

Mitglied

Urgestein

Urgestein

Urgestein

Urgestein

Mitglied

Veteran

Alle Kommentare lesen unter igor´sLAB Community →