Ein interessanter Videovergleich zwischen zwei Grafikkarten unter 250 Dollar, der Intel Arc A750 und der Radeon RX 6600 non-XT von AMD, wurde von Techtesters veröffentlicht. Beide Varianten sind natürlich keine High-End-Gaming-Karten, aber für viele Gamer da draußen ist das immer noch eine vernünftige Option.

Mit der jüngst angekündigten Preissenkung für die Arc A750 auf 249 US-Dollar sieht Intels Option jetzt noch besser aus, besonders wenn man bedenkt, dass diese relativ neue Architektur erst im letzten Jahr ihr Debüt feierte. Die Arc A750 basiert auf Intels bester Alchemist ACM-G10 GPU, die jedoch auf 28 von 32 verfügbaren Xe-Cores reduziert wurde. Trotzdem bieten beide Karten eine ähnliche Anzahl an GPU-Kernen (Radeon hat 28 Compute Units), aber Arc hat mehr FP32-Kerne (3584 vs. 1792). Darüber hinaus haben beide GPUs die gleiche Speicherkapazität von 8 GB GDDR6, aber Arc hat einen doppelt so breiten Speicherbus. In diesem Vergleich sind die Zahlen auf der Seite von Intel, aber nicht in allen Fällen. Die A750 hat nur einen großen Nachteil: eine TBP von 225W, die weit über dem Wert der RX 6600 von 132W liegt. Aber dazu später mehr.

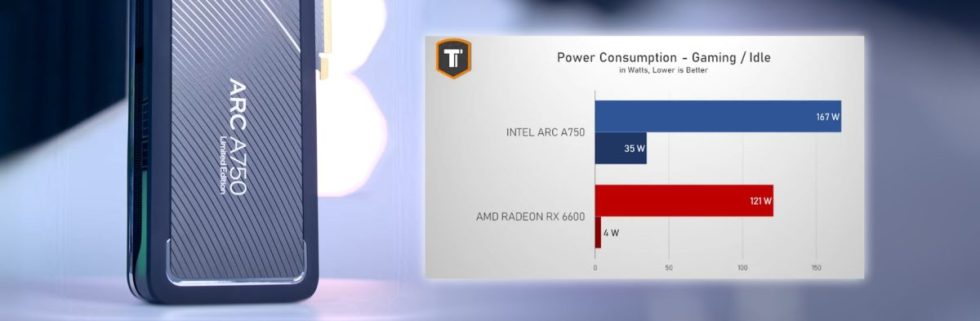

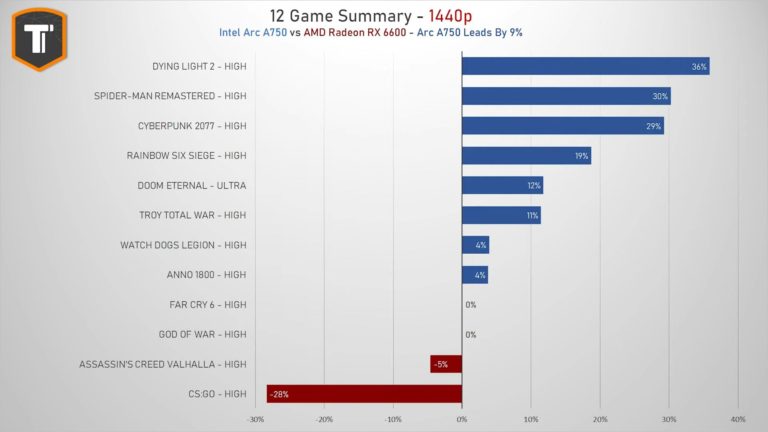

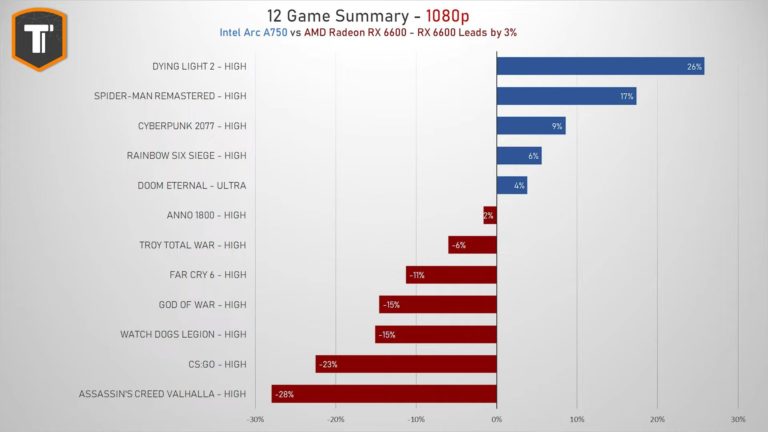

Techtesters haben beide Karten bei 1080p- und 1440p-Auflösungen mit Spieleinstellungen auf hoch oder ultra in die Schlacht geworfen. Die Ergebnisse wurden mit den neuesten Treibern und auf einer modernen Ryzen 5 7600X-Plattform ermittelt. Bei 1080p war die A750 Limited Edition im Durchschnitt etwa 3 % langsamer als die Radeon RX 6600 von Gigabyte (nicht übertaktet), aber die höhere Speicherbandbreite von Arc zeigt ihre Stärke bei der 1440p-Auflösung, wo Intel im Durchschnitt um 9 % führt. Beim Spielen verbraucht die Intel A750 167W, was nicht so schlimm ist wie der offizielle TDP-Wert von 225W, aber immer noch höher als die 121W der RX 6600, die von Techtesters gemessen wurden. Allerdings hat Arc immer noch ein Problem mit dem Stromverbrauch im Leerlauf mit 35W, also fast 9 mal höher als Radeon.

Ein sehr interessanter Ansatz von Techtesters ist die Darstellung der langfristigen GPU-Nutzung und ihrer Kosten. Dabei wird auch die Zeit berücksichtigt, in der der Grafikprozessor tatsächlich nicht genutzt wird. Abhängig von den Energiekosten kann dies ein entscheidender Faktor bei der Entscheidung für einen neuen Grafikprozessor sein, insbesondere für diejenigen, die in Europa leben, wo die Energiekosten höher sind. Die Kosten für die Nutzung der A750 könnten sich in 4 Jahren verdoppeln, wenn die Karte 2 Stunden pro Tag zum Spielen und 8 Stunden im Leerlauf genutzt wird und die Energiekosten 50 Cent pro kWh betragen. Intel ist sich des Problems der Leerlaufleistung der Arc Alchemist-GPUs bewusst. Das Unternehmen hat eine Lösung vorgestellt, die Änderungen an Windows und BIOS erfordert, aber nicht immer funktioniert.

Quelle:

7 Antworten

Kommentar

Lade neue Kommentare

Veteran

Urgestein

Urgestein

Urgestein

Veteran

Urgestein

Mitglied

Alle Kommentare lesen unter igor´sLAB Community →