Morgen Nachmittag ist es dann endlich soweit, da werde auch ich einen Test zu Intels neuester CPU-Generation veröffentlichen. Allerdings hat sich mir im Vorfeld durchaus die Frage gestellt, mit welcher High-End-GPU ich diesmal die Tests für den Launchartikel machen soll. Da ich alle vier Auflösungen testen wollte, also von Ultra-HD bis hinunter zu 720p, war natürlich abzuwägen, ob und wo gegebenenfalls ein möglicher Treiber-Overhead bei der NVIDIA-Karte auftreten könnte. Außerdem unterstützt ja auch die 11. Generation auf dem Z590-Board Resizeable BAR und ich war schon neugierig, wie gut die Performance ausfällt.

Nun hatte ich die Qual der Wahl. Da ich davon ausgehe, dass die meisten Kollegen mit einer GeForce RTX 3090 testen werden, habe ich mit genau diese Karte in Form einer MSI RTX 3090 SUPRIM geschnappt und dazu gleich noch eine werksübertaktete MSI RX 6900XT Gaming X Trio hinterher. Viel Zeit, um jetzt zig Spiele durchzupeitschen, blieb am Ende ja auch nicht, aber dazu schreibe ich morgen noch etwas. Auch zu den Umständen, die das Ergebnis nicht besser erscheinen lassen. Doch alles zu seiner Zeit und wenn es erlaubt ist.

Welche Karte skaliert besser bis 720p?

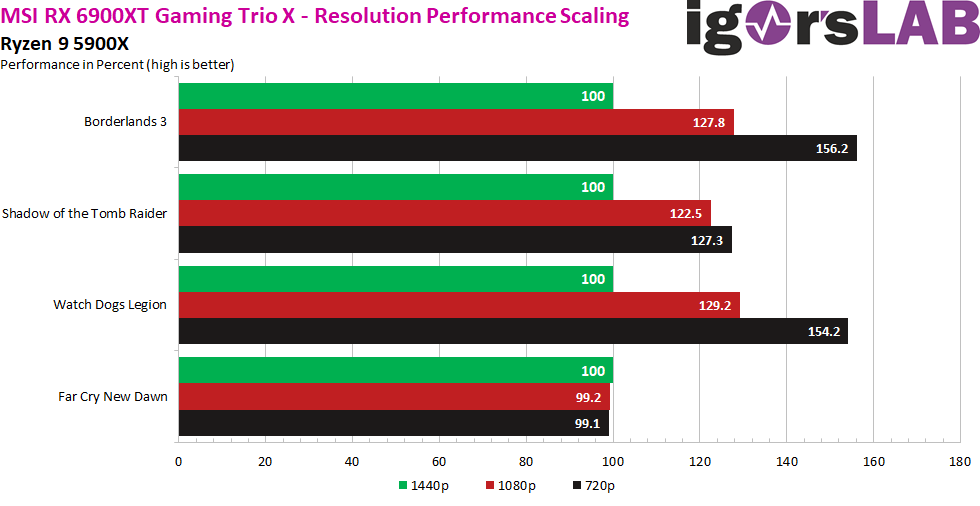

Da es bei CPU-Tests eher nicht primär auf Grafikfeatures wie DLSS und RTX ankommt, wohl aber die CPU-Limits bei sehr niedrigen Auflösungen immer eine Rolle spielen, muss man hier wirklich sorgfältig abwägen, welches Spiel und welche Hardware möglichst objektive Resultate ermöglichen. Um mir einen ersten Überblick zu verschaffen, habe ich zunächst auf einem Ryzen 9 5900X beide Karten in 4 Spielen getestet und die Skalierung zwischen 1440p (jeweils als 100%-Ausgangswert) über 1080p bis hinab zu 720p gegenübergestellt. Dabei tritt jede Karte erst einmal für und gegen sich sich selbst an. Zunächst also die Radeon RX 6900XT und ich messe der Fairness halber erst einmal ohne Resizeable BAR:

Das Gleiche habe ich nun mit der GeForce RTX 3090 gemacht. Auch wenn die Steigerung in Borderlands 3 etwas höher ausfällt, sind die eigentlichen FPS-Werte im direkten Vergleich deutlich niedriger. In den anderen 3 Spielen fällt die FPS-Leistung der Radeon ebenfalls bei den niedrigeren Auflösungen etwas höher aus, so dass ich hier bereits zur Radeon tendiert habe.

Es gab auch einige Spiele wie z.B. CoD MW, Horizon Zero Dawn oder Apex Legends, die mit zunehmendem CPU-Limit bei der GeForce RTX 3090 einige Anomalien aufwiesen und mit sinkender Auflösung auf dieser einen Karte deutlich schlechter skalierten. Das führte in eingen Fällen sogar dazu, dass die zu testenden 6-Kerner plötzlich deutlich schlechtere Ergebnisse produzierten als in anderen Spielen oder mit der Radeon RX 6900XT im selben Spiel gegenüber den 8-Kernen plötzlich stark abfielen. Dazu kommt, dass sich in einigen Situationen solcher Limitierungen die Ergebnisse unerwartet in Richtung Intel verschoben, da die Testplattform offensichtlich besser mit der GeForce und ihren bremsenden Treibern zurechtkam.

Vergleich in 720p mit und ohne Resizeable BAR

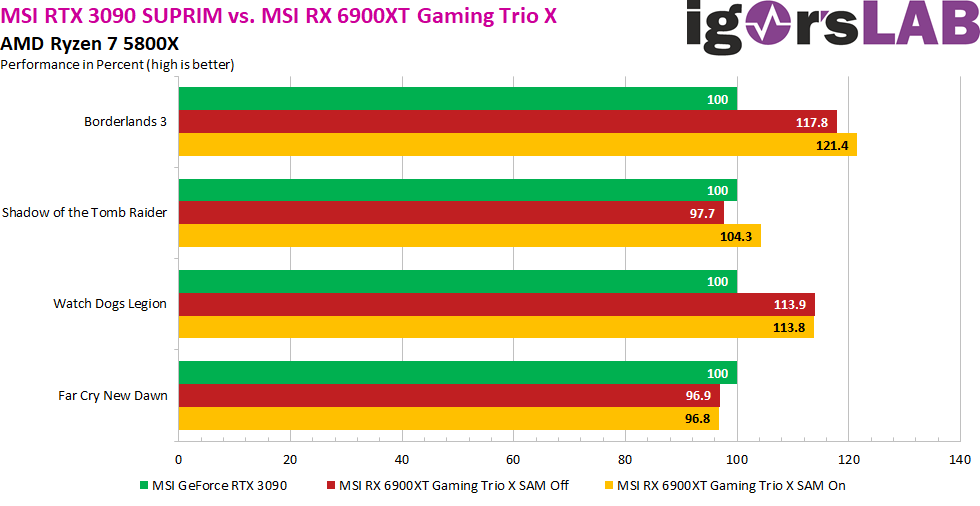

Jetzt vergleiche ich den Ryzen 7 5800X mit dem neuen Intel Core i7-11700K, beides 8-Kerner mit einer ähnlichen Zielgruppe. Und diesmal setze ich die Performance der GeForce RTX 3090 in 720p als 100%-Basis und vergleiche damit die Performance the RX 6900XT mit und ohne Resizeable BAR. Zunächst starte ich den Test mit dem Ryzen 7 5800X. Bis auf den alten DX11-Titel Far Cry New Dawn, bei dem die Karten schon in Ultra-HD von der CPU limitiert werden, sehen wir in zwei Spielen einen schönen Zuwachs mit aktiviertem großen Adressraum.

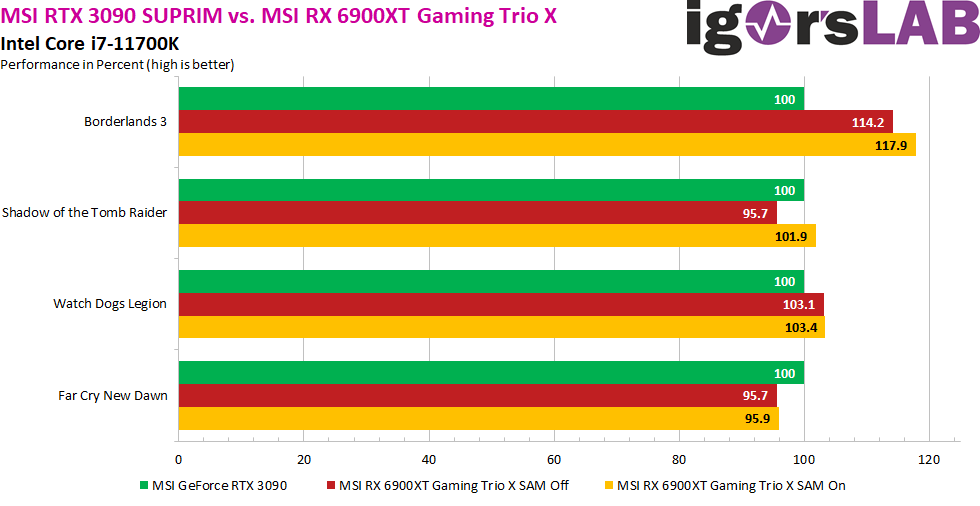

Dort, wo es auf dem Ryzen gut läuft, schafft es auch die vergleichbare Intel-CPU in vergleichbarem Maße, was uns beweist, dass Intel seine Hausaufgaben durchaus gemacht und die Implementierung gut umgesetzt hat. Und auch hier sehen wir schön, dass z.B. in Shadow of the Tomb Raider Resizeable BAR geeignet ist, aus dem Rückstand der Radeon sogar einen kleinen Vorsprung zu machen, wenn das Feature aktiviert wurde.

Solange NVIDIA hier keine wirkliche Alternative für alle RTX 3xxx-Karten in Form eines neuen BIOS anbietet, solange werde ich wohl erst einmal die Radeon RX 6900XT einsetzen, denn die Karte kommt den Anforderungen doch ein Stückweit näher als die GeForce.

Wer sich übrigens wundert, warum ich Prozente und keine FPS in den vier Charts verwendet habe, der sei neben der besseren Vergleichbarkeit auch auf den Launchartikel verwiesen, der dann auch die CPUs enthält, die noch nicht im Laden käuflich erwerbbar waren.

Das genaue Testsystem und die Methodik gibt es natürlich dann im Launchartikel und es wird auch beim Speicher fair zugehen, im Rahmen meiner Absichten natürlich. Und nein, ich werde definitiv nicht nach Specs testen, denn so verwendet der Kunde seine neu erworbene Technik ja auch nur in den seltensten Fällen. Da ich weiß, dass es Kollegen gibt, die sich exakt an die Beipackzettel halten, mache ich guten Gewissens dann etwas anderes. Und ja, es geht auch irgendwie um eine imaginäre Krone, die am Ende aber gar keiner braucht. Lasst Euch mal überraschen.

16 Antworten

Kommentar

Lade neue Kommentare

Mitglied

Veteran

Mitglied

Urgestein

Veteran

Veteran

Mitglied

Urgestein

Neuling

Urgestein

Urgestein

Neuling

Alle Kommentare lesen unter igor´sLAB Community →