Niemand war überrascht, als Nvidia auf der diesjährigen Games Developer Conference (GDC) seine GeForce GTX 1080 Ti vorstellte. Überraschend war nur eins: Der Preispunkt von 700 Dollar.

Ausgehend von den Spezifikationen der Karte sollte die GeForce GTX 1080 Ti genauso schnell sein wie eine Titan X (Pascal) – und vielleicht sogar ein bisschen schneller. Also warum wird der Preis des Flaggschiffs so massiv unterboten? Wir haben auf diese Frage keine wirklich gute Antwort – nur eine Vermutung: Wahrscheinlich sieht Nvidia AMDs Radeon RX Vega am Horizont dräuen und bereitet schon die Basis für künftige Auseinandersetzungen im High-End-Bereich.

Und warum jetzt? Weil die GeForce GTX 1080 Ti heute schon verfügbar ist, wie Nvidia uns mitteilt – und weil das für Vega nicht gilt, würden wir bissig hinzufügen.

Ausschuss zeigt Siegerqualitäten

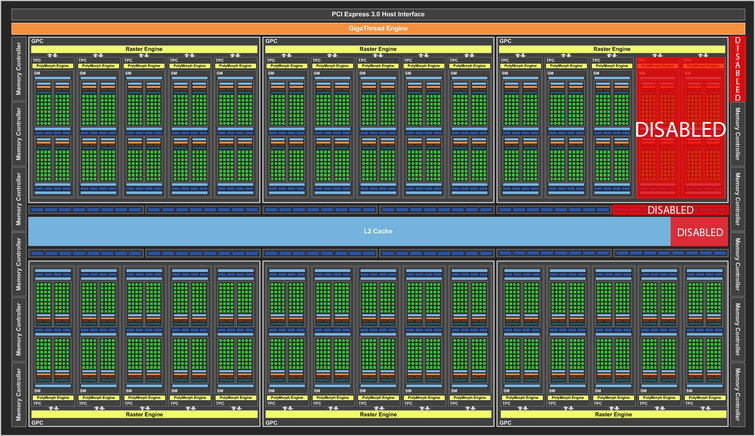

Es gibt momentan zwei Grafikkarten, die auf Nvidias GP102-GPU basieren: Titan X (Pascal) und Quadro P6000. Erstere nutzt eine Version dieser GPU, bei der zwei ihrer Streaming-Multiprozessoren deaktiviert sind. Letztere dagegen verbaut eine unberührte GP102 ohne jegliche Fehler.

Allerdings reden wir hier über einen Chip mit 12 Milliarden Transistoren. Ganz sicher ist doch die Ausbeute nicht so gut, dass alle produzierten GPUs in eine dieser beiden Kategorien fallen, oder? Hier kommt die GeForce GTX 1080 Ti ins Spiel.

Die 1080 Ti nutzt eine ähnliche Streaming-Multiprozessor-Konfiguration wie die Titan X: 28 ihrer 30 SMs sind aktiviert, was in 3584 CUDA-Kernen und 224 Textureinheiten resultiert. Nvidia hebt den Basistakt des Prozessors auf 1480 MHz an und beziffert den typischen Boost-Takt der GPU mit 1582 MHz. Zum Vergleich: Die Titan X (Pascal) taktet mit 1417 MHz respektive 1531 MHz.

Beim Backend unterscheidet sich die neue GeForce-Karte aber von Titan X und Quadro P6000. Die beiden letztgenannten Karten nutzen alle 12 32-Bit-Speicher-Controller, ROP-Cluster und L2-Cache-Blöcke der GP102 – das lässt keinen Raum für Fehler. Anstatt nun marginal fehlerhafte GPUs in die Tonne zu treten, werden sie in GTX 1080 Ti’s verwandelt, indem ein Speicher-Controller, eine ROP-Partition und 256 Kilobyte L2-Cache deaktiviert werden.

Das Resultat sieht auf dem Datenblatt vielleicht etwas gewöhnungsbedürftig aus, ist aber absolut funktionsfähig: Die GTX 1080 Ti hat ein aggregiertes Speicher-Interface von 352 Bit, 88 ROPs und 2816 Kilobyte L2-Cache. Zum Vergleich: Die Titan X hat einen 384 Bit breiten Datenpfad, 96 ROPs und glatte drei Megabyte L2-Cache.

Wenn man sich das so anschaut, dann müsste die GeForce GTX 1080 Ti im Vergleich zur Titan X leicht benachteiligt sein. Aber in den Monaten seit dem Launch der GTX 1080 hat Micron 11 (und 12) GBit/s schnelle GDDR5X-Speicher auf den Markt gebracht. Dessen höhere Datenrate kompensiert locker den schmaleren Speicherbus: Auf dem Papier schlägt die GTX 1080 Ti mit 484 GByte/s sogar die Titan X mit ihren 480 GByte/s.

Natürlich wird die maximale Speicherkapazität der Karte durch die Eliminierung eines Speicherkanals beeinträchtigt. Aber eine Speicherkapazität von 11 statt 12 Gigabyte klingt nicht wirklich alarmierend, wenn man das Ganze mit einer mit vier Gigabyte bestückten Radeon R9 Fury X vergleicht, die auch in 4K-Auflösungen ihren Dienst tut.

Einen Verlust von Speicherkapazität ist zudem allemal besser, als das GTX-970-Desaster zu wiederholen: Bei der GeForce GTX 970 entfernte Nvidia einen ROP und eine einen L2-Block, aber beließ den Speicher bei der alten Größe, was in einem deutlich langsameren Zugriff auf das verwaiste 512-MByte-Speichersegment resultierte. Bei der GTX 1080 Ti kommunizieren die 11 Gigabyte GDDR5X-Speicher dagegen mit voller Geschwindigkeit.

Spezifikationen

| Quadro P6000 |

Titan X (Pascal) |

GeForce GTX 1080 Ti |

GeForce GTX 1080 |

GeForce GTX 980 Ti |

|

|---|---|---|---|---|---|

| GPU |

GP102 | GP102 | GP102 |

GP104 | GM200 |

| CUDA-Kerne |

3850 | 3584 | 3584 |

2560 | 2816 |

| Basistakt | 1506 MHz | 1417 MHz | 1480 MHz |

1607 MHz | 1000 MHz |

| Boost-Takt |

1645 MHz | 1531 MHz | 1582 MHz |

1733 MHz | 1076 MHz |

| Speichergröße & -typ |

24 GByte GDDR5 | 12 GByte GDDR5X | 11 GByte GDDR5X |

8 GByte GDDR5X | 6 GByte GDDR5 |

| Die-Größe |

471 mm² | 471 mm² | 471 mm² |

314 mm² | 601 mm² |

| Prozesstechnik |

16 nm | 16 nm | 16 nm |

16 nm | 28 nm |

| Transistoren |

12 Mrd. | 12 Mrd. | 12 Mrd. |

7,2 Mrd. | 8 Mrd. |

| Streaming Multiprozessoren (SM) |

30 | 28 | 28 |

20 | 22 |

| GFLOPS (Basistakt) |

10.883 | 10.157 | 10.609 |

8.228 | 5.632 |

| Textureinheiten |

240 | 224 | 224 |

160 | 176 |

| Texturfüllrate |

361,4 GT/s | 317,4 GT/s | 331,5GT/s | 257,1 GT/s | 214 GT/s |

| ROPs |

96 | 96 | 88 | 64 | 96 |

| Pixelfüllrate |

144,6 GPix/s | 136 GPix/s | 130,24 GPix/s | 114,2 GPix/s | 116,7 GPix/s |

| Speicherdatenrate |

9 GByte/s | 10 GByte/s | 11 GByte/s | 10 GByte/s | 7 GByte/s |

| Speicherbus |

384 Bit | 384 Bit | 352 Bit |

256 Bit | 384 Bit |

| Speicherbandbreite |

432 GByte/s | 480 GByte/s | 484 GByte/s |

320 GByte/s | 336 GByte/s |

| L2-Cache |

3 MByte | 3 MByte | 2816 KByte |

2 MByte | 3 MByte |

| TDP |

250 Watt | 250 Watt | 250 Watt |

180 Watt | 250 Watt |

Sagt “Hallo!” zur GeForce GTX 1080 Ti Founders Edition

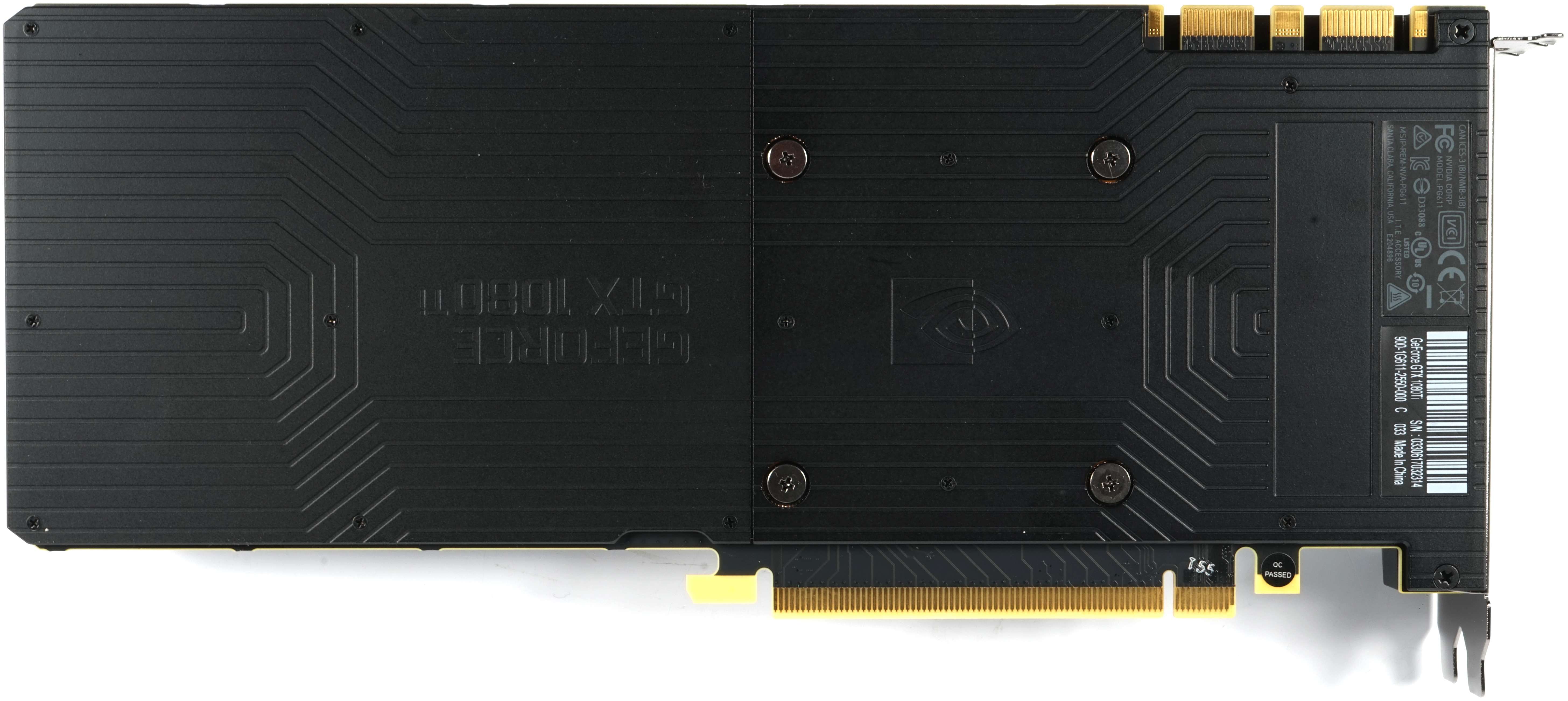

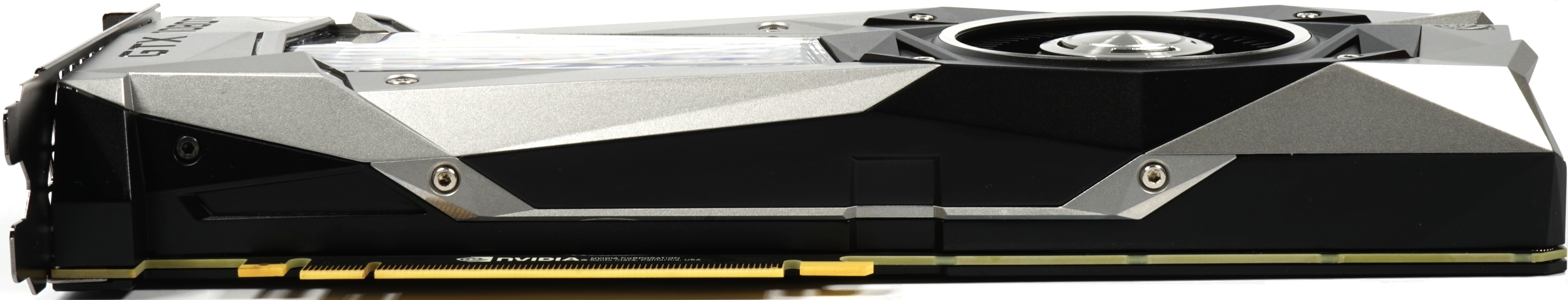

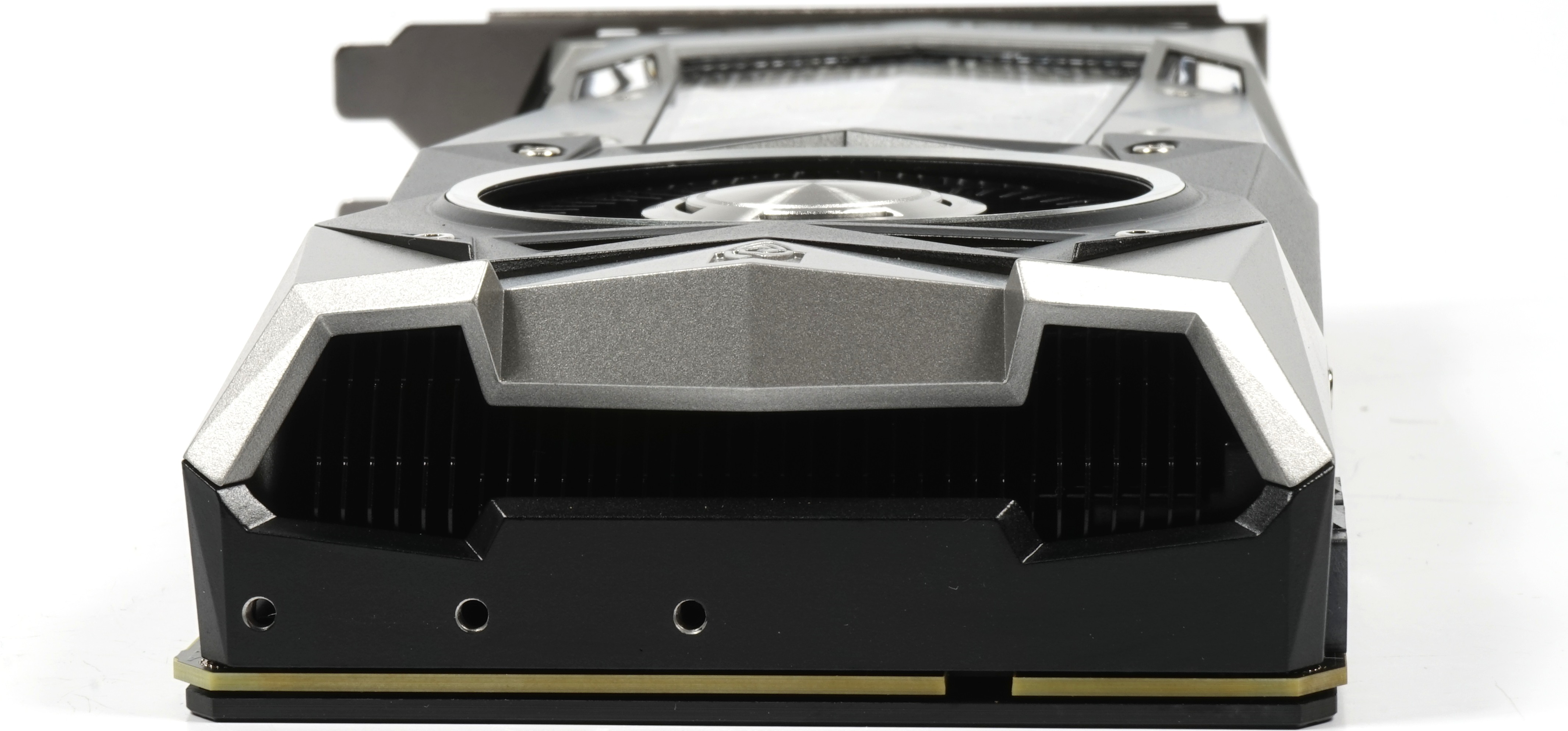

Nvidia meinte bei der Vorstellung der Karte, dass sich der Kühler gegenüber der Titan X (Pascal) noch einmal deutlich geändert habe, was optisch jedoch zu diesem Zeitpunkt nicht auffällt. Doch im Verlaufe unserer werden wir darauf noch einmal zurückkommen. Bis auf die Beschriftung ist eigentlich alles komplett übernommen worden. Dies gilt auch für den Materialmix aus Aluminiumguss und Kunststoffen, sowie den optisch dominanten Radialkühler mit 6,2 cm Nettodurchmesser.

|

|

Mt 26,9 cm vom Äußeren der Slot-Blende bis hin zum Kühlerende hat sich an den Abmessungen gegenüber der Titan X (Pascal) nichts geändert, was auch für die Einbauhöhe von 10,5 cm von der Oberkante des Mainboard-Slots bis hin zur Kühleroberkante gilt. Die Einbautiefe von 3,5 cm steht ebenfalls für das bereits bekannte Dual-Slot-Design, während das Gewicht der Karte ein klein wenig auf nunmehr 1039 Gramm zugelegt hat.

Die Oberseite gibt sich ebenfalls im gewohnten Bild und zeigt neben dem grün beleuchteten Schriftzug je einen 8- und 6-poligen externen Stromversorgungsanschluss. Die Unterseite ist noch wesentlich unspektakulärer und zeigt außer dem Cover eigentlich … nichts.

Das Kartenende bietet die üblichen Luftöffnungen für einen Teil des Luftaustritts, wobei anhand des Plattendesigns vermutet werden kann, dass die Wärmeabgabe ins Gehäuseinnere eher marginal ausfällt. Doch zu den konkreten Werten werden wir gleich noch die Messungen betrachten.

|

|

Um den Luftaustritt an der Slot-Blende zu verbessern, hat Nvidia auf den DVI-Anschluss komplett verzichtet und bietet stattdessen nur noch drei DisplayPort-Anschlüsse sowie einmal HDMI. Der Rest wird vom Lüftungsgitter dominiert.

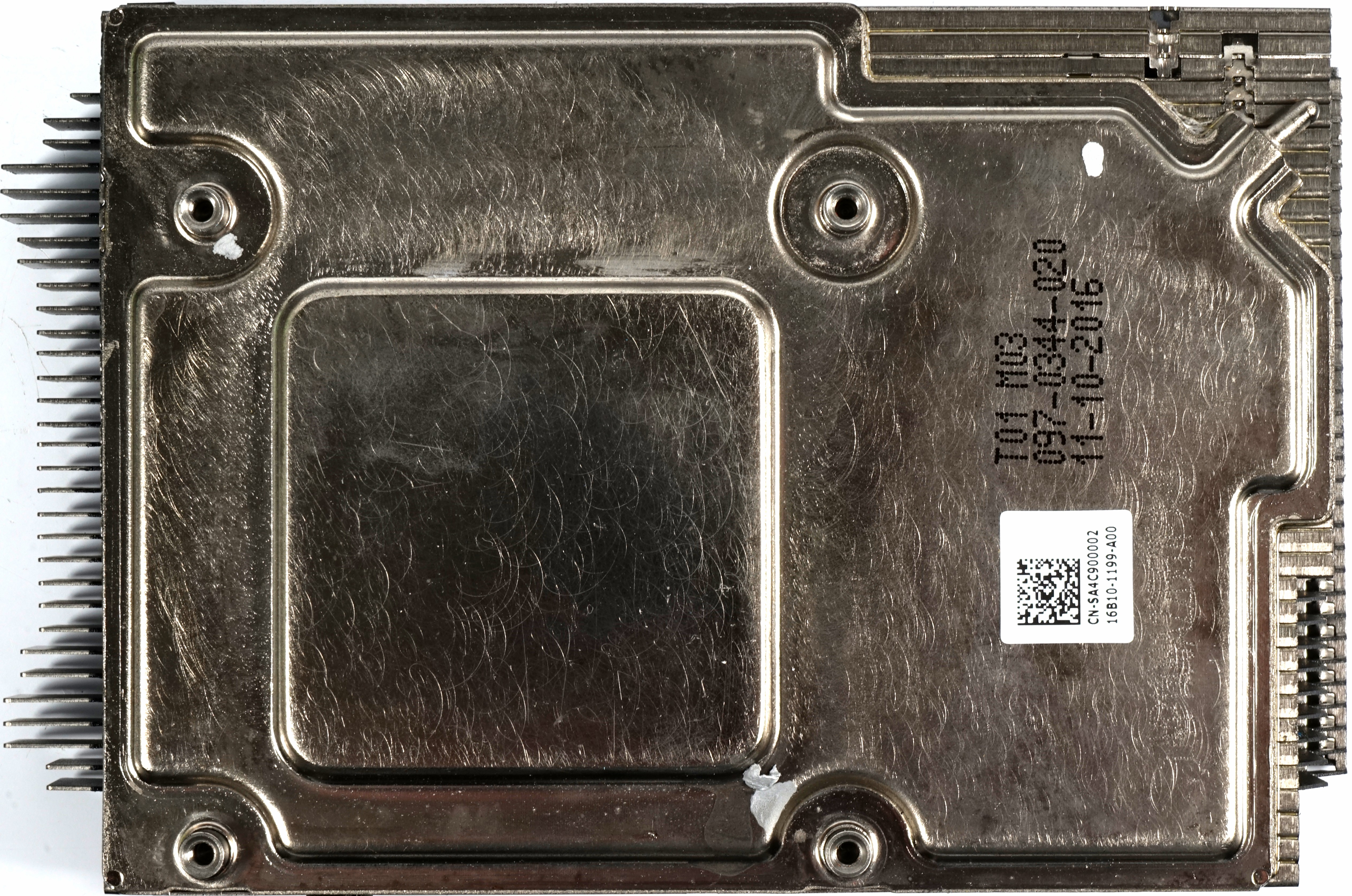

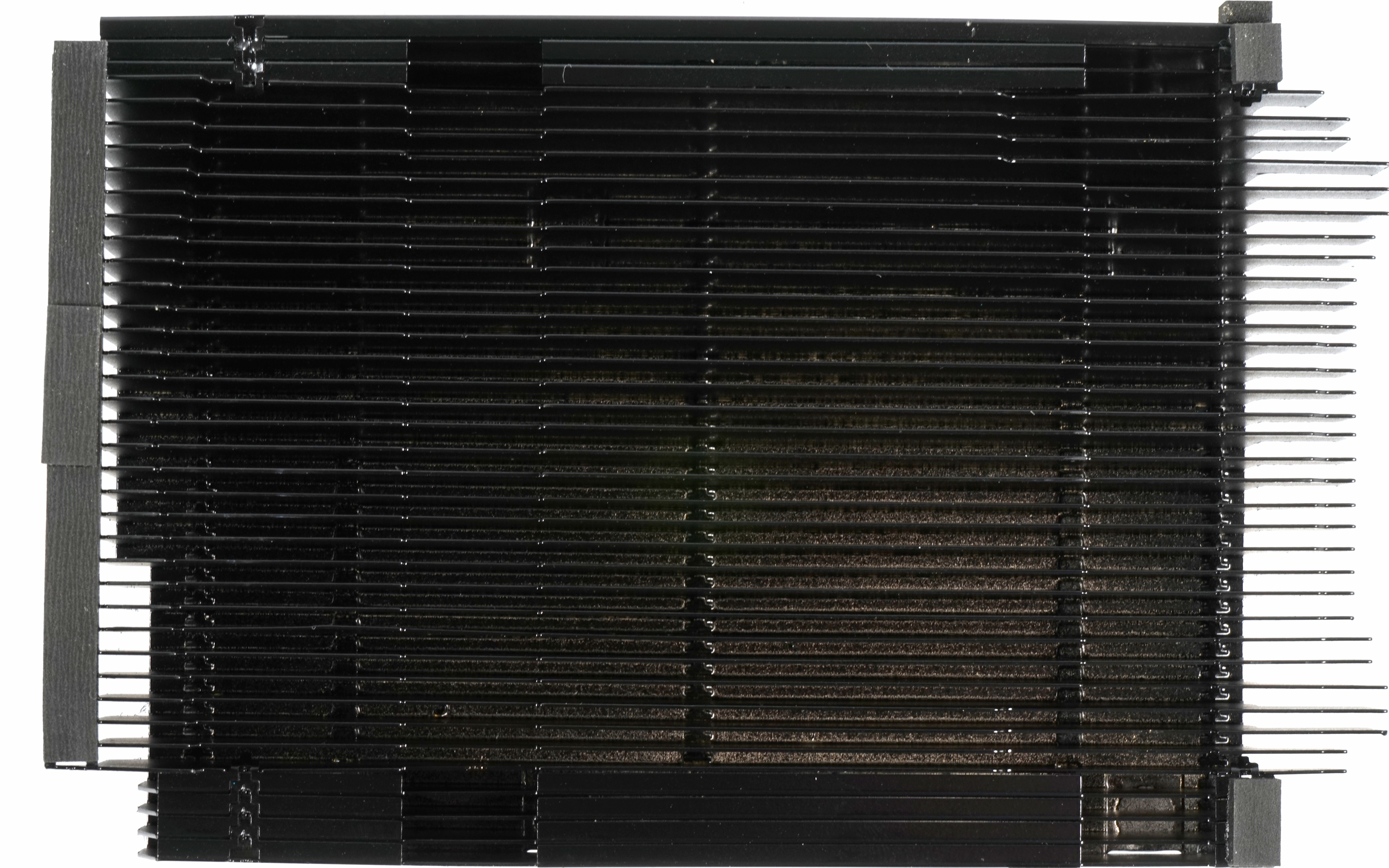

Kühleraufbau

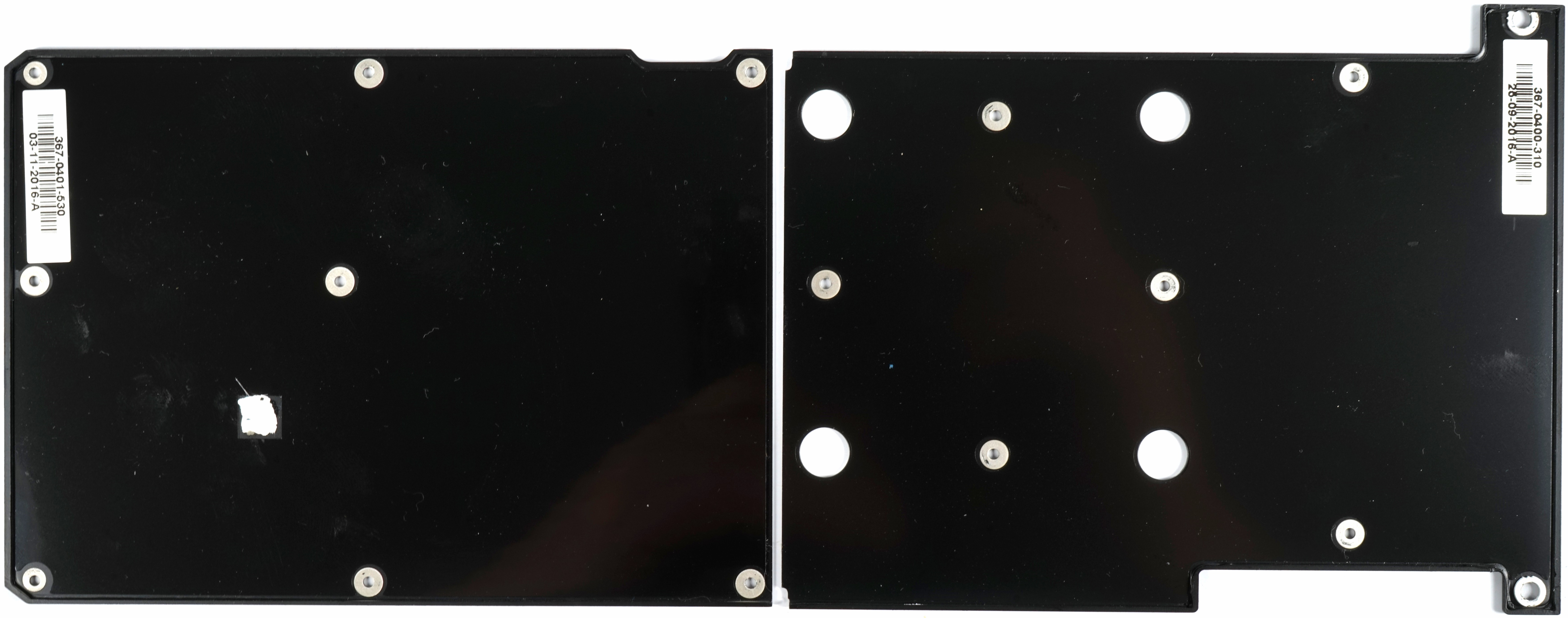

Nvidia nutzt zur Befestigung der zweiteiligen Backplate überwiegend ganz dünne Schräubchen (0,5 mm), deren Gegengewinde wiederum im Schraubenkopf von Nvidias speziellen Huckepackschrauben unterhalb der Backplate sitzen. Diese eher ungewöhnlichen Sechskantschrauben (M2.5) dienen gleichzeitig zur Befestigung des kompletten Gehäuses auf der Platine.

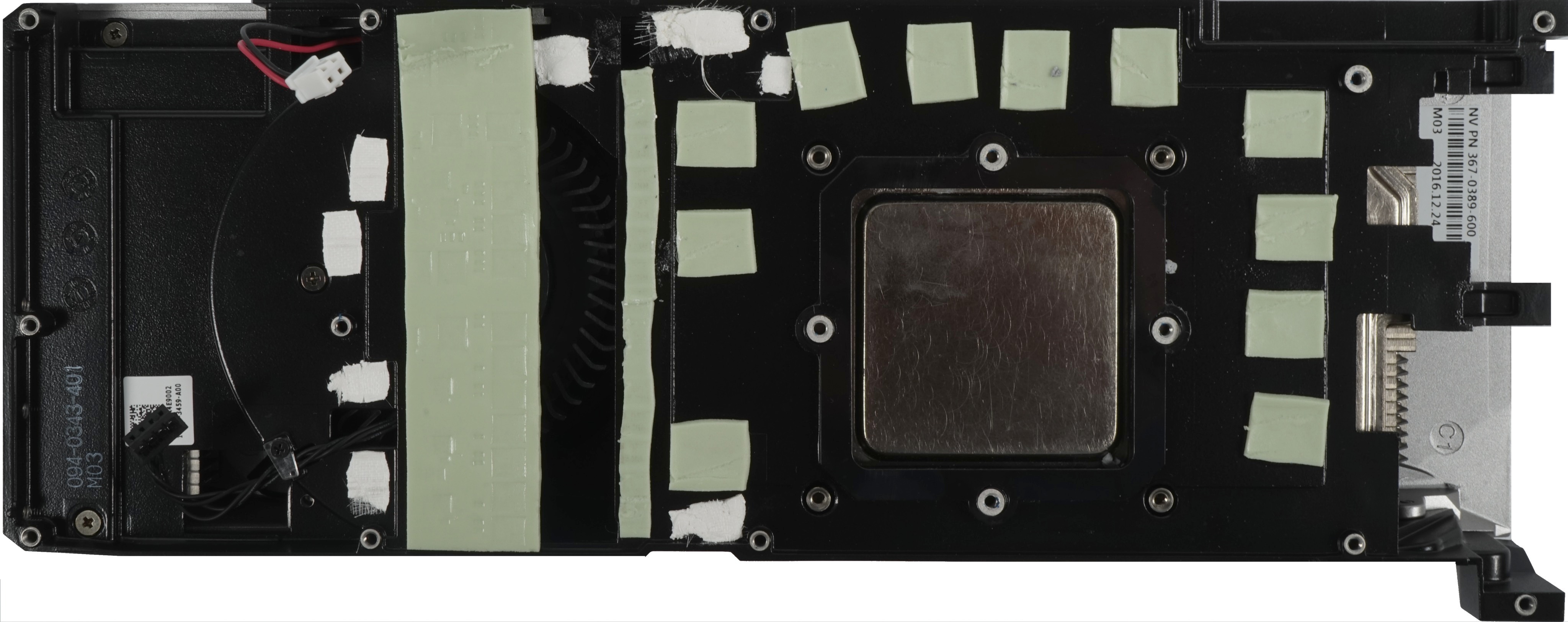

Die erste Änderung ist bereits sichtbar geworden, denn Nvidia verbindet den PWM-Controller-Chip auf der Platinenrückseite mit einem eigentlich selten genutzten dicken Wärmeleitvlies mit der einen Backplate-Hälfte zur besseren Wärmeabfuhr. Das würde sogar noch besser funktionieren, hätte Nvidia an dieser Stelle die Kunststofffolie, mit der die Backplate innen beklebt ist, einfach ausgespart.

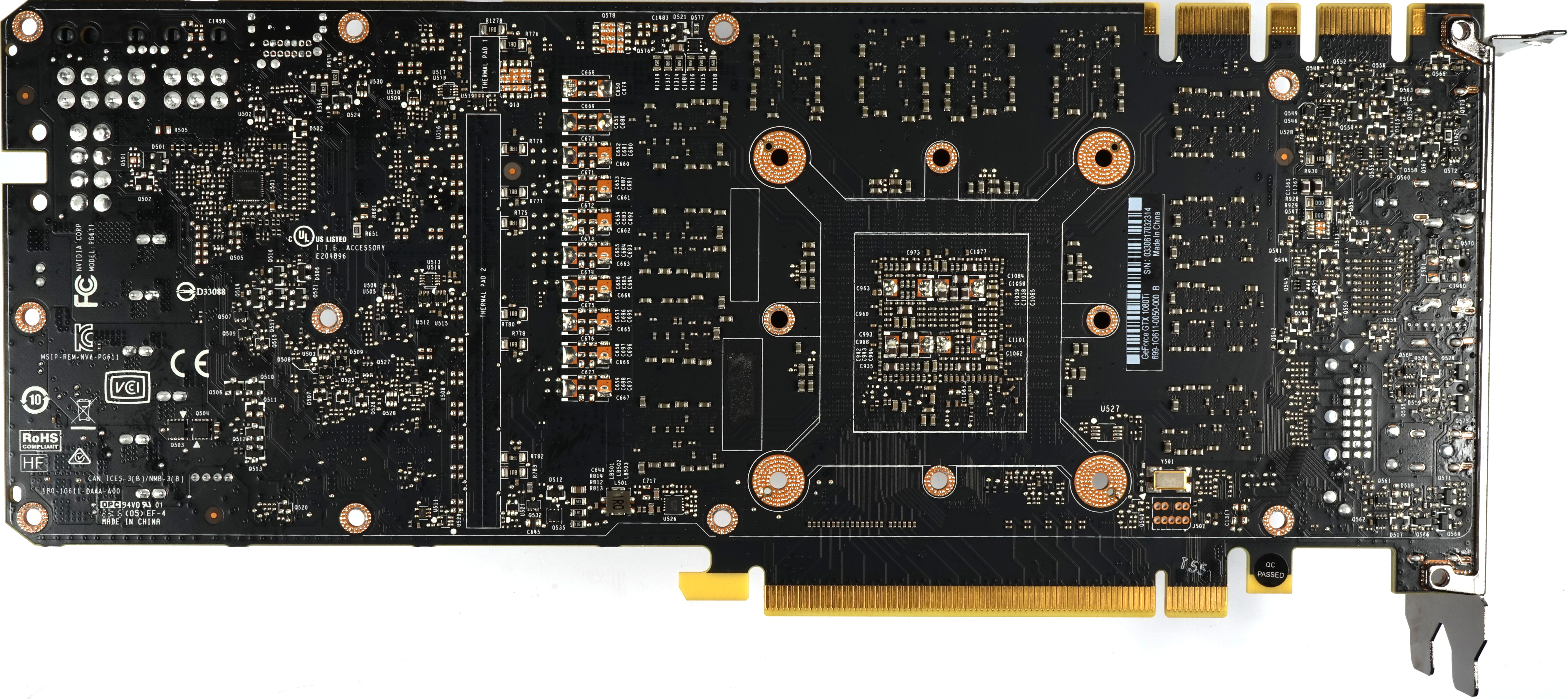

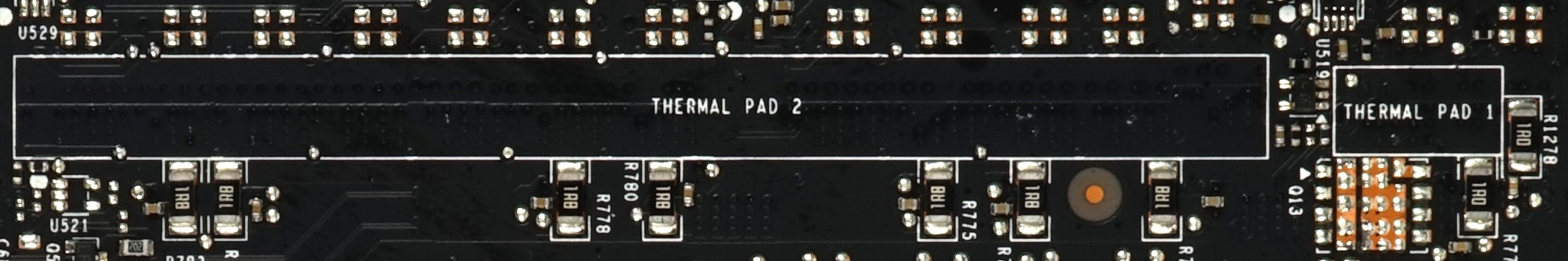

Betrachten wir nun kurz noch die freigelegte Rückseite der die Platine, dann sehen wir halb links noch zwei markierte und mit “Thermal Pad 1” und “Thermal Pad 2” beschriftete Bereiche, bei denen aber im Endprodukt die vorgesehen Pads fehlen. Ob Nvidia hier einfach nur der Mut (oder gar die Lust) verlassen hat, können wir nicht beurteilen – und dürfen ja auch noch nichts messen.

Die massive Platte des Kühler-Frames trägt neben den üblichen Wärmeleitpads für Spannungswandler und Speicher erneut einige der eben erwähnten Vliesstreifen, die zusätzlich aktive Bauelemente wie VR-Chips, MOSFETs und Dioden thermisch mit dem Boden der großen Platte verbinden. Andere Änderungen konnten wir am Kühler bisher nicht ausmachen.

Nvidia setzt – wie bei den anderen Karten der Founders Edition (FE) auch – wiederum auf eine in den Boden eingesetzte Vapor-Chamber, die mit vier Federschrauben an der Platine befestigt wird und den eigentlichen GPU-Kühler darstellt. Der Rest wird wie bereits beschrieben über den großen Frame mitgekühlt.

|

|

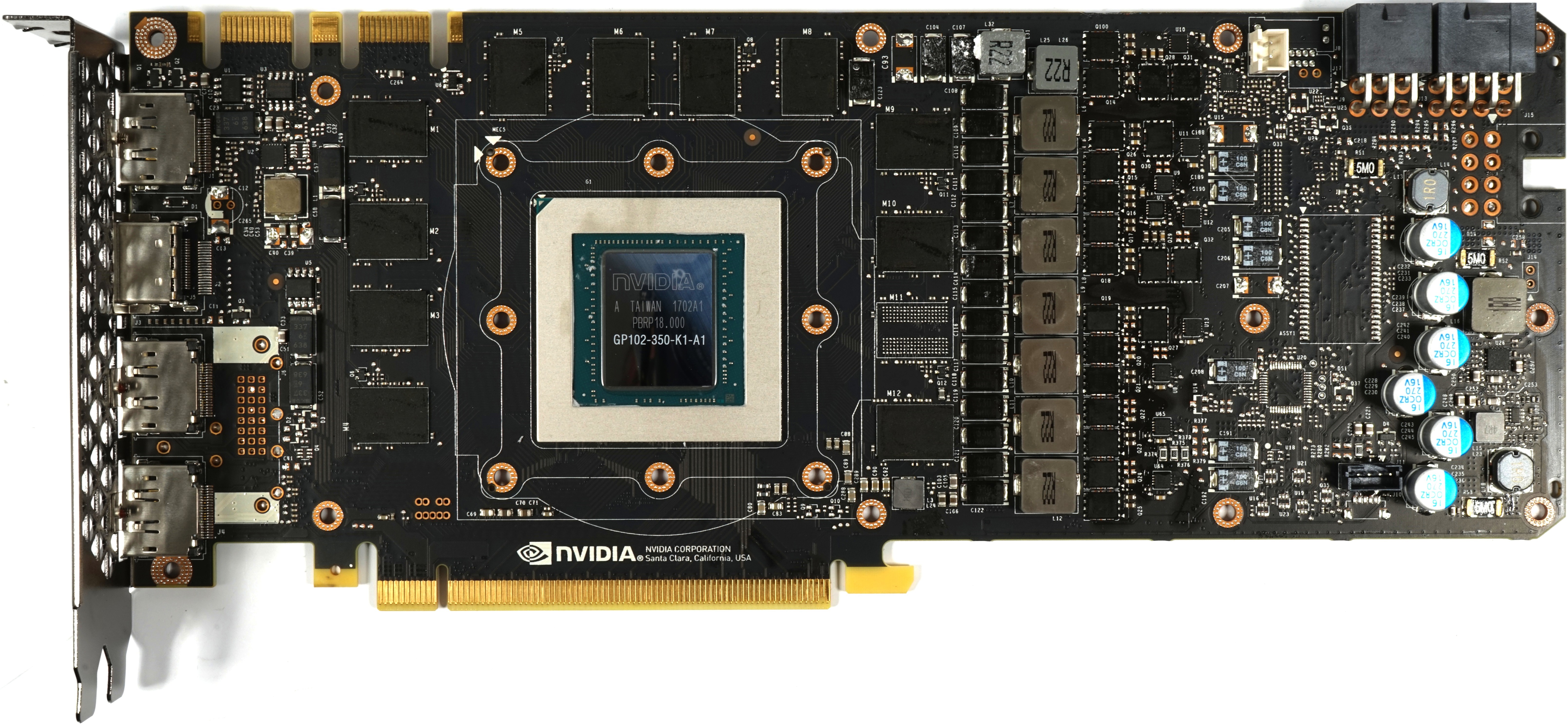

Platinendesign und Komponenten

Abschließend wollen wir noch einen Blick auf die Platine und die von Nvidia angekündigten Verbesserungen werfen. Was auf den ersten Blick auffällt: Der Bereich der Spannungswandler hat im Vergleich zur Titan X (Pascal) nunmehr eine Vollbestückung erfahren, auch wenn es sich immer noch um die gleiche Platine handelt.

Diese gemeinsame Basis nutzt Nvidia ja bereits seit der Quadro P6000, deren 8-Pin-Versorgungsanschluss rückseitig liegt, was man an den acht unbelegten Lötaugen gut ausmachen kann.

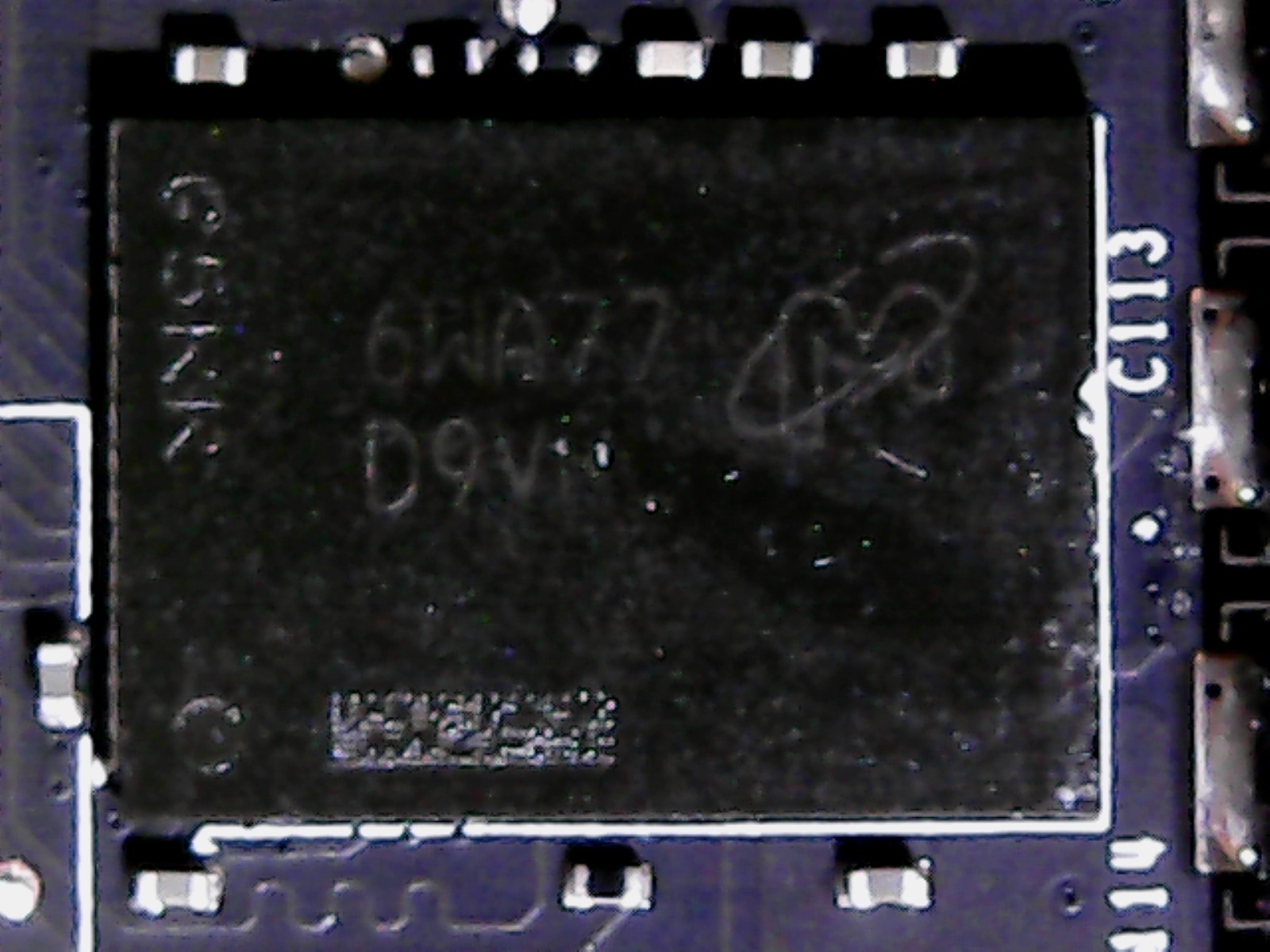

Werfen wir aber zunächst einen kurzen Blick auf den Speicher, bei dem im Unterschied zur Titan X (Pascal) ja ein Modul fehlt.

Insgesamt 11 der neuen G5X-Micron Module vom Typ MT58K256M321-Ja110, die bis zu 11 GByte/s bieten und damit die fehlenden 32 Bit des Speicherinterfaces durch einen höheren Takt von 5500 MHz (effektiv) wieder ausgleichen sollen, sind auf dieser Karte verbaut.

Insgesamt 11 der neuen G5X-Micron Module vom Typ MT58K256M321-Ja110, die bis zu 11 GByte/s bieten und damit die fehlenden 32 Bit des Speicherinterfaces durch einen höheren Takt von 5500 MHz (effektiv) wieder ausgleichen sollen, sind auf dieser Karte verbaut.

Uns wundert etwas, dass Nvidia nicht gleich die MT58K256M321-Ja120 verbaut hat, die noch einmal etwas höher takten. Aber vermutlich hat man Angst vor einem thermischen Problem des mit bis zu 1,35 Volt betriebenen Speichers, der jedoch in beiden Fällen bis maximal 95°C heiß werden darf.

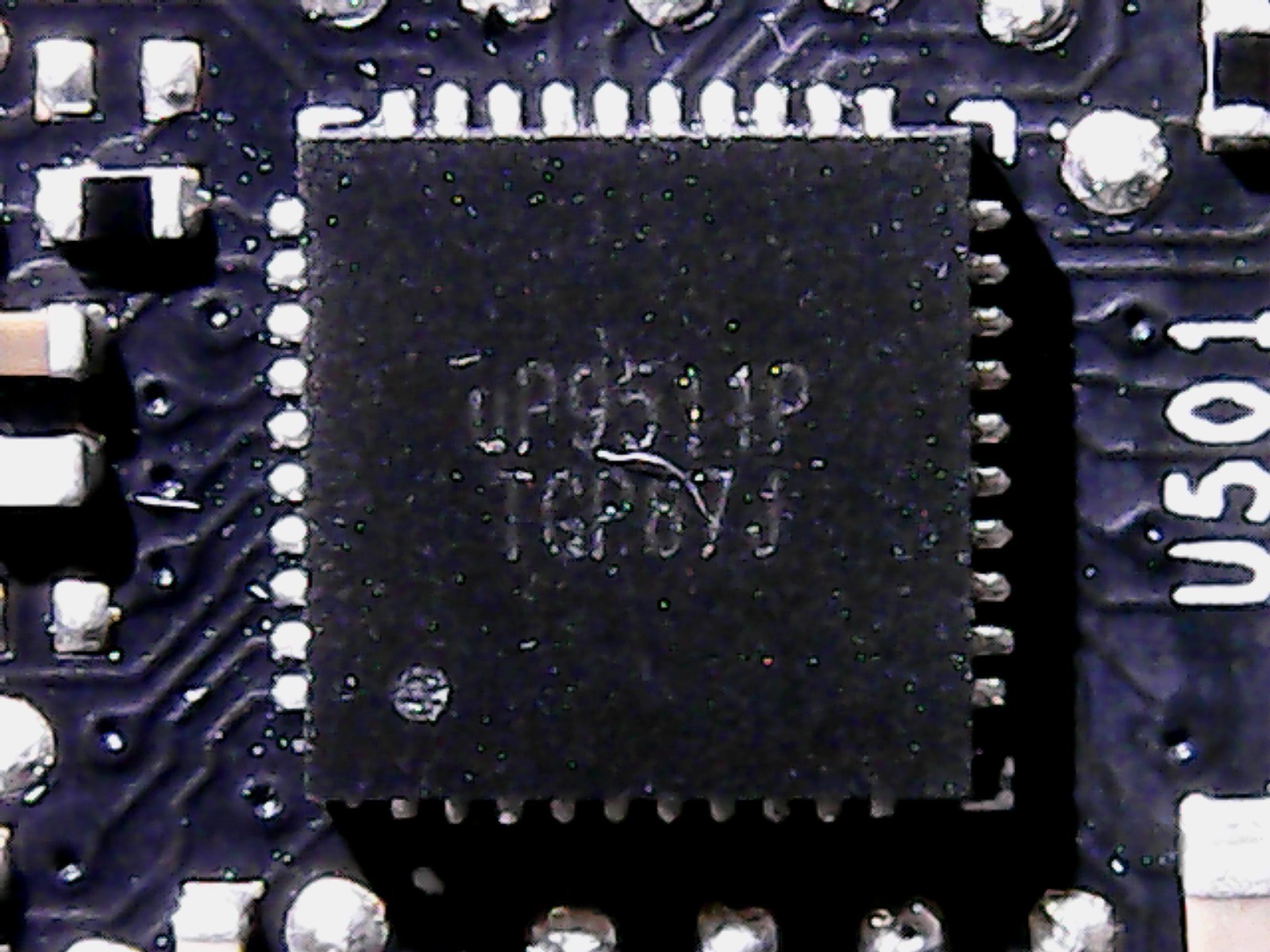

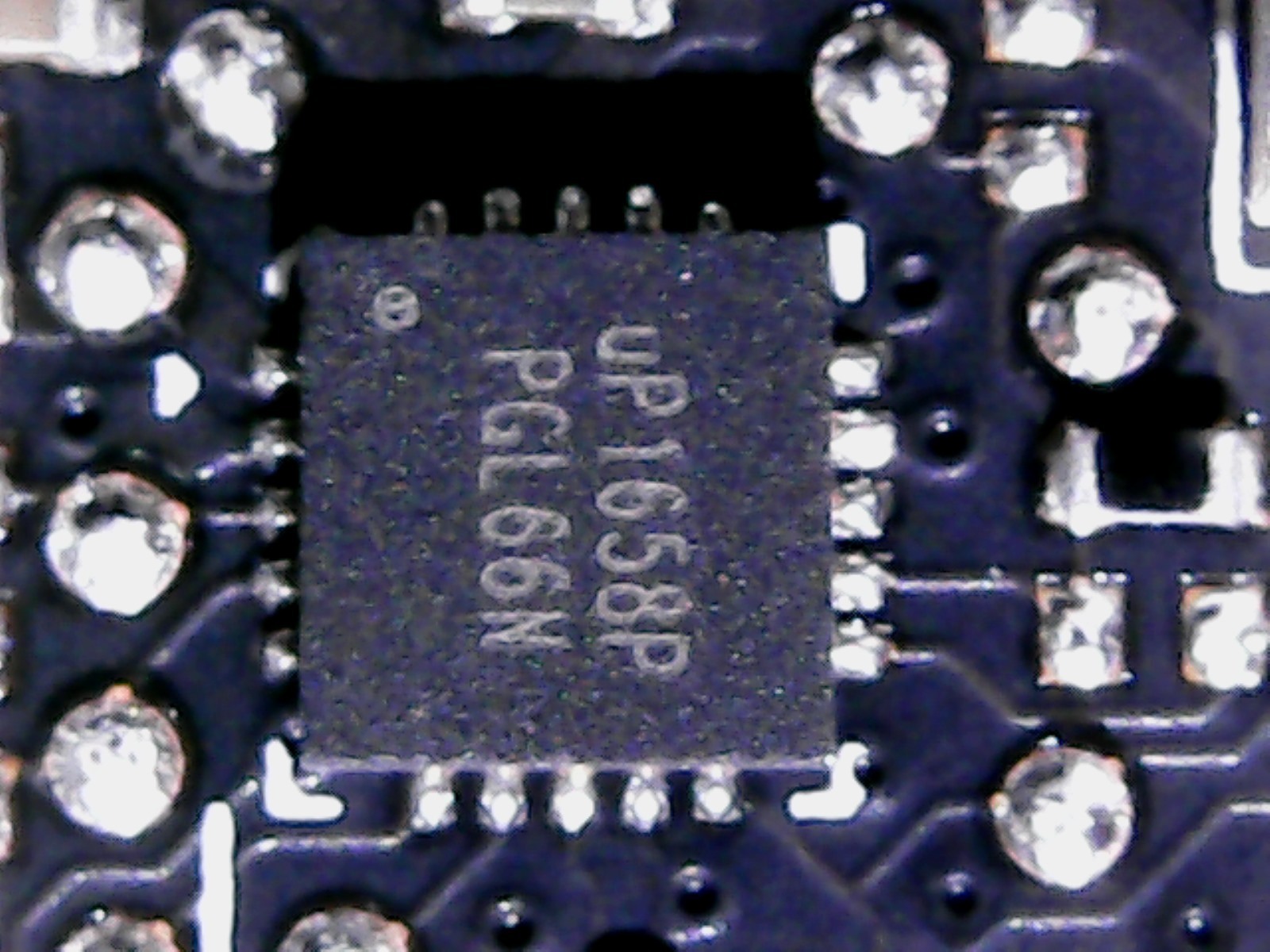

Bei den Spannungswandlern bleibt sich Nvidia treu und setzt bei der GPU und deren sieben Phasen mit dem uP9511 auf einen guten alten Bekannten, der wie gehabt auf der Platinenrückseite zu finden ist.

Diese Komponentenauswahl für den PWM-Controller ergibt durchaus einen Sinn, da dieser die sieben Phasen gleichzeitig betreiben und nicht nur 6(+2)-Phasen-Designs ansteuern kann.

|

|

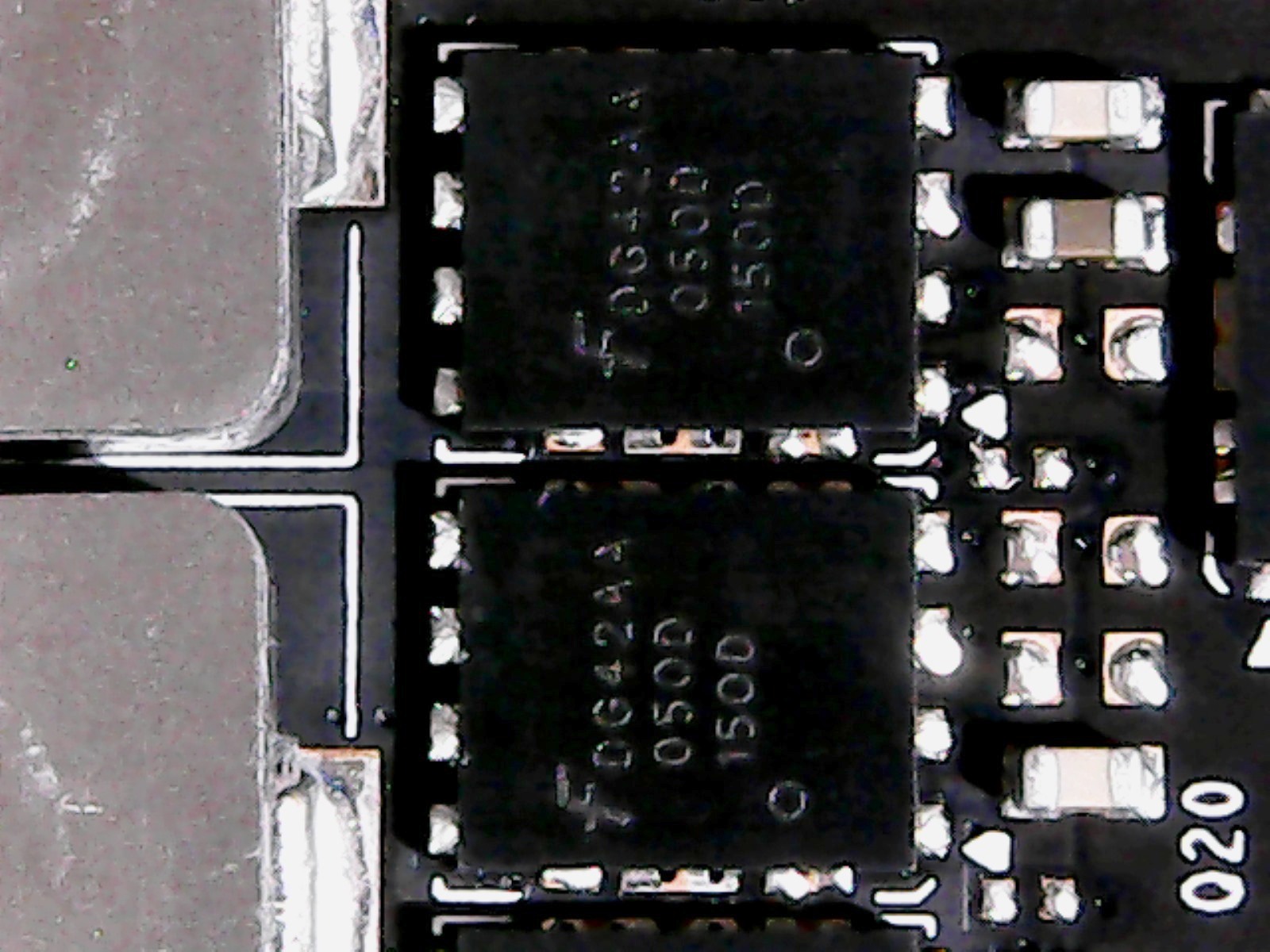

Das Design der Spannungswandler ist insofern interessant, als dass Nvidia einerseits auf ein eher simples Design aus einfachem Buck-Converter (LM53603) für die High-Side und nunmehr zwei statt einem MOSFET auf der Low-Side setzt, die in Form zweier Fairchild-D424-N-Channel-MOSFETs realisiert wurde. Damit entzerrt man etwas die Hotspots, denn die Verlustleistung verteilt sich dadurch auf eine doppelt so große Fläche.

Bei den Spulen setzt man auf einfach gekapselte Ferritschalen, die qualitativ in etwa Foxconns Magic-Coils entsprechen, maschinell bestückt werden können und nicht durchgesteckt sind. Thermisch gesehen ist dies für die Platinenrückseite ein Vorteil, wobei Nvidia die heißen Spulen unverständlicherweise nicht mitkühlt, sondern nur die daneben liegenden Kondensatoren.

|

|

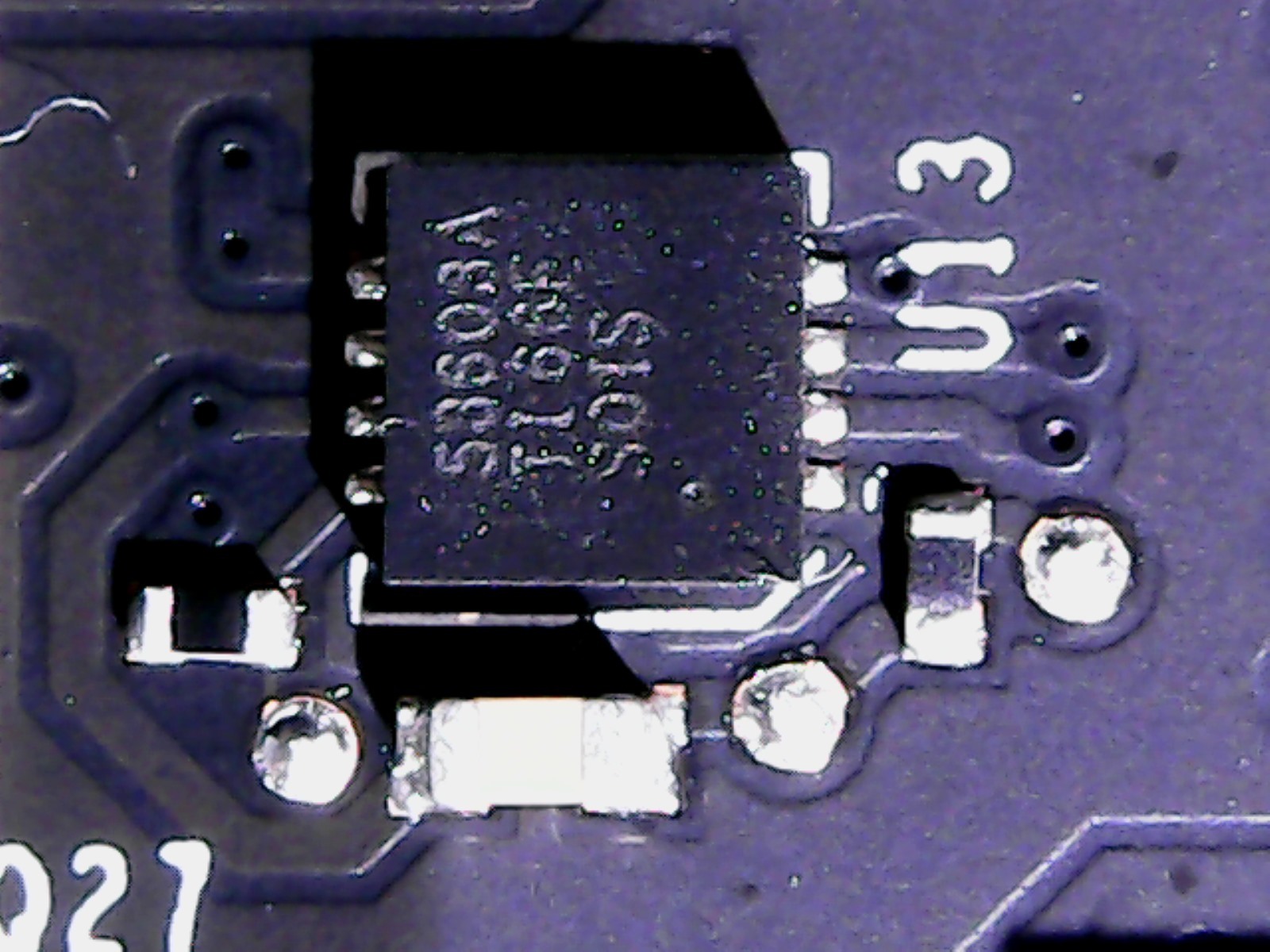

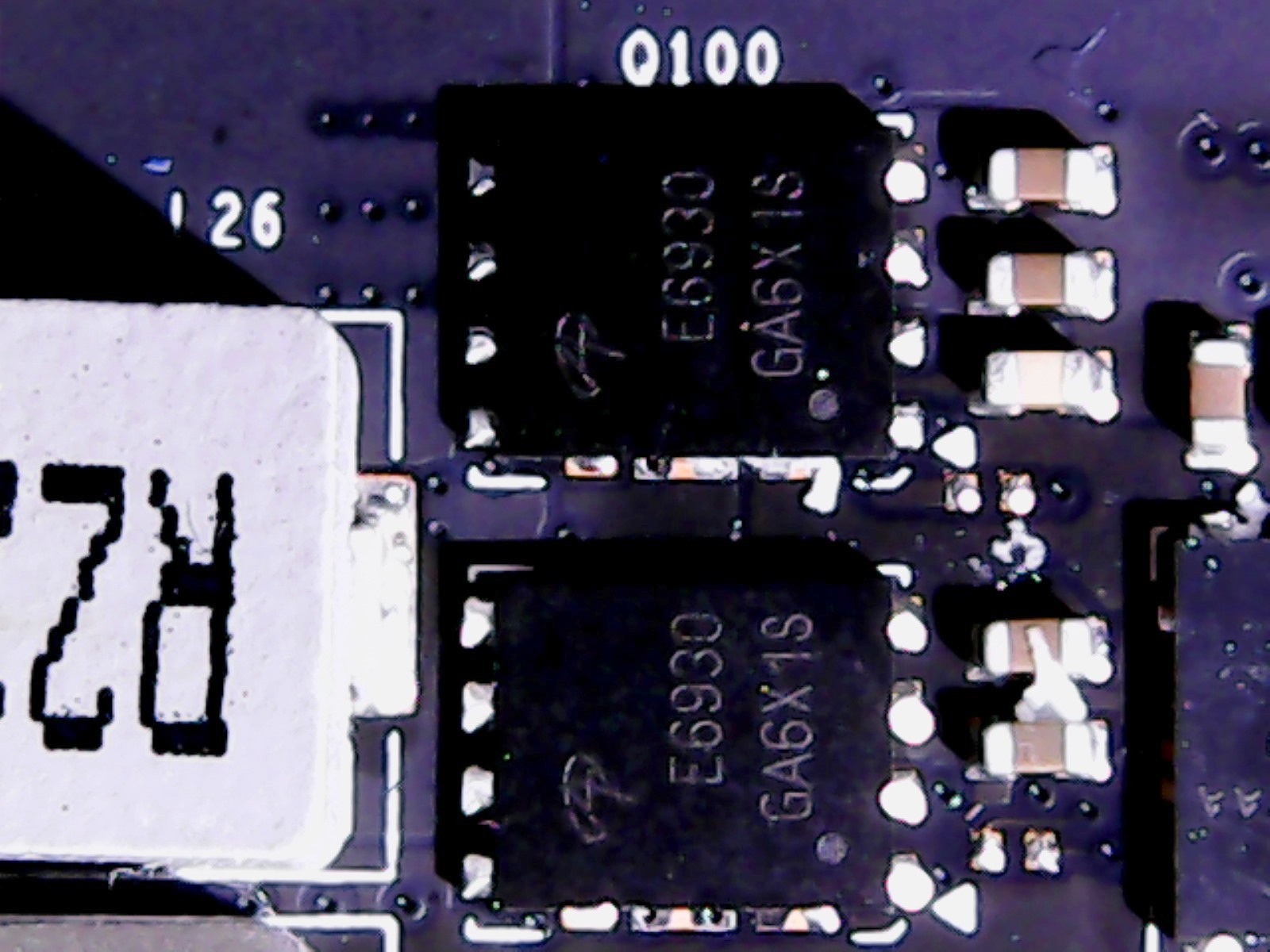

Der Speicher wird über zwei parallel angesteuerte Phasen gespeist, die von einem uP1685 angesteuert werden. Die Low-Side ist über jeweils zwei parallel geschaltete Dual-N-Channel-Logic-Level-PowerTrench-MOSFETs E6930 gelöst, was eher ungewöhnlich ist, die High-Side mit dem bereits oben erwähnten FD424. Die Spulen fallen für diese beiden einfacheren Phasen dann auch entsprechend kleiner aus.

|

|

Was ist nun mit dem erwähnten neuen Kühlerdesign? Da wir die konreten Messwerte nunmehr kennen, würden wir es besser als neues Kühlkonzept be- und umschreiben, bei dem sowohl die aktiven Komponenten als auch die Abwärmeabfuhr mit weiteren Pads zu den augenfälligsten Änderungen gehören. Mehr Dinge, die signifikante Verbesserungen bringen könnten, konnten wir bis hierher jedenfalls nicht feststellen.

MEHR: Nvidia GeForce GTX 1080 und GTX 1070 Roundup

MEHR: Nvidia GeForce GTX 1060 Roundup

So testen wir die GeForce GTX 1080 Ti

Nvidias Neuzugang wird zweifellos in High-End-Plattformen ein neues Zuhause finden; alles andere macht schlichtweg keinen Sinn. Ein Teil solcher Systeme wird auf Intels Broadwell-E-CPUs basieren, aber wir halten derweil unserem Core i7-7700K die Treue, der auf einem MSI Z170 Gaming M7 steckt. Dazu kommt das G.Skill-Speicher-Kit F4-3000C15Q-16GRR.

Intels Skylake-Architektur ist immer noch die pro Takt effizienteste des Herstellers – und der Basistakt von 4,2 GHz ist höher als bei den Modellen mir mehr Kernen. Der Rest des Testsystems besteht aus Crucials MX200-SSD, Noctuas CPU-Kühler NH-12S dem 850-Watt-Netzteil Be Quiet! Dark Power Pro 10.

In Sachen Konkurrenz hat die GeForce GTX 1080 Ti derzeit nur die mit 1200 Dollar fast doppelt so teure GeForce GTX Titan X (Pascal) zu fürchten. Die einzigen beiden anderen Konkurrenzprodukte, die halbwegs Sinn machen, sind Nvidias GeForce GTX 1080 und 1070 sowie AMDs Flaggschiff Radeon R9 Fury X. Wir erweitern das Ganze noch um eine GeForce GTX 980 Ti um zu zeigen, wie weit die GTX 1080 Ti ihre Vorgängerin hinter sich gelassen hat.

Treiber und Benchmarks

Software-seitig gibt es wichtigere Änderungen. Unsere Benchmark-Auswahl umfasst nun Ashes of the Singularity, Battlefield 1, Civilization VI, Doom, Grand Theft Auto V, Hitman, Metro: Last Light, Rise of the Tomb Raider, Tom Clancy’s The Division, Tom Clancy’s Ghost Recon Wildlands und The Witcher 3. Wir haben uns also von Battlefield 4 und Project CARS verabschiedet, aber verschiedene neue Games hinzugefügt.

Unser Testverfahren inklusive der zugrunde liegenden Methodik haben wir im Artikel THDE intern: So messen und bewerten wir die Grafik-Performance genau beschrieben. Um er kurz zusammenzufassen: Alle Games werden mit einer Kombination aus OCAT und unserer eignen GUI für PresentMon bewertet; das Loggen der Daten erfolgt mittels AIDA64. Wer mehr über unsere Charts-Methodik erfahren will, dem sei die Lektüre des verlinkten Artikels wärmstens an Herz gelegt.

Alle Werte im heutigen Test wurden mit aktualisierten Treibern neu erhoben. Für die Nvidia-Karten nutzen wir den Build 378.78 und für AMDs Grafikkarten verwenden wir den Crimson ReLive Edition 17.2.1 – der zum Testzeitpunkt aktuellste Treiber.

Kommentieren