Der heutige Artikel ist eigentlich eher ein Zufallsprodukt, denn bei den Vorbereitungen für den Ampere-Launch habe ich ja nicht nur das Testsystem erneuert und gravierend erweitert, sondern auch die ganzen Metriken und Grafiken für die Auswertung. Genau hier setzt dann auch der ganze Test an, denn die Tiefe der Auswertung war in dieser Form bisher nicht möglich und es hat wirklich ewig gedauert, bis auch die Auswertungssoftware für meinen Messplatz endlich fertig wurde.

Natürlich wird es auch für Ampere wieder die hochauflösende Messungen mit 8 analogen Kanälen und den beiden Oszilloskopen im Master-Slave-Modus geben, denn ich will ja wissen, wo die Spikes entstehen, wie Boost und die Spannungsversorgung auch im Mikrosekundenbereich so ticken und was das dann für Auswirkungen auf das Netzteil haben wird. Zu all diesen Details wird es vor Ampere natürlich noch einen gewohnt ausführlichen Spezial-Artikel geben, denn ich dann auch später beim Test aller neuen Karten verlinken kann. Doch heute geht es – auch ohne Ampere und im wahrsten Sinne des Wortes – mal um etwas ganz Grünes.

Kann man mit DLSS wirklich Energie sparen?

Genau die Frage hatte ich mir gestellt, als ich die aktuellen GeForce RTX in Ultra-HD für die kommenden Launches noch einmal komplett neu und schon mit den neuen, erweiterten Daten gebenchmarkt habe. Dass eine GeForce RTX 2080 Ti in Ultra-HD mit DLSS in einigen Spielen deutlich mehr Perfomance bei gleicher oder sogar leicht niedrigerer Leistungsaufnahme bot, ist soweit ja nichts Neues. Allerdings habe ich diesmal auch die Leistungsaufnahme der gesamten Grafikkarte (12 Volt und 3.3 Volt) mit der Package-Power der GPU kombiniert!

Im Detail sehe ich dann die Frame-Time-Verläufe als Kurve analog auf der gleichen Zeitachse wie die hochauflösende Leistungsaufnahmemessung und ich bekomme auch über den gesamten Benchmark eine sehr gut gemittelte Leistungsaufnahme, die ja je nach Spiel, Einstellungen und Szene auch gehörig schwanken kann. Hier jetzt alle Karten einheitlich und absolut vergleichbar messen zu können, ist fast schon unbezahlbar. Addiert man dann noch GPU und CPU, sieht man sogar die Auswirkungen der jeweiligen Grafiksettings auf den Leistungshunger der CPU.

Soweit, so theoretisch. Denn rein optisch sieht man beim Durchlauf mit DLSS 2.0 kaum einen Unterschied, eher im Gegenteil. Viele Details, die sogar in der nativen UHD-Auflösungen verschwinden, sind mit DLSS wieder sichtbar, auch wenn man ab und an fast mehr sieht, als die Spielentwickler reingepackt haben. Ein genau hier setzt mein heutiges Experiment dann an. Wenn man mit Hilfe des Framelimiters die FPS beim Durchlauf mit DLSS auf genau den Wert deckelt, den man ohne DLSS im Mittel auch gemessen hat, dann ist doch interessant zu wissen, wie sich die Leistungsaufnahme von GPU und CPU ändert, obwohl man de facto ja das gleiche Ergebnis erhält. Das klappt bei Shadow of the Tomb Raider, Control und Mechwarrior 5 übrigens frappierend gut, bei Wolfenstein Youngblood hingegen nicht ganz so elegant. Wobei letzteres Spiel ja noch eine Art Übergangslösung von DLSS benutzt. Man sieht also auch im Vergleich der Versionen, wo der Weg mittlerweile hingeht!

Wie kann man so etwas eigentlich messen?

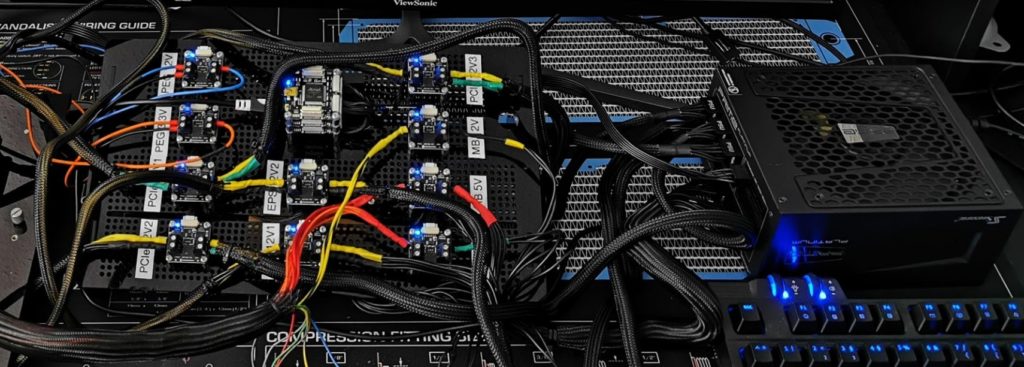

Die Details hebe ich mir für das Special nächste Woche auf, denn da werde ich gleichzeitig auch noch etwas ganz Anderes und richtig Neues vorstellen können. Heute dreht sich aber alles erst einmal um mein Messystem, das ich vor einigen Wochen parallel zum Oszillographen-Messplatz gebaut habe. Letztendlich war für eine genaue Synchronisierung der über die Shunts gemessenen Datensätze und die mit der eigenen, auf PresentMon basierenden Logging-Software für die Frametimes der Knackpunkt. Aber auch das lief am Ende ohne träge API, denn ich wollte für das Logging der Leistungsaufnahmedaten nicht noch eine zusätzliche Systemlast am Benchtable erzeugen.

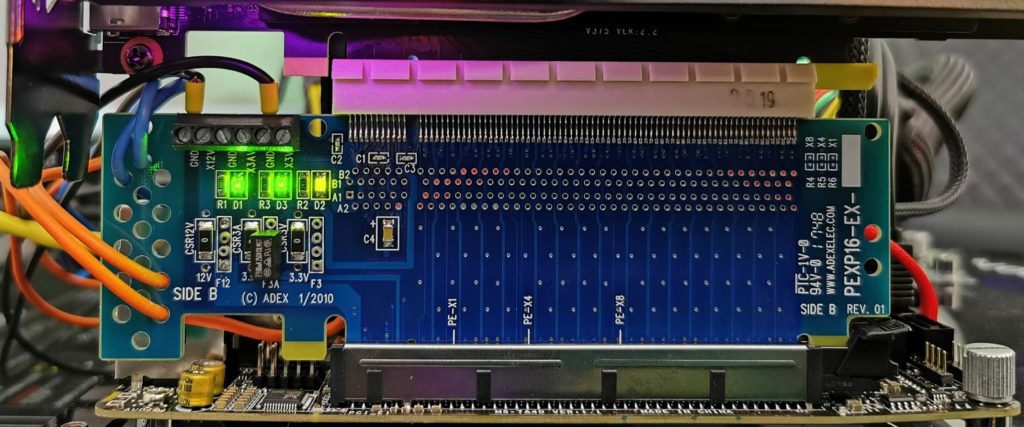

Natürlich messe ich nicht nur die bis zu drei 12-Volt Rails über die externen Versorgungsbuchsen der Grafikkarte, sondern auch die beiden 12-Volt und 3.3-Volt-Rails am Motherboard-Slot (PEG). Dafür gibt es eine spezielle Riser-Karte die natürlich auch bereits PCIe-4.0-fähig ist. Es ist ja auch kein Geheimnis mehr, dass die neuen NVIDIA-Grafikkarten dann ebenfalls PCIe Gen.4 unterstützen werden.

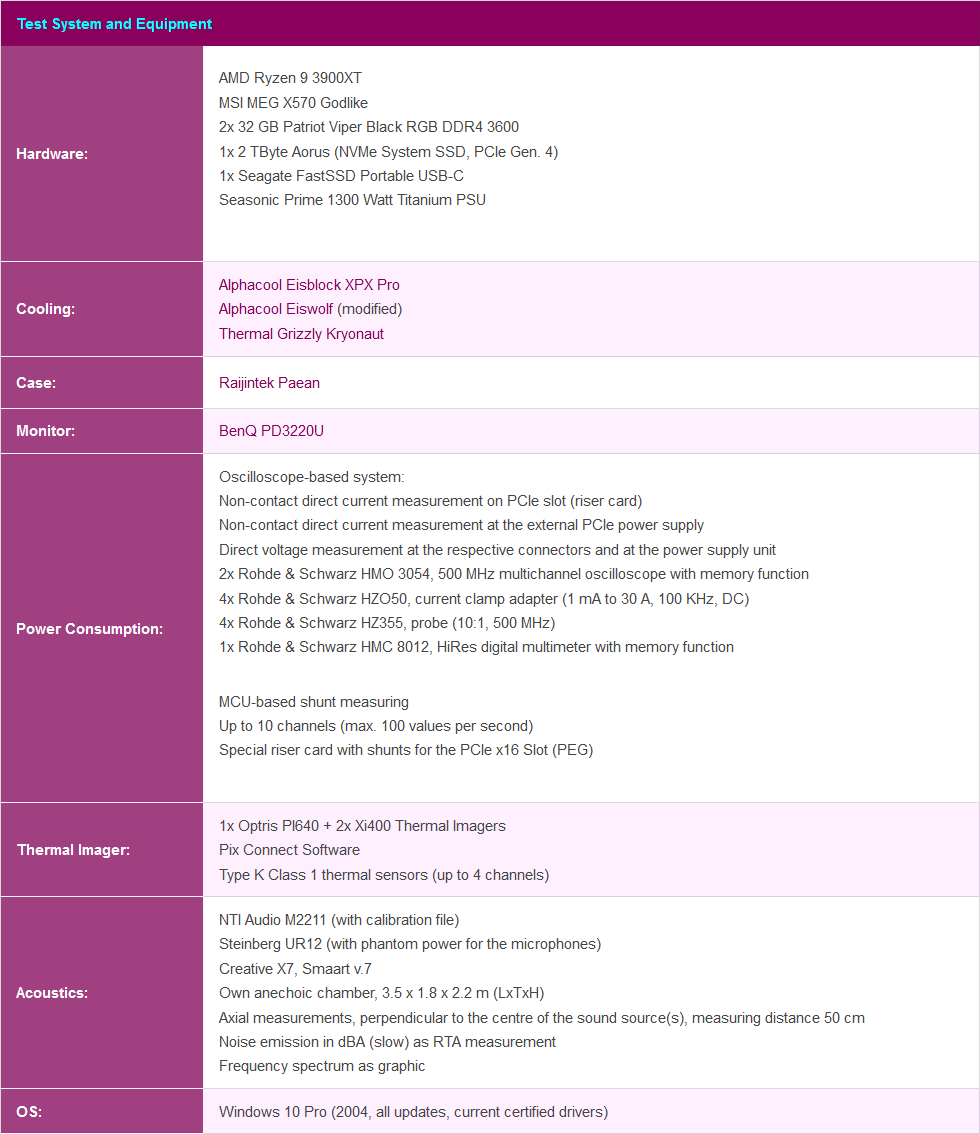

Ich bin aus Gründen der Maximalperformance vom Ryzen 9 3950X zum Ryzen 9 3900XT gewechselt, den ich auf dem MSI MEG X570 Godlike deutlich besser übertakten konnte. Am Ende standen 4.5 GHz als stabile Lösung fest, denn alles darüber war den Mehreinsatz an elektrischer Energie einfach nicht wert. Beim Speicher habe ich etwas gehadert, ihn aber bei DDR4 3600 mit etwas schärferen Timings belassen, denn ich wollte nicht auf den Ausbau mit den 64 GB verzichten. Denn ich werde auch Workstation-Anwendungen auf diesem System testen, bei denen 32 GB Speicherausbau zu wenig sind.

Kommentieren