Intel muss mit Alder Lake (in der dann 12. Generation) noch in diesem Jahr im Mainstream-Markt für Desktop-CPUs ordentliche Duftmarken setzen, will man den Anschluss (auch aus der Sichtweise dieser Zielgruppe) nicht ganz verlieren. Und es soll nicht nur endlich einmal keine neu angestrichene und weiter aufgebohrte 14-nm-CPU, sondern neben der geringeren Strukturbreite von 10 nm (nach Intels Lesart) endlich auch einmal eine komplett neue Architektur mit völlig anderem Lösungsansatz werden. Kann sicher klappen, aber der Ausgang ist zumindest jetzt noch etwas ungewiss, wenn man auf AMDs Warhol blickt. Nun ist allerdings ein Engineering-Sample (ES) eines Intel Core-1800 aufgetaucht, das mir und damit uns in so mancherlei Hinsicht bereits etwas mehr verrät.

Doch was hat man bei Intel vor? Man tritt die Flucht nach vorn an und setzt dabei erstmals auf den Big-Little-Ansatz, der seit vielen Jahren bereits in den ARM-SoCs mobiler Endgeräte wie Smartphones oder Tablets genutzt wird. Das Prinzip ist dabei eigentlich genauso einfach wie effizient, denn große und kleine Rechenkerne teilen sich die Arbeit, je nach Last, untereinander clever auf. Die nicht ganz so anspruchsvollen Aufgaben werden auf stromsparende, kleine Atom-Rechenkerne ausgelagert, während die großen Cores dann die rechenintensiveren Aufgaben zugeteilt bekommen und natürlich dafür auch mehr Leistung aufnehmen dürfen. Das ist alles bereits bekannt.

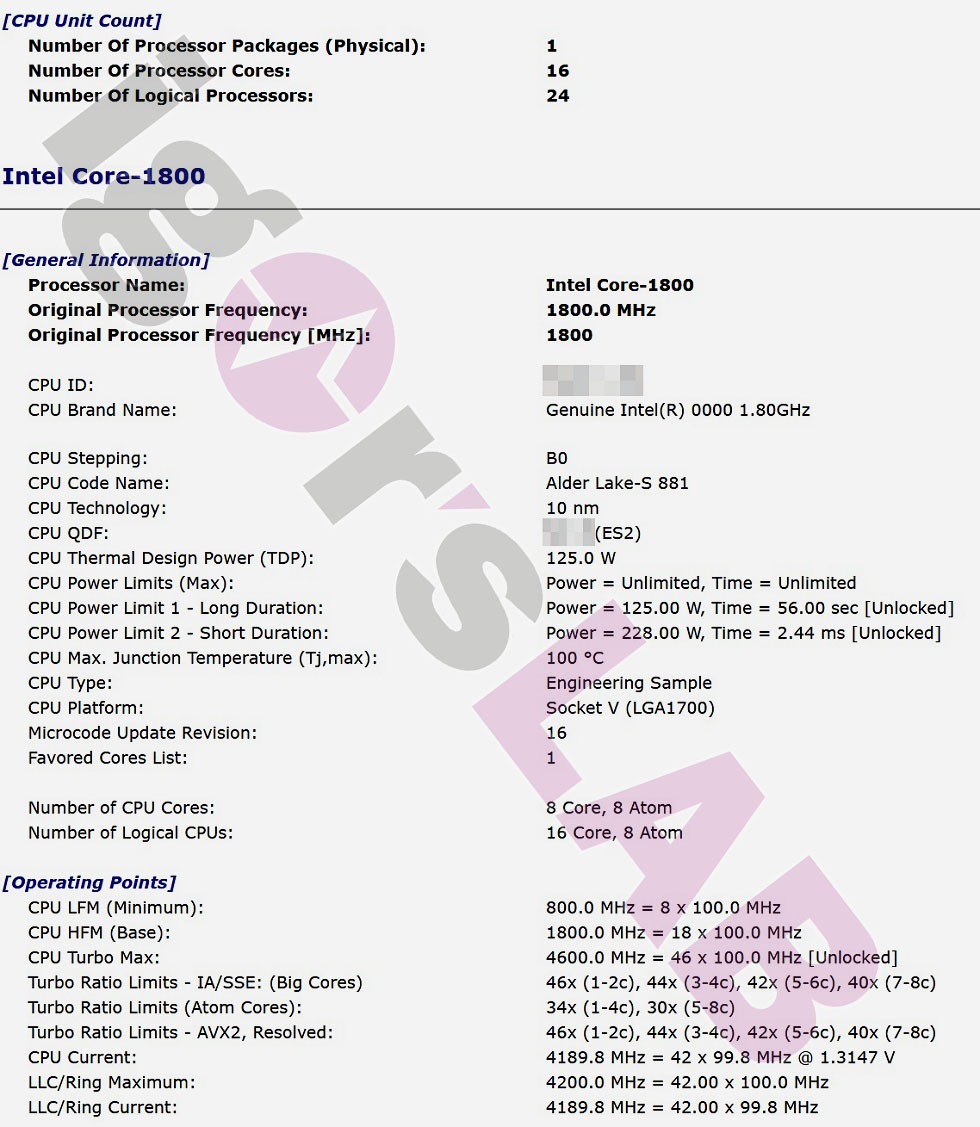

Beim heute vorgestellten ES des Core-1800 im (nicht finalen) B0-Stepping finden sich auf dem Die immerhin 8 große Golden Cove-Kerne (Core) und 8 kleine Gracemont-Kerne (Atom). Während die großen Cores auch Hyperthreading beherrschen, ist dies bei den Atom-Kernen nicht der Fall. In der Summe findet man also 16 Kerne vor, die maximal 24 Threads bearbeiten können. Der Leistungssprung gegenüber einer (leider nicht näher bezeichneten) konventionellen Lösung beziffert Intel laut diverser Leaks mit bis zu 20 Prozent in reinen Single-Thread-Szenarien und einer Verdoppelung der Multi-Thread-Performance im Idealfall, was aber dann doch recht optimistisch schein, wenn man einen aktuellen 8-Kerner der 11. Generation zugrunde legt.

Der intern als Intel Core-1800 bezeichnete Prozessor sitzt im neuen Socket V (LGA 1700) und besitzt eine TDP von 125 Watt. Den Screenshot unten, den ich leicht modifiziert habe, um die Quelle zu schützen, zeigt dazu für das PL1 eine Zeit von 56 Sekunden und für das PL2 von satten 228 Watt eine Peak-Zeit von 2,44 ms. Das diese Hoch- und Runterschalterei gut geeignet ist, um das eh schon nervöse Lastwechselverhalten der aktuellen Intel-CPUs noch weiter zu verschärfen, muss man ja noch nicht einmal extra erwähnen. Hier sind dann die Spannungswandler der Mainboards gefordert.

Die Revision B0 dieses ES ist noch recht früh und der Basis-Takt ist mit nur 1800 MHz auch noch recht niedrig angesetzt. Interessanter sind die Turbo-Boost-Limits der großen Kerne, wo 1-2 Kerne bereits jetzt 4.6 GHz erreichen sollen, bei 3-4 Kernen sind es noch 4.4 GHz, bei 5-6 kernen 4.2 GHz und bei allen 8 Kernen dann noch 4 GHz. Die kleinen Atom-Kerne takten mit bis 3.4 GHz bei <=4 ausgelasteten Kernen, sonst nur mit 3 GHz. Das Bild oben zeigt auch einen Spannungswert, den Intel bei 1.3147 V verortet. Der Rest ist selbsterklärend.

Die neuen Desktop-CPUs werden laut den ersten Informationen bis zu Dual-Channel-DDR5-4800-Speicher unterstützen und die DDR4-fähigen Mainboards Module mit bis zu 3200-MHz. Angeblich sollen nur die High-End-Z690-Mainboards DDR5-Unterstützung bieten, während aller günstigere Varianten noch auf DDR4 setzen. Dies gäbe dann Intel und auch den Motherboard-Herstellern deutlich mehr Flexibilität und Sicherheit, wenn es um die noch unklare DDR5-Massenproduktion geht.

Ein weiteres großes Upgrade, das mit Alder lake-S kommen wird, ist die Unterstützung für PCIeGen5. Die CPU wird 16 PCIe Gen5-fähige Lanes besitzen und dazu 4 Lanes im PCIe Gen4-Standard. Der 600er-Chipsatz selbst wird dann Gen4 und sogar noch Gen3 unterstützen. Außerdem wurde das Direct Media Interface (DMI) auf Gen4 aufgerüstet. Wenn es noch weitere Informationen gibt, werde ich Euch diese natürlich nicht vorenthalten. Man liest sich 🙂

63 Antworten

Kommentar

Lade neue Kommentare

Mitglied

Urgestein

Mitglied

Mitglied

Mitglied

Mitglied

Urgestein

Veteran

Veteran

Urgestein

Urgestein

Veteran

Urgestein

Mitglied

Urgestein

Mitglied

Veteran

Urgestein

Mitglied

Alle Kommentare lesen unter igor´sLAB Community →