Again Notebook Weeks at Igor’s Lab? Well, sort of yes and no, but I’ve now had the chance to at least take a longer inventory in direct comparison of two very similar notebooks, the one tested today containing the successor to the RTX 2080 Super Max-Q tested at the time. A notebook isn’t a desktop PC with a beast of a CPU and is also subject to thermal limits, so you have to find the perfect balance between CPU and GPU processing power. This is then packed into a notebook that is as flat as possible with an ultra HD display and touch function.

The Razer Blade Pro 15 used for this with the GeForce RTX 3080 in Max-Q design (95 watt variant) and an Intel Core i7-10875H CPU (2.30 GHz) is interesting in that you get a fast, sensitive display for Ultra-HD on the one hand and it can also serve as a touch panel and drawing board on the other. For this, however, you have to accept reflections, which can be avoided by clever positioning. Furthermore, you have to come to terms with the flat design and the resulting lack of an Ethernet port. If you need to push a lot of large content to a media server or the NAS, you won’t be happy with the WiFi alone here and should rely on an external USB-C adapter with at least Gigabit Ethernet, like I did.

However, the Max-Q design should not be confused with a dedicated chip, even though it is the same silicon. So today it’s a GeForce RTX 3080 that has to operate with an extremely limited power limit. The only question that remains is what effects this will have in practice. But that’s exactly why I have today’s test, which is supposed to show exemplarily where the journey can go further in the future due to GPU support with AI and CUDA.

Notebooks with Dynamic Boost and Studio Certification

For all RTX Studio laptops, NVIDIA sets the bar relatively high, but not too high. At least a GeForce RTX 2060, an Intel Core i7 (H-series) or higher, at least 16 GB, a fast SSD of 512 GB or more and a decent display with Full HD or Ultra HD resolution are required. The fact that Intel CPUs are used exclusively at the moment is certainly also due to the fact that AMD Dynamic Boost, although open source, is unfortunately completely ignored.

Because it ends up being (the very well performing) counterpart to AMD’s SmartShift technology found in the Ryzen Mobile 4000 and 5000 APUs. Both technologies are designed to take advantage of the fact that in many laptop designs, the GPU and CPU share a thermal budget, typically because they are both cooled by the same set of heat pipes. In practice, this is typically done to allow OEMs to build relatively thin and light systems where the cooling capacity of the system is more than the TDP of either the CPU or the GPU alone, but less than the total TDP of those two processors combined.

This way OEMs, like Razer in this case, can develop optimally adapted profiles for different scenarios, where one or the other component is given more leeway. So if both processors share a common cooling system, why not increase their power limits and then intelligently divide the system’s thermal budget? Dynamic Boost is a generic solution that also works on multiple platforms, while AMD’s SmartShift is designed solely and proprietarily for the combination of AMD APUs and GPUs to push (and lock down) the AMD ecosystem and their platform control structure. So Dynamic Boost could be used with both Intel’s Core processors and AMD’s Ryzen processors, except AMD doesn’t want it to. So that’s why there’s only an Intel CPU in the Razer Blade Pro 17 and no Ryzen.

Drivers as a solid foundation: Studio Drivers vs. Game Ready

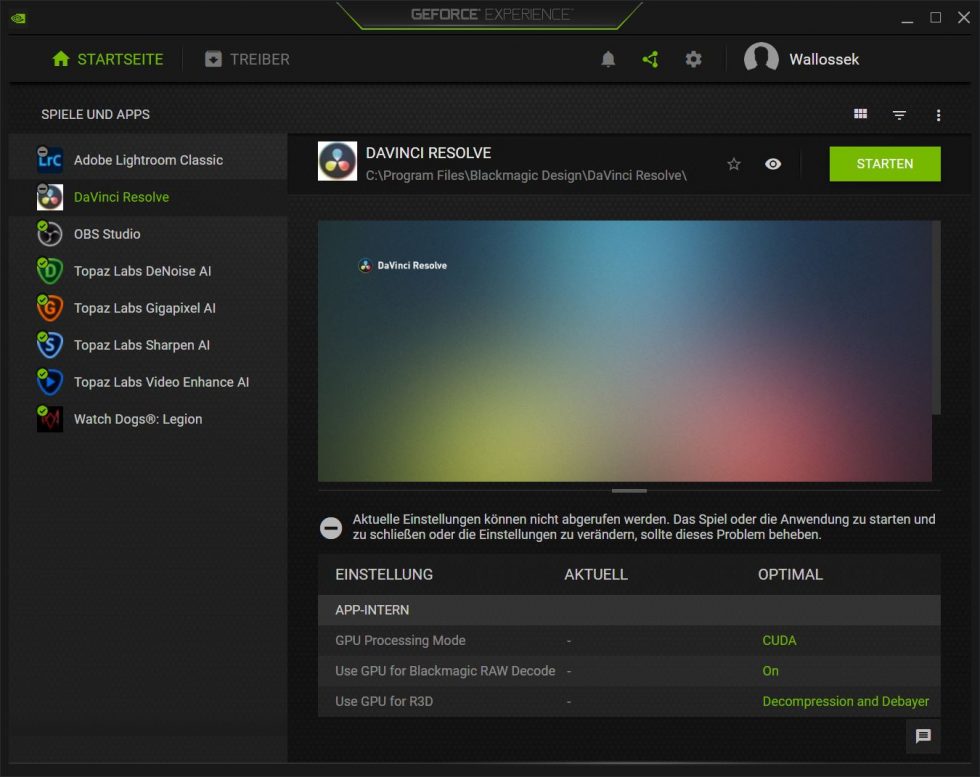

I’m not using the latest GameReady drivers for testing the notebook, but deliberately using NVIDIA’s Studio drivers. They don’t contain the latest game gimmicks, but they are stable and largely correspond to what NVIDIA provides for the Quadro cards, apart from the certified applications that (have to) rely on Quadro hardware. However, these drivers have been tested with many applications from the creative field, just as you would expect from workstation drivers. There’s also a new feature in GeForce Experience that automatically activates the right settings to maximize performance in creative apps. Currently, over 30 apps are supported, including Adobe Illustrator, Lightroom, Substance Designer, Autodesk AutoCAD, and DaVinci Resolve.

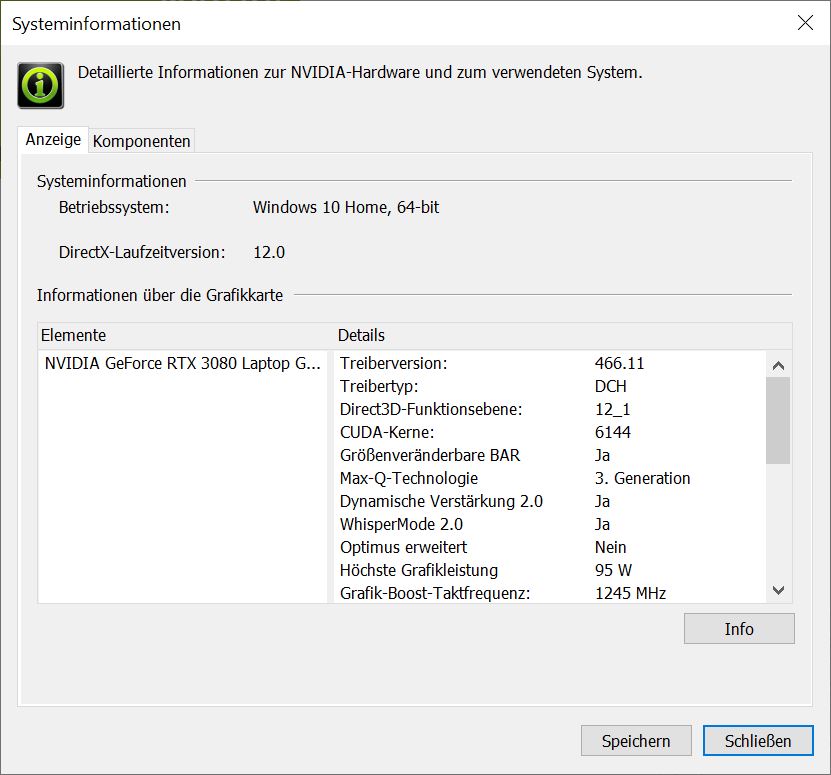

In the attached screenshot you can see the automatic optimization of the settings by configuring “GPU Processing Mode”, “Use GPU for Blackmagic RAW Decode” and “Use GPU for R3D” in DaVinci Resolve. With the optimal settings you can make sure that you can take full advantage of the studio products. Forgetting settings is, after all, a popular folk sport. And lest I forget, Resizeable BAR was available and active as well. Thanks to the last driver, just saw it and caught it. Up to 5% were feasible for suitable games, in the productive area the whitelist still has to be adapted or extended. It would certainly be worth it with the many textures to be loaded in many a studio app.

Test system and comparative values

The notebook was kindly provided by Razer and Notebooksbilliger on loan and has since been returned, so there were and are no obligations of any kind. It was important to create a portable counterpart to all the desktop solutions tested so far with a suitable product and to keep this comparable within the framework of the platforms used in each case, because my own notebook is unfortunately still based on an Intel CPU of the 9th generation. Generation and also Turing is not quite so starte-of-the-art anymore.

We still know the desktop system from all the other workstation tests in 2020:

| Test System and Equipment |

|

|---|---|

| Hardware: |

AMD Ryzen 9 5950X |

| Cooling: |

Alphacool Ice Block XPX Pro Alphacool IEISWOLFf (modified) |

| Case: |

Raijintek Paean |

| Monitor: | BenQ PD3220U |

| OS: | Windows 10 Pro (updated) |

21 Antworten

Kommentar

Lade neue Kommentare

1

Mitglied

Veteran

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Mitglied

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Mitglied

Urgestein

1

Urgestein

Alle Kommentare lesen unter igor´sLAB Community →