Test system and evaluation software

The benchmark system is new and is now not only in the lab, but also again as a double in the editorial office. I’m also going for PCIe 4.0, the right X570 motherboard in the form of an MSI MEG X570 Godlike (gaming benchmarks) and an MSI MEG X570 Ace (measurement lab) respectively, and a select Ryzen 9 5900X in each case, both water-cooled and overclocked to 4.7GHz. In addition, the matching DDR4 3800 RAM (Corsair, G.Skill) and several fast NVMe SSDs. For direct logging during all games and applications, I use NVIDIA’s PCAD, which adds to the convenience immensely.

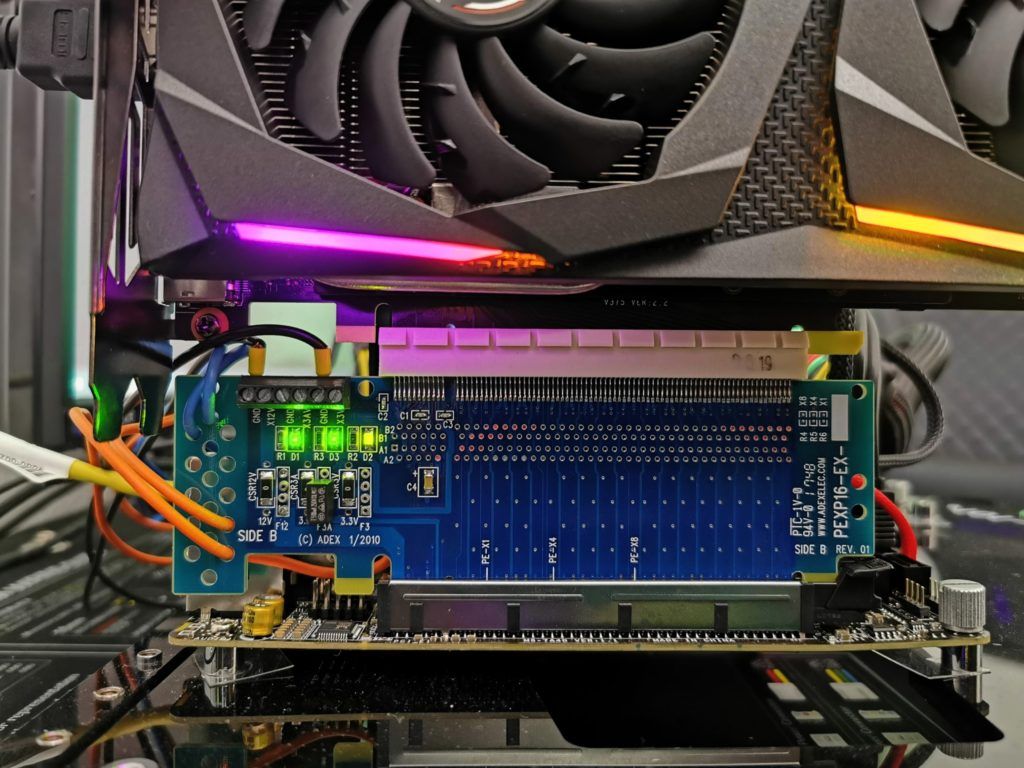

The measurement of the power consumption and other things takes place here in the special laboratory on a redundant and almost identical test system then double-tracked by means of high-resolution oscillograph technology…

…and the self-created MCU-based measurement setup for motherboards graphics cards (pictures below), where at the end in the air-conditioned room also the thermographic infrared images are created with a high-resolution industrial camera. The audio measurements are done outside in my chamber.

I have also summarized the individual components of the test system in a table:

| Test System and Equipment |

|

|---|---|

| Hardware: |

AMD Ryzen 9 5900X @4.7 GHz MSI MEG X570 Godlike / X570 Ace 2x 16 GB DDR4 3800, CL16 Be Quiet! Dar Power Pro 1200W |

| Cooling: |

Alphacool Ice Block XPX Pro Alphacool Ice Wolf (modified) Alphacool Subzero |

| Case: |

Raijintek Paean |

| Monitor: | BenQ PD3220U |

| Power Consumption: |

Oscilloscope-based system: Non-contact direct current measurement on PCIe slot (riser card) Non-contact direct current measurement at the external PCIe power supply Direct voltage measurement at the respective connectors and at the power supply unit 2x Rohde & Schwarz HMO 3054, 500 MHz multichannel oscilloscope with memory function 4x Rohde & Schwarz HZO50, current clamp adapter (1 mA to 30 A, 100 KHz, DC) 4x Rohde & Schwarz HZ355, probe (10:1, 500 MHz) 1x Rohde & Schwarz HMC 8012, HiRes digital multimeter with memory function MCU-based shunt measuring (own build, Powenetics software) NVIDIA PCAT and FrameView |

| Thermal Imager: |

1x Optris PI640 + 2x Xi400 Thermal Imagers Pix Connect Software Type K Class 1 thermal sensors (up to 4 channels) |

| Acoustics: |

NTI Audio M2211 (with calibration file) Steinberg UR12 (with phantom power for the microphones) Creative X7, Smaart v.7 Own anechoic chamber, 3.5 x 1.8 x 2.2 m (LxTxH) Axial measurements, perpendicular to the centre of the sound source(s), measuring distance 50 cm Noise emission in dBA (slow) as RTA measurement Frequency spectrum as graphic |

| OS: | Windows 10 Pro (all updates, current certified drivers) |

- 1 - Introduction, Unboxing and Technical Data

- 2 - Test System and Methods

- 3 - Teardown, PCB Analysis and Cooler

- 4 - Gaming Performance WQHD + FHD/RTX

- 5 - Gaming Performance Ultra-HD/DLSS

- 6 - Detailled Metrics and Graphics for all Games

- 7 - Frame Times vs. Power Draw

- 8 - Power Draw and Efficiency for all single Games

- 9 - Power Consumption Summary and Hi-Res Measuring

- 10 - PEG, Transients and PSU Recommendation

- 11 - Temperatures and Thermal Imaging

- 12 - Noise, Frequency Analysis and Audio-Sample

- 13 - Summary and Conclusion

15 Antworten

Kommentar

Lade neue Kommentare

Veteran

Veteran

Veteran

Mitglied

Urgestein

Mitglied

Veteran

Veteran

Veteran

Mitglied

Urgestein

Urgestein

Urgestein

Urgestein

Alle Kommentare lesen unter igor´sLAB Community →