Über die Ankündigung zu DLSS 2.0 Ende März samt Deep Learning hatte ich je bereits einen Artikel geschrieben. DLSS 2.0 wurde bisher in allen vier Spielen, in denen es verfügbar ist, sehr positiv beurteilt. Im Gegensatz dazu schwächelte ja die erste Implementierung von Deep Learning Super Sampling ein wenig und glänze eher mit sehr gemischte Ergebnissen. Das reichte dann von knackig bis wischiwaschi und verschwommen, je nach Spiel und Umsetzung. Auch wenn die GTC dieses Jahr nicht in echt stattfand, eine Online-Version gab es wohl, wo man sich auch akkreditieren konnte.

Und für alle Neugierigen, die es auch etwas genauer wissen wollten, hatte der leitende Forschungswissenschaftler von NVIDIA, Edwin Liu, in einem Vortrag im Rahmen der virtuellen GTC 2020, der kürzlich auch auf der NVIDIA-Website veröffentlicht wurde, genauer ausgeführt, was NVIDIA DLSS 2.0 zu einem so großen Upgrade gegenüber der Vorgängerversion macht. Es war eine sehr interessante Präsentation, aus der man am Ende nur das Wichtigste extrahiren muss, um sich nicht allzusehr im Detail zu verlieren.

Hier könnt Ihr das fast 50-minütige Video selbst ansehen.

Fassen wir es kurz zusammen Es gibt zwei mögliche Ansätze für das Rendern von Bildern in Superauflösung, als Einzelbild oder als Multi-Frame. Ersteres wird vielleicht häufiger verwendet und ist damit auch bekannter, da in der Regel reine Interpolationsfilter zum Einsatz kommen. Das kennen wir auch vom normalen Upscaling von Videoinhalten in verschiedenen Software-Applikationen oder Hardwareumsetzungen (z.B.TV-Geräte). In letzter Zeit werden jedoch tiefe neuronale Netzwerke verwendet, um neue Pixel nach dem Training zu “halluzinieren”, also quasi zu reproduzieren. Ein sehr gutes Beispiel dafür ist übrigens auch ESRGAN, das Enhanced Super-Resolution Generative Adversarial Networks-Modell, auf dem mehrere KI-erweiterte Texturpakete für ältere Spiele basieren.

Die durch einfache Interpolationsfilter rekonstruierten Bilder sind, einfach ausgedrückt, im Vergleich zum nativen Bild zu wenig detailliert. DNNs leisten in dieser Hinsicht eine bessere Arbeit, aber da sie die neuen Pixel “halluzinieren”, kann das Ergebnis mit dem nativen Bild durchus auch einmal inkonsistent sein. NVIDIA hält dies für DLSS jedoch für inakzeptabel, da das Ziel darin besteht, so nah wie möglich am “Ground Truth”-Bild und an der ursprünglichen Vision des Spieleentwicklers zu bleiben.

Ein weiteres großes Problem ist, dass das resultierende Bild oft zeitlich instabil ist, also flimmert und flackert. Deshalb hat sich Nvidia bei DLSS 2.0 für einen Multi-Frame-Superauflösungsansatz entschieden. Dadurch können mehrere niedrig aufgelöste Frames zu einem hochauflösenden Bild zusammengefügt werden, was die Wiederherstellung echter Details wesentlich erleichtert. Dies geschieht mit räumlich-zeitlichen Upsampling-Techniken wie dem inzwischen allgegenwärtigen Temporal Antialiasing und dem Checkerboard-Rendering.

Da diese Rekonstruktionstechniken Samples aus mehreren Frames verwenden, ist es sehr viel unwahrscheinlicher, dass sie auf zeitliche Instabilitätsprobleme wie Flackern stoßen. Darüber hinaus wird zwar für jeden Frame die Schattierungsrate niedrig gehalten, um eine starke Leistung zu erzielen, aber die effektive Abtastrate wird aufgrund des Multi-Frame-Rekonstruktionsansatzes drastisch erhöht. Das heißt nicht, dass es keine Probleme mit TAA oder CR gibt. Da es beim Rendern von Spielen in Echtzeit inhaltliche Änderungen gibt (die Szenen sind schließlich kontinuierlich dynamisch), könnte die naive Annahme, dass frühere Frames korrekt sind, leicht zu Artefakten wie Geisterbildern oder Verzögerungen führen.

In der Regel werden diese Probleme mit einer heuristisch basierten Historienkorrektur der ungültigen Samples aus früheren Frames behandelt. Das bringt jedoch auch andere Probleme mit sich, wie Flackern, Unschärfe und der gehasst-gefürchteten Moiré-Muster. Nvidia löst diese Probleme, indem man die Leistung eines Supercomputers ausnutzt, der offline an Zehntausenden von Bildern mit extrem hoher Qualität trainiert wird. Diese sogenannten neuronalen Netzwerke sind für eine solche Aufgabe einfach viel besser geeignet als einfache Heuristiken, da sie die optimale Strategie finden können, um über mehrere Bilder gesammelte Erkenntnisse zu kombinieren und so im Endergebnis eine viel hochwertigere Rekonstruktionen liefern können.

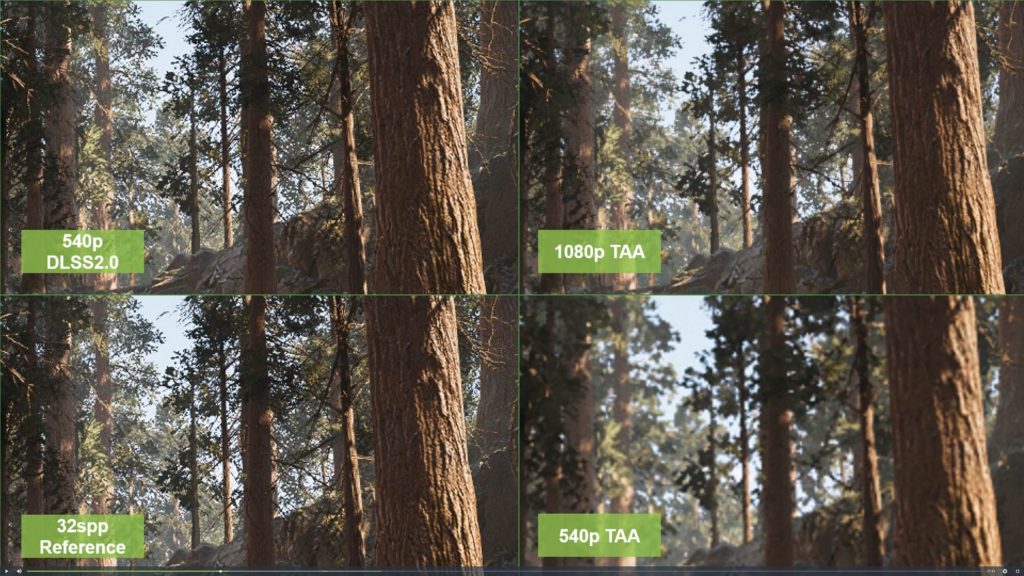

Es handelt sich somit um einen datengesteuerten Ansatz, der es DLSS 2.0 ermöglicht, selbst komplexe Situationen wie die mit dem Moiré-Muster erfolgreich zu rekonstruieren. Die folgenden Bildvergleiche sind durchweg beeindruckend und übertreffen selbst native Bilder in den meisten Fällen bei einer 4-fachen Hochskalierung von 540p auf 1080p.

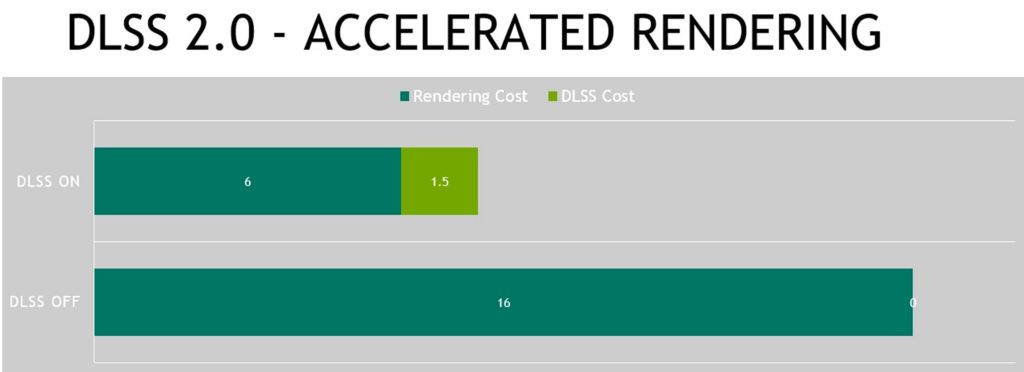

Natürlich ist es Nvidias erklärte Maxime, mit DLSS 2.0 eine optimale Leistung mit möglichst geringem Overhead zu erzielen. Die zusätzliche Leistung, die dafür benötigt wird, ist fast schon unbedeutend, da es auf einer GeForce RTX 2080Ti nur 1,5 Millisekunden dauert, wenn ein Bild bei einer Auflösung von 4K gerendert wird. Dzu kommt, dass das Hinzufügen von DLSS 2.0 für Spieleentwickler deutlich vereinfacht wird. Und da geht es nicht nur um die Unreal-Engine 4 und darum, dass das verallgemeinerte neuronale Modell nicht mehr pro Spiel einzeln trainiert werden muss, sondern vor allem darum, dass der Multi-Frame-Ansatz es erlaubt, DLSS 2.0 in all jenen Spielen und Engines zu implementieren, die bereits Temporal Antialiasing (TAA) unterstützen.

Es wird interessant sein, wie sich diese Techniken weiterentwickeln werden, also ich finde es wirklich spannend.

Kommentieren