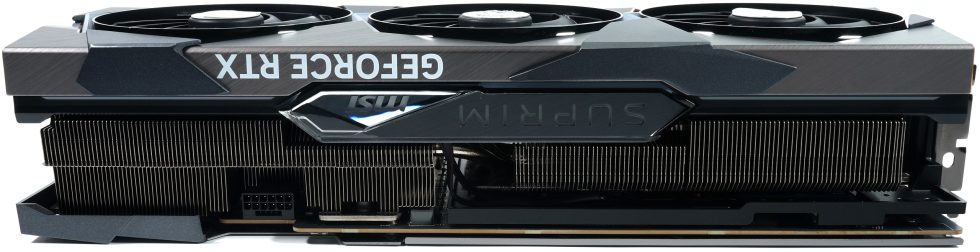

Gestern durften wir zwar die ersten eigenen Bilder von NVIDIAs kommender Grafikkarten-Generation veröffentlichen, müssen jedoch bis zum festgelegten Launchtag noch über weitere Details bis hin zur Performance schweigen. Dabei wäre etwas Aufklärung (sicher auch im Sinne NVIDIAs) dringend nötig. Denn der Aufschrei über die riesigen, schweren Kühllösungen nach den ersten Unboxing-Artikeln und -Videos war wirklich enorm. Das ganze Ausschütten von Gehässigkeiten über vermeintliche Stromfresser, überforderte Netzteile und Lastspitzen, die höher als der Mount Everest sein sollen, wäre schon längst erledigt, würde man die Hintergründe besser kommunizieren.

Doch woher kommen die kolportierte hohe TBP von 600 Watt und die damit einhergehende Notwendigkeit, diese Unmenge an Abwärme auch adäquat kühlen und sich noch ein neues Netzteil kaufen zu müssen? Und warum sind es jetzt plötzlich doch nur noch 450 Watt, wie überall berichtet wird? Die Antwort ist zwar simpel, aber der Grund ist leider nie offen kommuniziert worden. Dabei hätte sich NVIDIA sicher viel Häme und Spott ersparen können. Dazu muss ich einmal etwas weiter ausholen, denn auch ich hatte ja bereits einige Artikel zum Thema Leistungsaufnahme und Abwärme geschrieben.

Der eigentliche Grund für die ursprünglich angesetzten 600 Watt Default Power Limit liegen hier bei Samsung und dem sehr ineffizienten, alten 8-nm-Node, für den Ada seinerseits geplant wurde. Um die für die Steigerung der Performance notwenigen Takterhöhungen überhaupt realisieren zu können, wäre genau diese Menge an Energie notwendig gewesen. Und weil man Grafikkarten langfristig planen muss und sich natürlich dann auch im Vorfeld alle Beteiligten wie z.B. die ganzen Boardpartner (AIC) mit ins Boot holt, sind die ganzen Eckdaten natürlich immer das Worst-Case-Scenario einschließlich aller nötigen Reserven.

Wo die 600 Watt der NVIDIA GeForce „RTX 4090“ eigentlich herkommen – eine Schätzung von GPU und Komponenten

Hätte NVIDIA die neue Generation wirklich bei Samsung im 8-nm-Prozess fertigen müssen, dann wäre dieser Artikel heute natürlich überflüssig gewesen. Denn passend zu den kolportierten 600 Watt Leistungsaufnahme wurden damals auch alle Designs und Komponenten entwickelt, weil man dafür nun einmal den nötigen Vorlauf von einigen Monaten braucht. Tja, und dann kam TSMC. Der Wechsel von Samsung auf TSMCs deutlich besseren 4-nm-Prozess ist hier der absolute Wendepunkt einschließlich der (positiven) Folgen, die so keiner voraussehen konnte.

Laut meinen eigenen Quellen in Taiwan ist die Yield der produzierten Chips dermaßen hoch, dass nicht nur die Menge dessen, was man effektiv verwerten kann, höher ausfiel als erwartet, sondern auch die Qualität der Chips. Damit war man wohl auch in der Lage, die Leistungsaufnahme für das angestrebte Performance-Ziel deutlich senken (man kolportiert hier um die 33 Prozentpunkte) und liegt somit ungefähr auf dem Niveau der (noch) aktuellen Generation.

Basierend auf dem seinerzeit an die Boardpartner und Drittanbieter verteilten Thermal Design Guide wurden jedoch alle Kühllösungen auf die wirklich extrem hohen 600 Watt ausgelegt. Ich schrieb ja auch in einem älteren Artikel, dass die GeForce RTX 3090 Ti die Spielwiese für die neuen Grafikkarten sein sollte und man den Pin-kompatiblen GA102 mittels passender Firmware auf 600 Watt in den Test Vehicles aufgebohrt hatte, um die elektrischen und thermischen Probleme im Vorfeld sinnvoll evaluieren zu können.

Wenn man heute die verantwortlichen Entwickler bei den AIC fragt, dann hätten diese sich den kühltechnischen Stunt sicher gern erspart. Man hätte, das sollen wohl auch interne Tests zeigen, auch mit den bereits existierenden Kühllösungen für die GeForce RTX 3090 Ti locker hinkommen können. Doch es wird stets geliefert, was bestellt wurde und so werden wir mit Sicherheit auch viele Karten sehen, deren TBP die kolportierten neuen 450 Watt noch einmal etwas überschreiten werden. Nicht, weil sie es müssten, sondern weil sie es einfach können. Reserven sind ja genügend vorhanden, auch zum Übertakten und als grafischer Ersatz für die teure Gasheizung. Wobei man hier sehr schnell an die Spannungslimits bei der VDDC stoßen dürfte, was eine Erhöhung auf Werte über 500 Watt eigentlich überflüssig machen dürfte.

Denn die VF-Curves sollen ja auch nur bis 450 Watt reichen, egal mit welchem Limit eine Karte verkauft wird und der Rest ist dann nur Heizung pur. Mehr Details kann ich hier nicht nennen, denn es gibt leider auch Sperrfristen und ich berichte ja nur über die Meldungen Dritter.

Zu diesen durchgestochenen Informationen aus der Zubehörindustrie und den AIC passt auch, dass man wohl die Leistungsaufnahme der kommenden GeForce RTX 4080 16 GB von den anfänglichen 420 Watt auf 340 und später sogar noch auf 320 Watt abgesenkt haben soll und die Karte trotzdem schneller als erwartet sein könnte. Man hat sich als AIC also Kleider im XXXL-Format bestellt, die durch den plötzlichen Wechsel des Nahrungslieferanten und dem damit einhergehenden Gewichtsverlust am Ende dann viel zu groß ausfielen. Doch es gibt in industriellen Prozessen nun einmal einen Point of no Return, so dass jetzt eben alles so ist, wie es ist.

Das kann man als potentieller Käufer auch positiv sehen, denn es ist davon auszugehen, dass alle Kühler überdurchschnittlich souverän und leise arbeiten werden. Allerdings sollen wohl einige Boardpartner intern jammern, dass man sich die kolportieren Mehrkosten von stellenweise deutlich mehr als 10 USD pro Kühler gern gespart hätte. Rechnet man das nämlich auf die zu produzierenden Einheiten hoch, kommen da ganz schnell wirklich riesige Summen zustande.

Doch das Aufbäumen des letzten monolithischen Jumbo-Jets in Richtung Effizienz könnte durchaus auch andere prominente Opfer fordern als nur verbogene Motherboards mit heruntergezogenen Mundwinkeln. Der für einige sicher unerwartete Effizienzschub könnte wohl auch AMDs nächste Generation ein wenig ins Schleudern bringen, denn diese setzt nicht auf TSMCs neuesten Node, sondern auf eine Mischung aus älteren Prozessen für GCD und Chiplets.

AMD Radeon RX 7900XT – Mögliche Platine und neue Erkenntnisse

Genau an dieser Stelle kommt nun noch ein Spekulatius von mir, der vielleicht auch erklärt, warum NVIDIA aus der ursprünglich wohl so geplanten RTX 4070 eine kastrierte RTX 4080 12GB macht. Zwischen beiden RTX 4080 ist nämlich noch sehr viel Platz und es passt mehr dazwischen, also nur ein dünnes Blatt Papier. Zum Beispiel ein fetter Navi-31-Karton. NVIDIAs Spionage Investigativ-Abteilung lag in den letzten Jahren nämlich sehr selten falsch und so wäre ein grünes Sandwich eigentlich mehr als nur Schadenfreude, sondern fast schon eine Provokation. Ich maße mir nicht an, AMDs nächste Generation wirklich einschätzen zu können, aber nach allen vorliegenden Informationen dürfte es mit den älteren Nodes kaum möglich sein, die angestrebte Leistungsaufnahme zu schaffen UND die Performance so zu steigern, wie es NVIDIA dank TSMC vielleicht geschafft haben könnte.

Wie gesagt, es ist eine rein spekulative Mutmaßung aber nicht ganz ohne Hintergrund. Aber ein klein wenig Ehrfurcht habe ich vor dem Prozesswechsel dann noch, denn man könnte neben solchen Jumbos wie der GeForce RTX 4090 sicher auch hocheffiziente kleinere Kunstflieger für die grafische Mittelklasse fabrizieren, die auch als reine Monolithen im Ein-Chip-Design noch eine Weile existieren dürften. Falls sich NVIDIA herablässt, neben den Leuchtturmprojekten auch die Befriedigung des Performance-geilen Pixel-Proletariats zu priorisieren. Der Herbst wird spannend, der Winter nicht ganz so kalt und das Frühjahr erst recht interessant – je nach Geldbeutel und Finanzierungswillen. Womit sich wohl auch der aktuellen Farblehre noch nichts gravierend ändern würde. Aber ich lasse mich immer gern positiv überraschen.

Ergänzung und Korrektur: Auf nochmalige Nachfrage bei meiner Quelle wurde mir Samsungs aktueller Node als Bezug für die 600 Watt genannt, nicht aber explizit der alte 8-nm Prozess.

427 Antworten

Kommentar

Lade neue Kommentare

Urgestein

Urgestein

1

Urgestein

Mitglied

Urgestein

Veteran

Urgestein

Veteran

Urgestein

Mitglied

Urgestein

Veteran

Urgestein

Veteran

Mitglied

Urgestein

Veteran

Alle Kommentare lesen unter igor´sLAB Community →