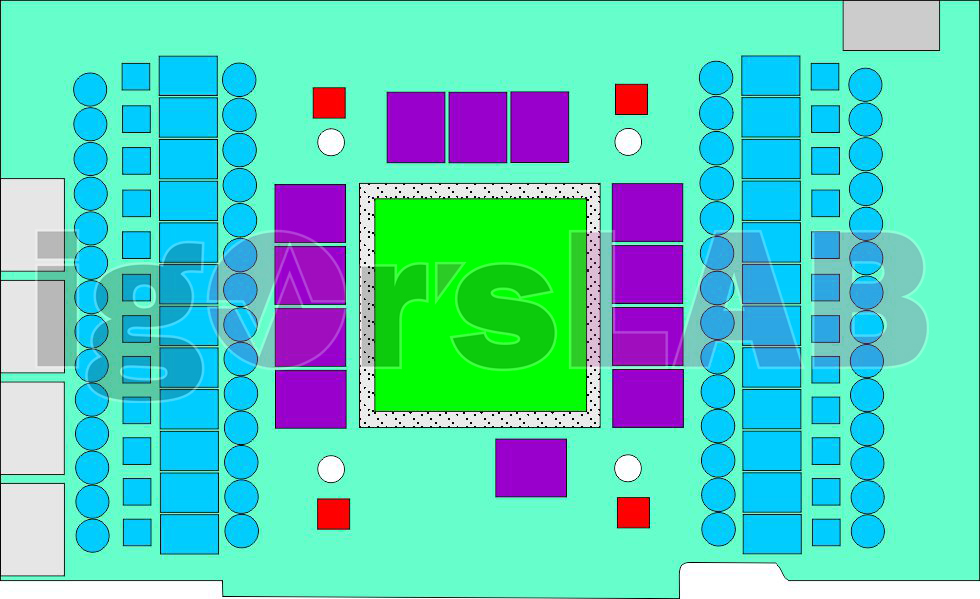

Auch dieses Mal werde ich versuchen, die Leistungsaufnahme einzelnen Komponenten hochzurechnen, um daraus auf die Leistungsaufnahme der GPU schließen zu können. Bei Turing lag ich fast aufs Watt genau richtig und auch diesmal stellt einen die Platine, so sie denn wirklich so kommen wird, vor keine Rätsel. Man kann, basierend auf der GeForce RTX 3090 Ti und deren Schaltungsdesign, durchaus interessante Details ableiten, aber dazu gleich mehr. Was mit die Boardpartner jedoch auch bestätigt haben, ist der Umstand, dass die Platinen der GeForce RTX 3090 Ti zwar denen der neuen Generation ähneln werden, sich jedoch nicht 1:1 verwenden lassen.

Spekulationen darüber, dass man später nur den Pin-kompatiblen Chip austauschen müsse, sollen so nicht stimmen, auch wenn sie dem Wunschdenken vieler Hersteller natürlich entgegen kommen würden. Ganz so einfach scheint es am Ende dann also doch nicht zu sein und es läge an einigen, durchaus wichtigen und abweichenden Details. Alter Chip auf neuem PCB ja, aber umgekehrt nein. Dass man aber parallel mit dem “alten” GA102 mangels echter Engineering Samples der neuen GPUs schon auf den ebenfalls neuen Platinen experimentiert, das wird nirgendwo bestritten. Die RTX 3090 Ti ist also quasi “Ada’s Playground”, ein neues Strategiespiel in Echtzeit mit RTX On. Nicht mehr und nicht weniger.

Aber ich bin für die GeForce RTX 3090 Ti durchaus dankbar, weil man sehr viele Dinge recht genau ableiten kann. Und genau da kommen wir wieder zurück zum Thema. Neben der TBP als Total Board Power gibt es noch die TGP als Total Graphics Power aus Nvidias Sicht. Das weicht zwar inhaltlich in kleinen Details etwas ab (TGP ist stets ohne 3.3 Volt), kommt aber zumindest bei den Größenordnungen noch recht gut hin. Erinnert Ihr Euch an meinen Artikel “Leistungsaufnahme: TDP, TBP und TGP bei Nvidia und AMD-Grafikkarten nachgerechnet samt Zerstörung einer PR-Folie“? Den sollte man gern auch noch einmal zum besseren Verständnis lesen.

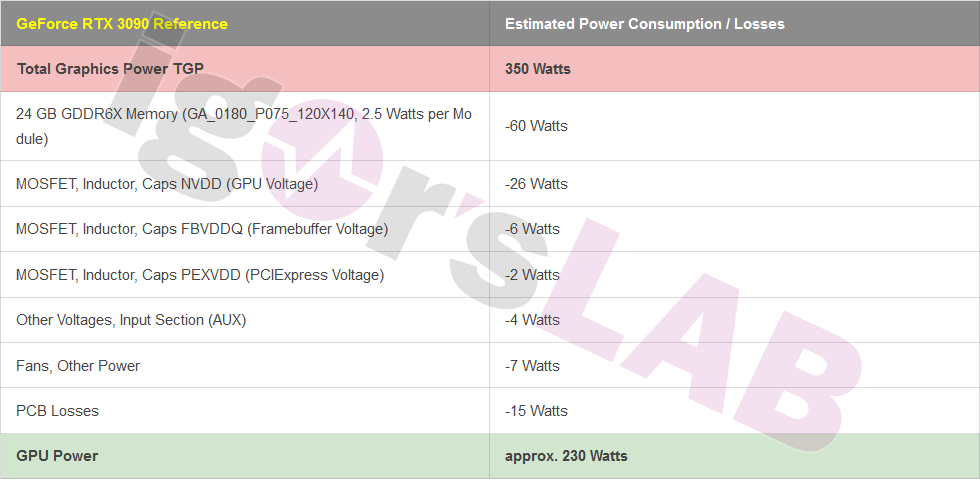

Die damalige Schätzung der GeForce RTX 3090 mit 350 Watt (Referenz)

Ich bin seinerzeit für meine Schätzung der GeForce RTX 3080 und später auch der RTX 3090 in diversen Foren angefeindet worden, wobei ich die Gründe des aufgekommen Unverständnisses nicht kommentieren möchte. Nur kommt Kraft nun einmal von Kraftstoff und am Ende lag ich bei meinen Kalkulationen fast aufs Watt genau richtig. Schauen wir noch einmal uns die (stark vereinfachte) Zusammenfassung der wichtigsten Baugruppen der alten GeForce RTX 3090 mit dem GA102 einmal an:

Die 230 Watt sind für so ein Rechenmonster eigentlich noch recht manierlich, wenn man impliziert, dass hier auch der Takt weit ausgefahren wird.

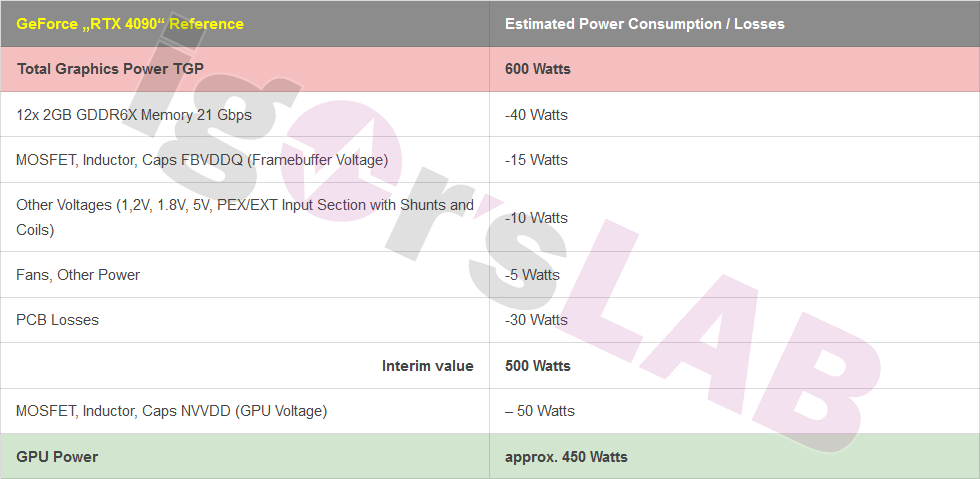

Die neue Hochrechnung für die GeForce “RTX 4090”

Diesmal sind es bei der großen Ada-Karte (ob diese nun RTX 4090 heißen wird oder nicht) immerhin 600 Watt, die als gesetzt gelten dürften. Auch diesmal will Euch herunterrechnen, wie viel dann noch auf den Chip entfallen könnte. Und genau jetzt wird es interessant, denn man kann Spannungswandlerverluste, Kleinspannungen und sonstige Verluste anhand der letzten Generationen recht gut hochrechnen. Gut, den Speicher habe ich explizit nachgefragt, denn ich bin ja kein Hellseher. Mit 3,4 Watt pro Modul (laut meinen Informationen) liegt Micron im Rahmen dessen, was man durch den gestiegenen Takt sowieso erwarten konnte. Der Speicherausbau selbst ist dabei eher sekundär. Das macht in der Summe für 24 GB (12 Module) dann nur noch rund 40 bis 41 Watt, statt der 60 Watt auf der GeForce RTX 3090.

Die vier Spannungswandler des Speichers sollten in dieser einfachen Ausführung einen Wirkungsgrad von ca. 60 bis 70% aufweisen, ich plane hier zusammen mit den beteiligten Komponenten rund 15 Watt an Verlusten für die gesamte Schaltung einschließlich der MOSFETs, Spulen und Caps mit ein. Das ist nicht wenig, aber auch nicht unüblich. Bei den Kleinspannungen mit den üblichen 1.2 Volt, 1.8 Volt, 5 Volt und den anderen Dingen wie der MCU, den Shunts, der Filterung der Rails usw. setze ich ca. 10 Watt an, für die Lüfter durchschnittliche 5 Watt, wobei hier auch gemunkelt wurde, dass sie nicht direkt ins Limit mit einfließen würden.

Rechnet man die Leistungsaufnahme hoch und schaut sich die Tracks an, kann man wohl ungefähr fast auch von einer Verdopplung der Platinenverluste ausgehen, da mehr Phasen auch mehr Leiterzüge bedeuten. Die Spannungswandler der GPU-Spannung (NVVDD), wenn sie denen der 3090 Ti stark ähneln, sollten einen Wirkungsgrad von ca. 90% ausweisen, womit wir bei ca. 50 Watt angelangt wären. Auch das ist in etwa das Doppelte dessen, was die RTX 3090 in Wärme umgesetzt hat, denn es blieben für die GPU dann ungefähr 450 Watt übrig. Ins Verhältnis gesetzt, nähme dann der AD102 in etwa auch nur etwas weniger als das Doppelte an elektrischer Leistung auf.

Die nachfolgende Tabelle zeigt noch einmal den Werdegang der Kalkulation:

Wie gesagt, so Einiges ist mit Sicherheit auch spekulativ, logisch gefolgert oder zumindest langweilige Rechenkunst, aber ich kann Euch auch versichern, dass ich mich nur ungern aus dem Fenster lehne, wenn ich solche Dinge veröffentliche. Das ist also alles kein Hexenwerk oder ein leichtsinniges Leak, sondern eher trivial nachgedacht und auch nachgefragt. Aber es klappt diesmal dank der GeForce RTX 3090 Ti viel einfacher und besser. Und manche Dinge werde ich auch (noch) nicht schreiben, weil es sich einfach nicht gehört.

Deshalb überlasse ich es auch den Kommentatoren und Kollegen, von diesem Wert in etwa auf die tatsächliche Rechenleistung oder Grafikperformance zu schließen. Da ich es nicht weiß bzw. wissen darf, halte ich mich hierbei besser vornehm zurück. Es darf also gern gerätselt und gestritten werden.

38 Antworten

Kommentar

Lade neue Kommentare

Veteran

Urgestein

Urgestein

1

Urgestein

Veteran

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Mitglied

Veteran

Veteran

Urgestein

Alle Kommentare lesen unter igor´sLAB Community →