Once again, I will try to extrapolate the power consumption of individual components to be able to conclude the power consumption of the GPU. I was almost right on the money with Turing and also this time the board design, if it will really come like this, does not pose any riddles. It is possible to derive quite interesting details based on the GeForce RTX 3090 Ti and its circuit design, but more on that in a moment. However, what the board partners have also confirmed with me is the fact that the boards of the GeForce RTX 3090 Ti will be very similar to those of the new generation, but they cannot be used 1:1.

Speculations about only having to replace the pin-compatible chip later on are said to be untrue, even though they would of course meet the wishful thinking of many manufacturers. In the end, it doesn’t seem to be quite that simple after all, and it would be due to some quite important and deviating details. Old chip on new PCB yes, but vice versa no. However, the fact that the “old” GA102 is already being experimented with on the new boards due to the lack of real engineering samples of the new GPUs is not disputed anywhere. The RTX 3090 Ti is thus virtually “Ada’s Playground”, a new strategy game in real time with RTX On. No more and no less.

But I am quite grateful for the GeForce RTX 3090 Ti because you can derive a lot of things quite accurately. And that’s where we come back to the topic. Besides the TBP as Total Board Power, there is also the TGP as Total Graphics Power from Nvidia’s point of view. This deviates somewhat in terms of content in small details (TGP is always without 3.3 volts), but at least in the orders of magnitude it still comes out quite well. Do you remember my article “Power consumption: TDP, TBP and TGP of Nvidia and AMD graphics cards recalculated including destruction of a PR slide“? I also recommend you read it again for a better understanding.

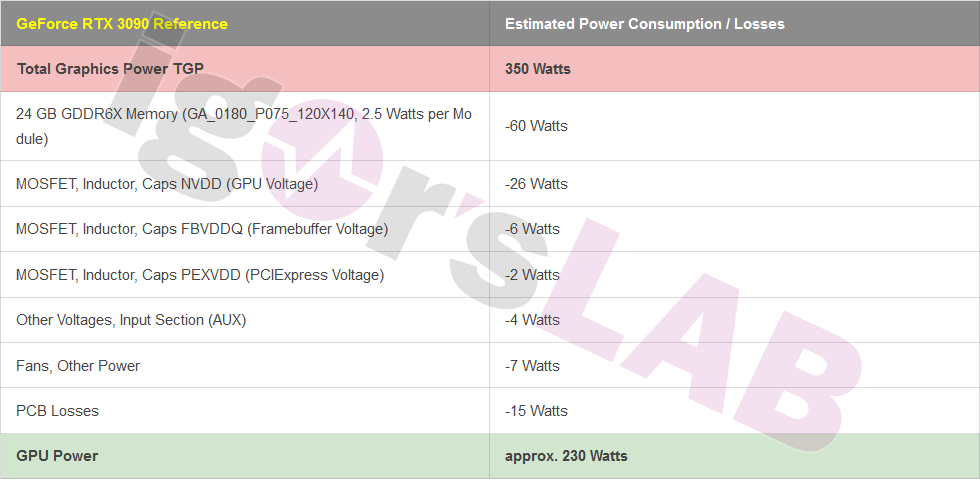

The estimate of the GeForce RTX 3090 with 350 watts (reference) at that time

At the time, I was attacked in various forums for my estimate of the GeForce RTX 3080 and later also the RTX 3090, although I do not want to comment on the reasons for the incomprehension that arose. But power comes from fuel, and in the end I was almost exactly right in my calculations. Let’s take another look at the (highly simplified) summary of the old GeForce RTX 3090’s most important components with the GA102:

The 230 watts are actually still quite acceptable for such a computing monster, if you imply that the clock is also extended far here.

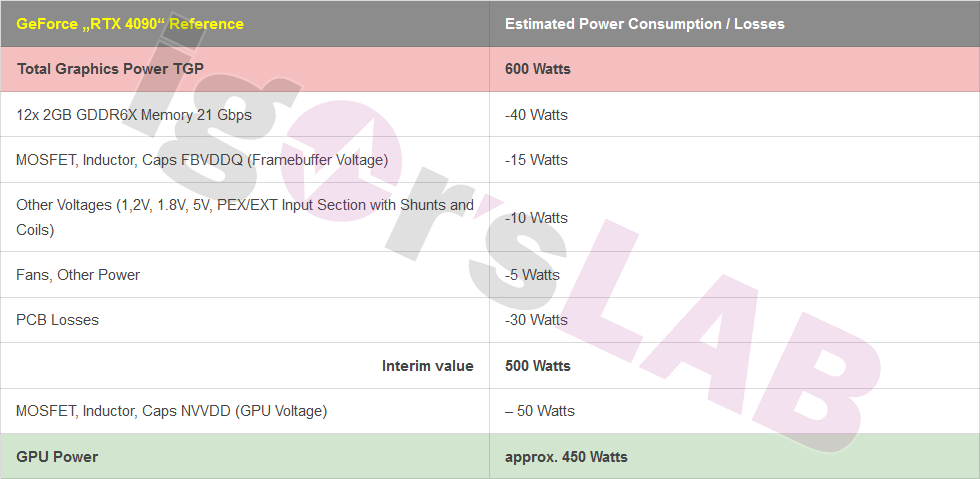

The new projection for the GeForce “RTX 4090”

This time, the large Ada card’s board power TGB (whether it will be called RTX 4090 or not) is 600 watts, which should be considered as set. Again this time we want to calculate down how much could then still left for the chip itsself. And this is where it gets interesting, because you can extrapolate voltage transformer losses, extra-low voltages and other losses quite well based on the last generations. Well, I explicitly asked about the memory, because I’m not a psychic. With 3.4 watts per module (according to my information), Micron is within the bounds of what could be expected anyway due to the increased clock. The storage expansion itself is rather secondary. That makes a total of only about 40 to 41 watts for 24 GB (12 modules), instead of the 60 watts on the GeForce RTX 3090.

The four voltage converters of the memory should have an efficiency of about 60 to 70% in this simple design, I plan here together with the involved components about 15 watts of losses for the whole circuit including the MOSFETs, coils and caps. This is not little, but also not unusual. For the low voltages with the usual 1.2 volts, 1.8 volts, 5 volts and the other things like the MCU, the shunts, the filtering of the rails, etc., I put about 10 watts, for the fans an average of 5 watts, although it was also rumored here that they would not be directly included in the limit.

If you extrapolate the power consumption and look at the traces, you can almost assume a doubling of the board losses, since more phases also mean more conductor traces. The GPU voltage converters (NVVDD), if they are very similar to those of the 3090 Ti, should show an efficiency of about 90%, which would bring us to about 50 watts. This is also about double what the RTX 3090 converted into heat, and it would then leave about 450 watts for the GPU. In relation to this, the AD102 would only consume slightly less than twice the electrical power.

The following table once again shows the process of the calculation:

As I said, some things are certainly speculative, logically deduced or at least boring math, but I can also assure you that I am reluctant to go out on a limb when I publish such things. So none of this is witchcraft or a careless leak, but rather trivial thought and also inquiry. But it also works out much easier and better this time thanks to the GeForce RTX 3090 Ti. And some things I won’t write (yet) because it’s just not appropriate.

Therefore, I will leave it to the commentators and colleagues to roughly infer the actual computing power or graphics performance from this value. Since I don’t know or am not allowed to know, I’d better keep a low profile here. So you are welcome to puzzle and argue.

38 Antworten

Kommentar

Lade neue Kommentare

Veteran

Urgestein

Urgestein

1

Urgestein

Veteran

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Mitglied

Veteran

Veteran

Urgestein

Alle Kommentare lesen unter igor´sLAB Community →