Dass die GeForce RTX 4060 8GB samt einer nicht funktionierenden Telemetrie in der Realität deutlich mehr an Leistung aufnimmt, haben wir ja in den Tests zum Launch und mit Overclocking gesehen. Statt der versprochenen maximalen 115 Watt Leistungsaufnahme im Datenblatt und einem typischen Gaming-Wert von 110 Watt, waren es in manchen Spielen satte 132 Watt und auch der Durchschnitt lag immer noch weit über dem, was sowohl Spezifikation als auch die Telemetrie-Werte ausgegeben haben.

Das hat mich durchaus sehr stark getriggert, denn die Frage nach der tatsächlichen Performance bei einer echten Leistungsgrenze von 115 Watt stand nicht nur im Raum, sie war allgegenwärtig. Und genau deshalb, um meine und Eure Neugier zu befriedigen, habe ich zumindest die ganzen Benchmarks in Full-HD noch einmal gemacht. Allerdings habe ich jetzt die Leistungsaufnahme der 3.3 Volt-Schiene erst einmal herausgerechnet, da NVIDIA ja generell nur die 12V-Schiene inkludiert.

Die nötigen Prozente im Afterburner gehen ja wegen der kaputten Telemetrie nicht wirklich auszurechnen, also habe ich es an mir bekannten Spielen per Trial & Error selbst ausgetestet. Dem fordernsten Spiel (Horizon Zero Dawn) habe ich dabei 3 Watt mehr zugestanden, um die sparsameren Spiele nicht zu sehr einzubremsen. Hätte ich einfach das Spiel mit dem Maximum genommen, und nur anhand dessen Wert gecuttet, dann hätte die 115-Watt-Karte noch schlechter ausgesehen. Man kann mit ca. 92% das 115-Watt Limit ganz gut treffen. Ich teste insgesamt 10 Spiele in Full-HD: Gewichtet in mit und ohne DXR sowie extreme und moderate Leistungsaufnahme.

Die Tücken der missratenen Telemetrie

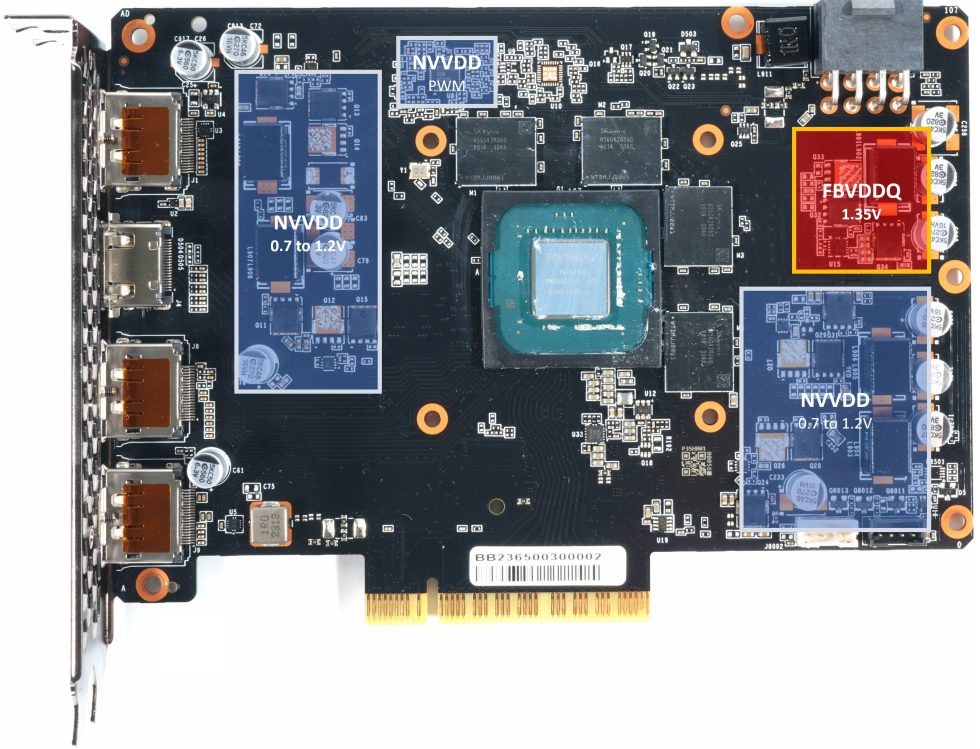

Ich möchte vor den Benchmarks noch einmal kurz zusammenfassen, warum das Platinenlayout und die Telemetrie so ein technischer Reinfall sind. Auf der MSRP-Karte (und nicht nur dort) finden wir ein Spannungswandler-Design mit insgesamt vier Phasen. Das könnte man durchaus so lassen, allerdings ist auch die Effizienz der Spannungswandler aller Karten durch den Verzicht auf richtige DrMOS nicht die beste. Da gehen der GPU bereits einige Watt an Leistung verloren. Denn gemessen wird ja stets das, was man der gesamten Karte zuführt.

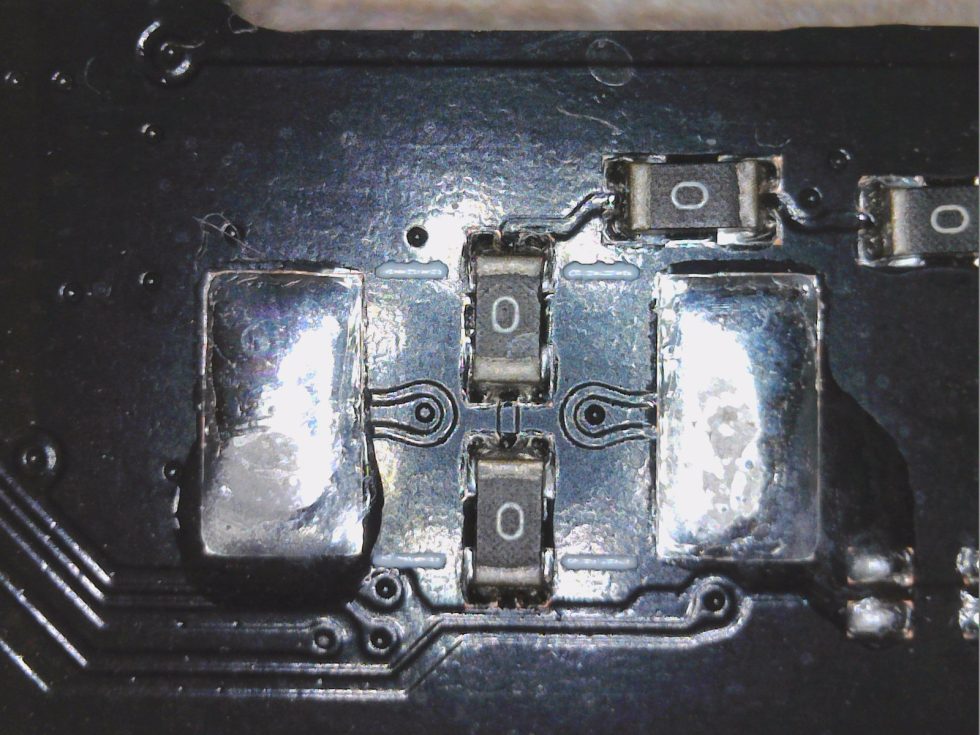

NVIDIA ist ja eigentlich dafür bekannt, dass jede 12V-Rail permanent mittels Shunts und dem dort entstehenden Spannungsabfall überwacht werden. So kann man mittels eines passenden Monitoring-Chips auf die fließenden Ströme schließen und die Firmware kann dann die Leistungszufuhr so drosseln, dass das in der Firmware hinterlegte maximale Power Target auch nie überschritten wird. Diese Shunts existieren interessanterweise auf keiner der RTX 4060 Platinen und auch ein geeigneter Monitoring-Chip fehlt komplett.

NVIDIA deklariert die normalen RTX 4060 als 115-Watt-Karten und spricht selbst von typischen 110 Watt beim Gaming. Doch genau das ist unwahr. Ja, die über die NVAPI auslesbaren Werte liegen brav bei 115 Watt und darunter, nur stimmen sie leider nicht mal im Ansatz. Während die Schnittstelle in der Software bei 115 bis 116 Watt verharrt, messe ich an den Rails und 4 Spielen in Wirklichkeit sogar über 130 Watt! Das sind 15 Watt mehr als maximal erlaubt und immerhin 20 Watt über den für die Spiele kommunizierten Wert! Die Karte ist also bei weiten nicht so effizient, wie es die Schnittstelle vorgaukelt und die PR-Folien gern hätten. Das wären beim Gaming nämlich schon über 18 Prozent mehr!

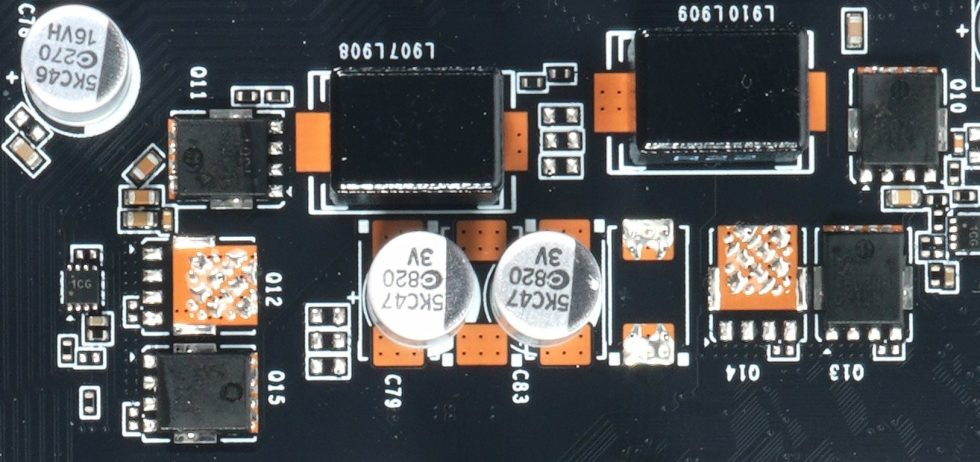

Um die einzelnen Regelkreise überhaupt kontrollieren zu können, benötigt man ein spezielles Verfahren. Das Schlagwort heißt DCR (Direct Current Resistance). Am Ende weist jedes Bauelement diesbezüglich ja ganz bestimmte Charakteristika auf. Um es aber einmal abzukürzen: DCR ist die Basis, um Temperaturen und vor allem Ströme zu kalkulieren oder zu messen. Doch wie erfährt der Controller nun genau, welche Ströme in welchem Regelkreis fließen? Das Monitoring kann unterschiedlich sein, denn es gibt – wen wundert es – verschiedene Methoden dafür.

Wir haben ja bereits analysiert, dass die Spannungswandler auf dem technischen Stand von vor 10 Jahren realisiert wurden. Intelligente Smart Power Stages (SPS), die die Drain-Ströme der MOSFETS für die MOSFET DCR in Echtzeit messen, sind hier reine Utopie. Man ersetzt das Ganze durch die deutlich günstigere Inductor DCR in einer diskreten Schaltung, also eine Strommessung über den induktiven Widerstand der jeweiligen Filterspulen im Ausgangsbereich. Die Genauigkeit dieser Lösung ist allerdings deutlich geringer und wird zusätzlich noch durch Schwankungen der Bauelemente-Güte sehr stark beeinflusst.

Angeblich kann bzw. möchte man es ja fixen, nur frage ich mich gerade, wie. Passt man die TBP an die Spezifikation an und begrentr die Karte auf echte 115 Watt, muss man die NVAPI austricksen und dort dann wieder was draufaddieren. Außerden würde die Karte dann als Downgrade so schnell bzw. langsa,m wie das heutige Testmuster und das kann man den Kunden kaum erklären. Oder aber man spezifiziert die Kate wirklich auf die 130 Watt und lässt dann die API anpepasste Werte liefern. Auch peinlich. Oder aber, man sitzt das Problem einfach aus. Bei der aktuellen Zahl verkaufter Karten wohl die wahrscheinlichste Variante.

- 1 - Einführung, Mess- und Testmethodik sowie Ursachen

- 2 - Anno 1800

- 3 - Cyberpunk 2077

- 4 - Far Cry 6

- 5 - Horizon Zero Dawn

- 6 - Marvel's Guardians of the Galaxy

- 7 - Metro Exodus EE

- 8 - Rainbow Six: Extraction

- 9 - Shadow of the Tomb Raider

- 10 - A Total War Saga: TROY

- 11 - Watch Dogs Legion

- 12 - Gesamtauswertung, Zusammenfassung und Fazit

50 Antworten

Kommentar

Lade neue Kommentare

Urgestein

1

Mitglied

Urgestein

1

Urgestein

Urgestein

Urgestein

Urgestein

Veteran

Neuling

Neuling

Urgestein

Urgestein

Urgestein

Urgestein

Veteran

Veteran

Urgestein

Alle Kommentare lesen unter igor´sLAB Community →