Auch wenn der Titel natürlich etwas martialisch und übertrieben klingen mag – es ist die bittere Realität, wenn man Gehäuse wirklich objektiv im thermischen und akustischen Bereich miteinander vergleichen möchte. Und nur darum geht es in diesem Artikel. Natürlich zählen subjektive Faktoren wie das Aussehen, die Fertigungsqualität und die Usability auch zum Inhalt eines guten Reviews und damit hat beides natürlich eine friedliche Koexistenz verdient. Nur muss man es dann auch so nennen. Hands-On und Usability auf der einen, die tatsächliche Kühlperformance, Geräuschemission und Dämpfung für einen ehrlichen Vergleich auf der anderen Seite. Im heutigen Gastbeitrag will ich einfach einmal die Sichtweise derer schildern, die es wirklich belastbar und objektiv machen möchten, ohne damit die Leistung derer zu schmälern, die ein Gehäuse aus Anwendersicht in den normalen Reviews vorstellen. Aber es geht hier um rechtssichere Bewertungen und auch Zertifizierungen.

Ausgangssituation: wie viel Aufwand muss man überhaupt treiben um was zu ermitteln?

Manche Leute glauben ja wirklich, dass das Testen eines Gehäuses ein elegantes Kinderspiel sei, da man ja nur einfach ein System darin installieren und im Text erwähnen muss, wie einfach oder schwierig dies alles war, ob einem das interne und externe Design gefällt und was es so als Dreingabe im Lieferumfang mitgibt. Und wenn man nicht gerade fürs Schönfinden bezahlt wird, dann kann man ja auch noch ein paar Worte über die Verarbeitungsqualität verlieren. Das kann man (und sollte man auch) machen, aber dann bitte nicht als Vergleich. Nennen wir es besser Produktvorstellung und Anwendererfahrung, denn es hat ja auch seine Berechtigung und Zielgruppe. Doch alles, das weiterführt, wird nun verzwickt.

Einige versiertere Tester gehen dafür zum nächsten Schritt über und bewerten auch die thermische Leistung, indem sie das gleiche System in allen ihren Gehäusetests verwenden und die Temperaturen kritischer Komponenten wie CPU, GPU, Laufwerke, VRMs usw. in einer Datenbank erfassen und vergleichen. Noch erfahrenere Tester verwenden dann zumindest die Delta-Temperatur, um die unterschiedlichen Umgebungsbedingungen zu kompensieren. Angenommen, man hat keine Klimakammer, dann kann man in diesem Fall auch keine stabile Betriebstemperatur garantieren. Somit ist die Verwendung der Delta-Differenz der einzige Weg, um bei allen Bewertungen einen einigermaßen brauchbaren Bezugspunkt zu haben. Physikalisch exakt ist aber auch das nicht und wird so manchem Produkt nicht gerecht. Objektivität kann man so nicht beanspruchen.

Schließlich messen nur sehr wenige Tester neben der thermischen Leistung dann auch noch auch die Geräuschemission und versuchen, die Ergebnisse zu normalisieren, indem sie die gleichen Testbedingungen auf alle Fälle anwenden. Das muss man aber einmal etwas erklären. Denn man kann ein Gehäuse, das bei voller Lüfter-Geschwindigkeit 40 dBA emittiert, nicht direkt mit einem Gehäuse vergleichen, das mit seinen Lüftern bei Höchstgeschwindigkeit 35 dBA erzeugt. Das richtige Vorgehen wäre nun, die Lüftergeschwindigkeit des lauten Gehäuses zu verringern und seine Lüfter mit der entsprechenden Geschwindigkeit drehen zu lassen, die es ermöglicht, 35 dBA auszugeben. Nur dann könnte man auch Äpfel mit Äpfeln vergleichen. Um dies zu tun, müsste man allerdings die Lüftergeräusch-Pegel normalisieren. Um das überhaupt tun zu können, müsste man eine Semi-Anechoic Chamber (im Weiteren einfach nur noch Chamber genannt) und einen hochgenauen Geräuschanalysator verwenden und dann noch die entsprechenden ISO-Richtlinien befolgen, in denen genau festgelegt ist, wie man das Mikrofon und das Testobjekt in der Kammer platzieren muss. Eine solche Ausrüstung ist teuer und der Bau einer geeigneten Kammer zudem schwierig. Tja, und nun?

Ein weiterer kritischer Faktor, wenn es um ehrliche Gehäusebewertungen geht, ist die Berücksichtigung der Geräuschdämpfung (umgangssprachlich auch Dämmung). Wie man so etwas realisiert? Ganz einfach: man installiert eine konstante Geräuschquelle im Inneren des Gehäuses und führt dann Messungen durch. Man entfernt danach die Geräuschquelle wieder aus dem Gehäuse und nimmt erneut Geräuschmessungen vor (oder umgekehrt). Am Ende ist es nur noch eine Frage der Subtraktion, um die Geräuschdämpfung als Differenz zu ermitteln. Doch welches Rauschmuster soll man verwenden? Rosa oder weißes Rauschen? Und ja, wenn man wirklich gründlich sein will, könnte man auch noch ein langes Chirp-Muster verwenden. Nehmen wir mal an, der Tester will den interessierten Anwendern noch weiterführendere Details liefern. In diesem Fall könnte man viele verschiedene Frequenzen von ultratief bis superhoch verwenden und die Geräuschdämpfungsleistung für jede Frequenz (oder verschiedene Frequenzbänder) ermitteln. Das ist zum Beispiel, was Cybenetics in den Gehäusebewertungen macht. Es ist ein anspruchsvolles Verfahren, das eine erstklassige Ausrüstung und eine fortschrittliche Chamber erfordert. Aber es sprengt auch die Grenzen eines “normalen” Reviews erheblich.

Warum ein reales System zu Fehlern führen muss

Der größte Fehler bei den meisten Reviews ist jedoch, dass sie sich auf ein reales System stützen, das die folgenden Nachteile hat:

- Es muss häufig ausgetauscht werden, um mit den Technologietrends Schritt zu halten und um den nötigen “Wow-Faktor” zu bieten. Niemand wird erfreut sein, wenn er/sie sieht, dass ein 3-5 Jahre altes Testsystem verwendet wird, obwohl die thermische Leistung ja das ist, was in diesen Tests am meisten zählt und nicht die Leistung. Nur interessiert das ja keinen oberflächlichen Betrachter.

- Man kann damit auch keine gleichmäßige, genaue und vor allem einstellbare Last aufbringen, wenn man ein reales System verwendt. Man verlässt sich darauf, wie gut die Benchmark-Software die Last stabil halten kann. Doch selbst kleine Lastabweichungen können die aufgezeichneten Temperaturen bereits um mehrere Grad beeinflussen, was wiederum ausreicht, um ein Gehäuse von einem anderen (unberechtigterweise) zu unterscheiden. Außerdem muss man ja alle Optionen, die die Wattleistung der CPU beeinflussen können, erst einmal manuell im BIOS einstellen und das Gleiche gilt natürlich am Ende auch für alle entsprechenden Optionen der GPU. Messtoleranzen und Fehler bei der Reproduzierbarkeit summieren sich hier recht schnell, leider.

- Es ist nicht einfach, verschiedene Szenarien, also andere Hardware, zu testen, da man ein festes System verwenden muss, um alle Messwerte zwischen den Auswertungen kompatibel zu halten.

Mit einem simulierten System wäre es jedoch möglich, mehrere Parameter schnell und mühelos anzupassen, so dass man bequem (und reproduzierbar) verschiedene Szenarien testen könnte. Wenn man also beispielsweise eine 250-W-CPU und eine 350-W-GPU in einem realen System installiert hat, könnte man die Leistungsunterschiede zwischen einem System, das eine 100-W-CPU und eine 200-W-GPU verwendet, nicht erkennen. Wenn man hingegen die benötigte Last genau einstellen kann, ist dies absolut einfach und man kann problemlos von Low-End- bis High-End alle CPUs und GPUs simulieren. Klingt gut? Das ist es auch!

Sensoren und Lüfter – weitere Unwägbarkeiten

Viele Tester verlassen sich übrigens auf die Temperatursensoren des Mainboards, der CPU und der GPU und Sie können nie wissen, ob diese Sensoren angemessen genau sind und wirklich über den gesamten Bereich überhaupt korrekte Temperaturen melden. Gut, man könnte argumentieren, dass dies alles ab dem Moment, in dem man das gleiche System in allen Tests verwendet, kein großes Problem darstellen würde, aber jedes Messsystem muss von Zeit zu Zeit kalibriert werden und genau das ist etwas, was man mit integrierten Sensoren (Alterung, Firmwareupdates usw.) nicht tun kann. Sicher gibt es einige wenige Tester, die richtige und kalibrierte Temperaturlogger verwenden, nur muss man sicherstellen können, dass diese Temperatursensoren bei jedem Test an exakt der gleichen Stelle platziert werden. Andernfalls werden die gelieferten Ergebnisse nicht mit denen früherer Tests übereinstimmen. Die beste Methode, um sicherzustellen, dass die Temperatursensoren bei jedem Test genaue Informationen liefern, ist es, kleine Löcher in die entsprechenden Kühlkörper oder Metallteile zu bohren und sie dann immer wieder genau dort zu installieren.

Die Steuerung der Lüftergeschwindigkeit ist eine weitere Herausforderung. Man müsste die totale Kontrolle über alle Systemlüfter haben, um die Lüftergeräusche zu normalisieren und auch ein detailliertes Protokoll zu erhalten. Wenn man jedoch automatisierte Tests durchführen will, ist auch eine programmierbare Lüftersteuerung zwingend erforderlich. Und schon sind wir beim eigentlichen Kernthema angelangt, das für ein effizientes Abarbeiten größerer Stückzahlen an Testobjekten zwingend geklärt werden muss.

Die Automatisierung der Abläufe minimiert Fehler – das Testsystem nimmt Gestalt an!

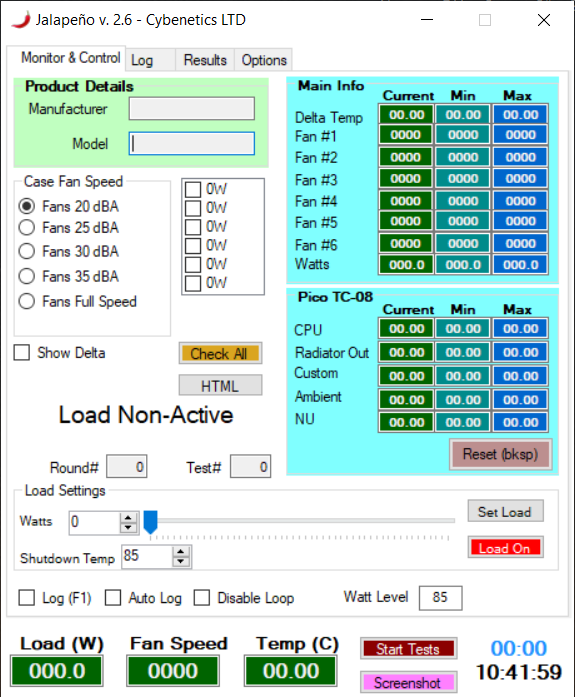

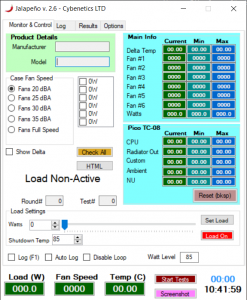

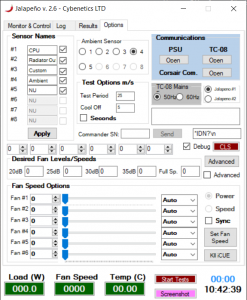

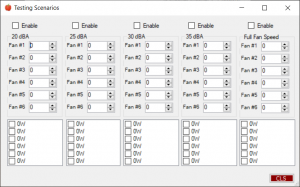

Die richtige Umsetzung ist somit das Wichtigste von allem. Wir sind alle Menschen, die anfällig für Fehler sind, die während der Testdurchführung oder bei der Übergabe der Ergebnisse an eine Excel-Tabelle gemacht werden können. Um all diese meist unbewusst gemachten Fehler zu vermeiden und lange Testsitzungen zu ermöglichen, bei denen alle Daten protokolliert und berichtet werden, braucht man nun einmal eine Automatisierung, ein Steuerungs- und Überwachungsprogramm, das alle Instrumente steuert und verschiedene Testszenarien unter Variation der angelegten Last und der Lüftergeschwindigkeit durchführt.

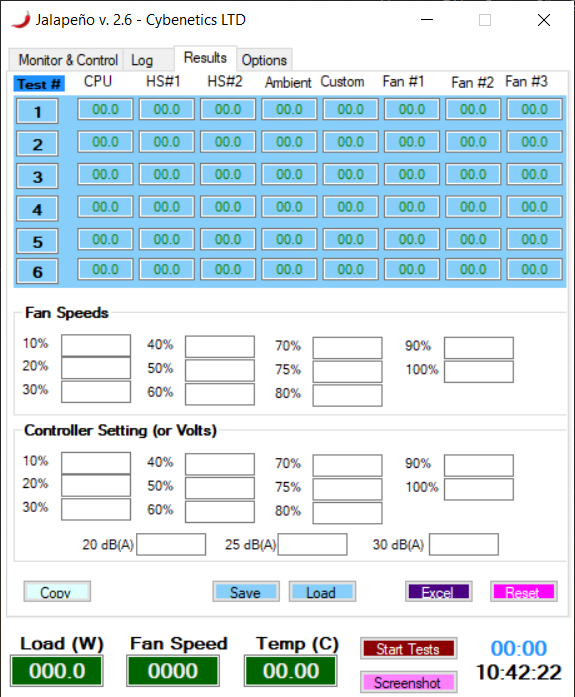

Schließlich, wenn alles fertig ist, sollte dieselbe Anwendung die Daten in dem benötigen Format zur weiteren Auswertung liefern können, von CSV- bis zu Excel-Dateien. Dieser Teil des Codes kann sehr kompliziert und aufwändig werden und erfordert lange Betatests. Dennoch, wenn es erst einmal gut funktioniert, wird es die genauesten Ergebnisse liefern und die ganze Testprozedur kann viele Stunden dauern, ohne dass jemand den ganzen Prozess beaufsichtigen muss. Außerdem kann man mit einem solchen Programm auch Durchschnittswerte zu bestimmten Zeitpunkten ermitteln, die viel genauer sind als wenn man nur einen Test durchführt und zufällige Spikes aufzeichnet.

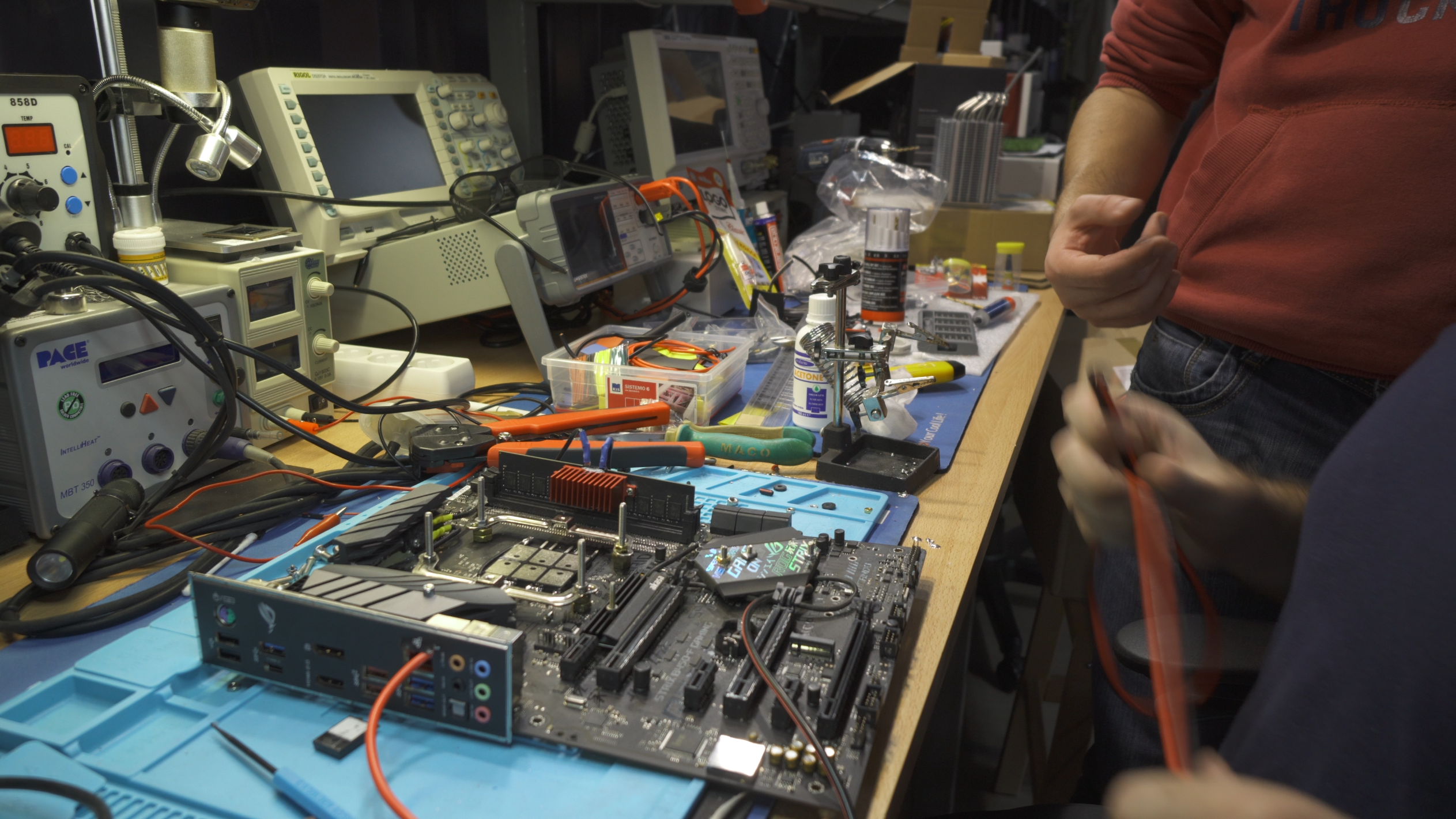

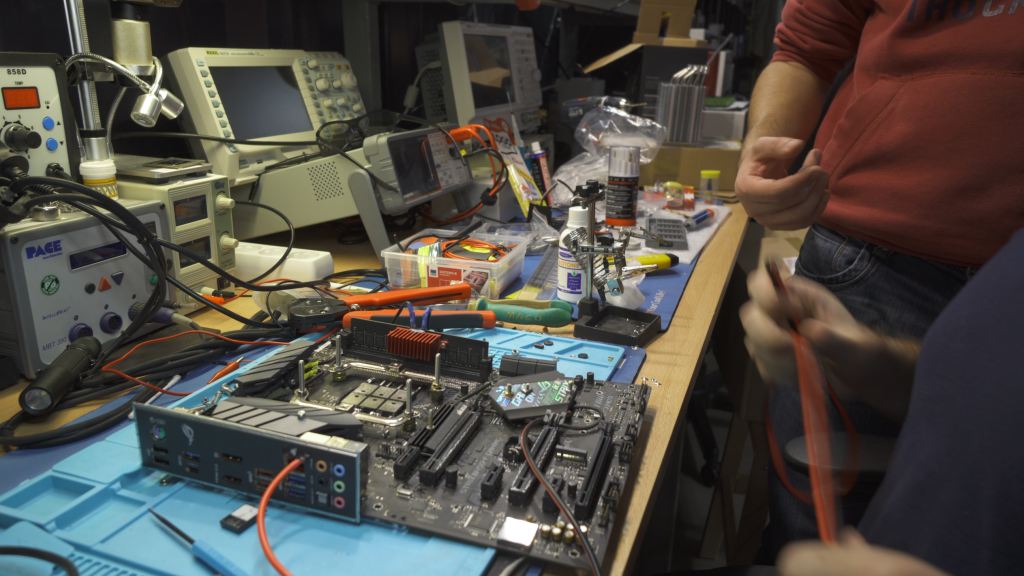

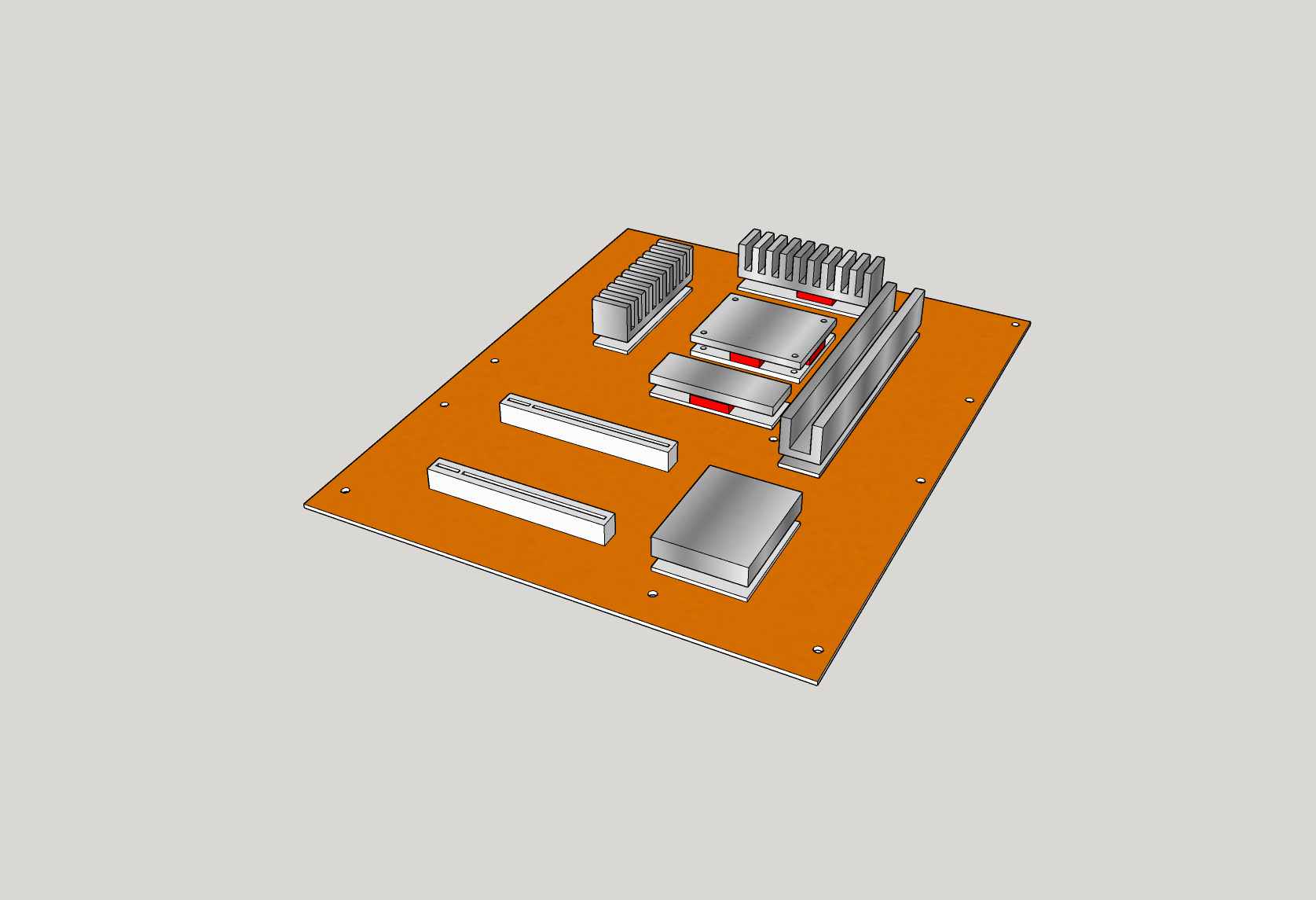

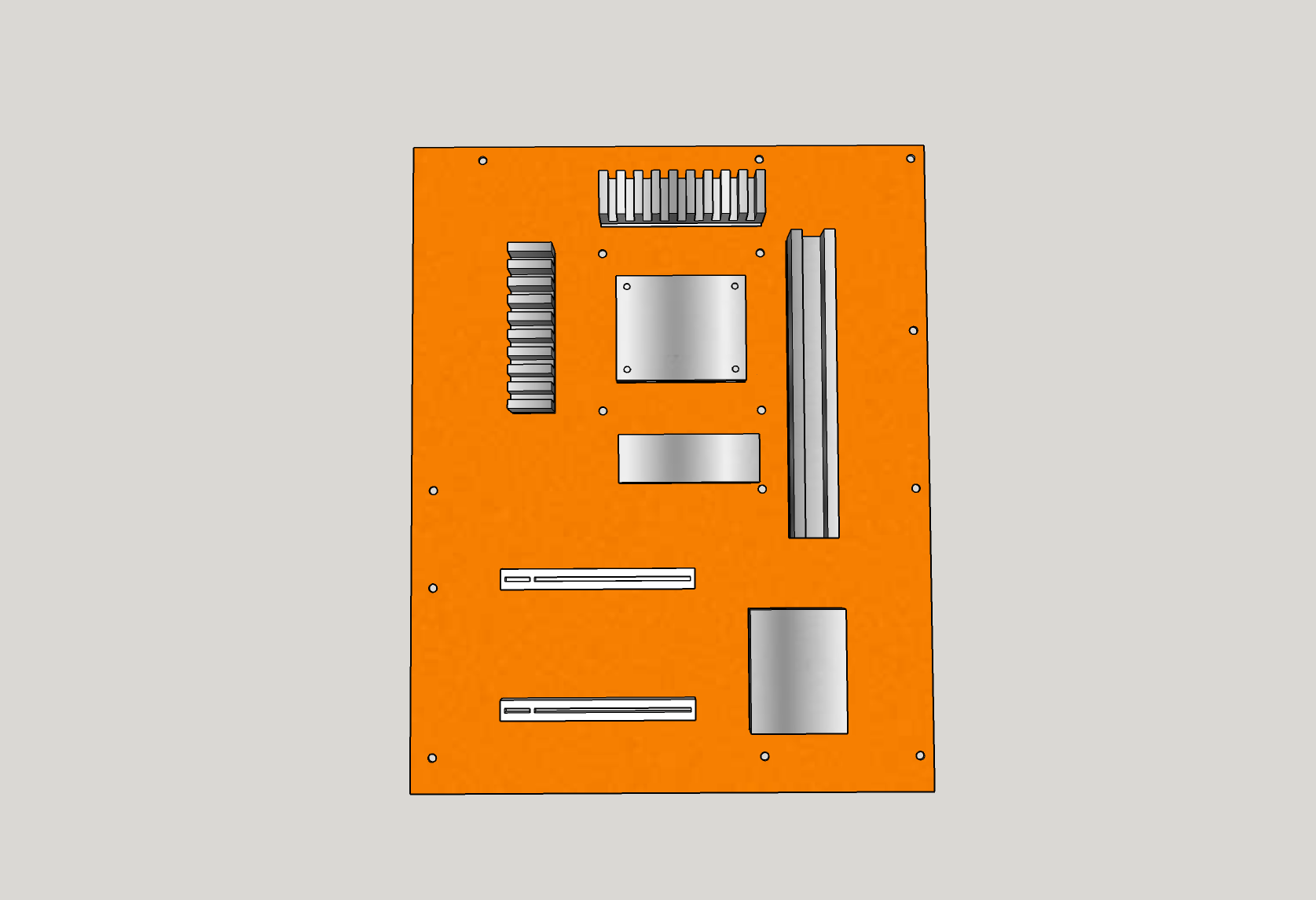

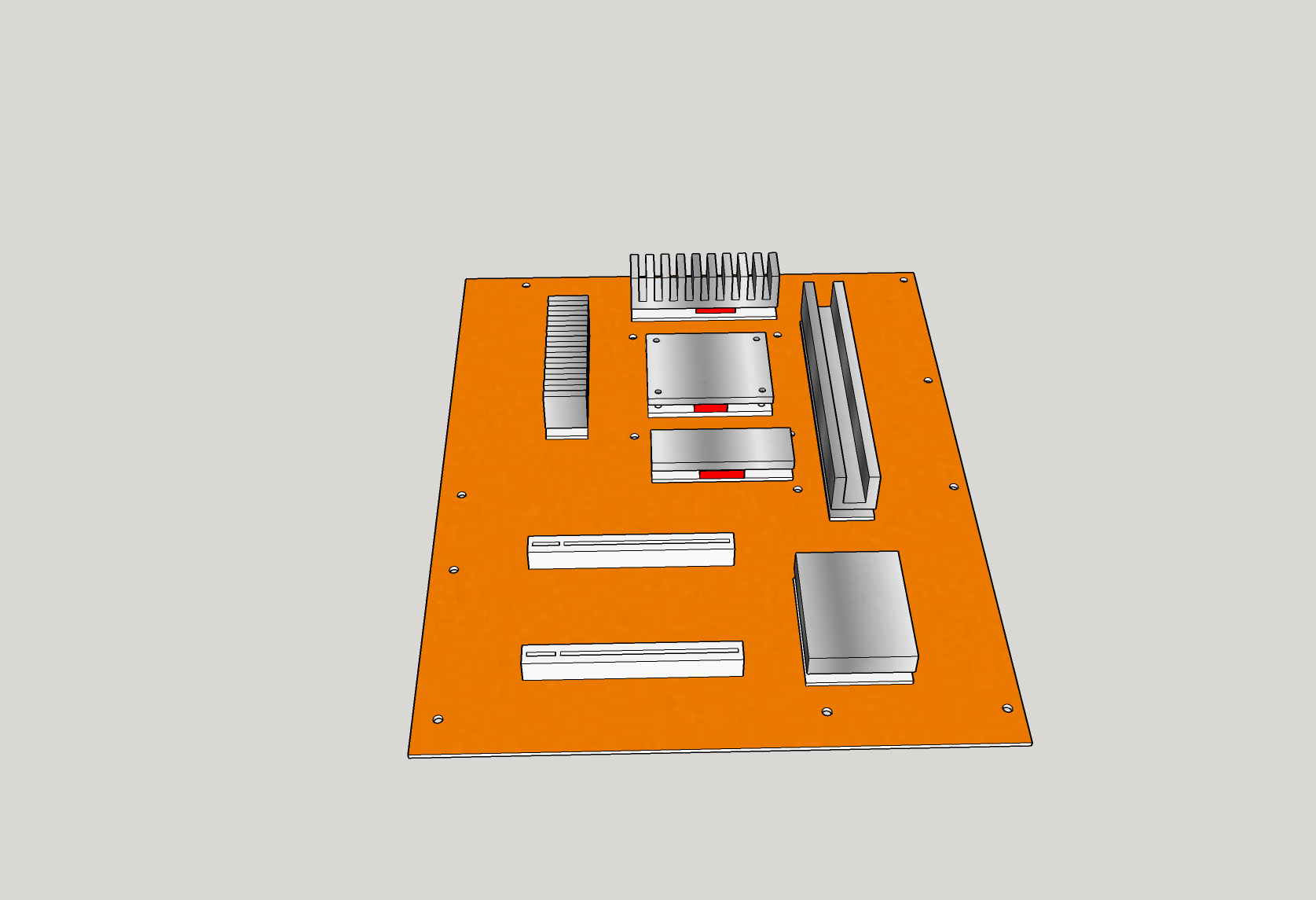

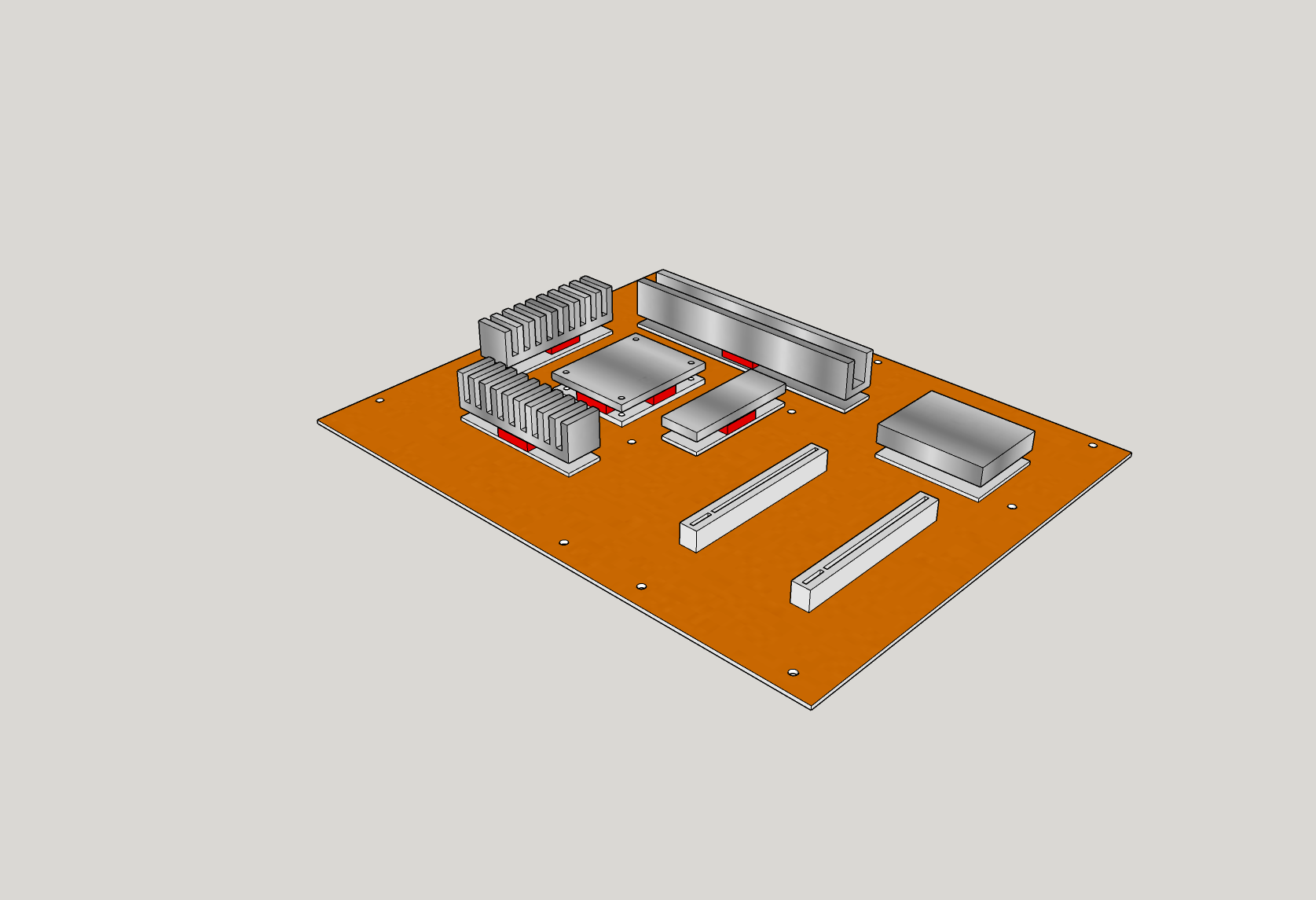

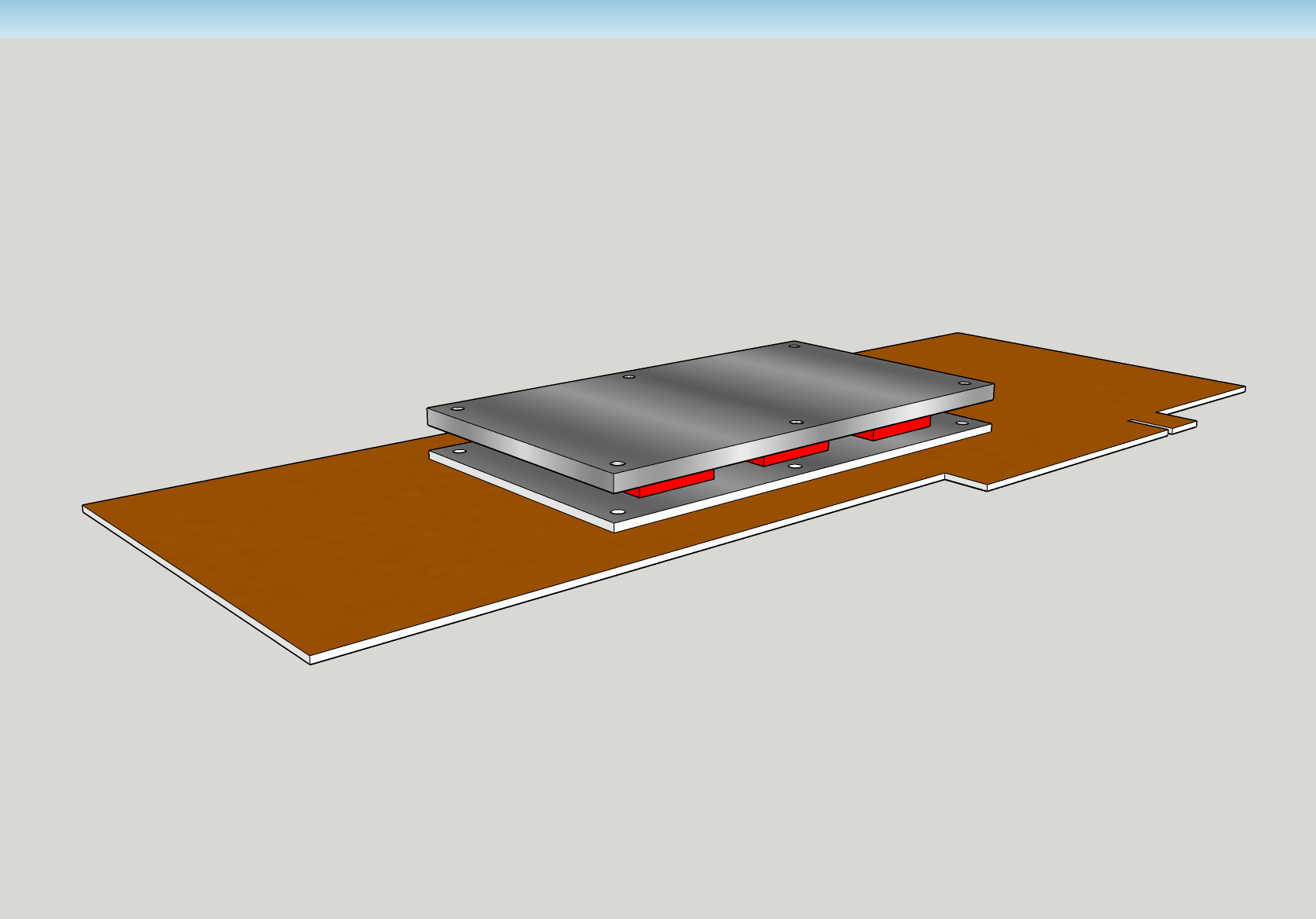

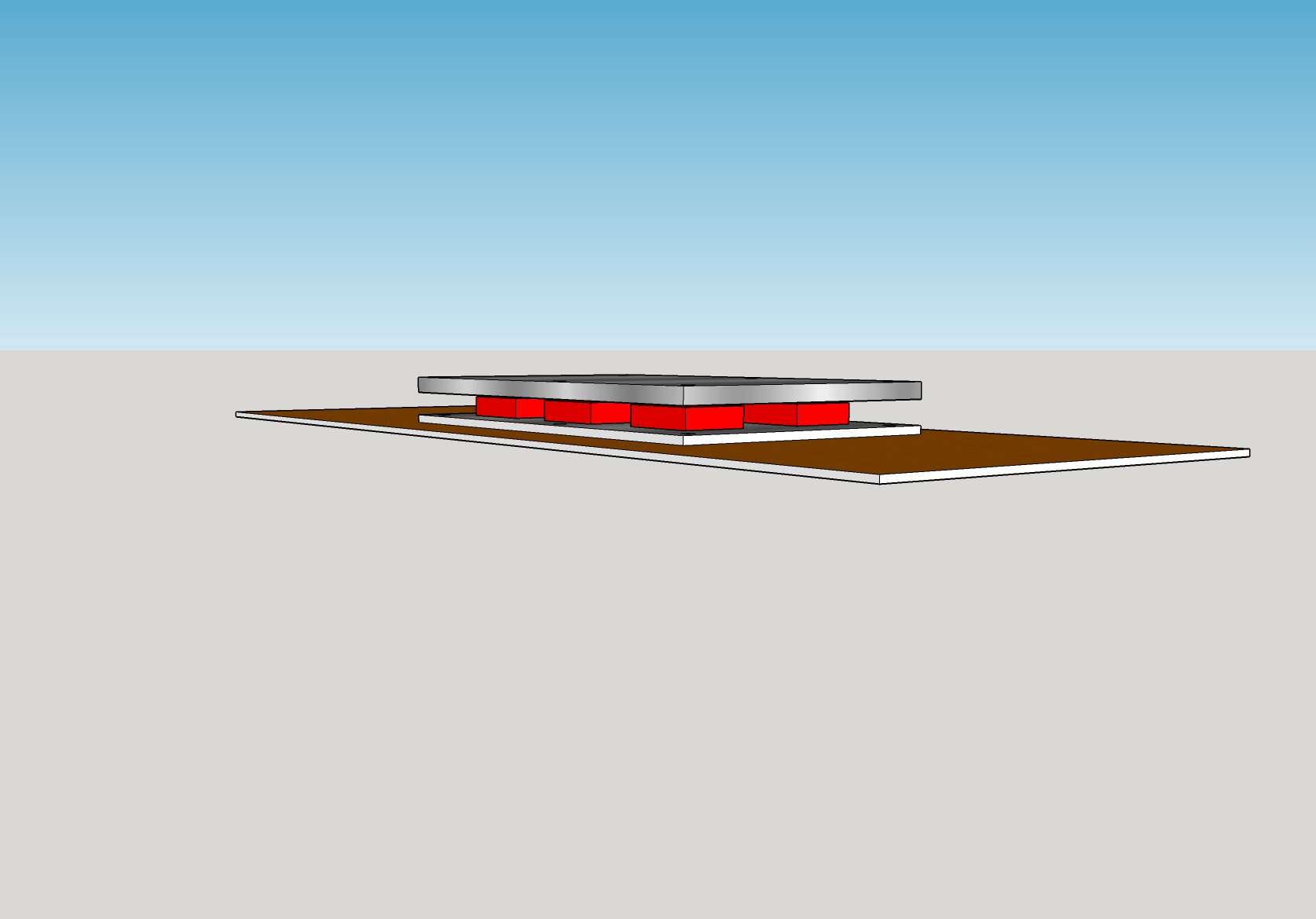

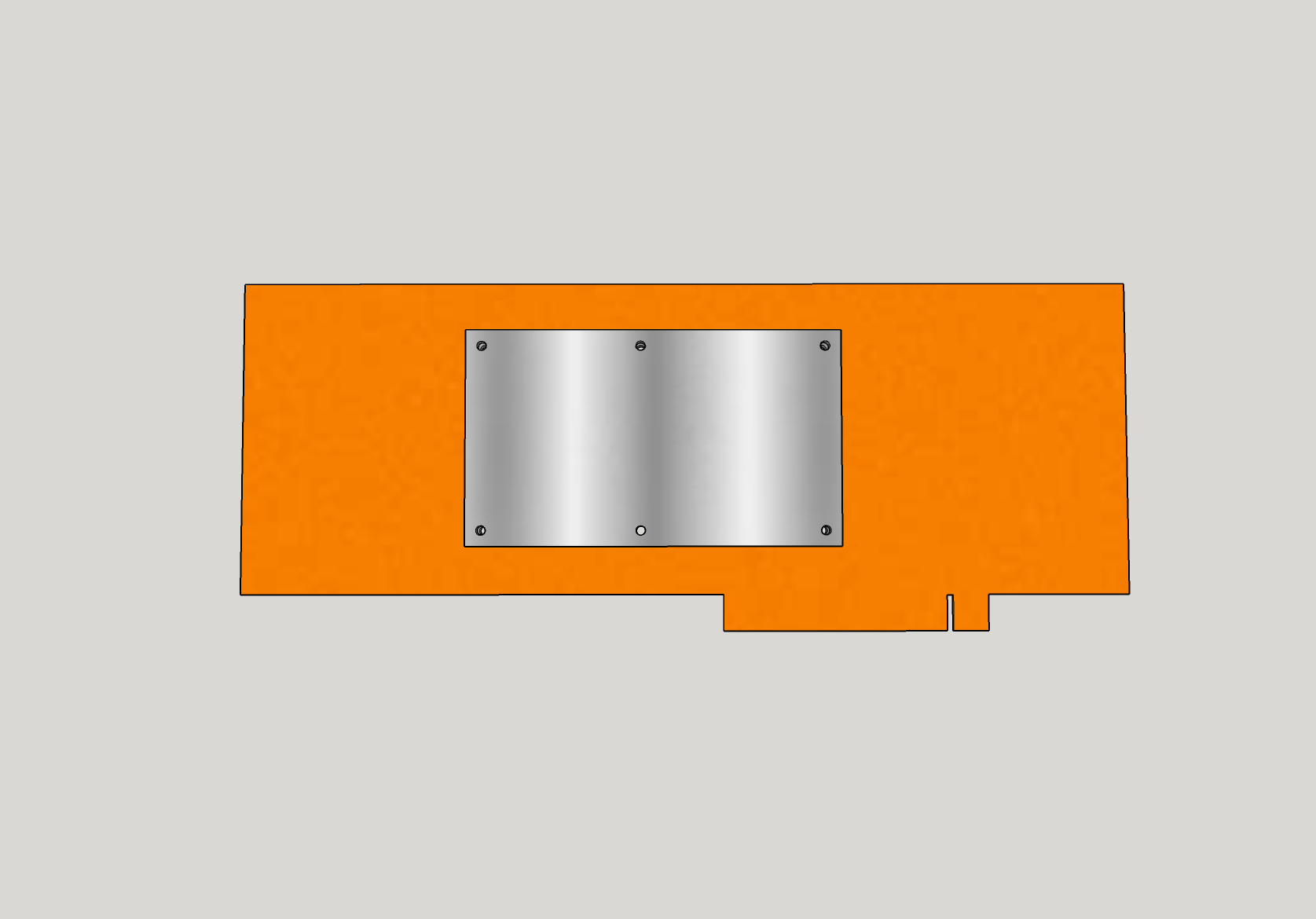

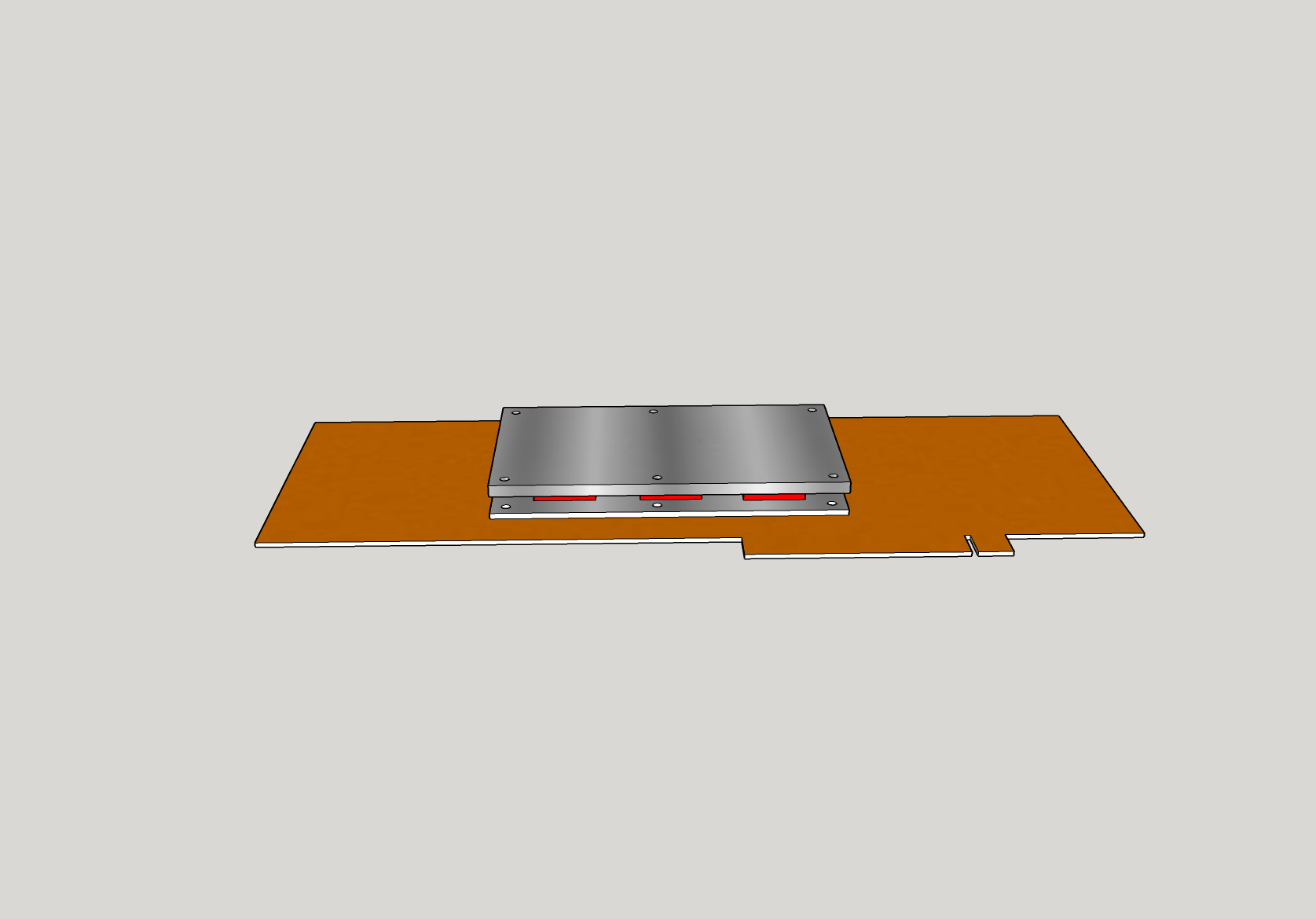

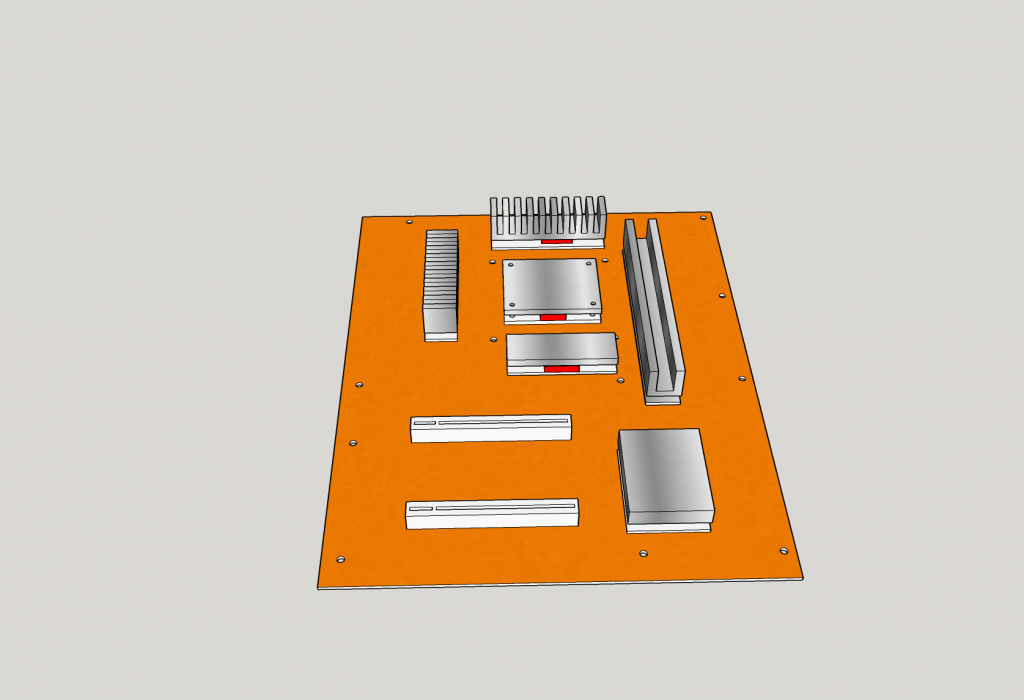

Genau deshalb haben wir uns entschieden, ein vollständig benutzerdefiniertes System zu entwickeln, das ausschließlich in unseren Gehäuse-Tests verwendet wird, um alle oben genannten Punkte zu berücksichtigen. Wir haben etwas Ähnliches ja schon für unsere Kühlkörper-Tests entwickelt und die erreichte Genauigkeit ist beeindruckend. Wir hatten nun zwei Möglichkeiten: Wir konnten entweder etwas von Grund auf neu entwerfen oder ein echtes System verwenden und es an unsere Bedürfnisse anpassen. Da wir keine CNC-Maschine in unserer Werkstatt haben und 3D-Druck nicht in Frage kam, entschieden wir uns daher, einige passende PC-Teile zu finden und sie für unsere Bedürfnisse zu modifizieren. Das hat zwei Vorteile, denn man kann ein echtes System verwenden und die Kosten sind am Ende deutlich geringer.

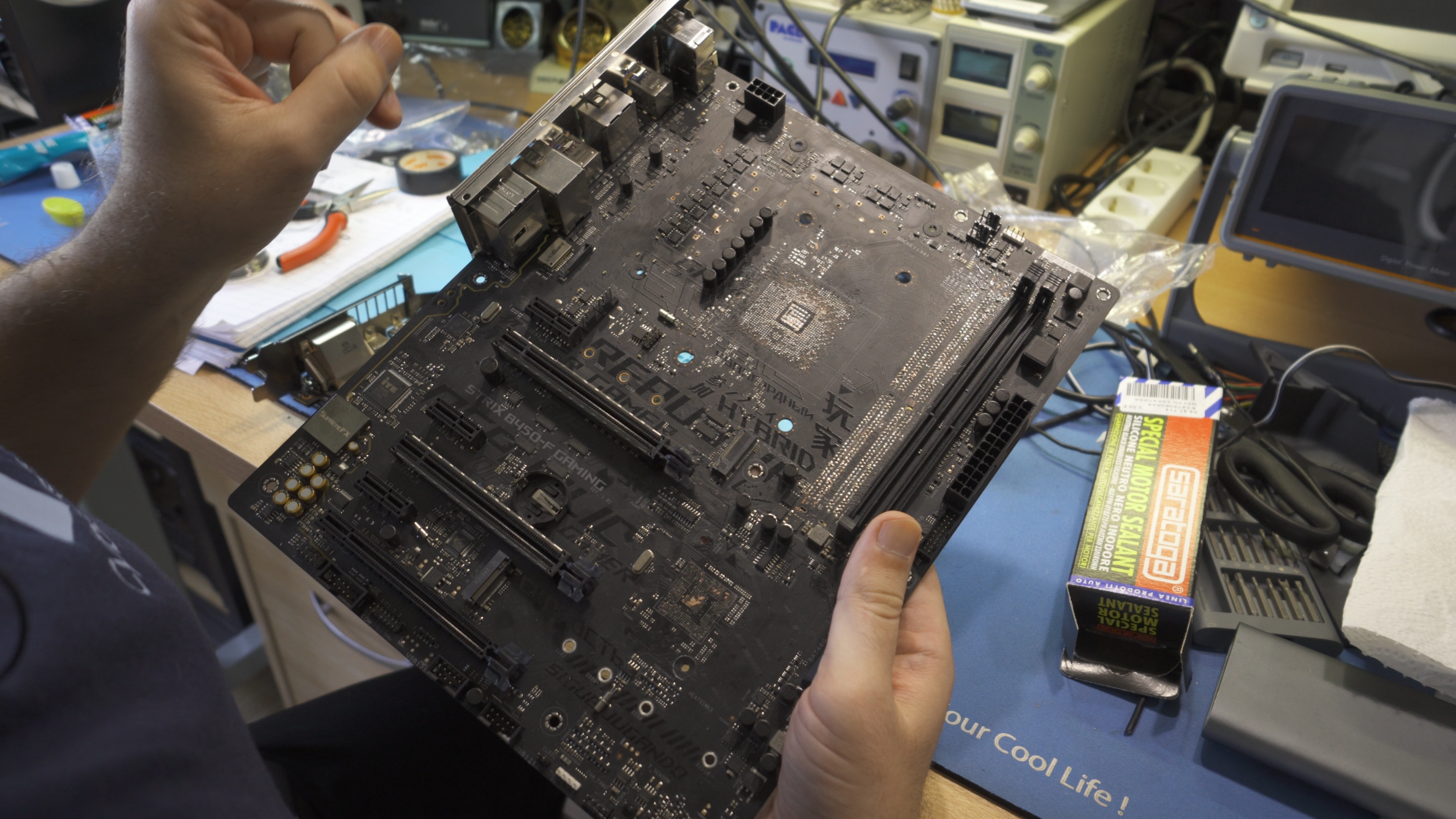

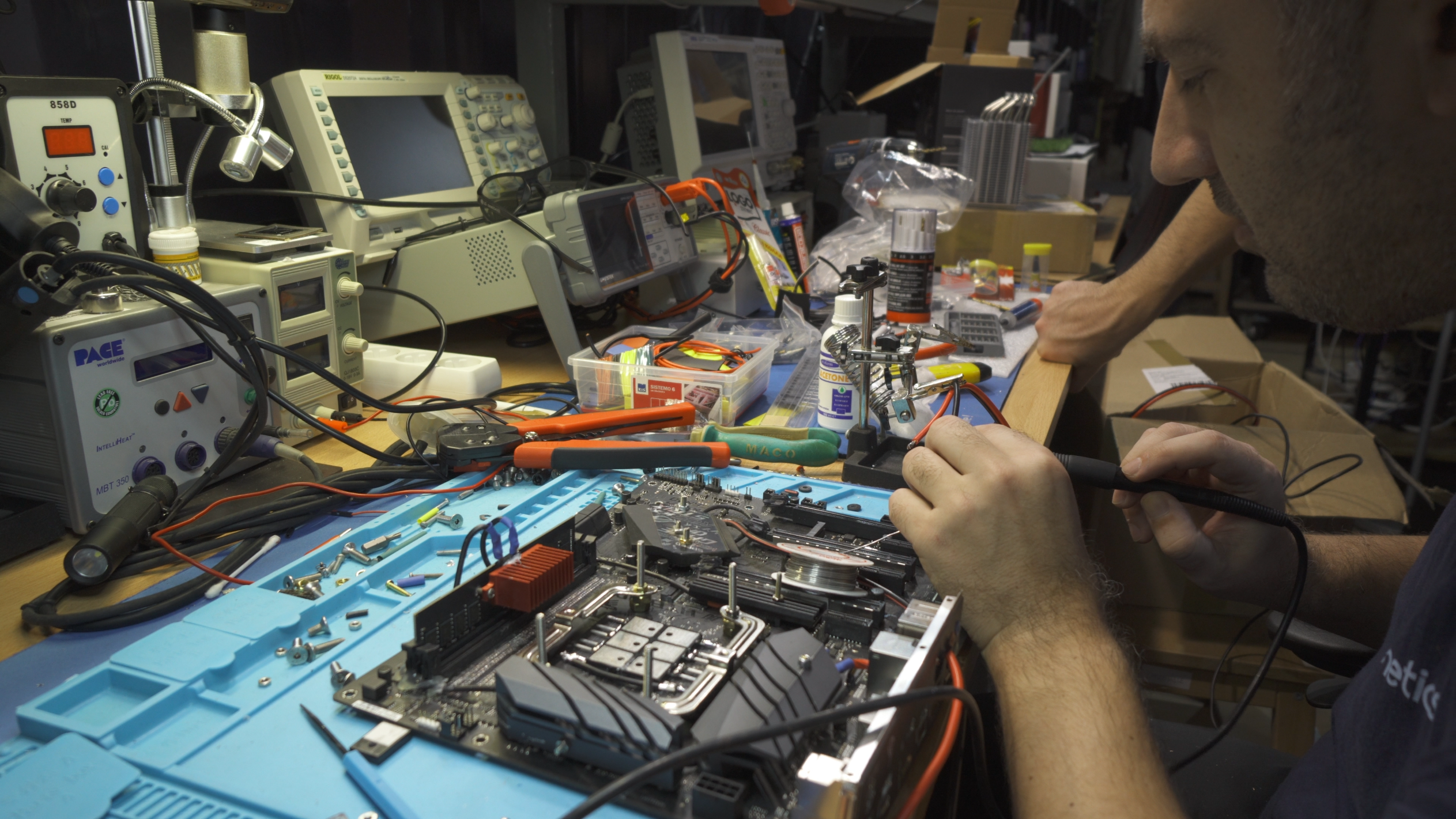

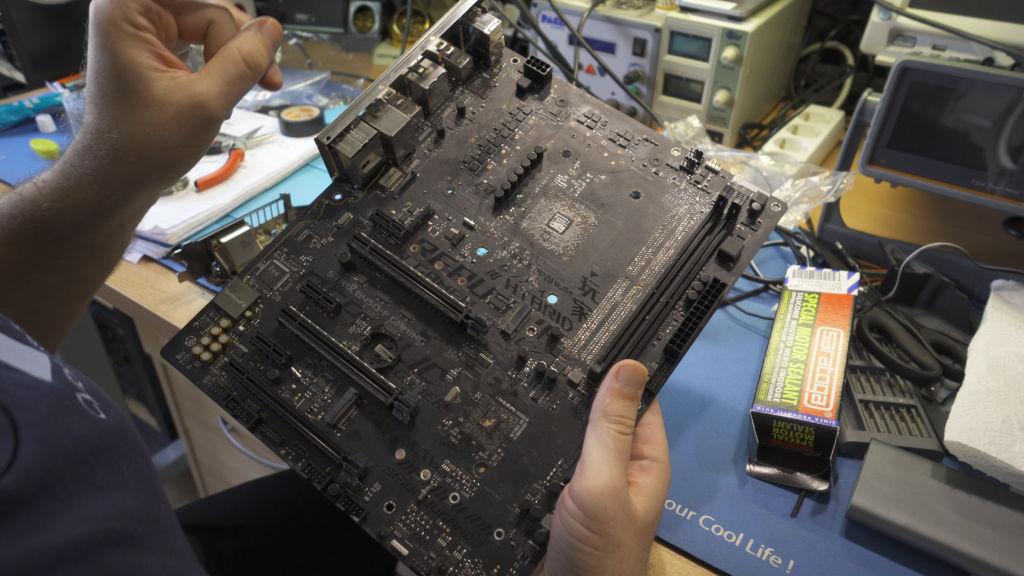

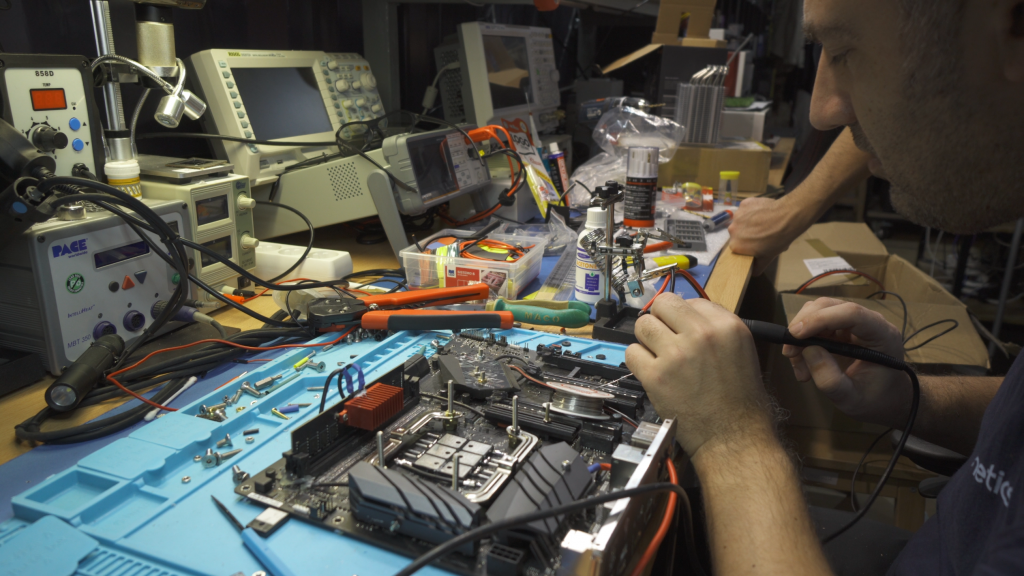

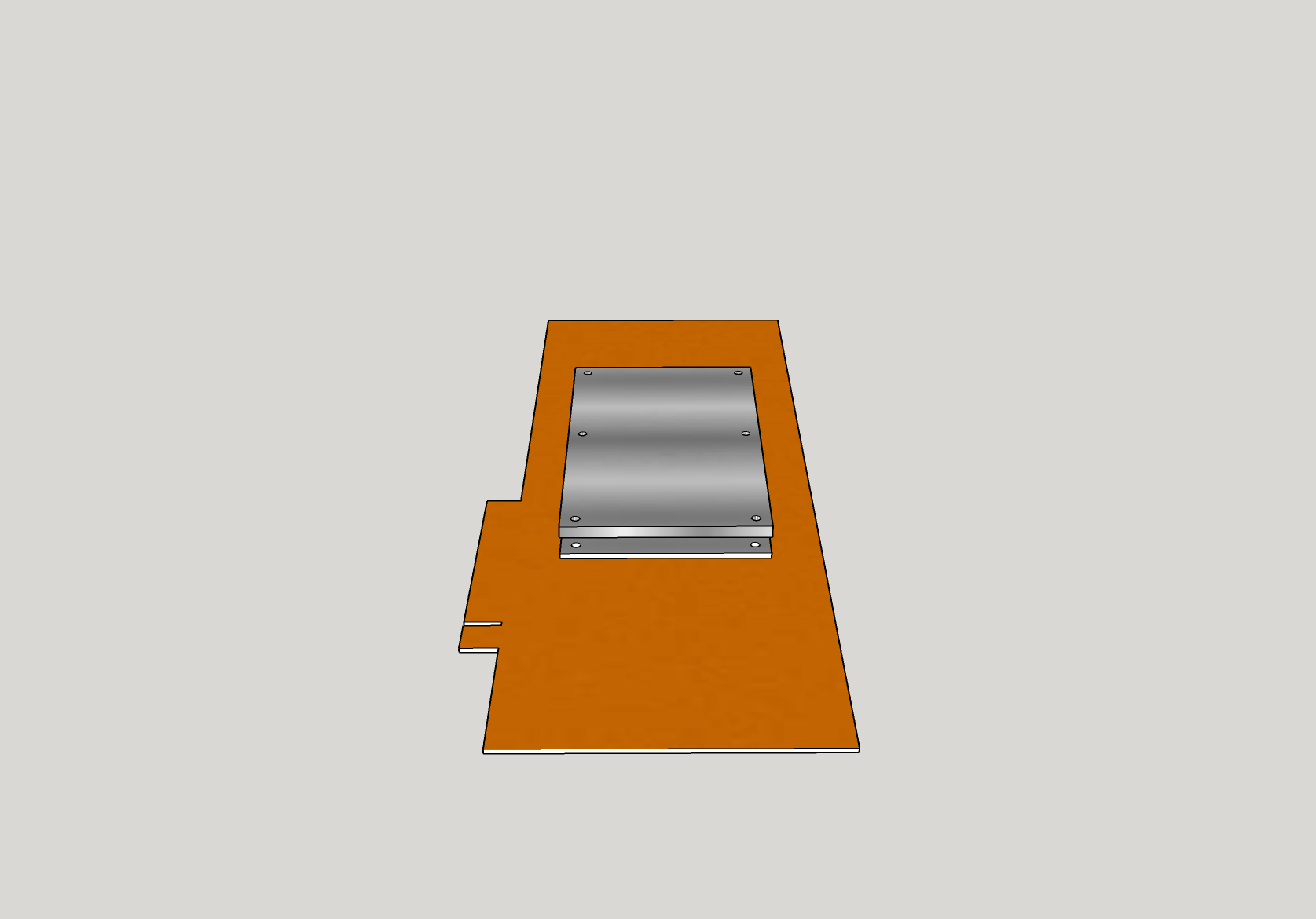

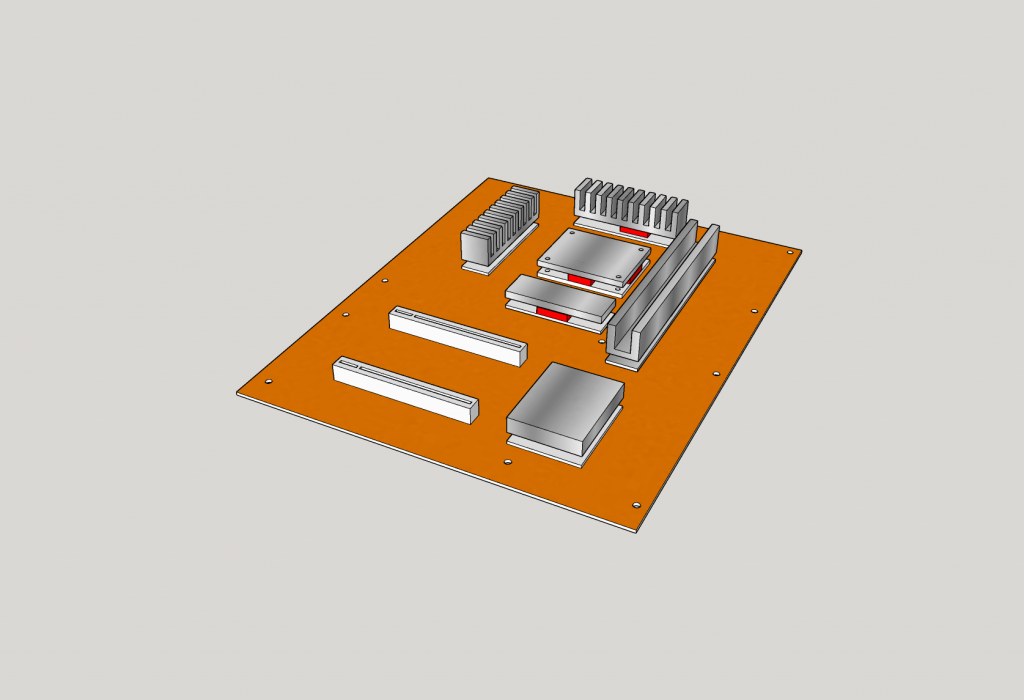

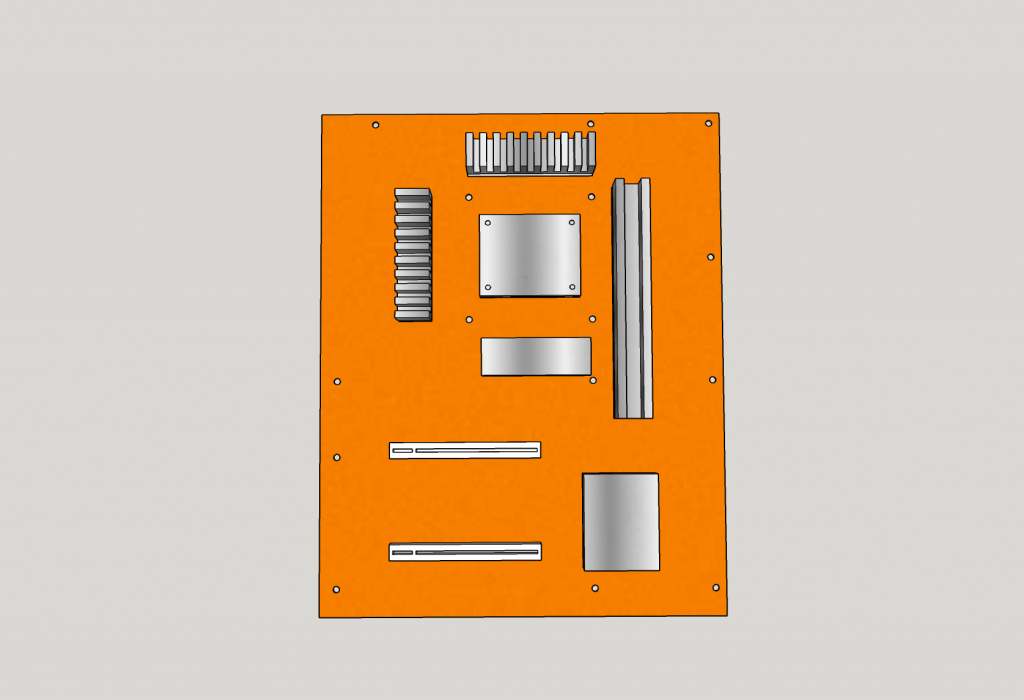

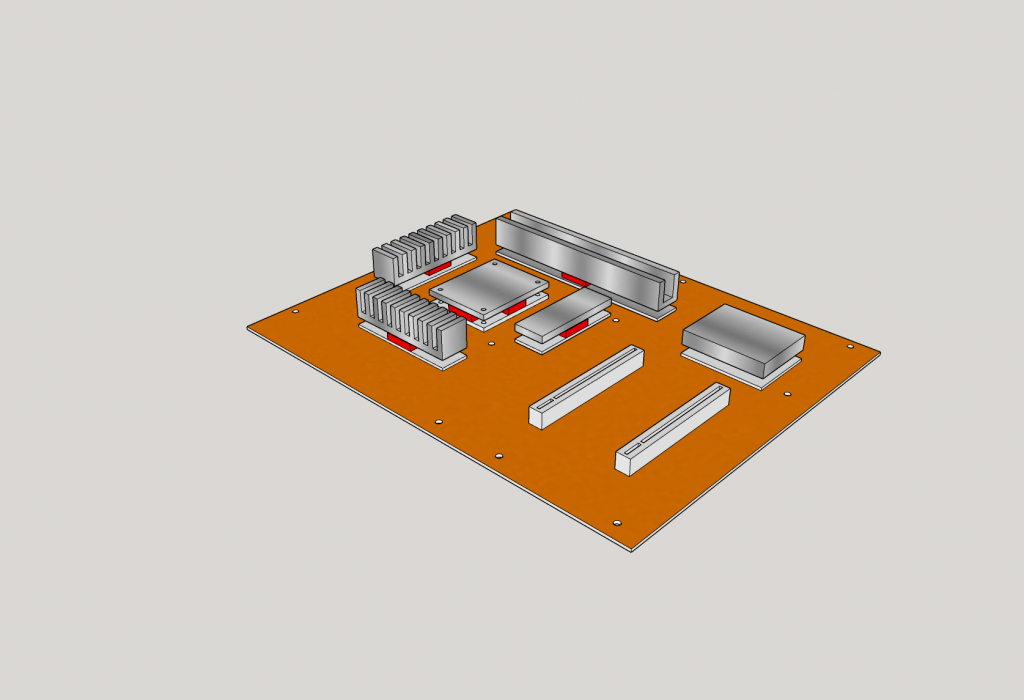

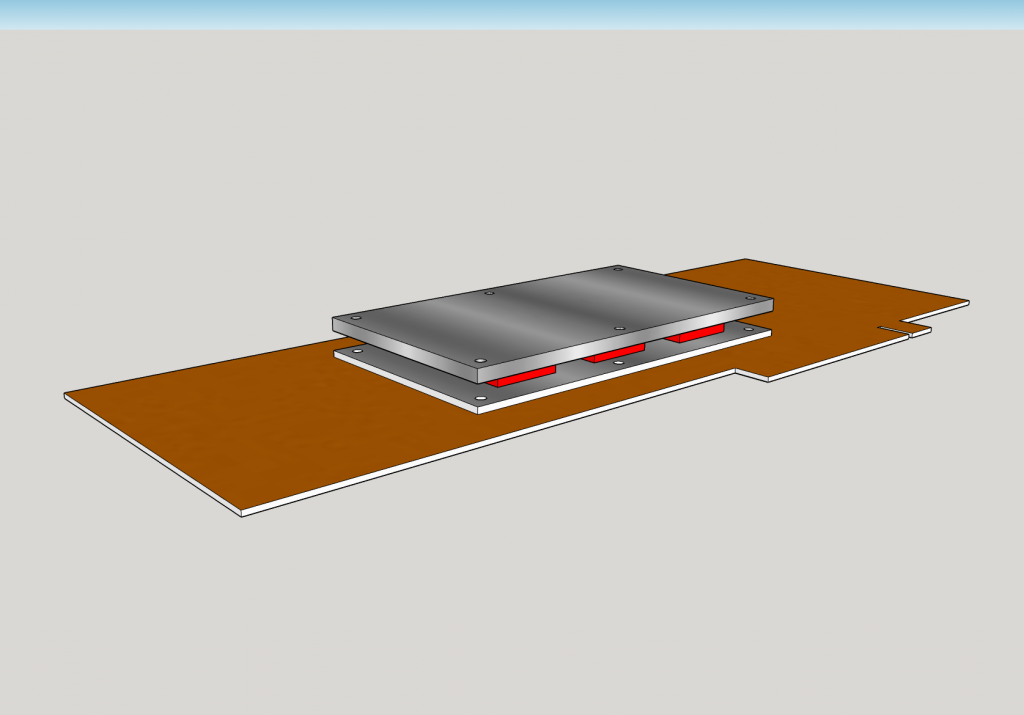

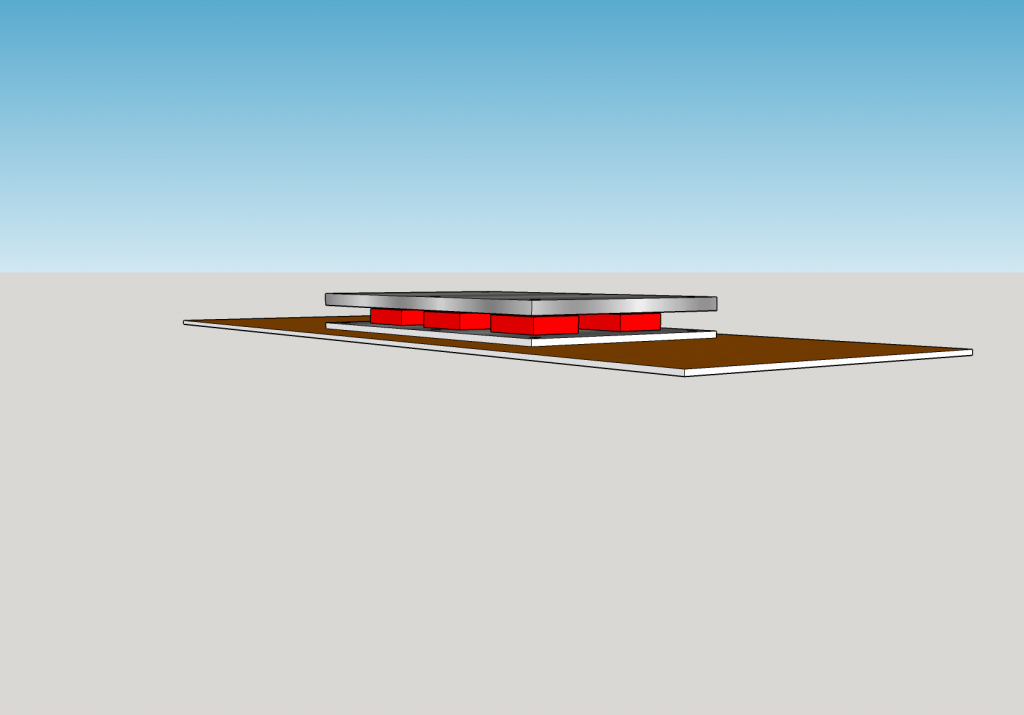

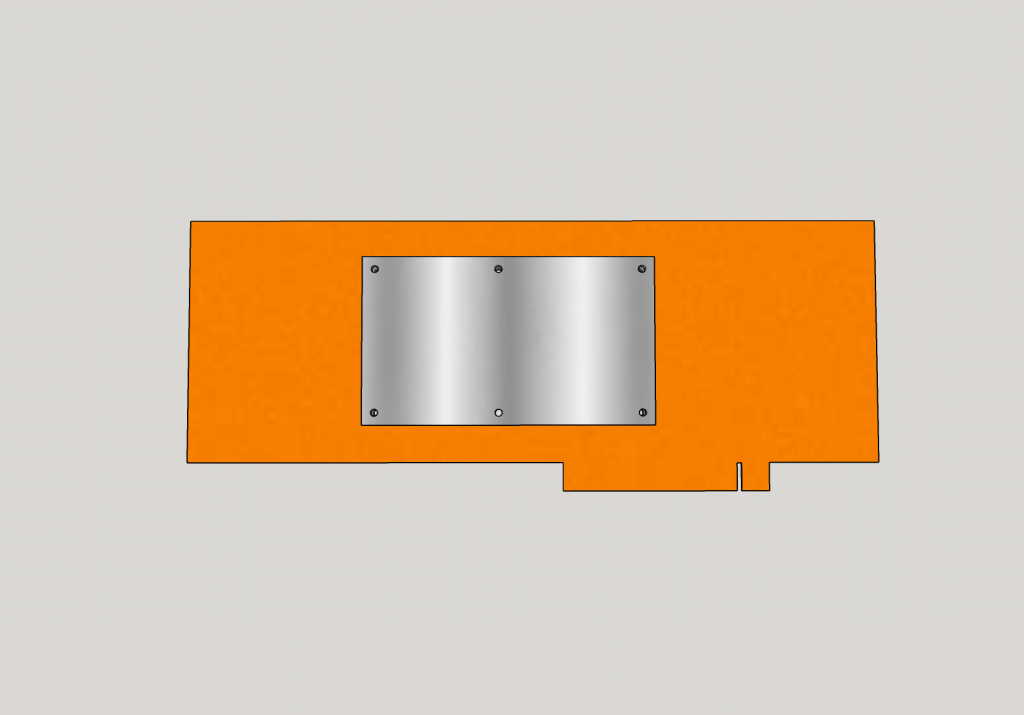

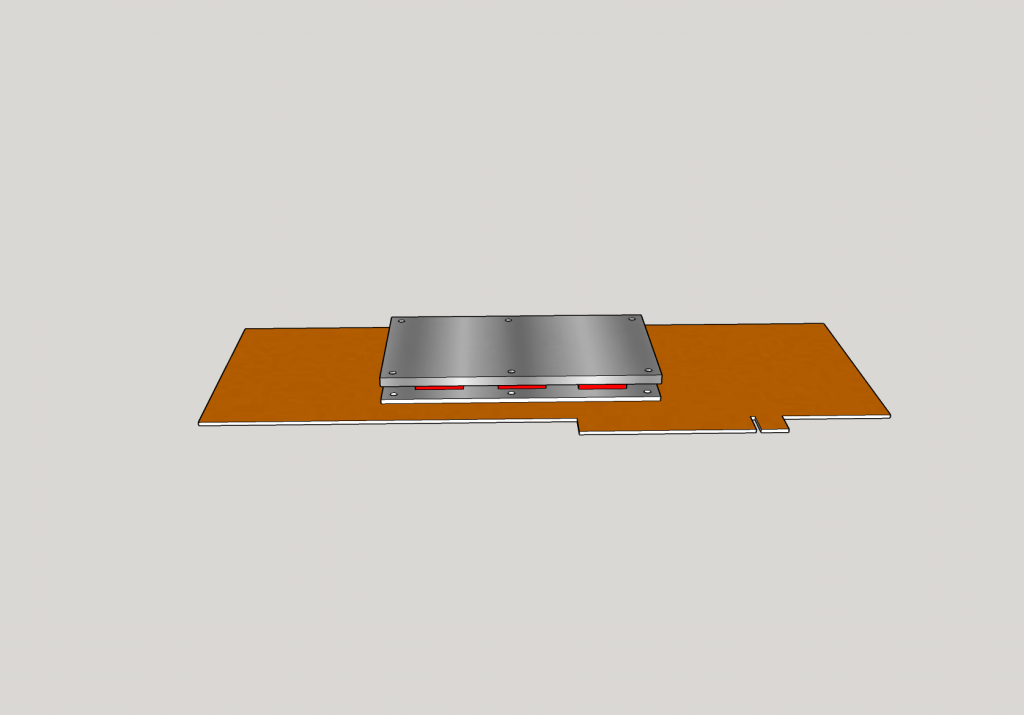

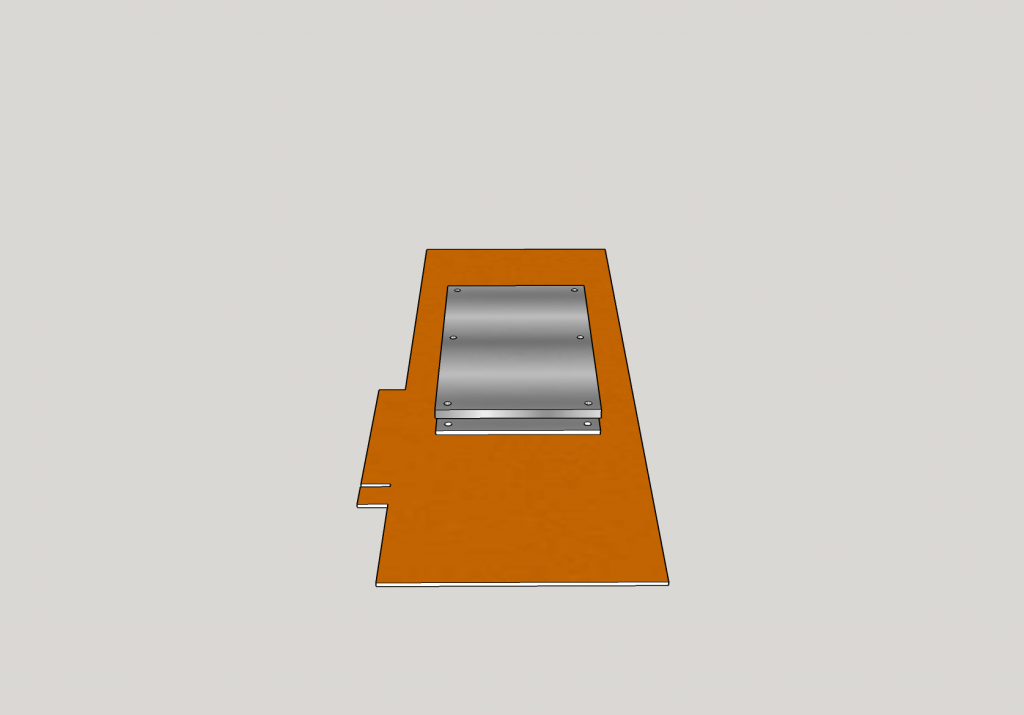

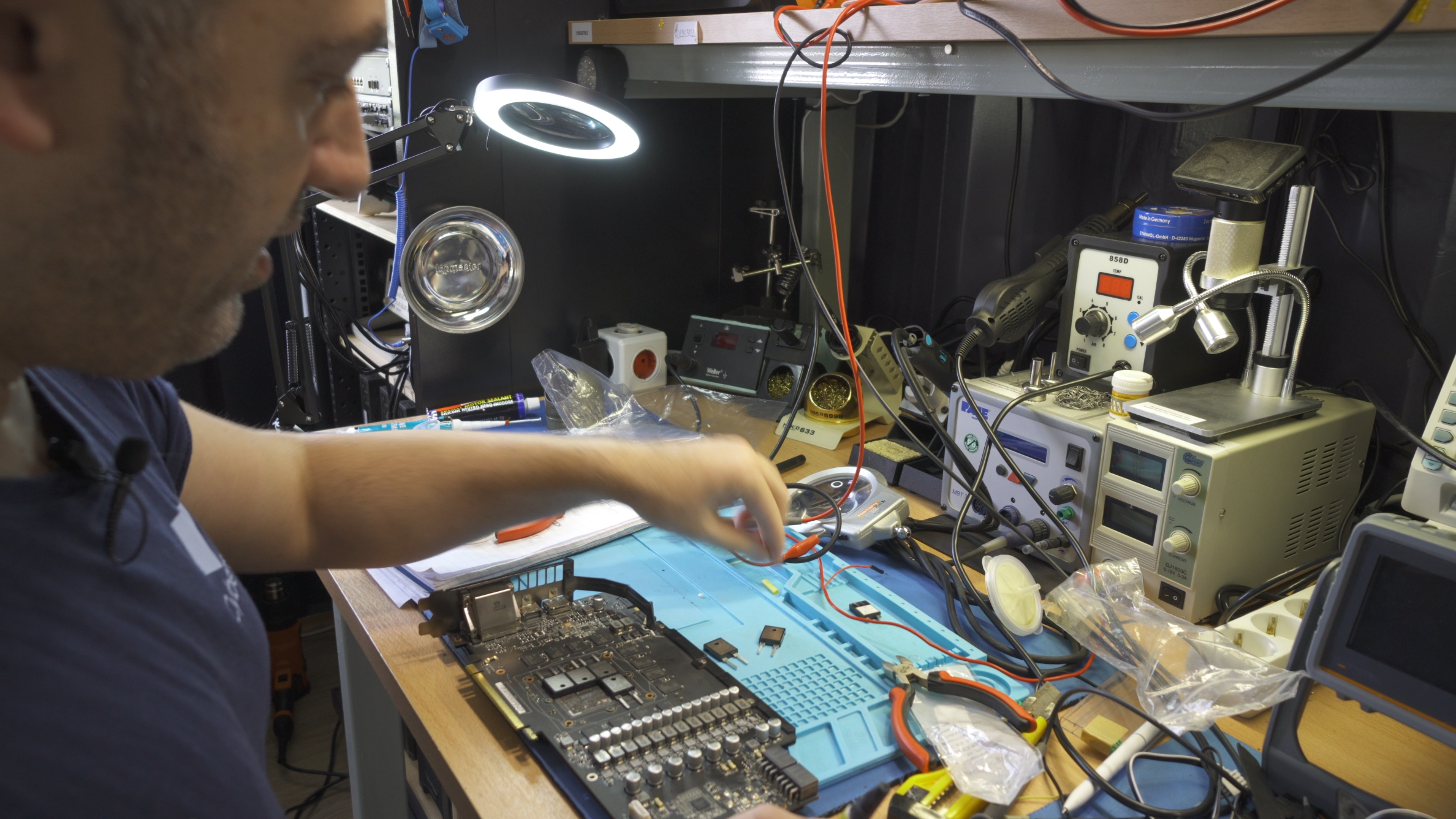

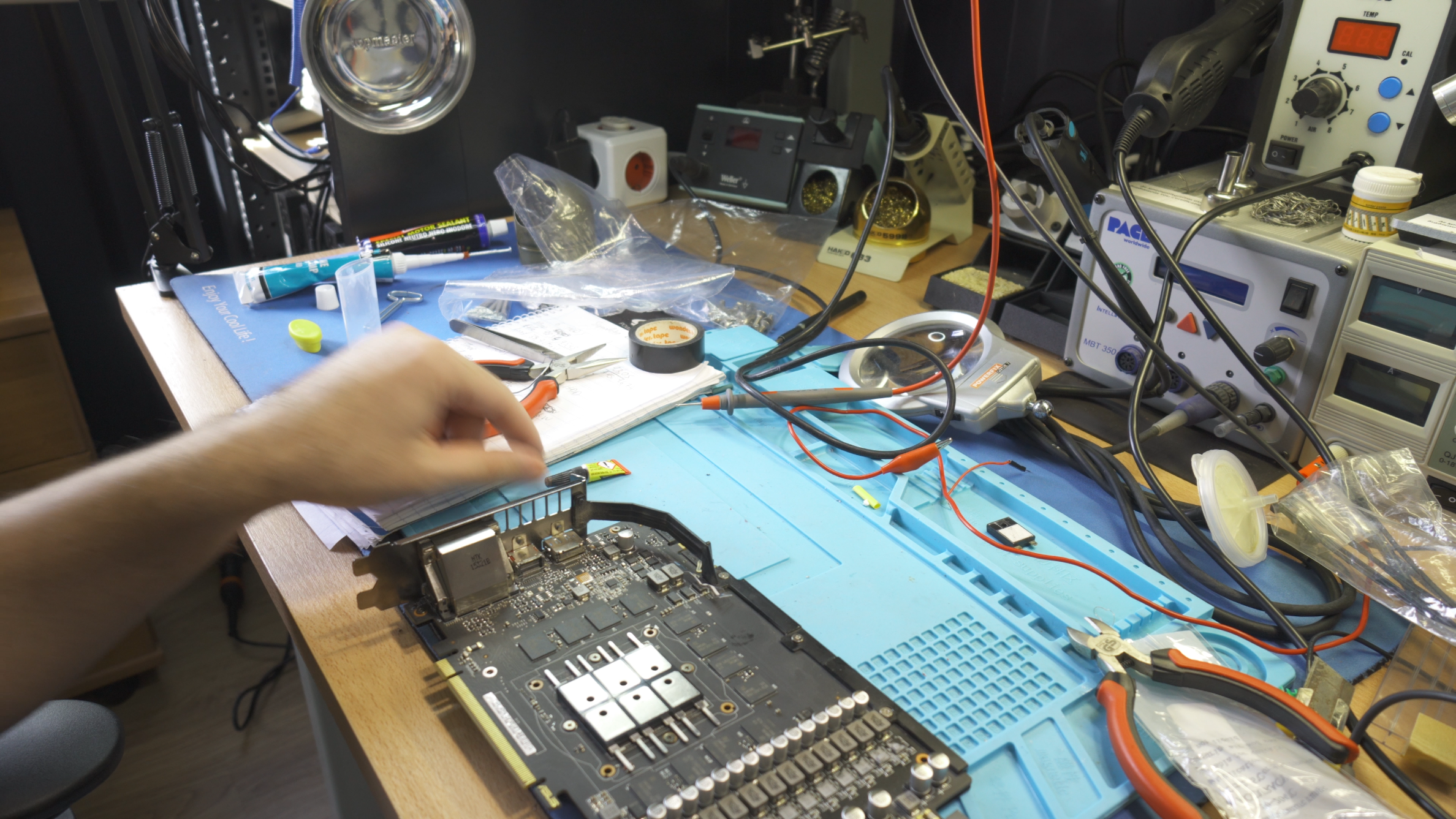

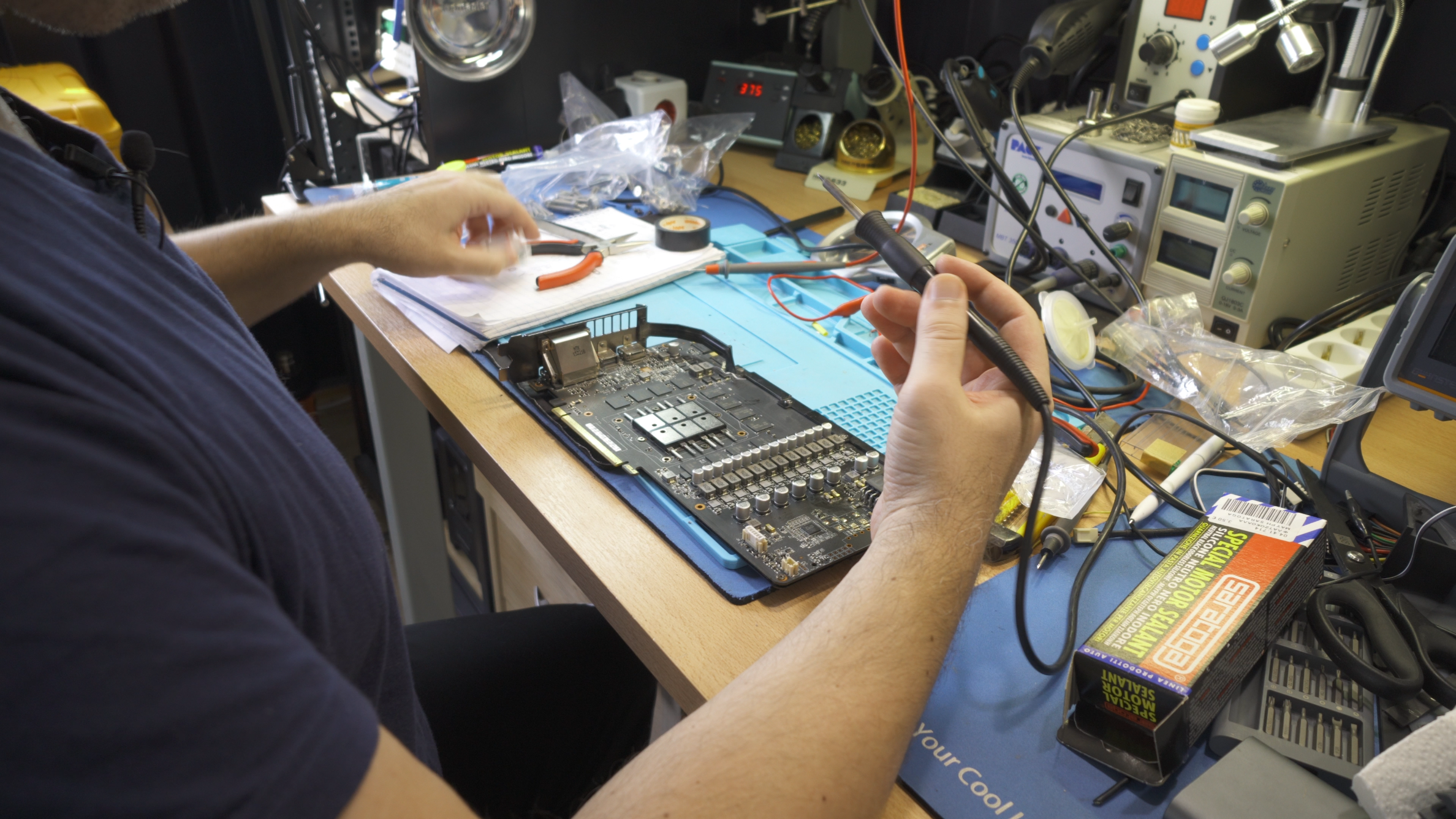

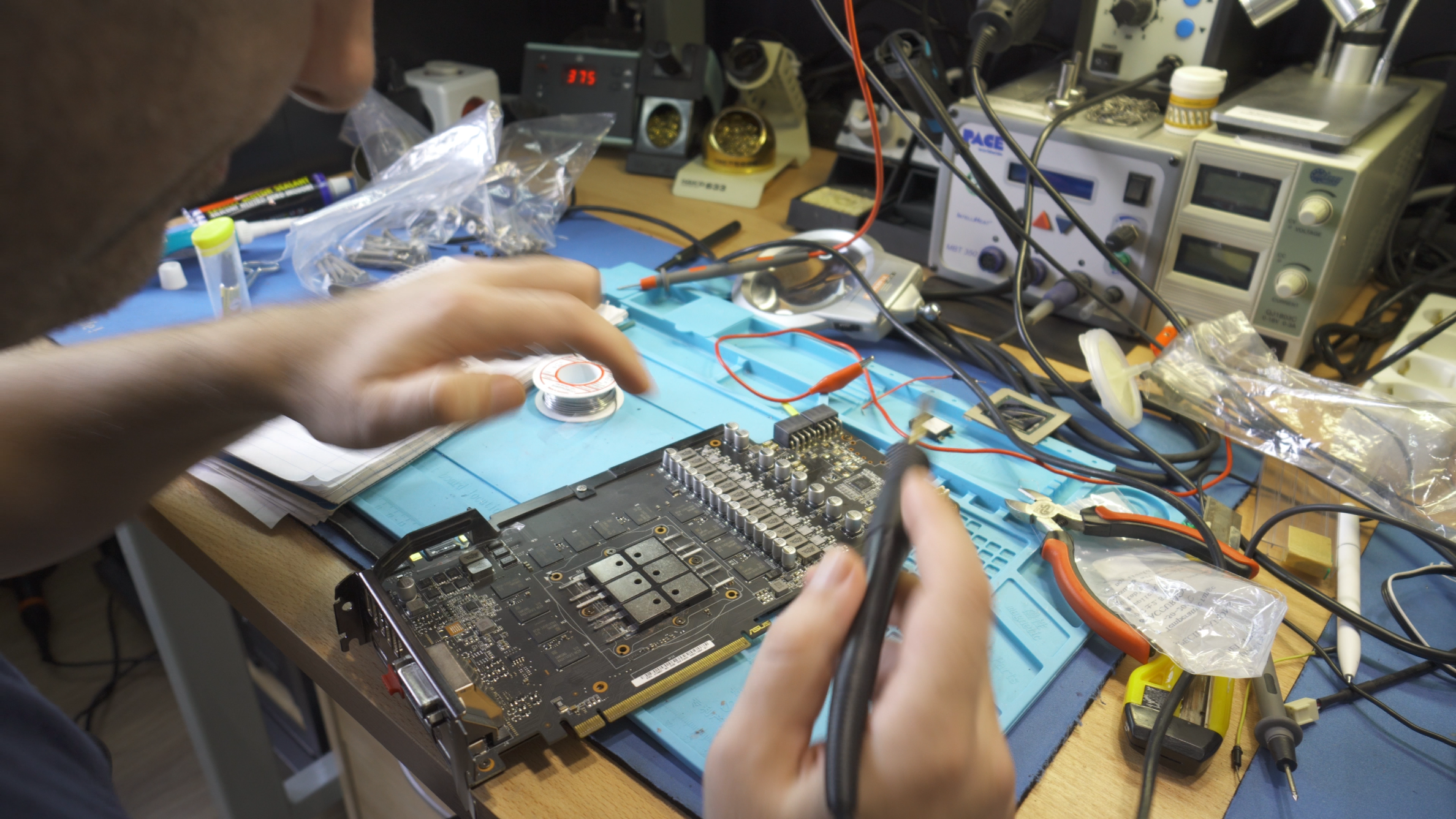

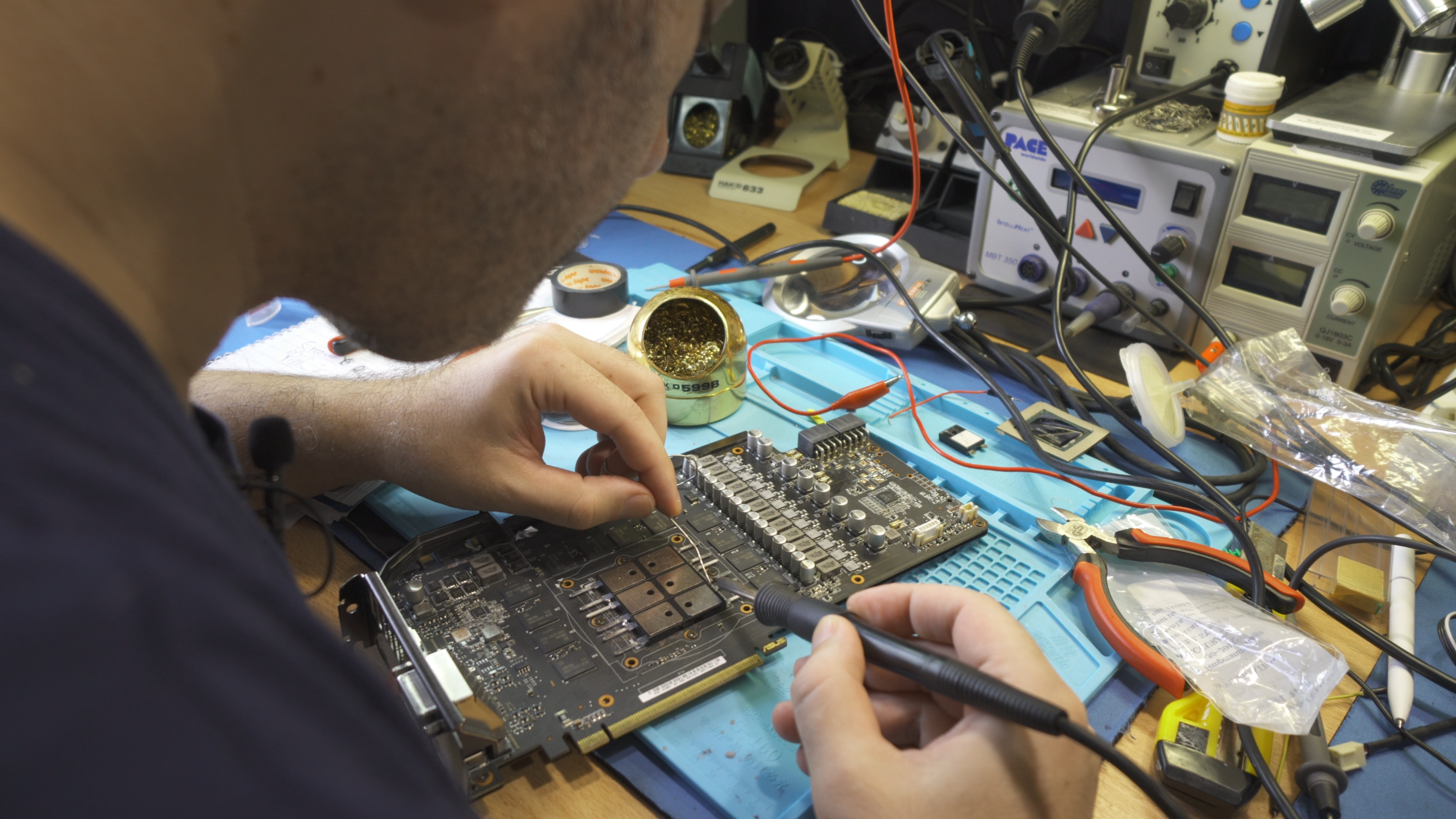

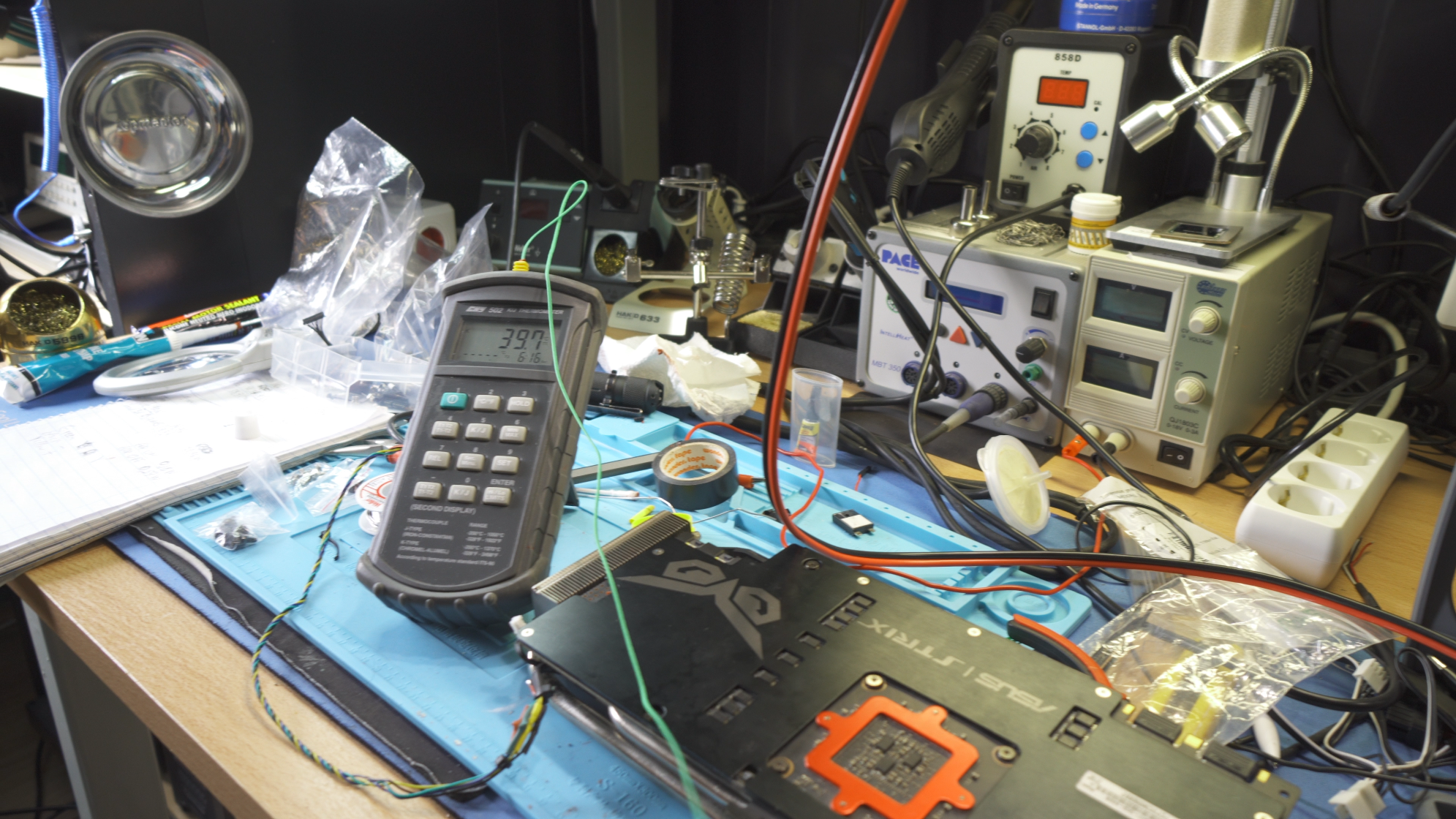

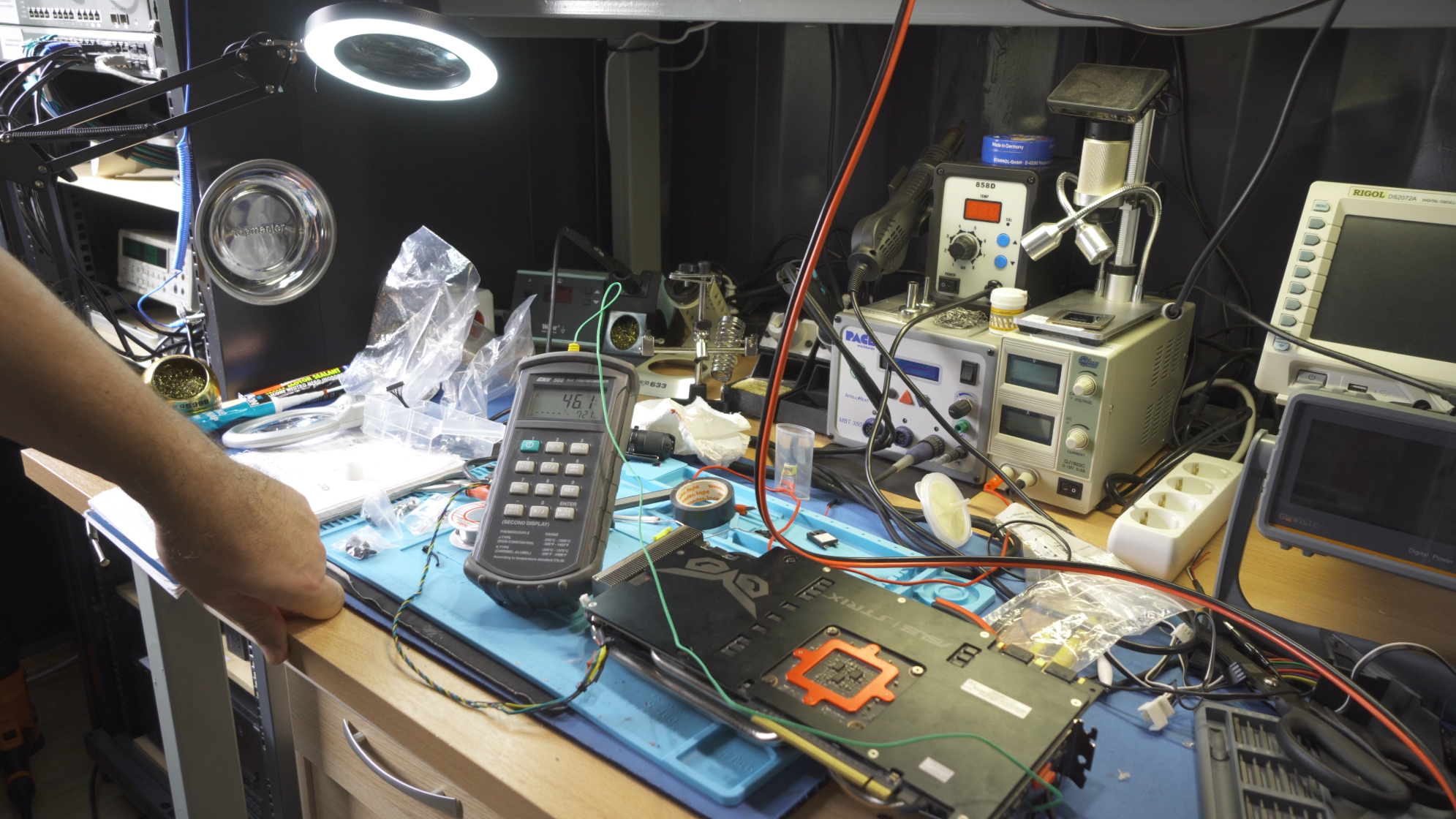

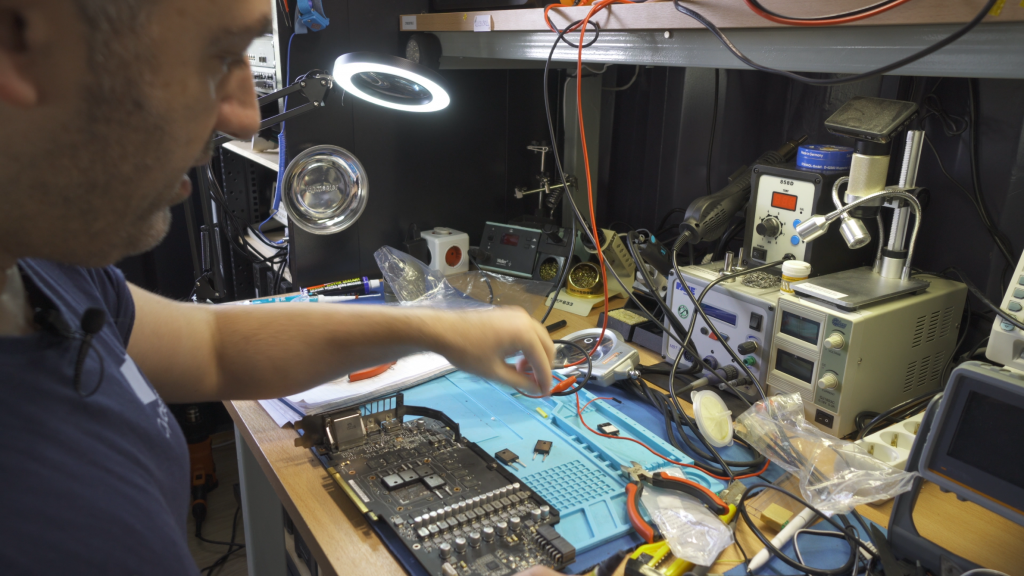

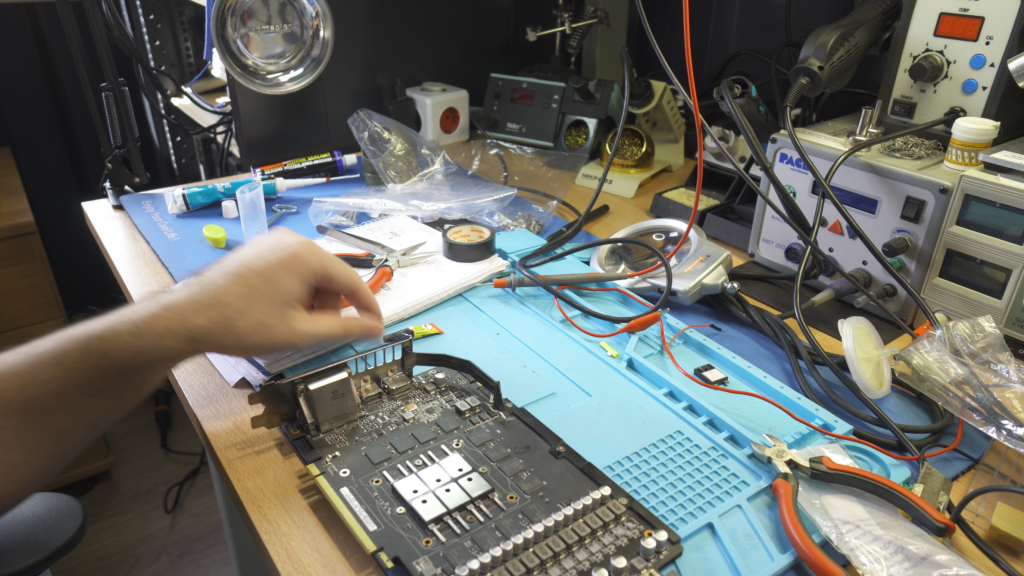

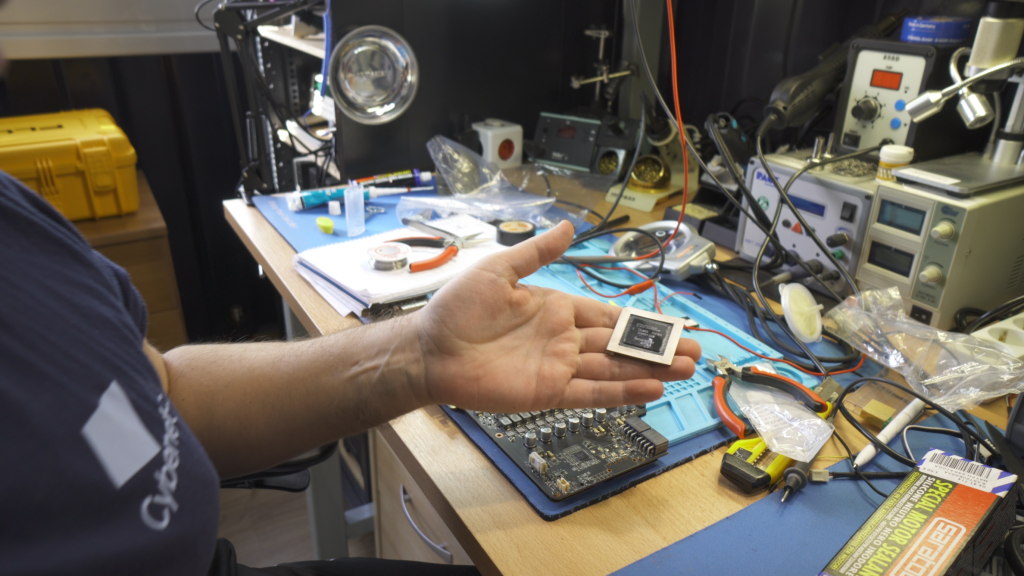

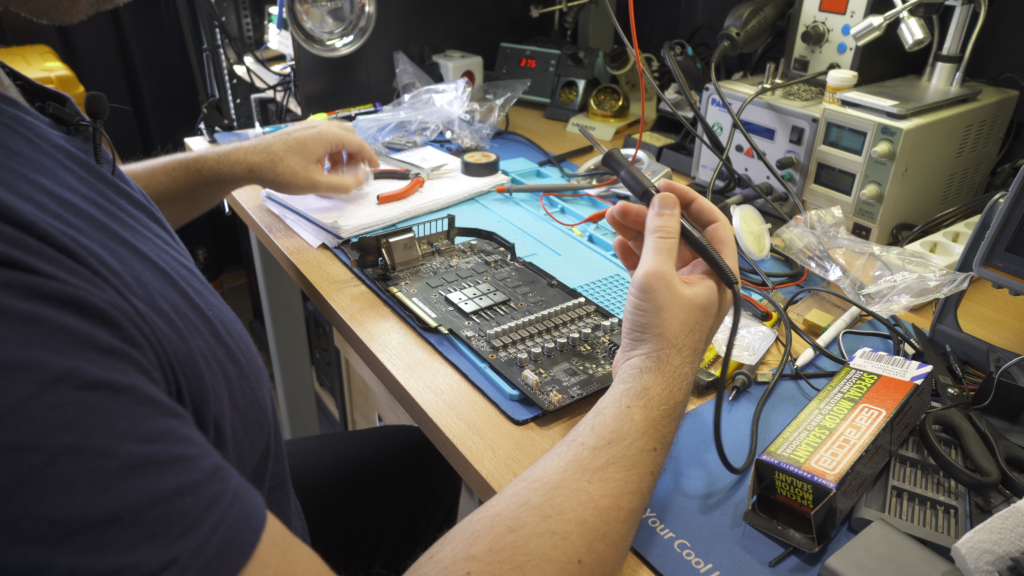

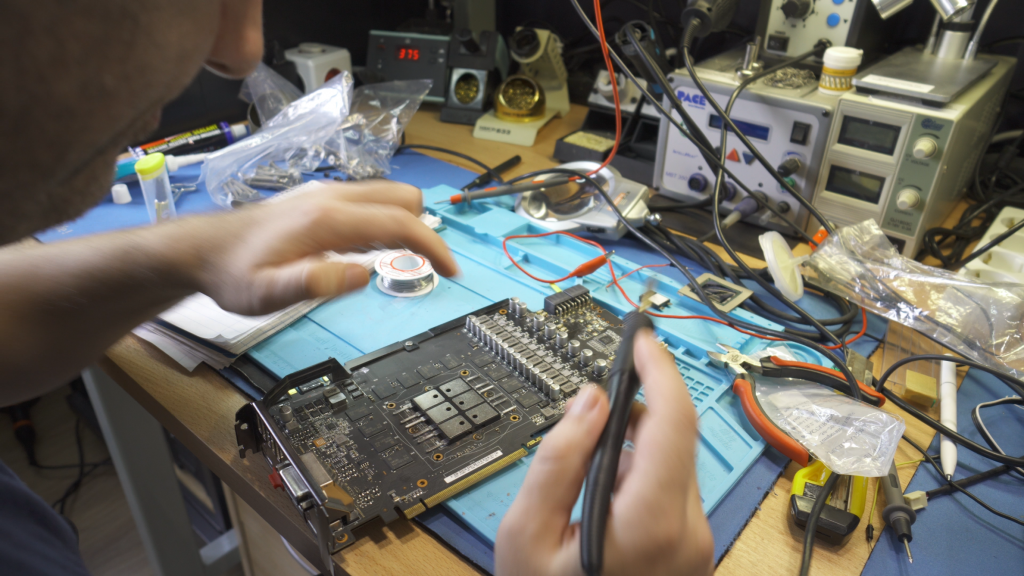

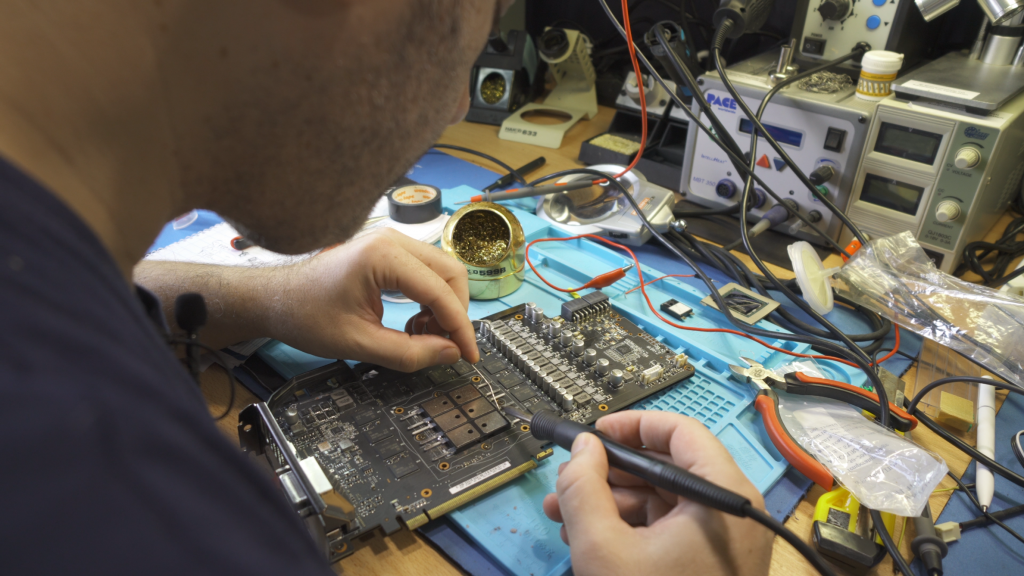

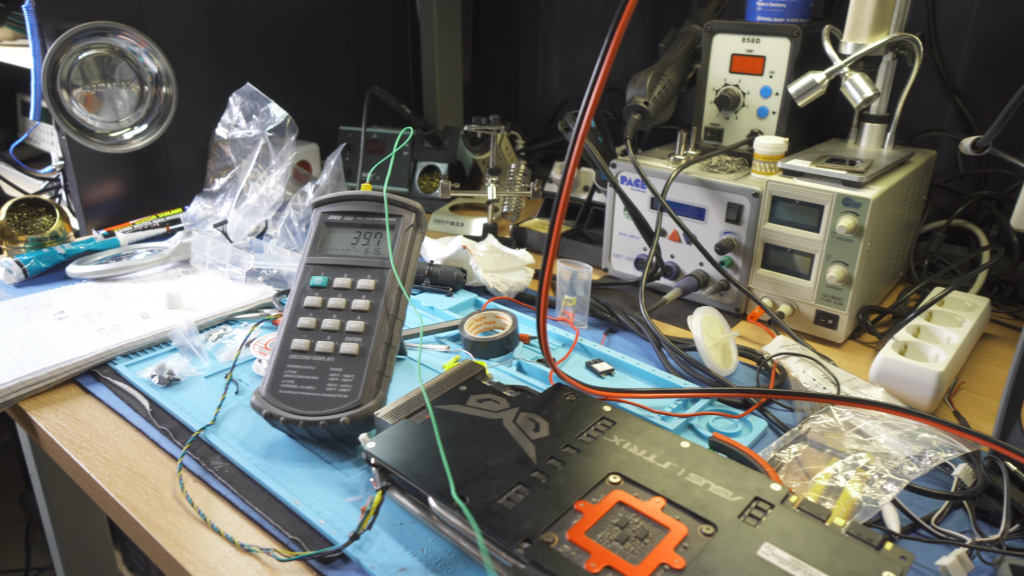

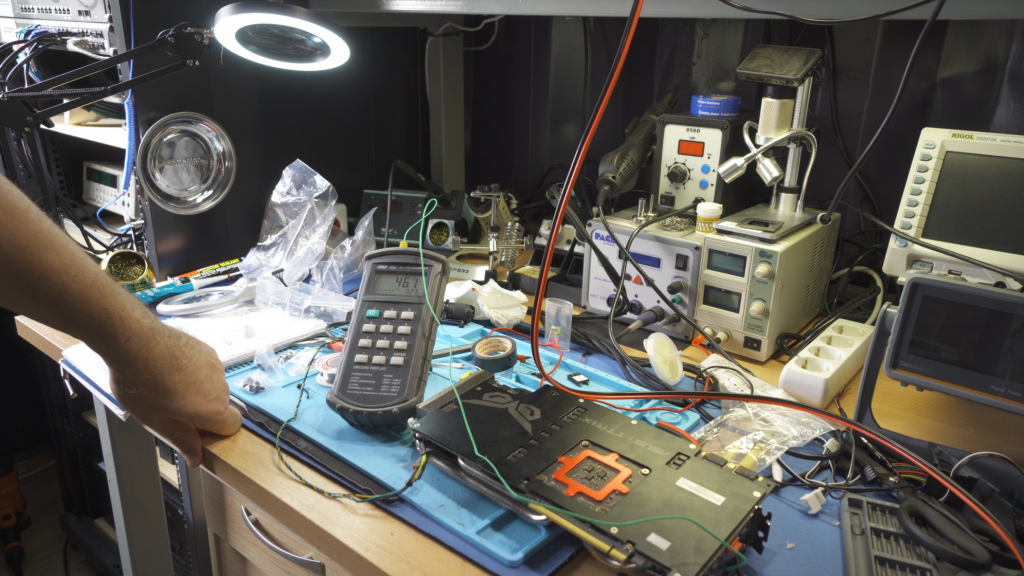

Wir begannen mit einem kaputten Mainboard, mit ausreichend starken Kühlkörpern. Wir ersetzten alle FETs und Chips unter diesen Kühlkörpern durch spezielle, leistungsfähige Widerstände – unsere Heizelemente. Die CPU zu simulieren ist nicht einfach, da man den Sockel entfernen muss und dort mehrere Widerstände zusammenquetschen muss. Wir haben mit viel Aufwand den Weg freigemacht und sechs 140-W-Widerstände im Bereich des CPU-Sockels installiert. Zur Kühlung der emulierten CPU werden wir einen Standard-Kühlkörper verwenden. Die Bereiche, in denen neben dem CPU-Sockel entsprechend bemessene Widerstände installiert werden, sind die VRMs, die RAM-Steckplätze, der Chipsatz und der NVMe-Steckplatz. Wir werden auch noch eine HDD modifizieren. Die Lasten sind in allen Teilen einstellbar und die CPU-Last kann bei Bedarf bis zu 600 W betragen!

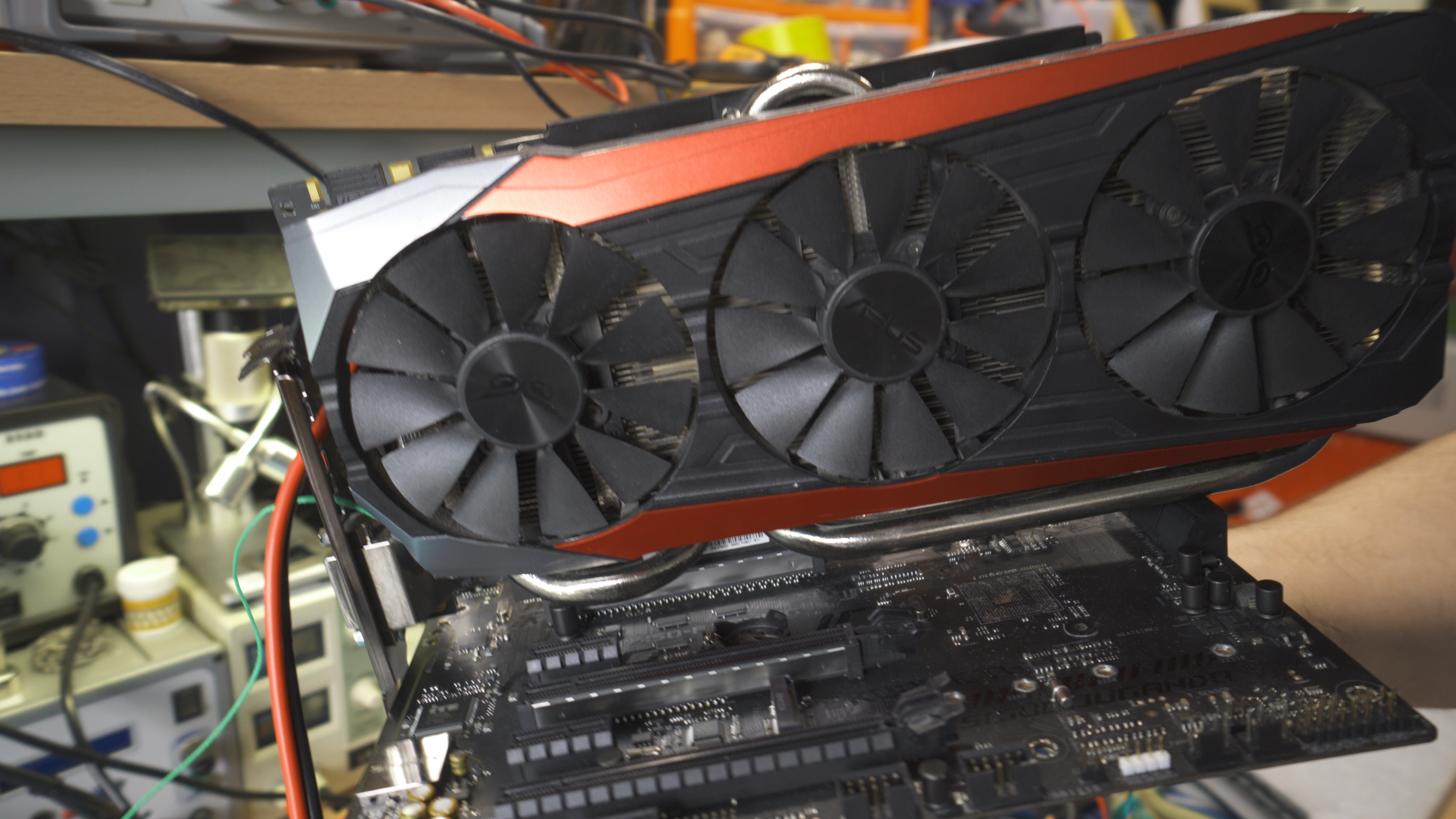

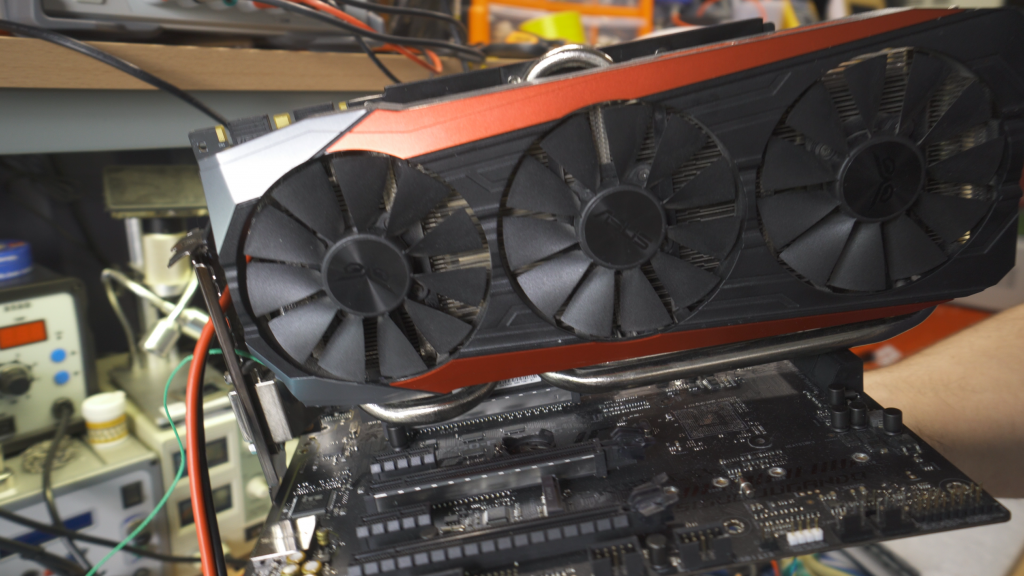

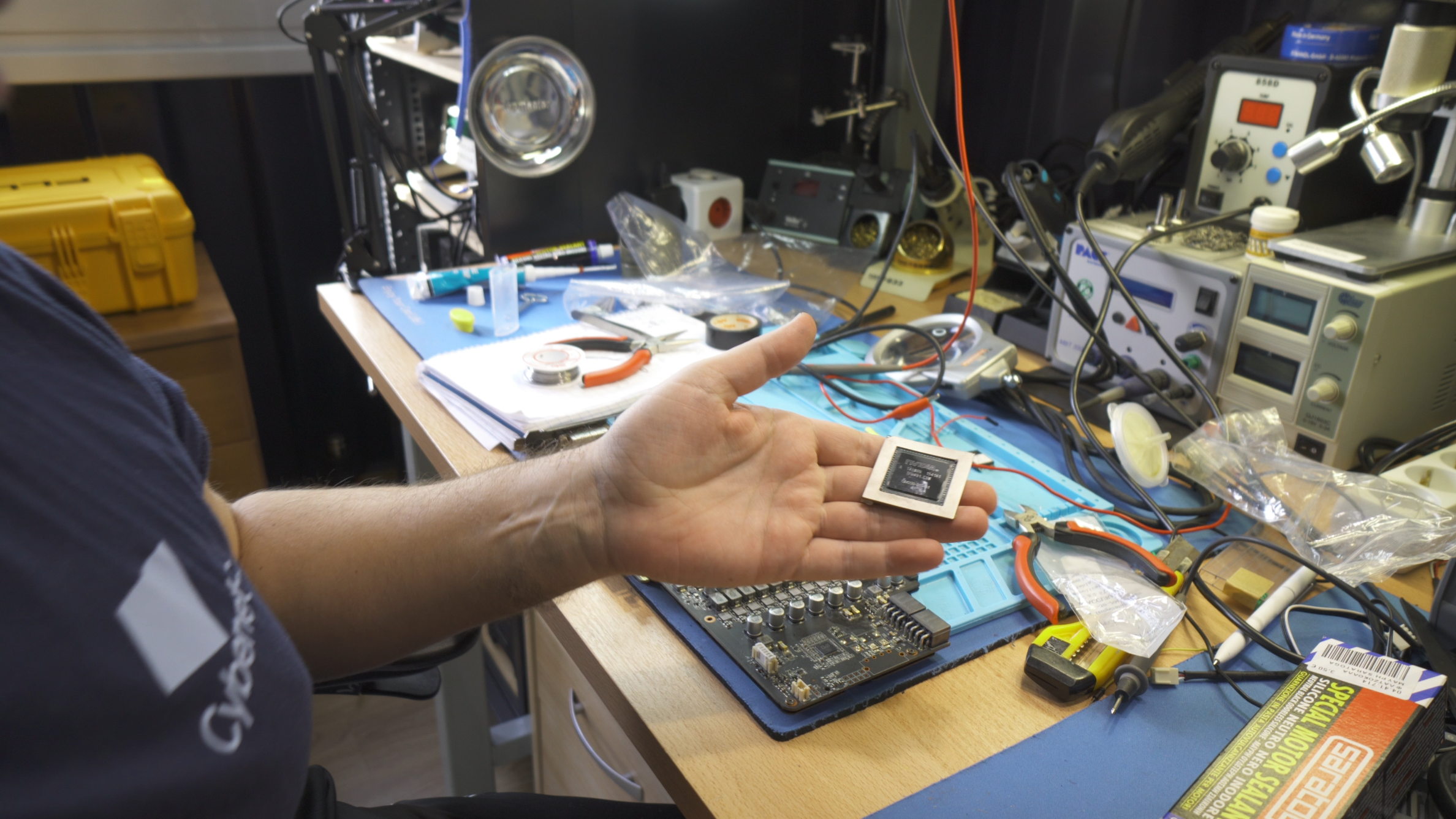

Neben dem Mainboard haben wir auch eine kaputte Grafikkarte “geschlachtet”, aus der wir die GPU entfernt und an ihrer Stelle mehrere Leistungswiderstände installiert haben, die bei Bedarf ebenfalls bis zu 600 W Last liefern können. Reicht das? Ja, es sollte.

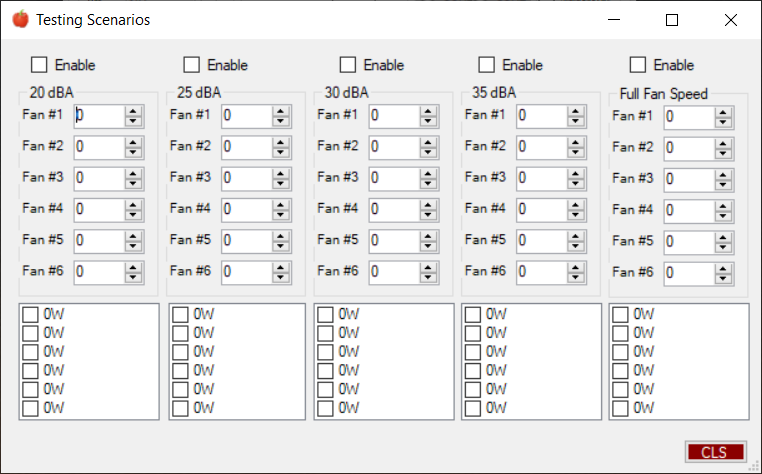

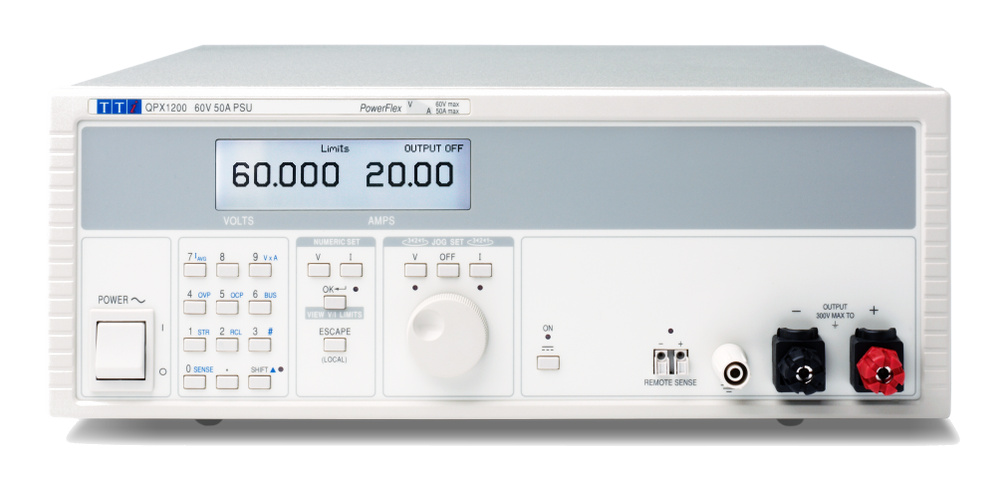

Die CPU- und GPU-Lasten werden durch ein leistungsstarkes und hochpräzises Labor-Netzteil (AimTTi QPX600DP) gesteuert, das in der Lage ist, zusammen bis zu 1200 W zu liefern. Das ist eine wahnsinnig hohe Last, und wir werden sie am Ende wohl auch nie voll ausnutzen. Wir haben vor, verschiedene Lastkombinationen sowohl für die CPU als auch für die GPU zu verwenden. Zum Beispiel könnten wir drei verschiedene Lasten für die CPU verwenden, 100W, 200W, 250W, und drei oder mehr andere Lasten für die GPU, 150W, 250W, und 350W. Die möglichen Lastkombinationen sind damit also neun, und wenn man noch drei von vier verschiedenen Lüfterdrehzahlszenarien (für die Gehäuselüfter) berücksichtigt (25 dBA, 30 dBA, 35 dBA und volle Lüfterdrehzahl), dann können alle Testkombinationen bis auf 36 Varianten gehen!

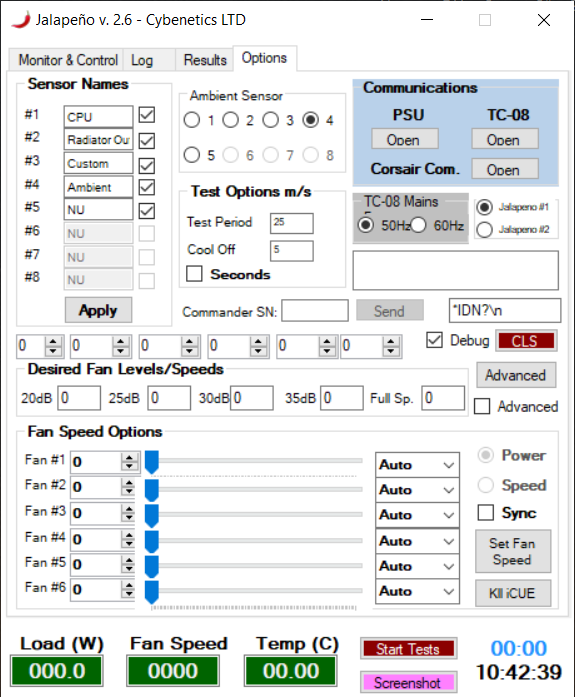

Wenn man nun einmal davon ausgeht, dass jeder Test mindestens 15 Minuten dauert, und wenn man zwischen jedem Test eine 5-minütige Leerlaufzeit einrechnet, damit alle Teile abkühlen können, beträgt die Gesamtzeit aller Testsitzungen 720 Minuten oder eben satte 12 Stunden!!! Aus diesem Grund braucht man einfach eine vollautomatische Test-Suite, die alles steuert und überwacht. Ein wesentliches Problem, das wir hatten, war die automatische Steuerung und Überwachung der Lüftergeschwindigkeit, aber glücklicherweise erwies sich der Corsair Commander Pro als einfach zu hacken und sehr fähig für diese Aufgabe. Man vergebe uns bitte diesen Frevel, es war einfach zu verlockend.

Was kommt, was wird?

Dies war eine kurze Präsentation dessen, was bald noch kommen wird. Folgen Sie uns für mehr auf Hardware Busters, und Igor, lass es weiter rocken! Wir werden zusammen mit igorslab.de eine Art strategische Partnerschaft eingehen und damit die gemessenen Daten auch der Leserschaft zur Verfügung stellen. Ich bin mir sicher, dass gerade die Leser dieser Seite wissenschaftliche Methodik und ein professionelles Herangehen schätzen werden. Das wird “normale” Gehäusetests nicht ersetzen können und soll es auch gar nicht. Aber es wird die Sichtweise der Tester um belastbare Fakten ergänzen, die man sonst nur mit extremen Aufwand selbst hätte ermitteln können.

Wir werden diese Partnerschaft mit Sicherheit auch auf die Messung und Bewertung von Netzteilen ausbauen, denn Cybenetics zertifiziert und misst Netzteile seit Jahren. Es ist allerdings nötig, noch eine passende Schnittstelle zu implementieren, dann ist es eine feine Win-Win-Situation für alle Beteiligten, die Leser natürlich inbegriffen. Und der YouTube-Kanal von Hardware Busters ist immer einen Besuch wert!

Kommentieren