Über Ada (Lovelace) und die kommenden Grafikkarten mit dem AD102 und bis zu 600 Watt TBP würde schon das eine oder andere Detail geleakt, heute kommt mit der voraussichtlichen Referenzplatine, den geplanten Kühlern und dem RAM-Ausbau sicher noch ein interessantes Puzzleteil dazu. Aus eigenen chinesischen Quellen wurde mir unlängst unter anderem ein Bild zugespielt, auf dem man die nackte, unbestückte Platine mehr oder weniger gut erkennen kann. Das Schema des als Referenzplatine bezeichneten Designs wurde mittlerweile von zwei weiteren Quellen bestätigt.

Auch wenn das PCB (das ich aus Rücksicht auf NVIDIA nicht im Original zeigen werde) für den Laien auf den ersten Blick nicht viel hergibt, ist es doch eine wahre Fundgrube, wenn man es verstehen kann. Natürlich muss man all diese Dinge mit der nötigen Skepsis betrachten, aber es sieht auf alle Fälle wirklich plausibel aus. Zusätzlich habe ich auch noch Informationen darüber, wie man die kolportieren 600 Watt gedenkt wegzukühlen und die Bestätigung, dass meine ersten Mutmaßungen nicht falsch waren. Dazu gehört auch, dass ich die GeForce RTX 3090 Ti als Testlauf für Ada und den AD102 bezeichnet hatte. Und ja, ich habe recht behalten, doch dazu gleich mehr.

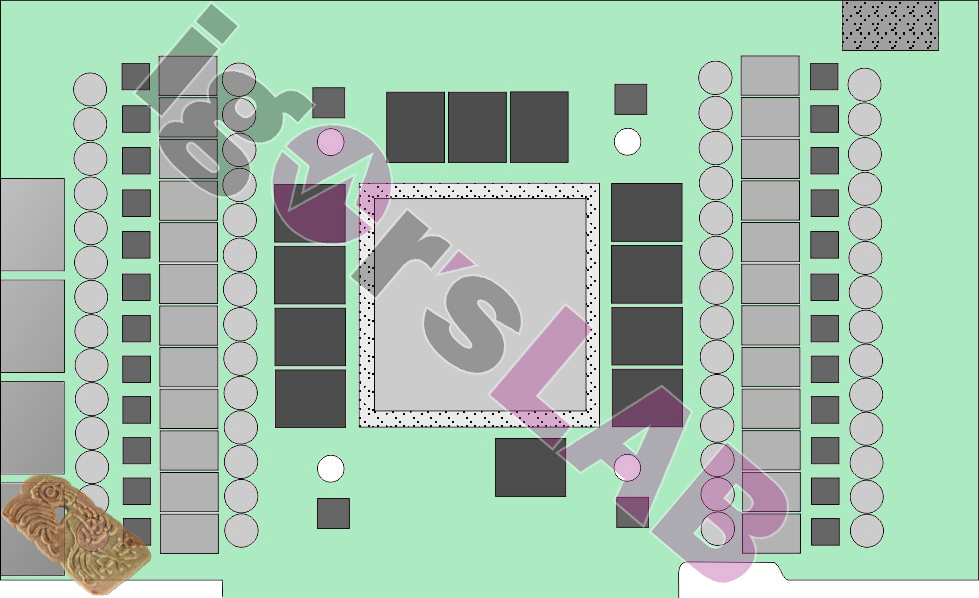

Selbst wenn manche Bereiche leider unscharf waren (auch gute Quellen sind leider mittlerweile sehr vorsichtig), lässt sich aus dem Größenverhältnis und den Abmessungen der Komponenten einer bekannten Referenzplatine der NVIDIA GeForce RTX 3090 doch eine recht genaue Rekonstruktion dessen ableiten, was NVIDIA den betreffenden Firmen eigentlich mitteilen wollte. Ich habe das Ganze noch einmal selbst nachgezeichnet (um auch keine NDAs zu brechen) und einigermaßen passend positioniert. Ich verweise jedoch noch einmal darauf, dass Änderungen seitens NVIDIA jederzeit möglich sind und nichts in Stein gemeißelt sein muss.

Immerhin bis zu 600 Watt TBP (also für die gesamte Platine) müssen verarbeitet und später fast komplett auch wieder als Abwärme entsorgt werden. Die Aufteilung der Verluste für die einzelnen Komponenten lässt sich recht einfach abschätzen, da lag ich ja auch bei Ampere nur wenige Watt daneben. Doch das wird ein anderer Artikel, weil ich noch einige Komponenten recherchieren muss.

Was wir jedoch auf den ersten Blick sehen, sind satte 24 Spannunsgwandler für die GPU! Da NVIDIA (auch das wurde mittlerweile geleakt) wieder auf einen uP9512 setzen wird, der lediglich 8 Phasen erzeugen kann (aber gut erhältlich ist), werden pro Phase höchstwahrscheinlich insgesamt drei Spannungswandler zusammen angesteuert. Die vier dunklen Rechtecke in der Nähe der Bohrlöcher für den Kühler sollten die VRM für die Speicher-Spannungswandler sein. Damit wären wir bei vier Phasen für den GDDR6X angelangt.

Was wir in diesem Zusammenhang auch sehen, sind maximal 12 Lötplätze für den GDDR6X (von Micron), die es aktuell als 1 und 2 GB Module gibt. Daraus kann man schlussfolgern, dass bei Vollbestückung 12 bzw. 24 GB (eher wahrscheinlich) möglich sind. Kleinere Versionen könnten dann wieder mit 8 bzw. 16 GB (wahrscheinlich) bestückt sein, was auch die Anzahl der Spannungswandler auf drei reduzieren dürfte.

Kommen wir nun wieder auf die RTX 3090 Ti zurück und das, was ich einen Testlauf genannt habe. Wie ich in Erfahrung bringen konnte, sollen der GA102 (Ampere) und der AD102 (Ada) Chip nämlich Pin-kompatibel sein. Das hieße im Umkehrschluss aber auch, dass man bereits jetzt bei allen Boardpartnern in der Lage sein dürfte, auch ohne den kommenden Chip an den neuen Platinen und den Kühlern zu arbeiten, indem man einfach ein offenes 600 Watt BIOS nutzt. Dann kann sowohl die neue Platine als auch die Kühlung vollumfänglich getestet werden.

Apropos Kühlung: einige Quellen berichten, dass NVIDIA für die Referenz bzw. FE auf einen Tripple-Slot-Luftkühler setzen wird, während fast alle Boardpartner auf ein 3,5-Slot Design setzen dürften. Damit wird auch die Gewichtsklasse über 2 Kilogramm mit Sicherheit eine Menge neuer Mitbewerber vorweisen können. Über AiO-Kompaktkühler und Karten mit echten Wasserblock ab Werk wird abenfalls laut nachgedacht, jedoch nicht als primäre Lösung. Und zur Beruhigung aller potentiellen Kunden mit älteren Netzteilen: ein 12+4 (12VHPWR) auf 4x 6+2 Pin (PCIe alt) liegt natürlich auch immer bei.

112 Antworten

Kommentar

Lade neue Kommentare

Veteran

Veteran

Urgestein

1

Urgestein

Urgestein

Urgestein

Urgestein

1

Urgestein

Urgestein

1

Veteran

Urgestein

Urgestein

Veteran

Urgestein

Neuling

Urgestein

Alle Kommentare lesen unter igor´sLAB Community →