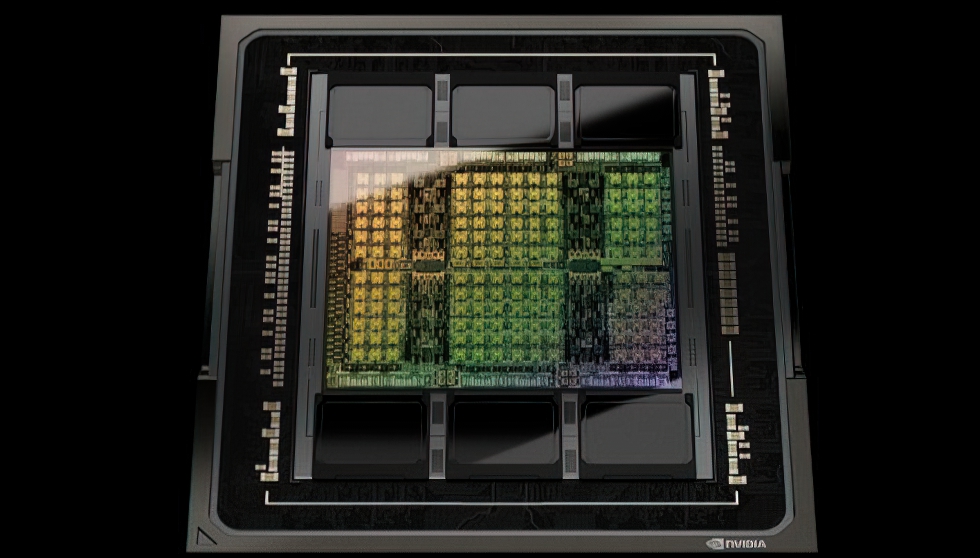

NVIDIA präsentiert mit der H100 GPU nicht nur eine neue KI-GPU, sondern verspricht einen Leistungssprung um eine ganze Größenordnung. Um die nächste Generation an KI-Rechenzentren zu prägen, stellt NVIDIA heute die neue Rechenplattform der nächsten Generation mit Hopper-Architektur vor. Benannt nach Grace Hopper, einer bahnbrechenden US-amerikanischen Informatikerin, ist die neue Architektur Nachfolgerin der Ampere-Architektur, die vor zwei Jahren eingeführt wurde. Das Unternehmen kündigte außerdem seinen ersten Hopper-basierten Grafikprozessor an, den NVIDIA H100, der mit 80 Milliarden Transistoren aufwarten kann. Der H100 ist damit der größte und leistungsstärkste Beschleuniger der Welt und verfügt über neue Funktionen wie die revolutionäre Transformer-Engine und den hoch skalierbaren NVIDIA NVLink® Interconnect für alle anfallenden Aufgaben einer noch leistungsstärkeren KI.

Der NVIDIA H100 Grafikprozessor setzt einen neuen Standard bei der Beschleunigung von KI und HPC im großen Maßstab und bietet laut NVIDIA sechs bahnbrechende Innovationen:

- Mit 80 Milliarden Transistoren in einem hochmodernen TSMC 4N Prozess, der für die beschleunigten Rechenanforderungen von NVIDIA entwickelt wurde, bietet der H100 eine Beschleunigung in den Bereichen AI, HPC, Speicherbandbreite, Interconnect und Kommunikation, einschließlich fast 5 Terabyte pro Sekunde an externer Konnektivität. Die H100 ist die erste GPU, die PCIe Gen5 unterstützt und die erste, die HBM3 nutzt und damit eine Speicherbandbreite von 3 TB/s ermöglicht. Zwanzig H100-GPUs könnten damit dem gesamten Internetverkehr der Welt standhalten und ermöglichen es Kunden, fortschrittliche Systeme und große Sprachmodelle zu nutzen, die Daten in Echtzeit inferenzieren.

- Die neue Transformer-Engine ist jetzt das Standardmodell für die Verarbeitung natürlicher Sprache. Transformer ist eines der wichtigsten Deep-Learning-Modelle, die je entwickelt wurden. Die Transformer Engine des H100-Beschleunigers wurde entwickelt, um diese Netzwerke bis zu 6-mal schneller zu machen als die aktuelle Generation, ohne dabei an Genauigkeit zu verlieren.

- Die MIG-Technologie der zweiten Generation ermöglicht die Partitionierung einer einzelnen GPU in sieben kleinere, vollständig isolierte Instanzen unterteilt werden, um verschiedene Arten von Aufgaben zu bewältigen. Die Hopper-Architektur erweitert die MIG-Fähigkeiten um das bis zu 7-fache gegenüber der vorherigen Generation, indem sie sichere mandantenfähige Konfigurationen in Cloud-Umgebungen für jede GPU-Instanz bietet.

- Confidential Computing – der H100 ist der weltweit erste Beschleuniger mit der Fähigkeiten, um KI-Modelle und Kundendaten während der Verarbeitung vertraulich zu schützen. Kunden können geschütztes Computing auch für föderiertes Lernen in datenschutzsensiblen Branchen wie Gesundheitswesen und Finanzdienstleistungen sowie auf gemeinsam genutzten Cloud-Infrastrukturen einsetzen.

- Um die größten KI-Modelle zu beschleunigen, kombiniert man NVIDIAs NVLink der 4. Generation mit einen neuen, externen NVLink Switch, um NVLink als Scale-up-Netzwerk über den Server hinaus zu erweitern, was den Anschluss von bis zu 256 H100-GPUs bei 9-fach höherer Bandbreite im Vergleich zur vorherigen Generation mit NVIDIA HDR Quantum InfiniBand ermöglicht.

- Neue DPX-Anweisungen beschleunigen die dynamische Programmierung, die ein Vielzahl von Algorithmen, einschließlich Routenoptimierung und Genomik, um das bis zu 40-fache im Vergleich zu CPUs und bis zu 7x im Vergleich zu GPUs der vorherigen Generation beschleunigen. Dazu gehört der Floyd-Warshall Algorithmus zur Ermittlung optimaler Routen für autonome Roboterflotten in dynamischen Lagerhausumgebungen und der Smith-Waterman-Algorithmus, der bei der Sequenzausrichtung für die und Protein-Klassifizierung und -Faltung.

Die kombinierten Technologie-Innovationen des H100 sollen NVIDIAs führende Position bei KI-Inferenz und Training erweitern, um Echtzeit- und immersive Anwendungen mit KI-Modellen im großen Maßstab zu ermöglichen. Der H100 wird Chatbots mit dem weltweit leistungsstärksten monolithischen Transformer-Sprachmodell Megatron 530B mit einem bis zu 30-fach höheren Durchsatz als die Vorgängergeneration ermöglichen und er erfüllt gleichzeitig die für Echtzeit-KI erforderliche Latenzzeit von unter einer Sekunde.

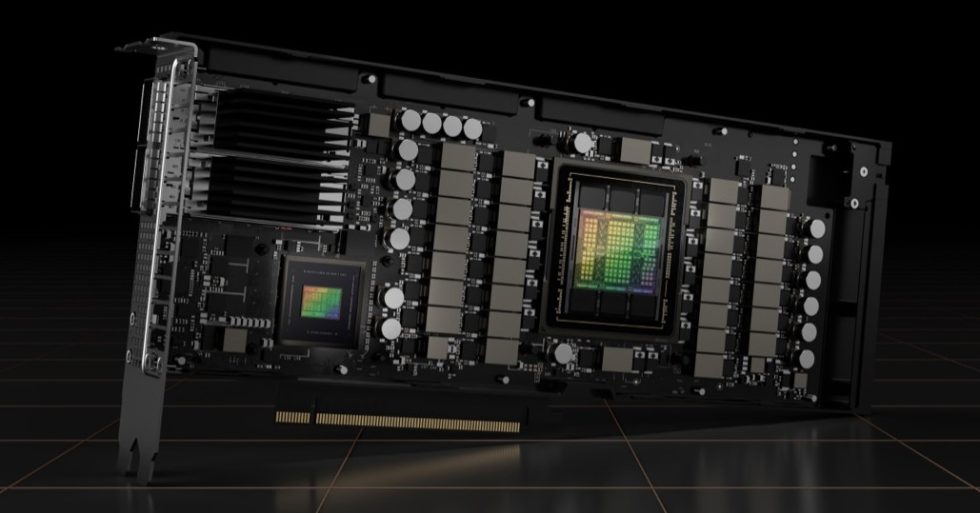

NVIDIAd H100 kann in allen Arten von Rechenzentren eingesetzt werden, einschließlich On-Premises, Cloud, Hybrid-Cloud und Edge. Er wird voraussichtlich noch in diesem Jahr weltweit bei den führenden Cloud-Service-Anbietern und Computerherstellern und Computerherstellern sowie direkt von NVIDIA erhältlich sein. NVIDIAs DGX™-System der vierten Generation, das DGX H100, verfügt über acht H100-GPUs und liefertinsgesamt 32 Petaflops an KI-Leistung mit der neuen FP8-Präzision und bietet damit die nötige Skalierbarkeit für die massiven Rechenanforderungen für große Sprachmodelle, Empfehlungssysteme, Gesundheitsforschung und Klimawissenschaft.

Jeder Grafikprozessor in den DGX H100 Systemen ist über NVLink der vierten Generation angebunden und bietet 900 GB/s Konnektivität, 1,5x mehr als bei der vorherigen Generation. Mit NVSwitch™ können alle acht H100-GPUs über NVLink verbunden werden. Ein externer NVLink Switch kann bis zu 32 DGX H100-Knoten der nächsten Generation von NVIDIA DGX SuperPOD™ Supercomputern vernetzen. Hopper erfährt eine breite Branchenunterstützung von führenden Cloud-Service-Anbietern wie Alibaba Cloud, Amazon, Web Services, Baidu AI Cloud, Google Cloud, Microsoft Azure, Oracle Cloud und Tencent Cloud, die planen, H100-basierte Instanzen anzubieten. Eine breite Palette von Servern mit H100-Beschleunigern wird von den weltweit führenden Systemherstellern erwartet, darunter Atos, BOXX Technologies, Cisco, Dell Technologies, Fujitsu, GIGABYTE, H3C, Hewlett Packard Enterprise, Inspur, Lenovo, Nettrix und Supermicro.

Quelle: NVIDIA

2 Antworten

Kommentar

Lade neue Kommentare

Urgestein

Mitglied

Alle Kommentare lesen unter igor´sLAB Community →