One or the other detail has already been leaked about Ada (Lovelace) and the upcoming graphics cards with the AD102 core and up to 600 watts TBP. Today, another interesting piece of the puzzle is surely added with the expected reference board, the planned coolers and the RAM configuration. I recently received a picture from my own Chinese sources, among others, where you can more or less see the bare, unpopulated PCB. The schematic of the design, which is called the reference PCB, has been confirmed by two other sources in the meantime.

Even if the PCB (which I won’t show in the original out of consideration for NVIDIA) doesn’t reveal much to the layman at first glance, it’s a real treasure trove if you can understand it. Of course, you have to look at all these things with the necessary skepticism, but it looks really plausible in any case. In addition, I also have information about how the 600 watts that are reported are to be cooled down and the confirmation that my initial assumptions were not wrong. This includes the fact that I had called the GeForce RTX 3090 Ti a test run for Ada and the AD102. And yes, I was right, but more on that in a moment.

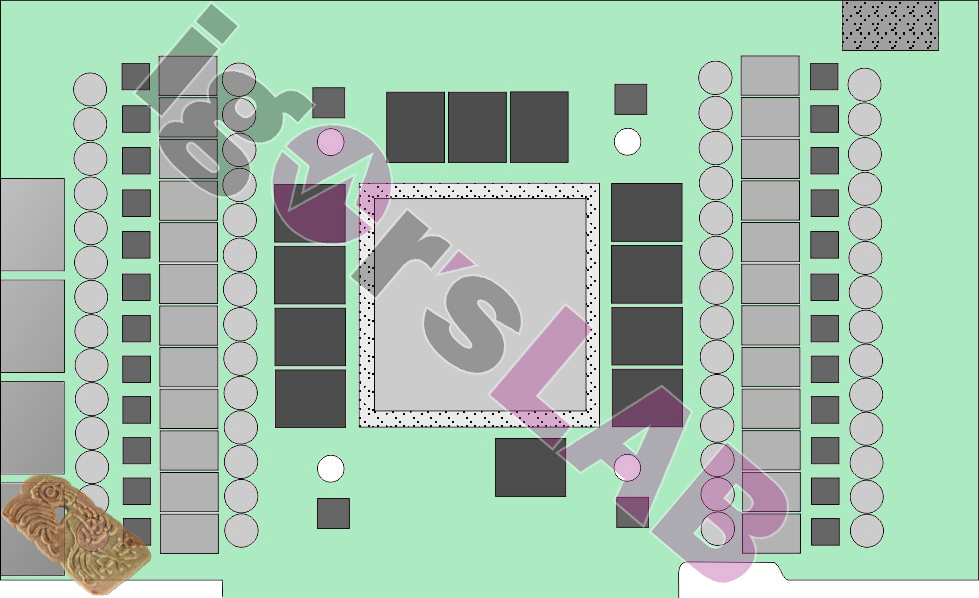

Even if some areas were unfortunately blurred (even good sources are unfortunately very cautious nowadays), a fairly accurate reconstruction of what NVIDIA actually wanted to tell the companies in question can be derived from the size ratio and the dimensions of the components of a known reference board of the NVIDIA GeForce RTX 3090. I have traced the whole thing again myself (in order not to break any NDAs either) and positioned it reasonably appropriately. However, I would like to point out once again that changes on the part of NVIDIA are possible at any time and nothing has to be set in stone.

After all, up to 600 watts TBP (i.e. for the entire board) have to be managed and later almost completely disposed of as waste heat. The distribution of the losses for the individual components can be estimated quite easily, I was only a few watts off the mark with Ampere. But that will be another article, because I still have to research some components.

However, what we see at first glance are a whopping 24 voltage converters for the GPU! Since NVIDIA (this has also been leaked in the meantime) will again rely on a uP9512 that can only generate 8 phases (but is readily available), a total of three voltage converters will most likely be driven together per phase. The four dark rectangles near the drill holes for the cooler should be the VRM for the memory voltage converters. This brings us to four phases for the GDDR6X.

What we also see in this context is a maximum of 12 solder slots for the GDDR6X (from Micron), which is currently available as 1 and 2 GB modules. From this, we can conclude that 12 or 24 GB (more likely) are possible when fully loaded. Smaller versions could then be equipped with 8 or 16 GB (probably) again, which should also reduce the number of voltage converters to three.

Now let’s get back to the RTX 3090 Ti and what I called a test run. As I could find out, the GA102 (Ampere) and the AD102 (Ada) chip are supposed to be pin compatible. Conversely, this also means that all board partners should already be able to work on the new boards and coolers without the upcoming chip by simply using an open 600 Watt BIOS. Then both the new board and the cooling can be fully tested.

Speaking of cooling, some sources report that NVIDIA will rely on a tripple-slot air cooler for the Reference or FE, while almost all board partners are likely to go with a 3.5-slot design. This means that the weight class above 2 kilograms will certainly also have a lot of new competitors. AiO compact coolers and cards with a real water block from the factory are also being considered aloud, but not as a primary solution. And to reassure all potential customers with older power supplies: a 12+4 (12VHPWR) to 4x 6+2 pin (PCIe old) is of course always included.

112 Antworten

Kommentar

Lade neue Kommentare

Veteran

Veteran

Urgestein

1

Urgestein

Urgestein

Urgestein

Urgestein

1

Urgestein

Urgestein

1

Veteran

Urgestein

Urgestein

Veteran

Urgestein

Neuling

Urgestein

Alle Kommentare lesen unter igor´sLAB Community →