A range of Vega 20 models have been unveiled by AMD, including workstation, data center and even gaming cards. Probably the best known SKU is the Radeon VII, a high-end model with 3840 cores, 16 GB HBM2 memory and over 1 TB/s bandwidth. The company has also developed several other Radeon cards based on the Vega 20, such as the Radeon Pro VII, a workstation variant of the non-Pro version, the Radeon Instinct MI50 and MI60 (each with 3840/4096 cores), and the Radeon Pro Vega II. The first is perhaps the most interesting with Vega 20 chip, released exclusively for Apple’s Mac systems. AMD has even produced two cards, either with one or two Vega 20 GPUs on a single board. This was by far the most powerful Radeon GPU AMD released at the time.

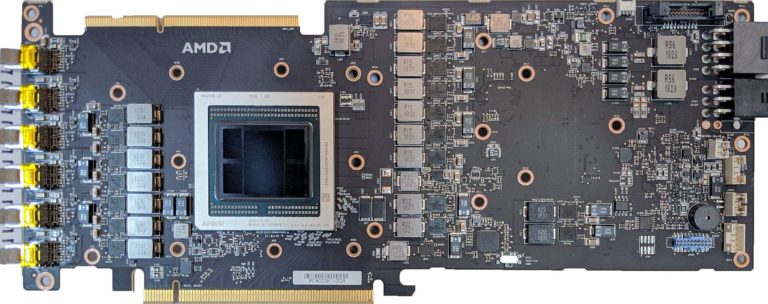

The prototype discovered on Reddit is displayed as Radeon Pro VII in the software. However, the Device PCI ID matches the Radeon Instinct MI60, so this prototype is definitely something in between. Reddit published a PCB image of the card with a Vega 20 GPU with four stacks of HBM2 memory. The card is powered via two power connectors (8+6-pin) and most likely consumes about 300 W. You can also see that the connectors are used exclusively for development purposes, which confirms that it is not a final product.

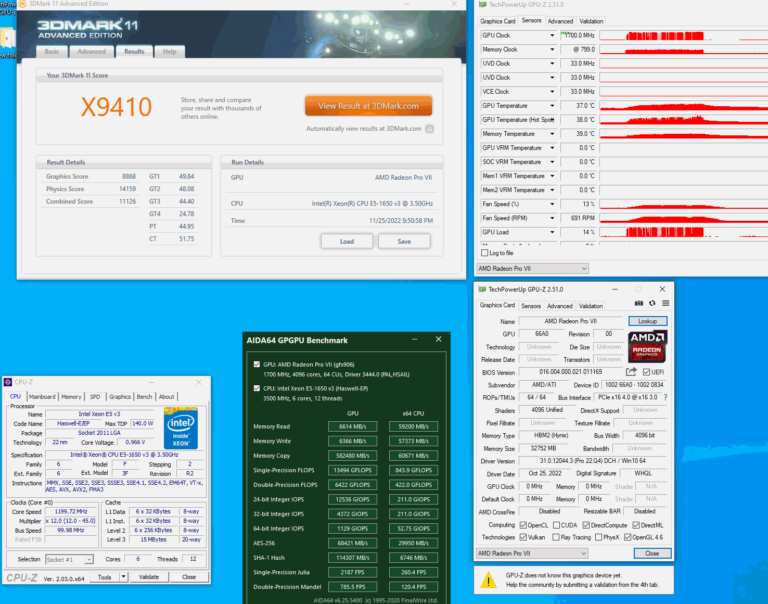

The GPU does not reach its full speed in real tests. The single precision computation is 13.5 TFLOPs and the memory read is 6614 MB/s. However, this screenshot proves that the maximum GPU clock is 1.7 GHz, which is the same clock as the Radeon Pro VII.

According to the information available on the Internet, this prototype might have been a Radeon Pro V420. Nevertheless, the Vega 20 product family had a very interesting history and an extensive list of models, which is something we cannot yet say about the Navi 3X GPUs.

Source: reddit

8 Antworten

Kommentar

Lade neue Kommentare

Urgestein

Veteran

Urgestein

Urgestein

Urgestein

Urgestein

Mitglied

Veteran

Alle Kommentare lesen unter igor´sLAB Community →