Neue Informationen von Kopite7kimi deuten darauf hin, dass NVIDIA seine Blackwell-GPUs vorbereitet, die später in der Gaming-Reihe der GeForce RTX 50 eingesetzt werden sollen. So soll die kommende Generation der GeForce RTX 50 “Blackwell”-GPUs von NVIDIA voraussichtlich den neuesten 3-nm-Fertigungsprozess von TSMC nutzen und den DisplayPort-2.1-Standard übernehmen.

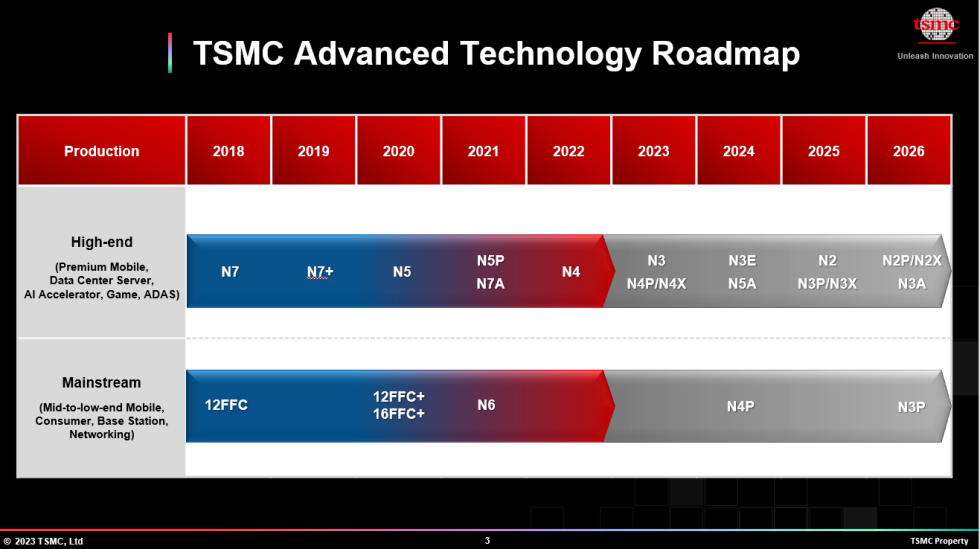

Die neueste 3-nm-Prozesstechnologie von TSMC bietet im Vergleich zu der 5-nm-Variante eine weitere Reduzierung des Energieverbrauchs um 25-30%, eine Steigerung der Leistung pro Transistor um 10-15%, eine 42%ige Verringerung der Fläche sowie eine Dichtezunahme um das 1,7-fache. Diese signifikanten Verbesserungen gegenüber dem aktuellen 5-nm-Knoten könnten dazu führen, den Effizienzvorsprung von NVIDIA gegenüber seinen Konkurrenten weiter zu vergrößern, da die bestehende GeForce RTX 40 “Ada Lovelace”-Reihe bereits eine beeindruckende Leistung pro Watt bietet.

TSMC3

— kopite7kimi (@kopite7kimi) November 15, 2023

Es ist jedoch noch zu früh, um zu sagen, welche spezifische 3-nm-Variante von den Blackwell Gaming-GPUs verwendet wird, da die Technologie in mindestens vier verschiedenen Ausführungen verfügbar sein wird – von der standardmäßigen N3 bis hin zu den effizienteren und leistungsorientierten Designs wie N3E, N3P und N3A.

NVIDIA plant, die “Blackwell”-GPUs, die speziell für HPC/AI ausgelegt sind, zusammen mit den neuesten HBM3e-Speicherlösungen im 3-nm-Fertigungsprozessknoten von TSMC zu nutzen. Gleichzeitig sollen die Gaming-Karten von NVIDIA mit der GDDR7-Speicherlösung ausgestattet werden, wie es kürzlich spekuliert wurde. Dies würde bedeuten, dass sowohl die HPC- als auch die Gaming-Seiten der Produktfamilien eine Architektur unter der gleichen Namenskonvention aufweisen – ein Novum nach einigen Jahren. Außerdem ist zu erwähnen, dass die HPC-Seite voraussichtlich von einem Chiplet-basierten Design profitieren wird, während die Gaming-Seite vermutlich mit monolithischen Dies fortgeführt wird.

Die nächste Generation der GeForce Grafikkarten wird voraussichtlich mit der DisplayPort 2.1-Technologie ausgestattet sein, was sie auf die gleiche Ebene wie die Radeon RX 7000-GPUs von AMD bringt. Die Enttäuschung über die Nicht-Verfügbarkeit von DP 2.1 auf den GeForce RTX 40-GPUs wird somit hoffentlich bald der Vergangenheit angehören. NVIDIA wird damit in seiner kommenden Grafikarchitektur die neuesten Technologien unterstützen. Neben der Prozessknotentechnologie wird also auch die DisplayPort 2.1-Technologie zum Einsatz kommen.

√

— kopite7kimi (@kopite7kimi) November 15, 2023

Quelle: Kopite7kimi

37 Antworten

Kommentar

Lade neue Kommentare

Urgestein

1

Veteran

Veteran

Urgestein

Urgestein

Veteran

Urgestein

Veteran

Mitglied

Urgestein

Veteran

Urgestein

Veteran

Urgestein

Veteran

Urgestein

Urgestein

Mitglied

Alle Kommentare lesen unter igor´sLAB Community →