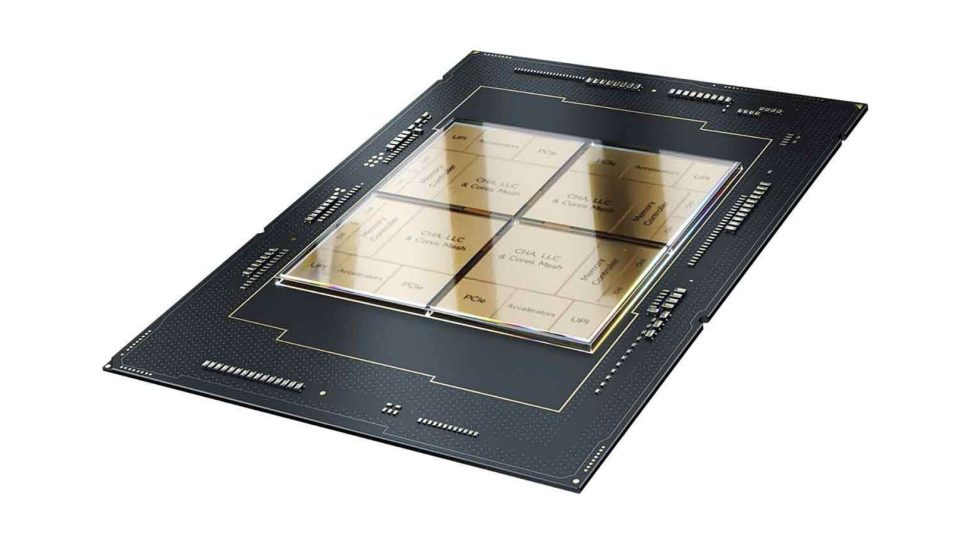

Heute hat MLCommons die Ergebnisse des renommierten KI-Leistungsbenchmarks MLPerf Training 3.0 veröffentlicht. In diesem Benchmark wurden sowohl der Deep-Learning-Beschleuniger Habana Gaudi2 als auch der Intel Xeon Scalable-Prozessor der vierten Generation eingesetzt. Die jüngsten MLPerf-Ergebnisse, die von MLCommons veröffentlicht wurden, bestätigen den Kostenvorteil, den Intel Xeon-Prozessoren und Intel Gaudi Deep-Learning-Beschleunigern für KI-Kunden bieten.

Der Xeon-Prozessor mit seinen integrierten Beschleunigern ist eine ideale Lösung für die Ausführung umfangreicher KI-Workloads auf Allzweck-Prozessoren. Gaudi hingegen bietet eine wettbewerbsfähige Leistung für große Sprachmodelle und generative KI. Intels skalierbare Systeme mit optimierter, benutzerfreundlicher und offener Software verringern die Hürden für Kunden und Partner, um eine Vielzahl von KI-basierten Lösungen im Rechenzentrum umzusetzen – von der Cloud bis zur intelligenten Edge. Diese Lösungen reichen von der Cloud bis zur intelligenten Edge und werden von Sandra Rivera, der Executive Vice President und General Manager der Data Center and AI Group bei Intel, betont.

Eine aktuelle Auffassung in der Branche besagt, dass generative KI und große Sprachmodelle (LLMs) nur auf Nvidia-Grafikprozessoren betrieben werden können. Jedoch zeigen neue Daten, dass das KI-Portfolio von Intel überzeugende und konkurrenzfähige Optionen für Kunden bietet, die sich aus geschlossenen Ökosystemen lösen möchten, welche die Effizienz und Skalierbarkeit einschränken. Die jüngsten Ergebnisse des MLPerf Training 3.0 unterstreichen die Leistungsfähigkeit der Intel-Produkte bei einer Vielzahl von Deep-Learning-Modellen. Die ausgereifte Trainingssoftware und -systeme auf Basis von Gaudi2 wurden erfolgreich im groß angelegten Training des großen Sprachmodells GPT-3 demonstriert. Gaudi2 ist eine von nur zwei Halbleiterlösungen, die Leistungsergebnisse für den GPT-3 LLM Trainings-Benchmark liefern konnten.

Darüber hinaus bietet Gaudi2 den Kunden erhebliche Kostenvorteile sowohl bei Servern als auch bei Systemen. Die durch MLPerf validierte Leistung des Beschleunigers bei GPT-3, Computer Vision und natürlichsprachlichen Modellen sowie die zukünftigen Softwarefortschritte machen Gaudi2 zu einer äußerst überzeugenden Preis-Leistungs-Alternative zur Nvidia H100. Auf der CPU-Seite haben die Xeon-Prozessoren der 4. Generation mit Intel AI Engines ihre Fähigkeit im Deep-Learning-Training gezeigt. Kunden können auf Xeon-basierten Servern ein einziges universelles KI-System aufbauen, das Datenvorverarbeitung, Modelltraining und Bereitstellung miteinander verbindet und die richtige Kombination aus KI-Leistung, Effizienz, Genauigkeit und Skalierbarkeit bietet. Die Ergebnisse von Habana Gaudi2 bestätigen, dass das Training generativer KI und großer Sprachmodelle Server-Cluster erfordert, um die massiven Rechenanforderungen in großem Maßstab zu bewältigen. Die Ergebnisse von MLPerf bestätigen die herausragende Leistung und effiziente Skalierbarkeit von Habana Gaudi2 beim anspruchsvollsten getesteten Modell, GPT-3 mit 175 Milliarden Parametern.

Highlights der Ergebnisse:

- Gaudi2 lieferte auf dem GPT-31 eine beeindruckende “Time-to-Train”: 311 Minuten bei 384 Beschleunigern.

- Nahezu lineare 95%ige Skalierung von 256 auf 384 Beschleuniger beim GPT-3-Modell.

- Ausgezeichnete Trainingsergebnisse bei Computer Vision – ResNet-50 8 Beschleuniger und Unet3D 8 Beschleuniger – und bei Modellen zur Verarbeitung natürlicher Sprache – BERT 8 und 64 Beschleuniger.

- Leistungssteigerungen von 10 % bzw. 4 % für BERT- und ResNet-Modelle im Vergleich zur Einreichung im November, ein Beweis für die zunehmende Reife der Gaudi2-Software.

- Die Gaudi2-Ergebnisse wurden “out of the box” eingereicht, was bedeutet, dass Kunden vergleichbare Leistungsergebnisse erzielen können, wenn sie Gaudi2 vor Ort oder in der Cloud implementieren.

Der Entwicklung der Gaudi2-Software für die Gaudi-Plattform nimmt stetig zu und passt sich der wachsenden Anzahl von generativen KI- und LLM-Anwendungen an. Der GPT-3 Beitrag von Gaudi2 wurde auf PyTorch basierend entwickelt und nutzte die beliebte DeepSpeed Optimierungsbibliothek (Teil von Microsoft AI at scale) anstelle von proprietärer Software. DeepSpeed ermöglicht eine effiziente Skalierung von LLMs durch die gleichzeitige Unterstützung von 3D-Parallelität (Daten, Tensor, Pipeline). Die Gaudi2-Ergebnisse für den 3.0 Benchmark wurden im Datentyp BF16 präsentiert. Es wird erwartet, dass Gaudi2 im dritten Quartal 2023 einen signifikanten Leistungsschub erfährt, wenn die Softwareunterstützung für FP8 und neue Funktionen veröffentlicht werden. Ergebnisse mit Xeon-Prozessoren der 4. Generation: Die MLPerf-Ergebnisse zeigen, dass Intel Xeon-Prozessoren im Vergleich zu anderen Alternativen als einzige CPU eine sofort einsatzbereite KI-Funktionalität für Unternehmen bieten. Dadurch können sie KI-Anwendungen auf Allzwecksystemen implementieren und die Kosten und Komplexität dedizierter KI-Systeme vermeiden. Einige Kunden, die gelegentlich große Modelle von Grund auf trainieren, können Allzweck-CPUs verwenden, insbesondere auf den Intel-basierten Servern, die sie bereits für ihre Geschäftsabläufe nutzen. Die meisten Kunden hingegen verwenden vortrainierte Modelle und verfeinern diese mit ihren eigenen kleineren, sorgfältig ausgewählten Datensätzen. Intel hat bereits gezeigt, dass diese Feinabstimmung mithilfe der KI-Software von Intel und gängiger Open-Source-Software in nur wenigen Minuten durchgeführt werden kann.

Highlights der MLPerf-Ergebnisse:

- In der geschlossenen Abteilung konnten Xeons der 4. Generation die Modelle BERT und ResNet-50 in weniger als 50 Minuten (47.93 Min.) bzw. weniger als 90 Minuten (88.17 Min.) trainieren.

- Für BERT in der offenen Abteilung zeigen die Ergebnisse, dass der Xeon das Modell bei einer Skalierung auf 16 Knoten in ca. 30 Minuten (31.06 Min.) trainieren konnte.

- Für das größere RetinaNet-Modell konnte Xeon eine Zeit von 232 Minuten auf 16 Knoten erreichen, was den Kunden die Flexibilität gibt, Xeon-Zyklen außerhalb der Spitzenzeiten zu nutzen, um ihre Modelle im Laufe des Morgens, über Mittag oder über Nacht zu trainieren.

- Der Xeon-Prozessor der vierten Generation mit Intel Advanced Matrix Extensions (Intel AMX) bietet erhebliche Leistungsverbesserungen, die mehrere Frameworks, End-to-End Data Science-Tools und ein breites Ökosystem intelligenter Lösungen umfassen.

MLPerf ist weithin anerkannt als der führende Maßstab für die Leistung von Künstlicher Intelligenz. Es ermöglicht einen fairen und wiederholbaren Vergleich der Leistung verschiedener Lösungen. Intel hat kürzlich einen wichtigen Meilenstein erreicht, indem es über 100 Beiträge eingereicht hat. Intel ist weiterhin der einzige Anbieter, der öffentlich CPU-Ergebnisse mit branchenüblicher Deep-Learning-Ökosystem-Software vorlegt.Diese Ergebnisse zeigen deutlich die ausgezeichnete Skalierbarkeit, die mit den kostengünstigen und leicht verfügbaren Netzwerkadaptern der Intel Ethernet 800 Serie möglich ist. Diese Adapter nutzen die Open-Source Intel Ethernet Fabric Suite Software, die auf Intel oneAPI basiert.

Quelle: TechPowerUP

Bisher keine Kommentare

Kommentar

Lade neue Kommentare

Artikel-Butler

Alle Kommentare lesen unter igor´sLAB Community →