Nvidias nächste Generation von Grafikkarten könnte eine Chiplet-GPU und eine neue Architektur nutzen. Seit Monaten halten sich Gerüchte über Nvidias Geforce RTX 5000 in den Schlagzeilen. Die neuesten Gerüchte sprechen dem Nachfolger von Ada Lovelace ein Multi-Chiplet-Modul (“MCM”) zu, wie es auch bereits auf einigen Grafikkarten aus der aktuellen Serie Radeon RX 7000 (“RDNA 3”) zum Einsatz kommt. Auch die Grafikeinheiten sollen demzufolge weitreichende Änderungen erfahren. Der für solche Vorabveröffentlichungen bekannte Twitter-Nutzer @kopite7kimi möchte nun erfahren haben, welche Grafikprozessoren auf den Geforce-Grafikkarten aus der nächsten Generation zum Einsatz kommen und wie diese aufgebaut sein sollen. Neuigkeiten zu Nvidias Geforce RTX 5000 sind immer mit Spannung erwartet. Die Gerüchte deuten darauf hin, dass die neue Generation eine echte Leistungssteigerung bringen könnte.

Nvidia könnte für seine nächste Generation von Grafikkarten auf eine Chiplet-Architektur setzen. Laut @kopite7kimi und anderen Quellen soll Nvidia die Grafikeinheiten der kommenden Geforce RTX 5000 (“Blackwell”) grundlegend umbauen und auf ein Multi-Chiplet-Modul (“MCM”) umsteigen. Dieses Konzept ist bereits bei AMDs GPUs Navi 31 und Navi 32 im Einsatz. Ein solches Design würde es Nvidia ermöglichen, die Leistung und Effizienz der Grafikkarten zu verbessern. Durch die Verwendung mehrerer kleinerer Chips kann Nvidia die Größe und den Stromverbrauch der Grafikkarten reduzieren. Ob Nvidia die Gerüchte bestätigt, bleibt abzuwarten. Die Geforce RTX 5000 soll voraussichtlich im Jahr 2024 auf den Markt kommen.

After the dramas of GA100 and GH100, it seems that GB100 is finally going to use MCM.

— kopite7kimi (@kopite7kimi) September 18, 2023

Die Anzahl der Graphics Processing Clusters (“GPCs”) und Texture Processing Clusters (“TPCs”) soll dabei unverändert bleiben, der interne Aufbau der Cluster soll jedoch grundlegend überarbeitet werden. Dieser Vorgang wurde bereits bei AMDs Generationswechsel von RDNA 2 auf RDNA 3 beobachtet. AMD hat den internen Aufbau der TPCs bei RDNA 3 deutlich verbessert, was zu einer Leistungssteigerung geführt hat.Nvidias Geforce RTX 5000 soll voraussichtlich im Jahr 2024 auf den Markt kommen. Ob Nvidia tatsächlich den neuen Aufbau der Grafikeinheiten plant, bleibt abzuwarten.

Die Codesnamen der Chips sind GB202, GB203, GB205, GB206 und GB207. Der Leaker “Panzerlied” aus dem Forum Chiphell hat Informationen veröffentlicht, die diese Gerüchte untermauern. Die Chips sollen in verschiedenen Leistungsklassen angeboten werden, von der High-End-GPU GB202 bis zur Einstiegs-GPU GB207.

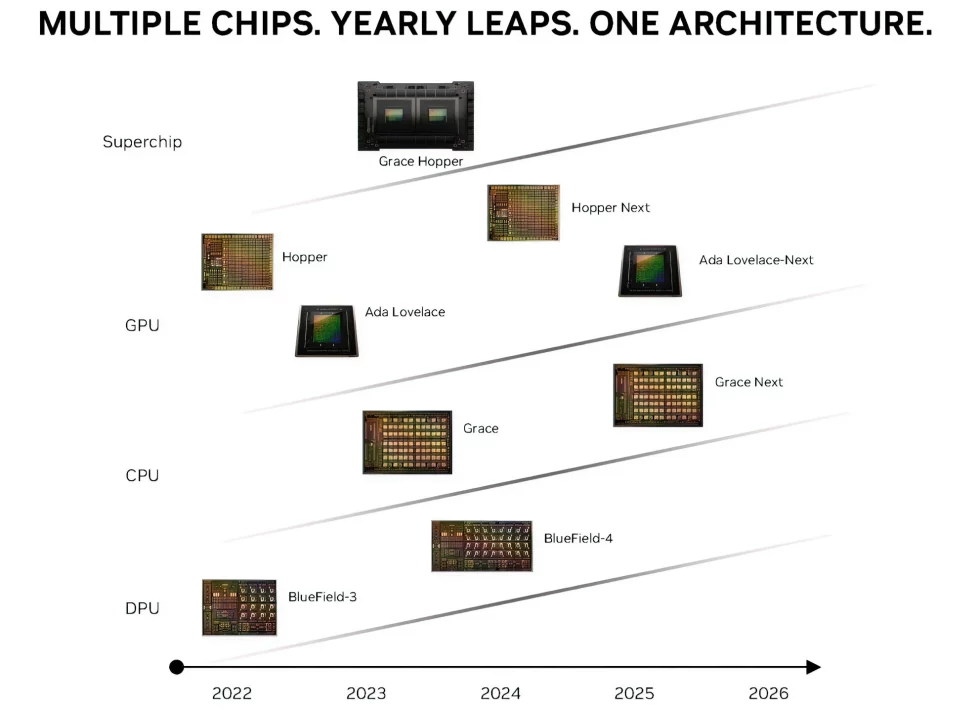

Nach einer durchgesickerten GPU-Roadmap von Nvidia wird die Geforce RTX 5000-Serie erst im übernächsten Jahr erscheinen. Die Serie, die auch als “Ada Lovelace Next” bekannt ist, soll auf einer neuen Architektur basieren und neue Grafikprozessoren mitbringen. Nvidia hat sich bisher nicht zu den Gerüchten geäußert. Allerdings ist es durchaus möglich, dass das Unternehmen seinen Vorsprung auf die Konkurrenz ausbauen möchte, bevor es eine neue Generation von Grafikkarten auf den Markt bringt.

Nvidias Geforce RTX 5000: Geforce RTX 5090 und 5080 mit GDDR7 und PCIe 5.0

Nach Angaben von Leakern plant Nvidia, die Geforce RTX 5000-Serie mit zwei neuen Grafikprozessoren zu starten: der Geforce RTX 5090 und der Geforce RTX 5080. Beide Grafikkarten sollen auf der neuen Architektur “David Blackwell” basieren und mit dem neuen GDDR7-Grafikspeicher ausgestattet sein. Die Geforce RTX 5090 wird voraussichtlich die leistungsstärkste Grafikkarte der Serie sein. Sie soll auf dem Grafikprozessor GB202 basieren, der über 18.432 CUDA-Kerne verfügen soll. Die Geforce RTX 5080 wird auf dem Grafikprozessor GB203 basieren, der über 10.752 CUDA-Kerne verfügen soll. Beide Grafikkarten sollen über eine PCIe-5.0-Anbindung verfügen. Dies ermöglicht eine höhere Bandbreite und damit eine bessere Leistung. Der Einsatz von GDDR7-Grafikspeicher ist ein weiterer wichtiger Schritt. GDDR7 soll eine um bis zu 25 Prozent verbesserte Energieeffizienz bieten.

Nvidia plant, für die Geforce RTX 5090 und Geforce RTX 5080 den neuen GDDR7-Grafikspeicher zu verwenden. Dieser soll eine Bandbreite von bis zu 36 Gigabit pro Sekunde erreichen.GDDR7 ist eine neue Generation von Grafikspeicher, die eine Reihe von Verbesserungen gegenüber GDDR6X bietet. Dazu gehören eine höhere Bandbreite, eine verbesserte Energieeffizienz und eine geringere Latenz. Der Einsatz von GDDR7 in den High-End-Modellen der Geforce RTX 5000-Serie ist ein weiterer wichtiger Schritt zur Verbesserung der Leistung. Die höhere Bandbreite ermöglicht eine schnellere Datenübertragung zwischen dem Grafikprozessor und dem Speicher, was zu einer besseren Grafikleistung führt.

Auch die effektive Speicherbandbreite würde von dem schnellen GDDR7-Speicher mit bis zu 36 GiBit/s deutlich profitieren:

- 128-Bit @ 36 Gbps: 576 GiByte/s

- 192-Bit @ 36 Gbps: 846 GiByte/s

- 256-Bit @ 36 Gbps: 1.152 GiByte/s

- 320-Bit @ 36 Gbps: 1.440 GiByte/s

- 384-Bit @ 36 Gbps: 1.728 GiByte/s

- 512-Bit @ 36 Gbps: 2.304 GiByte/s

Wie aus mehreren Einträgen im Chiphell-Forum hervorgeht, könnte Nvidia aber auch zweigleisig fahren:

- GB202: GDDR6X (“PAM-4”) mit 512-Bit

- GB203: GDDR6X (“PAM-4”) mit 384-Bit

- GB205: GDDR7 (“PAM-3”) mit 256-Bit

- GB206: GDDR7 (“PAM-3”) mit 192-Bit

- GB207: GDDR7 (“PAM-3”) mit 128-Bit

Aber auch hierbei handelt es sich in der Regel noch um reine Spekulationen, welche zwar auf bisher durchgesickerten Informationen basieren, aber noch absolut nicht als verbindlich anzusehen sind. Nvidia selbst hat sich bislang mit keinem Wort zur nächsten Generation seiner Geforce-Grafikkarten geäußert.

Nvidia Geforce RTX 5090: Leistungsprognosen sind schwierig

Laut Gerüchten soll die Geforce RTX 5090 bis zu 2,5-mal schneller als die Geforce RTX 4090 sein. Dies ist eine beeindruckende Leistungssteigerung, aber es ist wichtig, sich daran zu erinnern, dass diese Gerüchte noch nicht bestätigt sind. Es ist unklar, ob die Leistungssteigerung aufgrund von Hardware-Verbesserungen oder durch die Verwendung von DLSS 3 mit Frame Generation erreicht wird. DLSS 3 ist eine neue Version von Nvidias Deep-Learning-Upscaling-Technologie, die eine erhebliche Leistungssteigerung bei gleichzeitiger Verbesserung der Bildqualität bieten soll. Die Spezifikationen der Geforce RTX 5090 sind ebenfalls noch rein spekulativ. Es wird erwartet, dass die Grafikkarte über 18.432 CUDA-Kerne, einen L2-Cache von 96 MiByte und einen GPU-Takt von mehr als 3 GHz verfügen wird.

Quelle: @kopite7kimi, Chiphell

19 Antworten

Kommentar

Lade neue Kommentare

Veteran

Urgestein

Urgestein

Urgestein

Veteran

Urgestein

Urgestein

Veteran

Veteran

Veteran

Veteran

Veteran

Urgestein

Veteran

Veteran

Urgestein

Urgestein

Veteran

Neuling

Alle Kommentare lesen unter igor´sLAB Community →