Nvidia’s next generation of graphics cards could use a chiplet GPU and a new architecture. Rumors about Nvidia’s Geforce RTX 5000 have been in the headlines for months. The latest rumors attribute a multi-chiplet module (“MCM”) to the successor of Ada Lovelace, as it is already used on some graphics cards from the current Radeon RX 7000 series (“RDNA 3”). Accordingly, the graphics units are also supposed to undergo far-reaching changes. The Twitter user @kopite7kimi, who is known for such pre-releases, now wants to know which GPUs will be used on the Geforce graphics cards from the next generation and how they will be built. News about Nvidia’s Geforce RTX 5000 is always eagerly awaited. The rumors suggest that the new generation could bring a real performance increase.

Nvidia could be looking at a chiplet architecture for its next generation of graphics cards. According to @kopite7kimi and other sources, Nvidia is said to be fundamentally rebuilding the graphics units of the upcoming Geforce RTX 5000 (“Blackwell”) and switching to a multi-chiplet module (“MCM”). This concept is already in use in AMD’s Navi 31 and Navi 32 GPUs. Such a design would allow Nvidia to improve graphics card performance and efficiency. By using multiple smaller chips, Nvidia can reduce the size and power consumption of the graphics cards. Whether Nvidia will confirm the rumors remains to be seen. The Geforce RTX 5000 is expected to be launched in 2024.

After the dramas of GA100 and GH100, it seems that GB100 is finally going to use MCM.

— kopite7kimi (@kopite7kimi) September 18, 2023

The number of Graphics Processing Clusters (“GPCs”) and Texture Processing Clusters (“TPCs”) is to remain unchanged, but the internal structure of the clusters is to be fundamentally revised. This process was already observed with AMD’s generation change from RDNA 2 to RDNA 3. AMD significantly improved the internal structure of the TPCs in RDNA 3, which led to an increase in performance.Nvidia’s Geforce RTX 5000 is expected to be launched in 2024. It remains to be seen whether Nvidia actually plans the new construction of the graphics units.

The code names of the chips are GB202, GB203, GB205, GB206 and GB207. The leaker “Panzerlied” from the Chiphell forum has published information that supports these rumors. The chips are supposed to be offered in different performance classes, from the high-end GPU GB202 to the entry-level GPU GB207.

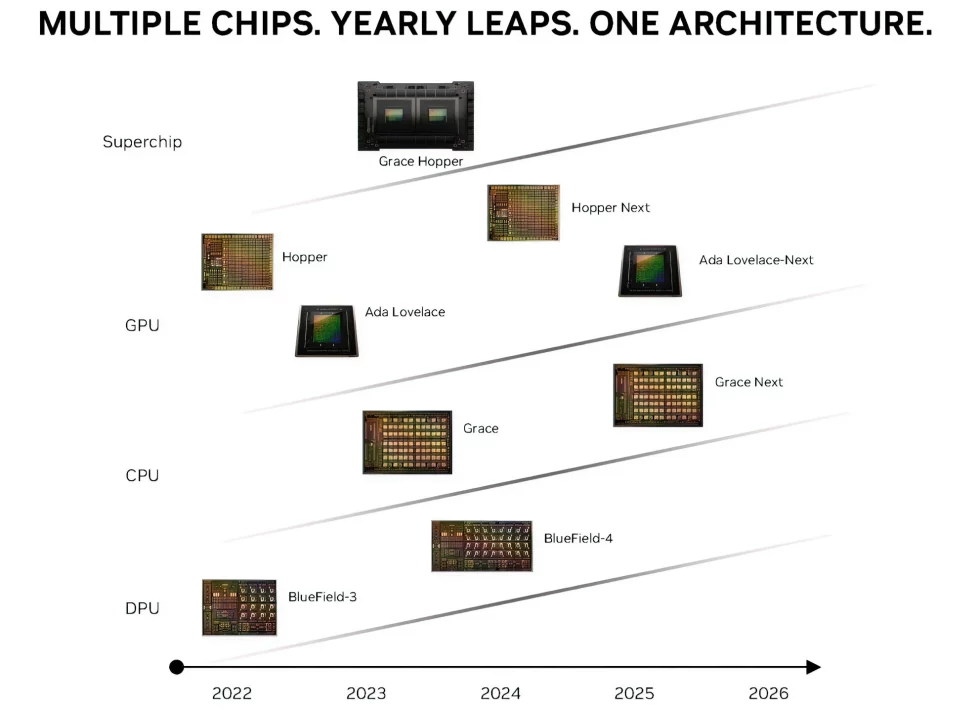

According to a leaked GPU roadmap from Nvidia, the Geforce RTX 5000 series will not be released until the year after next. The series, also known as “Ada Lovelace Next,” is said to be based on a new architecture and bring new GPUs. Nvidia has not commented on the rumors yet. However, it is quite possible that the company wants to expand its lead over the competition before launching a new generation of graphics cards.

Nvidia’s Geforce RTX 5000: Geforce RTX 5090 and 5080 with GDDR7 and PCIe 5.0

According to leakers, Nvidia plans to launch the Geforce RTX 5000 series with two new GPUs: the Geforce RTX 5090 and the Geforce RTX 5080. Both graphics cards are said to be based on the new “David Blackwell” architecture and feature the new GDDR7 graphics memory. The Geforce RTX 5090 is expected to be the most powerful graphics card in the series. It is said to be based on the GB202 GPU, which is said to have 18,432 CUDA cores. The Geforce RTX 5080 will be based on the GB203 GPU, which is said to have 10,752 CUDA cores. Both graphics cards are supposed to have a PCIe 5.0 connection. This enables a higher bandwidth and thus better performance. The use of GDDR7 graphics memory is another important step. GDDR7 is supposed to offer up to 25 percent improved energy efficiency.

Nvidia plans to use the new GDDR7 graphics memory for the Geforce RTX 5090 and Geforce RTX 5080. This is expected to achieve a bandwidth of up to 36 gigabits per second.GDDR7 is a new generation of graphics memory that offers a number of improvements over GDDR6X. These include higher bandwidth, improved power efficiency and lower latency. The use of GDDR7 in the high-end Geforce RTX 5000 series models is another important step in improving performance. The higher bandwidth enables faster data transfer between the GPU and memory, resulting in better graphics performance.

The effective memory bandwidth would also benefit significantly from the fast GDDR7 memory with up to 36 GiBit/s:

- 128-bit @ 36 Gbps: 576 GiByte/s

- 192-bit @ 36 Gbps: 846 GiByte/s

- 256-bit @ 36 Gbps: 1,152 GiByte/s

- 320-bit @ 36 Gbps: 1,440 GiByte/s

- 384-bit @ 36 Gbps: 1,728 GiByte/s

- 512-bit @ 36 Gbps: 2,304 GiByte/s

However, as can be seen from several entries in the Chiphell forum, Nvidia could also go double-track:

- GB202: GDDR6X (“PAM-4”) with 512 bit

- GB203: GDDR6X (“PAM-4”) with 384 bits

- GB205: GDDR7 ( PAM-3 ) with 256-bit

- GB206: GDDR7 (“PAM-3”) with 192-bit

- GB207: GDDR7 (“PAM-3”) with 128-bit

However, these are still pure speculations, which are based on leaked information, but can’t be considered binding yet. Nvidia itself hasn’t said anything about the next generation of its Geforce graphics cards so far.

Nvidia Geforce RTX 5090: Performance predictions are difficult

According to rumors, the Geforce RTX 5090 will be up to 2.5 times faster than the Geforce RTX 4090. This is an impressive performance increase, but it is important to remember that these rumors are not yet confirmed. It is unclear whether the performance increase is due to hardware improvements or the use of DLSS 3 with Frame Generation. DLSS 3 is a new version of Nvidia’s deep learning upscaling technology that is supposed to offer a significant performance boost while improving image quality. The specifications of the Geforce RTX 5090 are also still purely speculative. It is expected that the graphics card will have 18,432 CUDA cores, an L2 cache of 96 MiByte and a GPU clock of more than 3 GHz.

Source: @kopite7kimi, Chiphell

19 Antworten

Kommentar

Lade neue Kommentare

Veteran

Urgestein

Urgestein

Urgestein

Veteran

Urgestein

Urgestein

Veteran

Veteran

Veteran

Veteran

Veteran

Urgestein

Veteran

Veteran

Urgestein

Urgestein

Veteran

Neuling

Alle Kommentare lesen unter igor´sLAB Community →