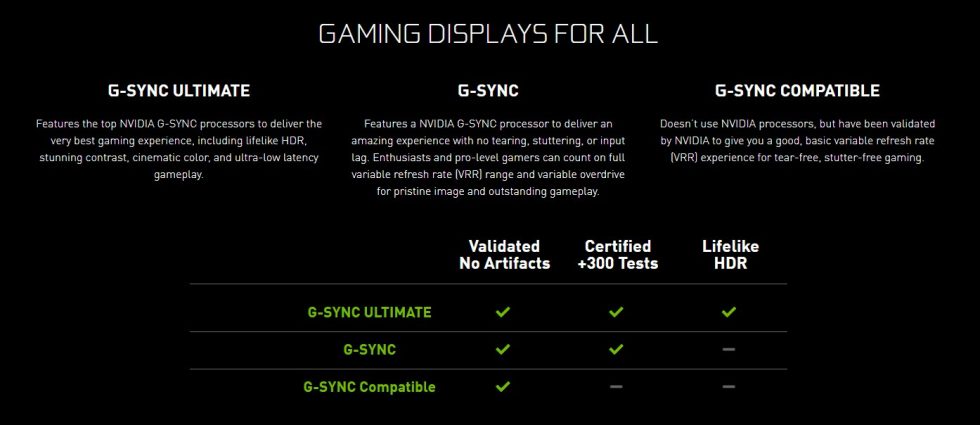

Seit den ersten G-Sync Monitoren von Nvidia hat sich einiges getan. G-Sync mit Nvidia Grafikkarten lässt sich schon seit längerem auch mit günstigeren „Freesync“ Monitoren betreiben. Der Unterschied ist hier, dass die Frame-Synchronisierung zwischen GPU und Monitor lediglich über das DisplayPort-Protokoll erfolgt und keine zusätzliche Hardware auf Seiten des Monitors notwendig ist.

Aber diese spezielle Hardware ist nicht ohne Grund in den offiziellen „G-Sync“ Produkten verbaut, wenn es nach Nvidia geht. Geringere Latenz, bessere Performance in niedrigen FPS Bereichen und HDR Kompatibilität sind Features, die nur mit Nvidias dedizierter Hardware möglich sind und seither als „G-Sync Ultimate“ zertifiziert werden.

Einen solchen „G-Sync Ultimate“ Monitor habe ich mir vor kurzem privat zugelegt. Als Sysadmin und Gamer ist so ein großes Investment zwar noch immer unvernünftig, aber zumindest verargumentierbar – rede ich mir zumindest ein. Bei 1800 Euro für den AOC Agon AG353UCG habe ich dann nach langer Überlegung zugeschlagen, der meinen bisherigen Acer XB270HU – ein G-Sync Monitor erster Stunde – ablösen soll.

Nach erster Inbetriebnahme des AG353UCG ist mir sofort der interne Lüfter aufgefallen, der zwar auf der Produktseite nicht erwähnt wird, den neuen Monitor sofort zu einer Störquelle an meinem sonst stillen Arbeitsplatz macht. Meiner Verwunderung folgte sogleich der Tatendrang, dem ganzen auf den Grund zu gehen und den Monitor zu zerlegen.

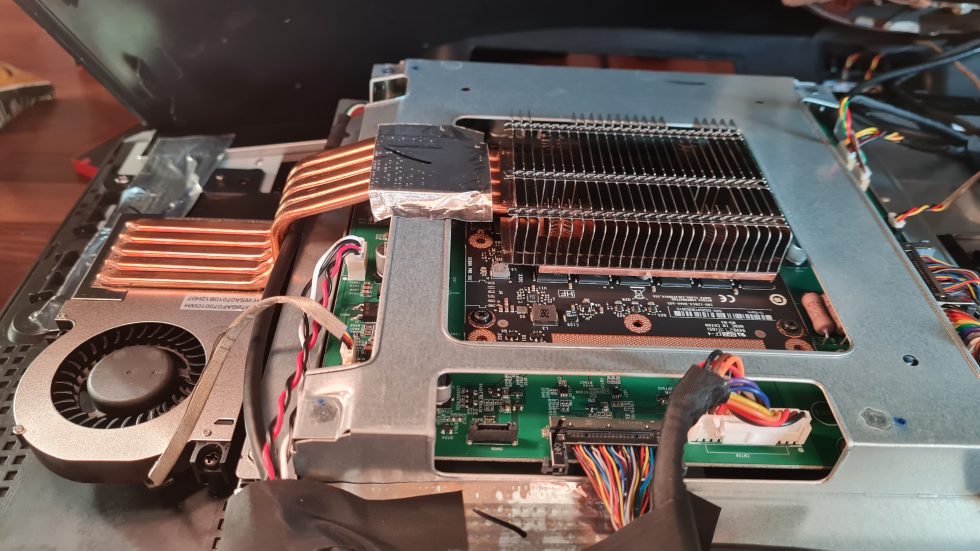

Ein paar Schrauben und dutzende Kunststoff-Clips später eröffnete sich mir dann dieser Anblick. 5 Heatpipes, ein massiver Kühlkörper aus Kupfer und ein Radial-Lüfter, wie man sie von mobilen Workstation-Notebooks kennt sorgen hier in diesem Monitor für tatsächlich für aktive Kühlung, und das nicht zu knapp.

Einfach die Stromversorgung vom Lüfter abzustecken undà la AMD X570 Chipsatz auf die passive Kühlung zu vertrauen, stellte sich ziemlich schnell als schlechte Idee heraus. Nach ca. 30 Minuten Gaming im HDR bei niedrigster Helligkeit erscheint eine „Critical Temperature – Emergency Shutdown“ Meldung auf dem OSD des Displays und es schaltet sich ab. Nur durch ein Trennen und Wieder-Verbinden der Stromversorgung lässt sich der Monitor wieder in Betrieb nehmen. Demzufolge dürfte die Abwärme deutlich höher sein, als zunächst von mir vermutet und ehrlich gesagt gehofft.

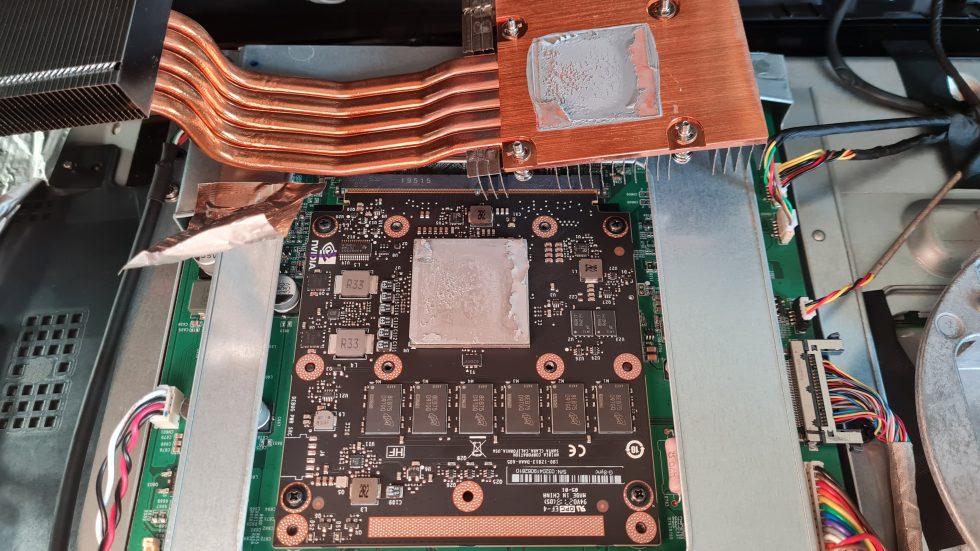

Also habe ich den Monitor wieder zerlegt und einmal untersucht, was sich unter der kühlenden Kupfer-Konstruktion befindet. Das Ergebnis ist zum einen sehr viskose Wärmeleitpaste zwischen der Bodenplatte und dem aktiv gekühlten Chip, und darunter eine schwarze Platine, die mit Layout und Komponenten auf den ersten Blick einer Grafikkarte im MXM Format ähnelt, wie man es ebenfalls von Notebooks kennt.

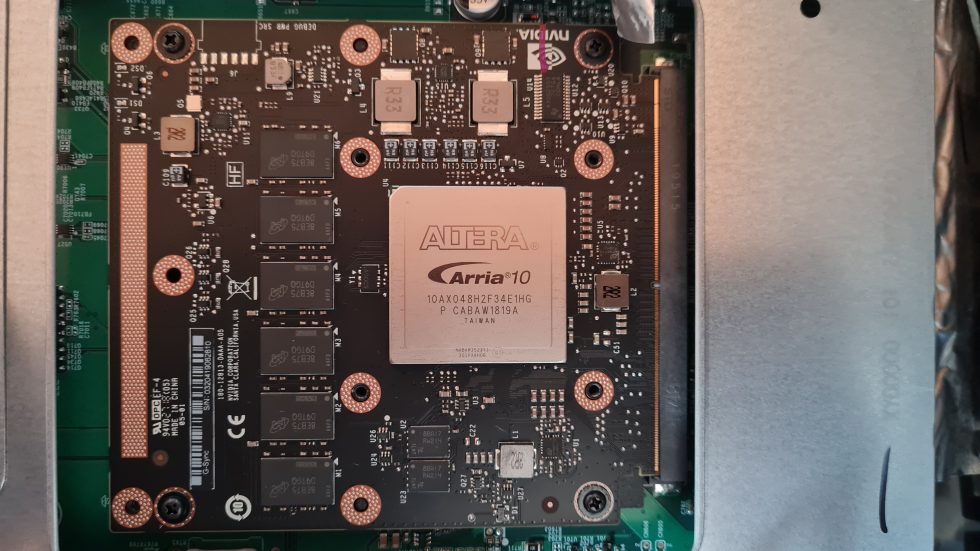

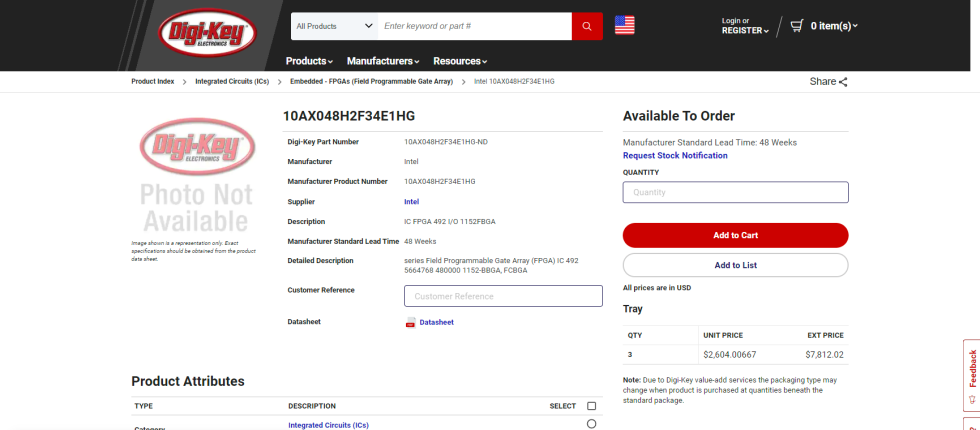

Unter den rohen Mengen Zement-ähnlicher Paste kommt dann ein „Altera Arria 10“ Chip zum Vorschein, mit der Modellnummer 10AX048H2F34E1HG. Nach kurzer Recherche entpuppt sich dieser als Field-programmable Gate Array oder kurz FPGA, also einfach gesagt ein Mikrochip mit programmierbarer Funktion. Diese FPGAs sind aufgrund ihrer Programmierbarkeit relativ teuer verglichen mit herkömmlichen Mikrochips mit fester Funktion. Der Vorteil von FPGAs ist aber eben, das man keine speziellen Chips eigens herstellen muss und sich die Funktionsweise nachträglich via Software programmieren lässt.

Glücklicherweise ist das Datenblatt zu diesem Chip öffentlich und als Hersteller kommt neben Altera auch Intel zum Vorschein. Mit der Dokumentation zur Produktnummer lässt sich dann die genaue Variante des Arria 10 Chips herausfinden, der hier installiert ist.

gsync_ultimate_a10_overview

Es handelt sich also bei diesem A10X um einen 17,4 Gbps Transciever-Typ mit 480K Logik Elementen, 24 Transceivern mit einer Speed Grade von „2“, verbaut in einen FBGA Package mit 1152 pins auf 35 mm x 35 mm. Zudem hat der Chip eine Betriebstemperatur von 0 – 100 °C, FPGA Speed Grade von „1“, die Leistungsstufe „High Performance“ und „RoHS6“ Klassifizierung. Spannung und Leistungsaufnahme hängen von der jeweiligen Programmierung ab und können also ohne weiteres nicht genauer bestimmt werden, aber vom Kühlköpers zu schließen dürfte es schon mal mehr sein als ein normaler Desktop-Chipsatz mit z.B. 15 W.

Wirft man die Chipnummer in Google auf der Suche nach dem Listenpreis, staunt man nicht schlecht. Über 2000 Euro bzw. 2500 USD werden hierfür auf Seiten wie Digi-Key aufgerufen, wobei ein Mengenrabatt bei höheren Stückzahlen natürlich noch abgezogen werden muss. Zudem wird Nvidia als Großabnehmer wohl nicht bei solchen Zwischenhändlern, sondern direkt bei Intel, einkaufen.

Trotzdem, auch wenn man einen hypothetischen Einkaufspreis von „nur“ 1000 USD in den Raum stellen würde, muss Nvidia dann noch den FPGA programmieren, die restlichen Komponenten einkaufen, das Modul fertigen lassen und das fertige G-Sync Modul dann an die Monitor-Hersteller weiter verkaufen. Ein günstigerer „G-Sync Ultimate“ Monitor wie der LG UltraGear 34GP950G-B ist schon ab ca. 1250 Euro zu haben und da sind Panel und das ganze Drumherum ja auch schon mit dabei.

Also stellt sich die Frage, wie wird hier ein Schuh draus bzw. wie kann ein so teurer FPGA in einem Monitor verbaut sein, der im Listenpreis sogar günstiger als der FPGA ist? Tragen die Monitor-Hersteller die Kosten des G-Sync Moduls? Wohl kaum. Schluckt Nvidia einen Großteil der Kosten des FPGA und verkauft die G-Sync Module mit Verlust, um im Gegenzug das G-Sync Ecosystem mit ihren GeForce-Grafikkarten zu pushen? Das klingt schon plausibler.

Und wieso verwendet Nvidia überhaupt einen FPGA und lässt nicht stattdessen spezielle Chips fertigen, die in der Herstellung zwar aufwändiger, aber dafür im Einkauf günstiger wären – sind die G-Sync Ultimate Stückzahlen wirklich so gering? Die Antworten auf alle diese Fragen haben wir noch nicht, aber interessanter Diskussions-Stoff ist es auf jeden Fall.

82 Antworten

Kommentar

Lade neue Kommentare

Mitglied

Urgestein

Veteran

Veteran

Moderator

Urgestein

Veteran

Urgestein

Veteran

Veteran

Urgestein

Veteran

Veteran

Urgestein

Mitglied

Neuling

Alle Kommentare lesen unter igor´sLAB Community →