I built the first board for performance measurements long before Nvidia’s PCAT was released. Nvidia had also purchased a Powenetics system to study about a year before PCAT was released. And they kind of lost track of me there, so I guess things didn’t go as expected for them or they thought maybe they could do it differently or better. Who knows?

I had long intended to build a new Powenetics system that would be even more versatile, easier to set up, and have a much faster polling rate. Production costs were last on my list, as this system is not for the average user, but for very enthusiastic users or reviewers, so I ended up going all-in, technically speaking.

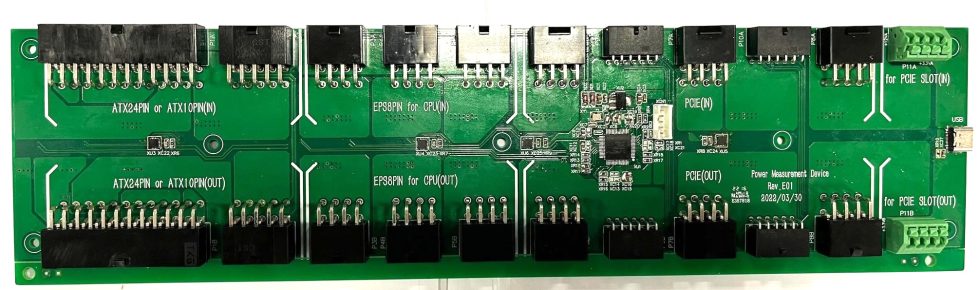

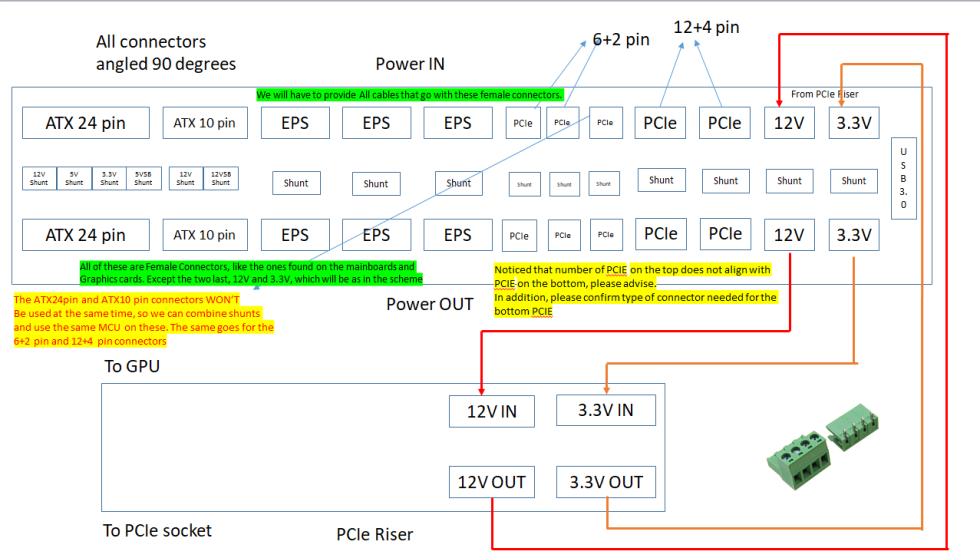

The first designs were delivered and we slowly started the process. The crazy time we were going through limited my IC options, and we ended up only finding two ICs to even build a couple of boards. Against all odds and obstacles, we achieved the desired data retrieval rate of 1000 samples per second from ALL sensors, for both voltage and current. And Powenetics v2 has 12 of these sensors supporting ATX12V and ATX12VO power supplies! There are also two 12+4 pin PCIe connectors on the board for the upcoming GPUs.

Now to the technical part: I wanted to use the high-end IC INA228AIDGSR, but it was not in stock! So the first two boards use the PAC195X, which has a 16-bit ADC, as opposed to the 20-bit ADC mentioned above. The brain of the board is a 32-bit MCU, PIC32MZ, which supports up to 48 inputs!

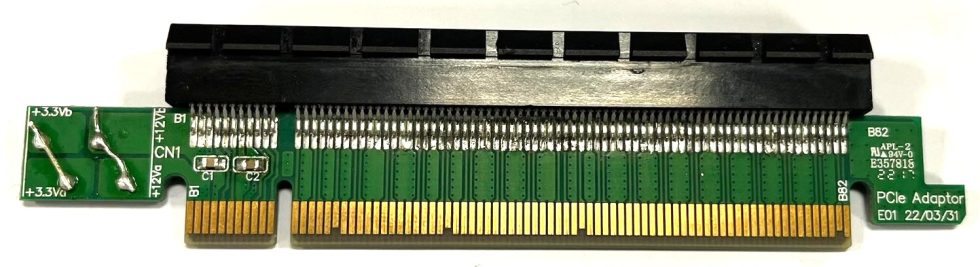

The most important thing is that the PMD is also accompanied by a PCI extender, so it can effortlessly measure the performance that the PCIe slot delivers. With the original Powenetics, we had to buy some unique and very expensive PCIe expansion cards, and I didn’t want that to be the case with the new system.

As I mentioned earlier, I didn’t care about production costs and wanted the best I could build. So you always have to keep in mind that it is a laboratory instrument and not a “toy”. Considering the current situation and as soon as we find enough parts to produce more, the price of the Powenetics v2 will be around, 500 Euro/Dollar, excluding VAT and shipping. For that amount, mane gets the entire system, including all cables, the PCIe extender, and the software, and we’re already in talks with the founder of CapFrameX to have this fantastic app supported.

We don’t know when we will find more parts, and we need to optimize and thoroughly test the system through our evaluation boards. But once we’re ready, we’ll start building them in volume, and we’ll solve the problem of accurately measuring power in systems in an elegant way!

Source: hwbusters (guest post by Aris)

21 Antworten

Kommentar

Lade neue Kommentare

Veteran

1

Veteran

Neuling

Veteran

Neuling

Veteran

1

Veteran

1

Veteran

1

Veteran

1

1

Veteran

1

Urgestein

Veteran

Alle Kommentare lesen unter igor´sLAB Community →