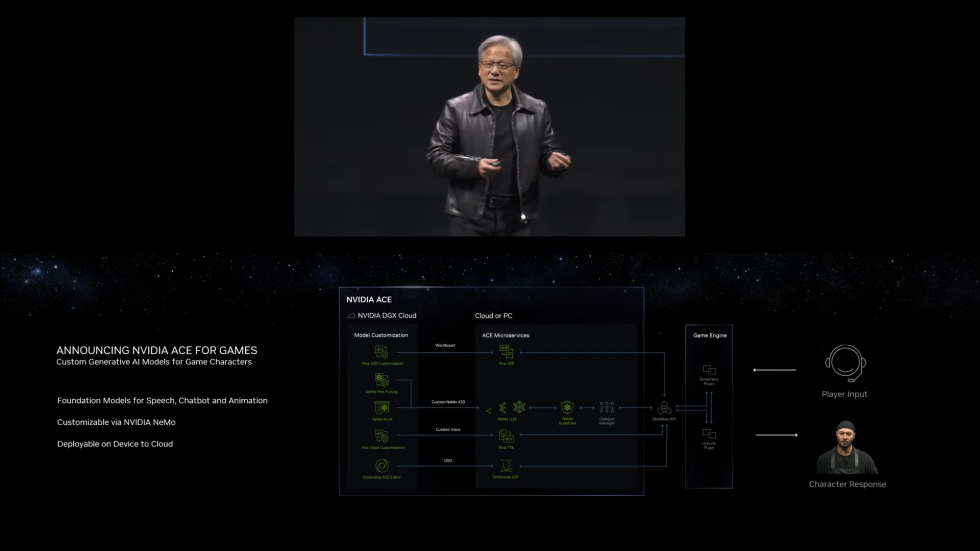

Auf der Computex 2023 präsentierte NVIDIA erstmals seine ACE (Avatar Cloud Engine)-Technologie. Ziel war es, Entwicklern dabei zu helfen, einzigartige KI-Modelle für Sprache, Konversation und Bewegung in Spielecharaktere zu integrieren. Später wurde die Technologie mit den NeMo SteerLM-Tools von NVIDIA weiter verbessert, um eine zusätzliche Anpassungsebene für die Attribute jedes einzelnen Charakters hinzuzufügen. Das Unternehmen zeigte eine interessante Demonstration.

NVIDIA geht nun mit ACE noch einen Schritt weiter und bietet damit noch mehr Realismus und Zugänglichkeit für KI-gesteuerte NPCs, Avatare und digitale Menschen. Das brandneue ACE-Modell ermöglicht Entwicklern die Nutzung verschiedener Cloud-APIs für automatische Spracherkennung (ASR), Text-to-Speech (TTS), Neural Machine Translation (NMT) und Audio2Face (A2F). Alle diese Tools sind bereits im Frühzugriffsprogramm verfügbar und harmonieren perfekt mit beliebten Rendering-Tools wie der Unreal Engine 5. Diese Engine wird als Powerhouse für die Entwicklung von Next-Gen-AAA-Gaming-Erlebnissen angesehen.

NVIDIA arbeitet nicht nur an der Entwicklung eigener Technologien, sondern kooperiert auch mit Start-ups wie Inworld AI, die mithilfe von Generative AI Next-Gen-Spielcharaktere erstellen. Inworld AI ist bereits bekannt durch ihre innovative Technologie, über die bereits berichtet wurde. Zusammen mit Xbox hat Inworld AI ein KI-unterstütztes Spielentwicklungs-Toolkit entwickelt, das dynamische Geschichten, Quests und Dialoge für zukünftige AAA-Titel ermöglicht. Die Technologie wurde bereits von Moddern in bestehende Spiele wie GTA V und Skyrim integriert und ermöglicht dort völlig neue Handlungsstränge und immersive Dialogoptionen.

Auch das bevorstehende MMO Avalon wird die Technologie nutzen, um Spielern die Generierung eigener Inhalte mit kontextuell versierten NPCs zu ermöglichen. NVIDIA enthüllt in seinem Blog weitere Details über Inworlds KI “Character Engine”, die nach der Sicherung bedeutender Finanzierung von Unternehmen wie Lightspeed Studios, Microsoft und Samsung Open Source wird. Die Character Engine besteht aus drei Hauptebenen.

Character Brain Layer: orchestrates a character’s performance by syncing to its multiple personality machine learning models, such as for text-to-speech, automatic speech recognition, emotions, gestures and animations.

The layer also enables AI-based NPCs to learn and adapt, navigate relationships and perform motivated actions. For example, users can create triggers using the “Goals and Action” feature to program NPCs to behave in a certain way in response to a given player input.

Contextual Mesh Layer: allows developers to set parameters for content and safety mechanisms, custom knowledge and narrative controls. Game developers can use the “Relationships” feature to create emergent narratives, such that an ally can turn into an enemy or vice versa based on how players treat an NPC.

Real-Time AI Layer: The Real-Time AI layer ensures optimal performance and scalability for real-time experiences.

Um die Character Engine betreiben zu können, ist leistungsstarke KI-Hardware erforderlich. Zu diesem Zweck verwendet InWorld AI den A100 Ampere-Beschleuniger von NVIDIA, der dem Unternehmen das beste Verhältnis zwischen Kosten und Leistung bietet.

Technologien wie NVIDIA ACE und Inworld AI’s Character Engine stoßen wirklich an ihre Grenzen, was die Möglichkeiten und Errungenschaften der Generativen KI betrifft. NVIDIA hat viele Pläne für die Zukunft der KI, darunter auch den Einsatz vollständig neuronaler Rendering-Ansätze. Dies ist nur ein kleiner Einblick in das, was noch kommen wird. Ein Beispiel für ein großes AAA-Spiel, das von der NVIDIA ACE-Technologie profitieren wird, ist voraussichtlich S.T.A.L.K.E.R 2, das im nächsten Jahr erscheinen wird. Man darf schon sehr gespannt sein, zu sehen, wie KI die nächste Generation von NPCs beeinflussen wird.

Quelle: YouTube

5 Antworten

Kommentar

Lade neue Kommentare

Mitglied

Veteran

Mitglied

Veteran

Urgestein

Alle Kommentare lesen unter igor´sLAB Community →