[wege]mini

Mitglied

- Mitglied seit

- Okt 25, 2020

- Beiträge

- 32

- Bewertungspunkte

- 13

- Punkte

- 8

Cache ist der neue Takt.

Wirklich?

Wer hätte es gedacht.

"was CPUs wirklich "schnell" für Gamer macht ist Cache, Cache und noch mal Cache. Der muss dann mit ordentlicher Latenz angebunden sein und schweine schnell. Am besten mit CPU Takt." ← habe ich im Mai 2020 bei CB geschrieben.

Ich wünsche dir aber in jedem Fall frohe Ostern und genieße die Zeit, die du hast. Es ist zwar unendlich davon vorhanden, nicht aber für uns Menschen. Wir müssen das Beste daraus machen und du bist auf jeden Fall ein gutes Beispiel, wie man es macht.

Weiter machen und bleibe uns allen bitte noch viele Jahre erhalten. Einheitsbrei ist für jedermann. Kann man mögen, muss man aber nicht.

mfg

p.s.

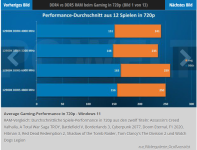

Die dann erreichten 15% gegenüber dem 5800er, überraschen mich aber tatsächlich. Ich hätte bei dem Takt mit höchsten 10% gerechnet.