DigitalBlizzard

Urgestein

Warum hast jetzt zur 4060ti mit 16GB gegriffen und nicht zur 4070 die nicht viel Teurer ist dafür aber effizienter wo der Aufpreis doch nicht mehr so groß ist?

Du nimmst mehr Verbrauch bei der 4060ti in Kauf für 4GB mehr,oder verbraucht die 4070 am Ende doch mehr bei gleicher Leistung wie die 4060ti?

Dann hättest doch besser zur AMD gegriffen, weil da ist es kein Problem.

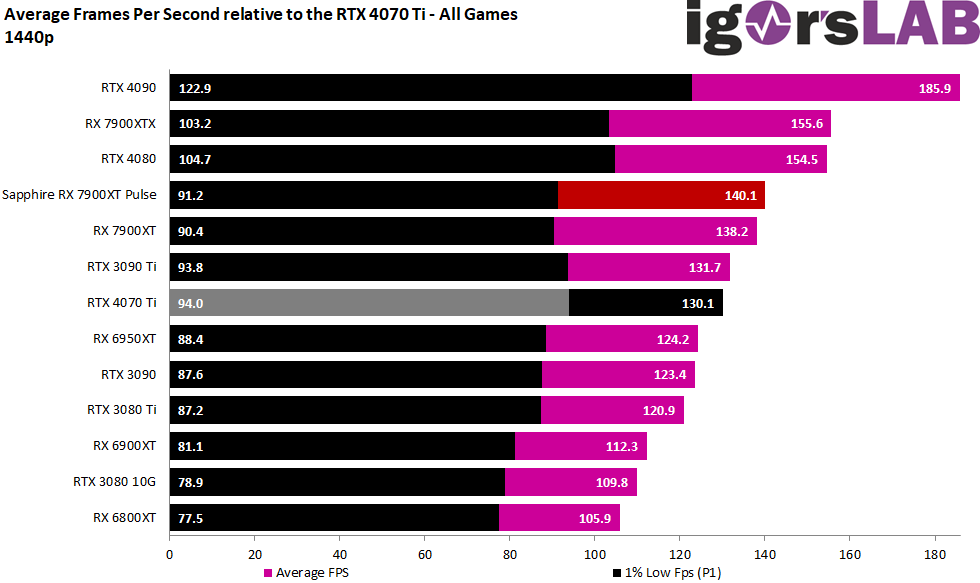

Und zu deinen komischen vergleichen solltest dir mal reale Daten ansehen.

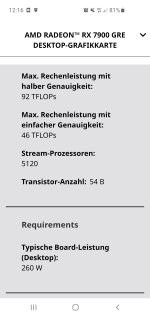

Die 7600 ist ne 6700 mit weniger VRAM,leicht weniger Verbrauch und günstiger.

Die 4GB mehr kann ich verstehen, den Rest gar nicht,aber gut ich bin besseres gewohnt mit AMD wo die größeren Modelle Effizienter sind als die kleineren und Intel und NVIDIA da nicht mithalten können.

Gut Du kannst es nicht und NVIDIA Karten kann man nicht Effizienz betreiben.

Allein schon zu Schreiben das die 6800 lauter ist und Wärmer wird und dann noch das Bild ein zu fügen mit Lüftern die der Karte die kühle Luft entziehen disqualifiziert Dich eh und zeigt nur wie Du denkst.

Bring also nix mit dir,weil Du das eigentliche Thema eh nicht verstehst.

Und von welchem Test redest DU,ich sehe keinen......

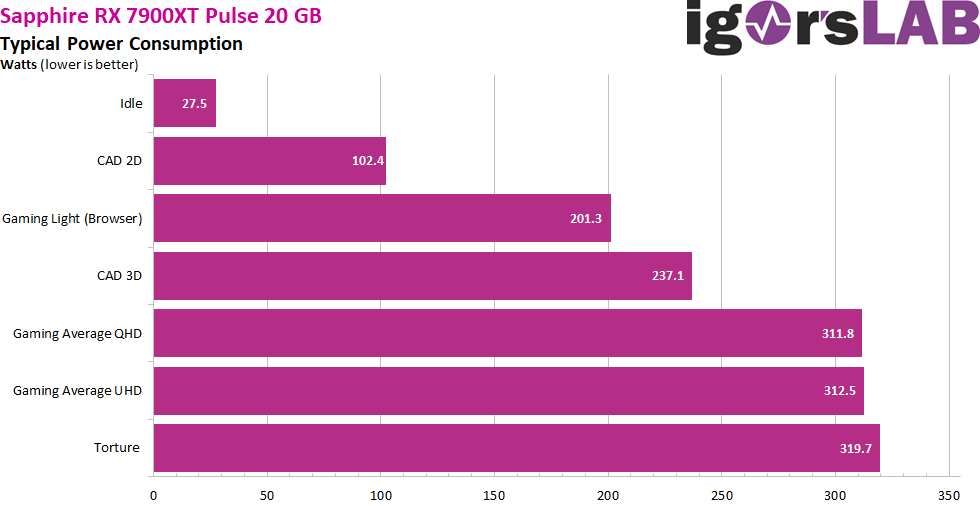

Das waren so verscheidene Einlassungen, bezüglich AMD sei Effizienter usw.Und selbst eine 6900XT ist schon fast Effizienter als ne 4060TI,da liegt eine 6800 mit der 4060TI schon recht gleich auf für den gleichen Preis.

Leider liefert Igor keine Daten,deswegen TGs Cyberpunk2077.

Meine 6900XT liefert im Spiel immer über 50FPS wenn man das Aufzeichnen mal abzieht bei max TBP von 160Watt wenn sie Lüfter hätte,die 4060TI avg 46FPS bei max 150Watt.

die Ausgangslage war folgende

Da habe ich bereits ganz klar erklärt, warum es letztlich Diese und keine Andere wurde.Moinsen, ja seit knapp einer Woche bin ich auch im Besitz einer 4060Ti, allerdings in der 16GB Version, eine Inno3D / Zotac Twin X2 OC https://www.inno3d.com/en/PRODUCT_INNO3D_GEFORCE_RTX_4060_TI_16GB_TWINX2_OC_WHITE

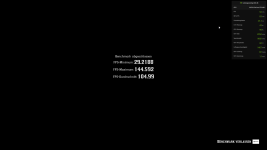

Ich habe meine vorherige 3070 OC durch diese ersetzt und wurde nur positiv überrascht, da ich sowieso nur in FHD 144Hz max. auflöse, reicht das völlig, selbst für meine ab und an stattfindenden Gaming Anfälle ( RDR2, Division 2 etc. )

Was mir sofort aufgefallen ist, am Beispiel RDR2, die Grafik ist bei gleichen Ultra Einstellungen wie vorher bei der 3070 OC irgendwie smoother, dazu läuft es dank 16GB RAM jetzt viel stressfreier.

Aber das Beste ist wirklich der Verbrauch und damit auch die viel geringeren Temperturen und eine Lautstärke die nicht mehr vorhanden ist.

Bei 165Watt liegt das bisherige Maximum in Werks OC Einstellungen, dabei geht die Karte nicht mal auf 70Grad Temperatur, Hotspot waren 76 Grad, und man hört sie absolut nicht.

Ich habe lange mit mir gerungen, weil ich definitiv keine 8GB Karte mehr haben wollte, aber in der Mittelklasse quasi alles mit 8GB gesetzt ist, daher war ich schon drauf und dran, schweren herzens auf eine RX6800 zu gehen.

Ich bin aber sehr eingeschränkt, weil ich eine weiße Karte brauche ( White Build System ).

Es gab schlicht nichts, womit ich glücklich hätte werden können, erst als meine bisherige Gigabyte 3070 Vision OC nach wenigen Monaten quasi fast abgeraucht ist, weil plötzlich die Wärmeleitpads offensichtlich keinen Bock mehr auf ihren Job hatten, habe ich kurzentschlossen die Inno3D 16GB 4060ti gekauft.

Als Fazit kann ich bisher nur sagen, der absolute Sweetspot für jeden der Gaming in FHD abwickelt.

Ich bin fast ein wenig verliebt.

Endlich mal keine exorbitanten Temperaturen und Lüfterorgien, saubere Leistung, die zumindest mit der 3070 OC gleichauf liegt ( nahezu identische FPS in den Games, teilweise sogar bessere wie bei RDR2 ), gute 100Watt weniger Verbrauch und endlich keinen auf Kante genähten VRAM mehr.

nur die Preise die Nvidia für 8GB RAM mehr aufruft, sind eine echte Ohrfeige.

Eine 3070 gibts ab 400€ logischerweise nur mit 8GB, eine 4060ti mit 8GB gibts ebenfalls ab 400€, eine RX6750 mit 12GB gibts ab 380€, eine ARC 770 mit 16GB gibts ab 360€, aber die 4060ti mit 16 GB gibts ab 530€ also mindestens 120 Euro teurer als die normale 4060ti, 120€ für 8GB GDDR6!??? Selbst die 4070 kommt mit 12GB daher und die bekommt an bereits ab 590€

Bisher lagen zwischen einer 3060ti und einer 3070 je nach Modell so ca 100-150€, also ca 100€ mehr für die nächstgrößere GPU.

Jetzt liegen zwischen 4060ti 8GB und 4070 12GB satte 190€ ( 100€ mehr für die größere GPU und 90€ für 4GB RAM oder was ?? ), zwischen 4060ti 16GB und 4070 12GB ( +100€ für die größere GPU und 40€ Abzug für 4GB weniger RAM ) nur noch 60€. Seltsame Kalkulation.

Die 4070 steigt also knapp 100€ teurer ein als ihre Vorgängerin, nur wegen 4GB RAM mehr, 25€/GB, krass, die Einstiegspreise der 3060ti und der 4060ti mit je 8GB sind jedoch gleich geblieben, also kann ja nur der RAM die Preissteigerung rechtfertigen.

Für Nvidia ist die 4060ti entweder die absolute Melkkuh, oder man will diese Karte, die Nvidia ja eigentlich niemals bauen wollte, über den Preis unbeliebt machen. Nvidia scheint wohl die Politik zu verfolgen, wer mehr RAM will, den man heute auch braucht, soll gefälligst größere und teurere GPUs kaufen, in der Mitteklasse für 1080p haben 8GB zu reichen.

Aber ich will ja keine größere GPU brauche sie auch nicht, nur mehr RAM, also war ich bereits diesen unverschämten Preis zu zahlen.

Und dann kamen so Sätze wie " selbst meine 6900XT ist effizienter als eine 4060ti.... blablabla" Absoluter Nonsens und Kneipenlogik.