Und aus welchen Fingern du dir deine Prozente raus gesaugt hast musst mir auch mal erklären.?!

Die Werte stammen aus den Tests und den Hersteller Angaben, findest unter anderem bei pcgh etc.

Und aus eigener Erfahrung.

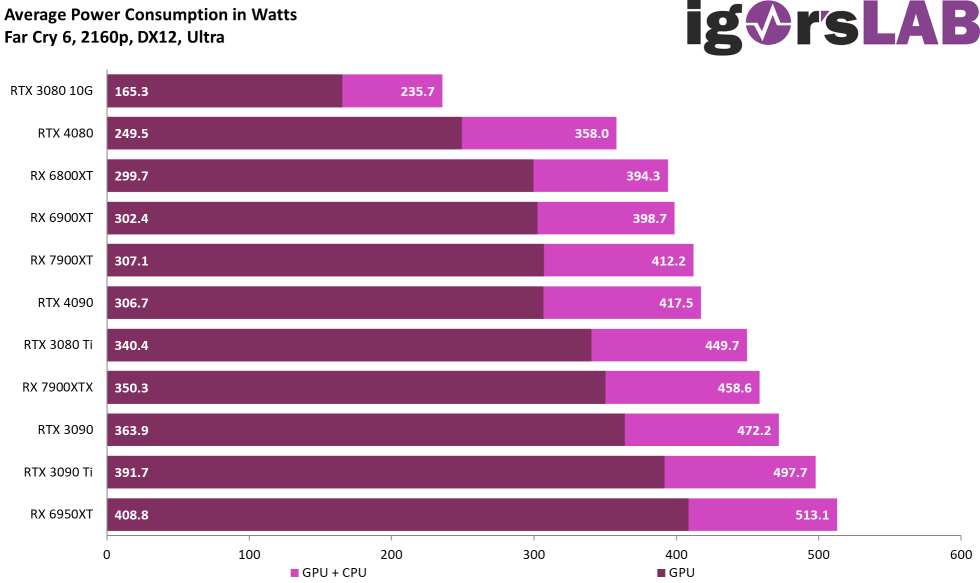

Und Fakt in allen Tests ist das AMDs 7xxx Serie die Wattleistung Pro FPS angestiegen ist, bei Nvidias 40xx Serien ist sie allerdings stark gesunken im Vergleich zum Vorgänger.

Das bedeutet ganz klar das Nvidia effizienter ist.

Die 3060 TI hatte noch 0.183FPS/ Watt die 4060ti hat 0.287FPS/Watt

Die RX6650 hatte 0.17FPS/ Watt die RX6700 hat 0.199 Watt/FPS

Die RX 7 Serie erreicht zwar mehr FPS aber auch der Verbrauch ist gestiegen, sie ist nur minimal effizienter geworden.

Wahren AMD 0.1FPS pro Watt mehr erreicht, schafft AMD gerade mal 0.029 FPS pro Watt mehr.

Ist also ein sehr deutlicher Effizienzunterschied.

Wenn man bedenkt das eine 7600 nicht im Ansatz an eine 4060ti herankommt und trotzdem durchschnittlich 160Watt Boardpower zieht, die 4060ti jedoch deutlich höhere Leistung bei 140Watt durchschnittlicher Boardpower liefert, ist der Effizienzunterschied riesig.

Nimmt man diese Differenzwerte und übertragt die auf die kommende 7700 dann hat AMD ein Problem, denn die bisherige 6700 hat gerade mal 0.176FPS/ Watt erreicht bei einer durchschnittlichen Boardpower von 185 Watt, die 6700xt 0.183FPS/Watt bei einer Boardpower von 205 Watt.

Von der Effizienz der bereits auf dem Markt befindlichen 7xxx ausgehend, wird die 7700 0.205FPS/Watt erreichen und damit 170Watt durchschnittliche Boardpower ziehen.

Die 7700xt wird 0.211FPS/ Watt erreichen und rund 185 Watt Boardpower ziehen.

Das bedeutet ganz klar, Nvidia ist auf gleichem Leistungsniveau fast 25-30% effizienter als AMD bei den neuen Serien.

Und mehr Watt bedeutet immer mehr Wärme und Kühlung und damit Lautstärke.

Und wenn ich von den Werten ausgehe, eine 7600 nicht im Ansatz an die 4060ti herankommt, dann wird die 7700/7700xt der Kontrahent mit nahezu gleicher Leistung werden.

Fazit, um die Leistung einer 4060ti zu erreichen brauchst eine 7700/XT die zwischen 400-500 Euro kosten wird, dabei hat sie nur 12GB RAM, die 4060ti für 500€ aber 16GB RAM und dann braucht die 7700/XT immer noch 20-30 Watt mehr im Schnitt als die 4060ti.

Und wenn ich vom fast gleichen Preis aber höherem Verbrauch ausgehe wird es fies.

Wenn ich jeden Tag NUR 2 Stunden Spiele, dann habe ich mit der AMD 7700 21.900 Watt mehr Strom verbraucht pro Jahr, also 22kwh, was in etwa 8-9€ pro Jahr entspricht.

Macht in 3 Jahren schon fast 30€ damit liegt die AMD durch die schlechtere Effizienz auch preislich hinten.

Und das sind Testwerte und Mathematik, kein Fanboy schöngerede, oder kann ich ja alles einstellen.

Nein, es geht um die Nutzung der Karte ab Werk @ Stock, einstellen, Undervolten etc kann ich bei Nvidia auch.