Mit Raptor Lake beendet nun auch Intel die Ära der monolithischen Prozessoren. Das geschieht natürlich noch einmal mit einem ordentlichen Performance-Schub und es wird der Zweck dieses Test sein, die neuen CPUs mit AMDs neuer Ryzen 7000 Familie zu vergleichen. Das lohnt sich durchaus, denn Intel hätte schon ganz gern die Gaming-Krone zurück. Bei den (read full article...)

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Internetseiten nicht korrekt angezeigt werden.

Du solltest ein Update durchführen oder einen alternativen Browser verwenden.

Du solltest ein Update durchführen oder einen alternativen Browser verwenden.

Intel Core i9-13900K und Core i5-13600K im Test - Showdown der 13. Generation und eine 3/4 Krone für den letzten Monolithen

- Themenstarter Redaktion

- Beginndatum

- Mitglied seit

- Jun 1, 2018

- Beiträge

- 10.204

- Bewertungspunkte

- 18.837

- Punkte

- 114

- Alter

- 59

- Standort

- Labor

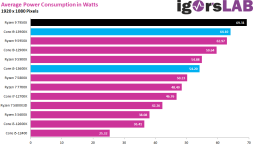

Ich möchte nur mal zu Bedenken geben, dass diese Tests bis runter zu 45 Watt nur die FPS bewerten. Das P1 geht nämlich durchaus etwas in die Knie. In der Relevanz ab Full-HD oder WQHD spielen diese Limits eh keine Rolle, weil die CPU ja meist drunter liegt. Da muss man dann schon mal wie ich eine Durchschnittsberechnung über alle Spiele machen.

Man liegt bereits in Full-HD bei 64 Watt im Schnitt. Ein stark gekapptes PL würde nur die kurzen Spikes abbremsen, die man aber vielleicht braucht, damit nichts dropt. Solche PL-Begrenzungen sind purer Click-Bait, sorry. Und genau weil die CPU eh meist drunter liegt, bringt es nichts und ist dann quasi auch genauso schnell. Was dann durch die Kappung vielleicht kurzzeitig gespart wird und fehlt, sieht man leider am schlechteren Bildverlauf. Und ansonsten spart man ja in der Summe über die Zeit fast gar nichts ein. Sinnlos.

Ich verweise gern mal auf Seite 2 und die Theorie. Wenn man das PL so kappt, dann hat man das System hinter IVMP9.1 und dem PL4/PS4 nicht kapiert.

Man liegt bereits in Full-HD bei 64 Watt im Schnitt. Ein stark gekapptes PL würde nur die kurzen Spikes abbremsen, die man aber vielleicht braucht, damit nichts dropt. Solche PL-Begrenzungen sind purer Click-Bait, sorry. Und genau weil die CPU eh meist drunter liegt, bringt es nichts und ist dann quasi auch genauso schnell. Was dann durch die Kappung vielleicht kurzzeitig gespart wird und fehlt, sieht man leider am schlechteren Bildverlauf. Und ansonsten spart man ja in der Summe über die Zeit fast gar nichts ein. Sinnlos.

Ich verweise gern mal auf Seite 2 und die Theorie. Wenn man das PL so kappt, dann hat man das System hinter IVMP9.1 und dem PL4/PS4 nicht kapiert.

Casi030

Urgestein

- Mitglied seit

- Sep 9, 2019

- Beiträge

- 11.923

- Bewertungspunkte

- 2.338

- Punkte

- 113

Nur das PL zu kappen ist auch verdammt dumm.........

Selbst im PL von 65Watt begrenzt ein Optimierter 5950X @5900X eine Optimiert RX6900XT 0 .

Die neuen Intel und AMD dürften da noch mal mehr Potential haben.

Selbst im PL von 65Watt begrenzt ein Optimierter 5950X @5900X eine Optimiert RX6900XT 0 .

Die neuen Intel und AMD dürften da noch mal mehr Potential haben.

Eragoss

Urgestein

- Mitglied seit

- Jul 23, 2018

- Beiträge

- 1.096

- Bewertungspunkte

- 314

- Punkte

- 84

- Alter

- 42

- Standort

- Deutschland

Wo würde sich den der 9900k bei der Spieleleistung aktuell einordnen? Aus dem Bauch heraus in 720p vielleicht 20-25% langsamer wie der 13900k?

TGH1978

Mitglied

- Mitglied seit

- Mrz 1, 2019

- Beiträge

- 55

- Bewertungspunkte

- 25

- Punkte

- 18

@Igor: Mal wieder ein spitzen Test - Vielen Dank!

@Palmdale + @Tronado

Auch wenn hier nicht soviel technischer Hintergrund erklärt wird, wie von Igor, aber speziell wenn ihr den Einfluss von DDR4 Speicher oder Luftkühlung sehen wollt, empfehle ich euch den Test von Hardwareluxx:

www.hardwareluxx.de

www.hardwareluxx.de

Die testen beide CPU's mit DDR4 und DDR5 und nützen einen be quiet! Dark Rock Pro 4

Danke für die ausführliche Arbeit. Ich schwanke nur noch, obs mit DDR4 @3600 C16 Samsung BDie deutliche Unterschiede zu DDR5 gibt im Gaming, um nicht doch komplett zu tauschen

Schöne CPUs, wie erwartet, sogar noch etwas schneller als gedacht. Tests mit 200-220W Limit wären interessant, das schafft der Luftkühler.

@Palmdale + @Tronado

Auch wenn hier nicht soviel technischer Hintergrund erklärt wird, wie von Igor, aber speziell wenn ihr den Einfluss von DDR4 Speicher oder Luftkühlung sehen wollt, empfehle ich euch den Test von Hardwareluxx:

Der Dino Intel ist noch nicht ausgestorben: Core i9-13900K und Core i5-13600K im Test - Hardwareluxx

Der Dino Intel ist noch nicht ausgestorben: Core i9-13900K und Core i5-13600K im Test.

Die testen beide CPU's mit DDR4 und DDR5 und nützen einen be quiet! Dark Rock Pro 4

Megaone

Urgestein

- Mitglied seit

- Jan 26, 2021

- Beiträge

- 1.746

- Bewertungspunkte

- 1.645

- Punkte

- 113

Seh ich genauso. Ein Produkt ist erstmal so zu präsentieren wie es am Ende gedacht und für ein großteil der Benutzer gemacht wird.Ich verstehe was du meinst, und stimme dem auch zu. Aber es ist doch völlig i.O. zu zeigen was geht. Jeder hat selbst in der Hand an welchem Punkt er seine Hardware betreiben möchte. Finde es so besser als wenn alles @stock so wahnsinnig sparsam konzipiert wird. Kühlung, Stromersorgung etc. So können Enthusiasten und Sparfüchse (naja beim Anschaffungspreis nicht) auf ihre Kosten kommen. Autos werden auch mit max Leistung angegeben und nicht mit dem Durchzug im 5. Gang

Deine Kritik sollte wohl eher an die Reviewer gehen. Technisch gesehen haben wir halt nur noch Verbesserungen.

Welchen Schluss ich am Ende aus der Bewertung ziehe, bleibt doch mir überlassen. Meiner Meinung nach dürfte es für alle Produkte mit integriertem Akku und für alle AIO`S ohne Aufrüstmöglichtkeit und der Option Kühlflüssigkeit nachzufüllen, nur Daumen nach untern und die goldene Zitrone geben. Diese Liste läst sich fast beliebig erweitern. Aber so funktioniert die Welt halt leider nicht.

Solange ich meinen Traum vom Absolutismus mit mir an der Spitze nicht umgesetzt habe, muss ich brav Vergleichstest lesen und die sind von Igor unterm Strich immer sehr objektiv. Trotzdem kann ich ja auf Basis seiner Ergebnisse zu einem für mich individuell anderem Schluss kommen. Das macht seinen Test aber nicht weniger richtig.

LightWaveGuru

Mitglied

@Igor Wallossek

Zitat aus dem Artikel

"Mein geliebter igoBOT ist da eine eine dankbare Aufgabe, auch wenn das Rendern auf der CPU langsam aus der Mode kommt."

Lieber Igor, das rendern auf CPU`s "kommt nicht langsam aus der Mode". Ob wir 3D-Artists auf CPU oder GPU rendern hängt ergo davon ab welche Shader-Eigenschaften ein Surface-Material haben muss. So bieten GPU-Renderer bei weitem nicht so viele Optionen an wie CPU-Renderer. (Kein Wunder. CPU-Renderer haben zum Teil 25 Jahre Vorsprung bzgl. der Entwicklung).

Das heisst im Fall der Fälle rendern wir die entsprechenden Layer jeweils auf GPU und CPU (mit verschiedenen Renderern).

Je nachdem welche Kanäle wir für den finalen "Beauty"-output brauchen.

Beispiel. Wir haben einen GPU-Renderer der bestimmte procedurale 2D/3D Texturen/Funktionen nicht hat. In diesem Falle werden alle Kanäle die nicht von diesen Texturen beeinflusst werden via GPU gerendert, und alle Layer bei denen diese sichtbar werden mit CPU.

Sprich man lässt dann z.b. die Kanäle amb occ, z-depth, clay gray,mat ID, position, tangent, objekt layer color, render Layer ID, etc.pp via GPU rechnen und alles andere via CPU. (z.b. diffuse, refraction, reflection, roughness, opacity etc.pp)

Es kommt ergo tatsächlich darauf an welche Kanäle man für den finalen Output braucht um in der Post-Produktion alle Layer zu haben die man braucht. Insofern sind pauschale Äusserungen wie "kommt aus der Mode" unpassend, denn es geht nicht um "Mode/Zeitgeist" sondern um konkrete Anforderungen bzgl. Shader-Development.

Insofern. Solange GPU-Renderer nicht die gleiche Vielfalt an Lösungen anbieten können wie CPU-Renderer wird es je nach Task/Aufgabe unvermeidlich sein auch weiterhin im Fall der Fälle CPU-Renderer einzusetzen.

Daher. Wir 3D-Artists (ich meine die damit ihr Geld verdienen) wissen das beide Wege nicht miteinander konkurieren sondern sich bisweilen sehr gut ergänzen.

my 2 cent zu dem Thema

Grüsse LWGURU

Zitat aus dem Artikel

"Mein geliebter igoBOT ist da eine eine dankbare Aufgabe, auch wenn das Rendern auf der CPU langsam aus der Mode kommt."

Lieber Igor, das rendern auf CPU`s "kommt nicht langsam aus der Mode". Ob wir 3D-Artists auf CPU oder GPU rendern hängt ergo davon ab welche Shader-Eigenschaften ein Surface-Material haben muss. So bieten GPU-Renderer bei weitem nicht so viele Optionen an wie CPU-Renderer. (Kein Wunder. CPU-Renderer haben zum Teil 25 Jahre Vorsprung bzgl. der Entwicklung).

Das heisst im Fall der Fälle rendern wir die entsprechenden Layer jeweils auf GPU und CPU (mit verschiedenen Renderern).

Je nachdem welche Kanäle wir für den finalen "Beauty"-output brauchen.

Beispiel. Wir haben einen GPU-Renderer der bestimmte procedurale 2D/3D Texturen/Funktionen nicht hat. In diesem Falle werden alle Kanäle die nicht von diesen Texturen beeinflusst werden via GPU gerendert, und alle Layer bei denen diese sichtbar werden mit CPU.

Sprich man lässt dann z.b. die Kanäle amb occ, z-depth, clay gray,mat ID, position, tangent, objekt layer color, render Layer ID, etc.pp via GPU rechnen und alles andere via CPU. (z.b. diffuse, refraction, reflection, roughness, opacity etc.pp)

Es kommt ergo tatsächlich darauf an welche Kanäle man für den finalen Output braucht um in der Post-Produktion alle Layer zu haben die man braucht. Insofern sind pauschale Äusserungen wie "kommt aus der Mode" unpassend, denn es geht nicht um "Mode/Zeitgeist" sondern um konkrete Anforderungen bzgl. Shader-Development.

Insofern. Solange GPU-Renderer nicht die gleiche Vielfalt an Lösungen anbieten können wie CPU-Renderer wird es je nach Task/Aufgabe unvermeidlich sein auch weiterhin im Fall der Fälle CPU-Renderer einzusetzen.

Daher. Wir 3D-Artists (ich meine die damit ihr Geld verdienen) wissen das beide Wege nicht miteinander konkurieren sondern sich bisweilen sehr gut ergänzen.

my 2 cent zu dem Thema

Grüsse LWGURU

Arcbound

Veteran

Wenn ich mir die Effizienz- und FPS-Balken so angucke, muss ich einfach immer wieder darüber staunen, wie gut der 5800X3D ist. Ich persönlich werde für meinen Privat-PC daher versuchen zu warten, bis AMD da eine neue Gen der V-Cache CPUs bringt, ehe ich wieder aufrüste.

@TGH1978

Danke für den Tipp! Dachte beim lesen der Spiele schon, dass es ja kaum Auswirkungen hat. Dann jedoch Troy und Cyberpunk.... Hmm, hab halt nochn edles 3600er Kit von G.Skill verbaut und könnt mir so den 6400er sparen. Die Boards selbst nehmen sich da ja nicht so viel (und ehrlich gesagt genügt mir z690)

Danke für den Tipp! Dachte beim lesen der Spiele schon, dass es ja kaum Auswirkungen hat. Dann jedoch Troy und Cyberpunk.... Hmm, hab halt nochn edles 3600er Kit von G.Skill verbaut und könnt mir so den 6400er sparen. Die Boards selbst nehmen sich da ja nicht so viel (und ehrlich gesagt genügt mir z690)

HerrRossi

Urgestein

- Mitglied seit

- Jul 25, 2018

- Beiträge

- 6.778

- Bewertungspunkte

- 2.243

- Punkte

- 113

Sei bloß Still und erwecke keine Gruft Trolle die dann wieder los hudeln

Naja, ich bin leider nicht Experte genug, um das für dumm zu halten, wenn es vielerorts und als Fazit durchaus zahlreicher Tests empfohlen wird. Auch der 8auer empfiehlt ja, die 4090 nicht zu undervolten, sondern nur das Powerlimit zu senken, und auch wenn sich über so was sicher immer diskutieren lässt, dürfte das wohl kaum Resultat kompletter Ahnungslosigkeit sein - ganz abgesehen davon, ob ein 0815-User da überhaupt relevante Unterschiede wahrnimmt.Nur das PL zu kappen ist auch verdammt dumm.........

Neben CB attestiert ja auch hardwareluxx dem 13900K "gute TDP-Skalierung mit Stromspar-Potenzial" und sagt im Fazit: "Vor allem beim Core i9-13900K lohnt es sich einmal mehr, diesem seine Grenzen aufzuzeigen und via BIOS die Power-Limits zu beschränken. Selbst bei 125 W liefert er noch er noch eine gute Leistung ab. In Spielen kommt er ohnehin nicht über 100 W hinaus. Hier muss man also zwischen Anwendungen unterscheiden, die alle Kerne verwenden und solchen wie die Spiele, die eben keine Volllast erzeugen."

Wenn man - wie ich - 90% spielt und dabei zum einen nur ganz ab und zu mal was anderes macht, und dabei zum anderen auch ohne aufwändige Wasserkühlungen ein möglichst kühles und leises, dabei aber schnelles System haben möchte, erscheint es mir recht naheliegend, die 4090 auf 320 und den 13900K auf 100 Watt zu limitieren, um sich beim Gehäuse/Lüfter/Kühler darauf verlassen zu können, immer in diesem Rahmen zu bleiben. Wenn die 4090 dabei kaum Leistung verliert und der 13900K in Spielen ohnehin nie über 100 W hinaus kommt, dauern halt Dinge wie Entzippen, Konvertieren u.ä. vielleicht mal etwas länger als sie müssten, aber auf einem fast reinen Spielerechner ist das von komplett untergeordneter Bedeutung. Wenn es gute Gründe gibt, die dagegen sprechen, würde ich die sehr gerne hören.

Megaone

Urgestein

- Mitglied seit

- Jan 26, 2021

- Beiträge

- 1.746

- Bewertungspunkte

- 1.645

- Punkte

- 113

Womit wir endlich mal wieder beim Thema wären. Ist jetzt zwar kurz "off Topic" und ich bitte aufrichtig allseits im voraus um Entschuldigung, aber was macht Ihr mit eurer 4090?Auch der 8auer empfiehlt ja, die 4090 nicht zu undervolten, sondern nur das Powerlimit zu senken, und auch wenn sich über so was sicher immer diskutieren lässt, dürfte das wohl kaum Resultat kompletter Ahnungslosigkeit sein - ganz abgesehen davon, ob ein 0815-User da überhaupt relevante Unterschiede wahrnimmt.

s

Hab meine gerade eingebaut, aber was macht ihr genau

Untervolten, Powerlimit oder beides und wenn ja um wieviel?

Danke.

Tronado

Urgestein

Mir z.B. geht es nicht darum, auf 65W PL 3 Ct/Stunde Strom zu sparen, sondern weiterhin einen Luftkühler verwenden zu können.Man liegt bereits in Full-HD bei 64 Watt im Schnitt. Ein stark gekapptes PL würde nur die kurzen Spikes abbremsen, die man aber vielleicht braucht, damit nichts dropt. Solche PL-Begrenzungen sind purer Click-Bait, sorry. Und genau weil die CPU eh meist drunter liegt, bringt es nichts und ist dann quasi auch genauso schnell.

Wenn die Temperaturentwicklung und die Power-Skalierung beim 13900K ähnlich wie beim 12900K verläuft, reicht ein Limit von 200W aus, um die CPU mit meinem Luftkühler auch bei z.B. zweimaligem CB23 unter 80°C zu halten und nur minimalen Leistungsverlust zu haben.

Angefügt: Lass doch mal bitte SOTTR in FHD auf 200W PL laufen und poste die fps, dann brauche ich nicht bis Montag warten, wenn meiner ankommt.

Zuletzt bearbeitet

:

ipat66

Urgestein

- Mitglied seit

- Sep 16, 2019

- Beiträge

- 1.359

- Bewertungspunkte

- 1.357

- Punkte

- 115

was macht Ihr mit eurer 4090?

….“kurz“....

Ich glaube dafür kann getrost ein neuer Thread aufgemacht werden.

Da wird jede Menge dazukommen; 100%

Megaone

Urgestein

- Mitglied seit

- Jan 26, 2021

- Beiträge

- 1.746

- Bewertungspunkte

- 1.645

- Punkte

- 113

Meinetwegen gerne….“kurz“....

Ich glaube dafür kann getrost ein neuer Thread aufgemacht werden.

Da wird jede Menge dazukommen; 100%

- Mitglied seit

- Jun 1, 2018

- Beiträge

- 10.204

- Bewertungspunkte

- 18.837

- Punkte

- 114

- Alter

- 59

- Standort

- Labor

Bitte für die 4090 einen neuen Thread aufmachen.

BTW: Optane ist bei Intel angefragt

BTW: Optane ist bei Intel angefragt

HerrRossi

Urgestein

- Mitglied seit

- Jul 25, 2018

- Beiträge

- 6.778

- Bewertungspunkte

- 2.243

- Punkte

- 113

Intel hat Optane doch schon vor Monaten eingestampft: https://www.heise.de/news/Optane-Intel-stampft-seine-letzte-Speichersparte-ein-7194159.html

- Mitglied seit

- Jun 1, 2018

- Beiträge

- 10.204

- Bewertungspunkte

- 18.837

- Punkte

- 114

- Alter

- 59

- Standort

- Labor

Darum geht es doch nicht, sondern um den Hardware-Support von CPU und Chipsatz.

Onkel.Tom

Mitglied

- Mitglied seit

- Mai 29, 2021

- Beiträge

- 55

- Bewertungspunkte

- 8

- Punkte

- 8

Für Leute die von ZEN3 aufrüsten und ihr gutes DDR4 RAM behalten wollen ist Core13 die Beste Alternative um günstig TOP Performance zu bekommen. ZEN4 mit DDR5 ist einfach zu teuer. Und bei Intel kauft man immer mit einer neuen CPU auch ein neues Board, das ist kein Argument gegen Core13.

Tronado

Urgestein

Ja, diesmal hat Intel den "neue CPU passt auch in altes Board" und P/L-Bonus, beim nächsten Mal wieder nicht. Es gibt B660 Boards mit DDR4 schon für 110€, AMD B650 kosten weit über 200€. Alten DDR4 Speicher weiterverwenden, 13100K oder, wenn Preise etwas fallen, 13600K drauf, da hat man eine preiswerte, leistungsstarke Gaming Plattform.

Ich glaube, AMD hat die Marktchancen so teurer Mainboards mit neuem Speicher und teuren CPUs vielleicht überschätzt und das System "neue CPU passt auf uralte AM4 Boards" rächt sich jetzt auch. Was würde ich machen wenn ich überwiegend spiele und noch ein altes AM4 Board besitze? Natürlich einen 5800X3D drauf packen. Diese CPU ist eigentlich umsatzschädigend, war eine blöde Idee.

Ich glaube, AMD hat die Marktchancen so teurer Mainboards mit neuem Speicher und teuren CPUs vielleicht überschätzt und das System "neue CPU passt auf uralte AM4 Boards" rächt sich jetzt auch. Was würde ich machen wenn ich überwiegend spiele und noch ein altes AM4 Board besitze? Natürlich einen 5800X3D drauf packen. Diese CPU ist eigentlich umsatzschädigend, war eine blöde Idee.