Viel hilft viel, sagte meine Oma. Und bevor man etwas wegwirft, macht man besser noch einmal etwas Neues draus. Sagen meine Oma und Intel. Nach Raptor Lake ist vor Arrow Lake und so kommt fast nach genau einem Jahr noch einmal der Schnappi-Refresh. Sagt Intel und meine Oma schweigt. Und so stehen neben etwas mehr Takt zumindest bei einer CPU auch noch ein paar mehr E-Kerne auf dem Datenblatt. Doch nichts im Leben ist umsonst. Sagen meine Oma und mein Energieversorger. Und genau das wird heute das Thema sein: Wieviel mehr muss man am EPS-Anschluss reinstecken, damit sich am HDMI- […] (read full article...)

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Internetseiten nicht korrekt angezeigt werden.

Du solltest ein Update durchführen oder einen alternativen Browser verwenden.

Du solltest ein Update durchführen oder einen alternativen Browser verwenden.

Raptor Lake Resfresh mit den Intel Core i9-14900K, Core i7-14700K und Core i5-14600K im Test

- Themenstarter Redaktion

- Beginndatum

Tronado

Urgestein

Luftgekühlt sind beim (gut eingestellten) 13900KF etwas über 80°C bei ca. 23°C Raumtemperatur die Regel, bei Volllast mit 220W PL. 300W wollen wir uns ja dann doch nicht antun.Öhm also mein 12700K hat bei Vollast mit 165W auf stock settings im Cinebench 60-62°C. Von daher sei dir da mal ned so sicher. :'D

Ifalna

Veteran

- Mitglied seit

- Mrz 31, 2022

- Beiträge

- 362

- Bewertungspunkte

- 320

- Punkte

- 63

Du kriegst allen Ernstes 220W mit ner LuKü weg? Donnerwetter. Das möchte ich bei meinem Racker lieber nicht versuchen.Luftgekühlt sind beim (gut eingestellten) 13900KF etwas über 80°C bei ca. 23°C Raumtemperatur die Regel, bei Volllast mit 220W PL. 300W wollen wir uns ja dann doch nicht antun.Beim Spielen sind es in der Regel 80-120W je nach Spiel.

Selbst mein Custom Loop liegt bei ca 250W schon über 90°C.

Hab aber auf Reddit gelesen, dass die XX900er chips wohl besser zu kühlen sein sollen als der 12700K.

Bei 300W musst du dann vermutlich zum Staubsaugermodul greifen um noch genug Airflow hinzubekommen. :'D

Tronado

Urgestein

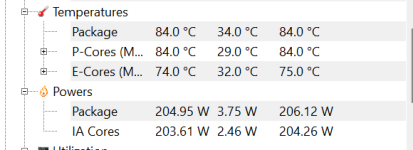

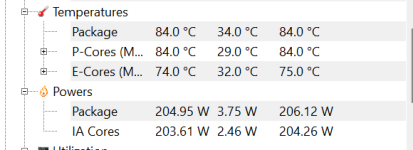

Saufen lassen darfst du sie alle nicht, bis 220W mit negativem Vcore offset geht's noch mit einem sehr guten Luftkühler. Die meisten 360er AIOs sind ja kaum besser. Hier im CPU-Z Stresstest, zieht nicht mehr als 208 W. Ist aber auch warm in der Bude, ca. 24°C.

Aber auf dem Board schafft er sogar dauerhaft 5,5GHz allcore, das war bei den Z690 vorher unter Luft weniger.

Aber auf dem Board schafft er sogar dauerhaft 5,5GHz allcore, das war bei den Z690 vorher unter Luft weniger.

Das ist ja garnicht mal so gut.

5% schneller merkt man in keiner Anwendung. Das kann man nur Messen.

Klar Neue Gen für die Händler , damit sie jedes Jahr was neues haben... wenn Intel den einfach als ersatz zum alten zum selber Preis angeboten hätte ok, so ist es für mich nur eine verkappte Preiserhöhung.

Ich fände z.b. mal eine CPU mit 2P Core und 64E Cores interessant.

5% schneller merkt man in keiner Anwendung. Das kann man nur Messen.

Klar Neue Gen für die Händler , damit sie jedes Jahr was neues haben... wenn Intel den einfach als ersatz zum alten zum selber Preis angeboten hätte ok, so ist es für mich nur eine verkappte Preiserhöhung.

Ich fände z.b. mal eine CPU mit 2P Core und 64E Cores interessant.

Zuletzt bearbeitet

:

Tronado

Urgestein

Ernsthaft? Die E-Cores brauchen in etwa die halbe Leistung der P-Cores, haben aber weniger als die halbe Rechenleistung. dann wäre ein 16- oder 20-Kerner nur mit P-Cores schon interessanter, auf ca. 250W gedrosselt.Ich fände z.b. mal eine CPU mit 2P Core und 64E Cores interessant.

DigitalBlizzard

Urgestein

Das hast Du völlig missinterpretiert, wir reden nicht davon, dass die jetzigen und in kürze kommenden CPUs schlecht sind, sondern, dass das was sie liefern, nur small Steps im Vergleich zu den Vorgängern sind. Kein echter Effizienzgewinn, Leistungszuwachs nur durch aufbohren, bei AMD 8000 wird es endlich Big-Little, aber durch das anstehende Sockelende von AM5 eine Limitierung.Quark.

Einfach mal abseits der Benchmarkblase schauen und realisieren, dass so ziemlich jede CPU brachiale Leistung liefert für das was 0815 Konsumenten mit den Teilen wirklich anstellen.

Selbst im Gamingbereich sind wir nachwievor GPU limitiert, wenn man mal von Mäuse- und Kinderkino a.k.a. 720p/1080p absieht.

Daher ist der 8000er, auch wenn er Recht gut werden wird, keine wirklich langfristige Lösung, bei Intel kommt die wirklich wirkungsvolle Änderung in der Architektur und Effizienz erst mit Cougar Cove und mit dem Beast Lake in wirklich interessantem Ausbau.

Aber mit Intel 16.Gen und AMD 9000 kommen massive Steps, auch gerade in der Effizienz.

Das bedeutet also mitnichten, dass die 15.Gen und AMD 8000 schlecht wären, sie haben nur nicht so große Steps und Vorteile an Bord, wie ihre Nachfolger.

Auch die jetzigen Generationen CPUs sind schon oft verdammt gut und bieten mehr als genug Leistung, aber es hapert stark an der Effizienz, gerade bei Intel im Moment noch.

Aber wir ich in mehreren früheren Posts bereits angedeutet habe, wird Nvidia den Einstieg in den CPU Markt wagen, und das könnte uns Kunden massive Vorteile bringen.

Mehr Konkurrenz und ich denke Nvidias Debut wird durchaus ernst zu nehmend sein, ARM CPUs mit hoher Leistung und Effizienz und ordentlicher KI, und einige Boardpartner sind schon ganz heiß drauf.

Arbeiten ja im GPU Bereich und früher im MB Bereich Chipsätze seit vielen Jahren mit Nvidia zusammen.

Das wird das ewige hin und her zwischen AMD und Intel auch preislich ordentlich aufmischen.

DigitalBlizzard

Urgestein

Ja, vom Hersteller Logo her wird es vollständig Grün bald geben, dann hast die Wahl zwischen komplett ROT, GRÜN oder BLAU, wobei dann Grün einfach das beste Gesamtpaket liefern könnte.Jaa, ein rein grüner PC, das wäre fein.

Das Nvidia in der Lage ist, auch ordentliche Effizienzsprünge zu machen haben sie ja gerade bewiesen, da sind 30-40% Effizienzzuwachs, bzw Leistungszuwachs bei gleichem Verbrauch kein Problem gewesen, auf dem CPU Markt hast von einer Generation zur nächsten keine solchen Zuwächse gehabt bisher.

Wird zwar noch ne Weile dauern, aber da wird dann wohl einiges grüner, auch die Verbräuche.

Mich freuts.

Aber auch Intel wird mit den Grafikambitionen immer besser, die nächsten ARCs werden auch besser und effizienter, ist halt die Frage, um mal politisch zu werden, wem die Grünen mehr Marktanteile abnehmen werden, den Roten oder den Blauen?

Die Entwicklung der ARM CPU läuft bereits bei Nvidia, und wenn alles glatt läuft ist das Debut 2025, ist auf jeden Fall ein straffer Zeitplan, auch für die Boardpartner und die Softwarehersteller.

Aber soweit ich weiß, ist speziell ein Boardpartner mit 3 Buchstaben bereits voll im Boot, da hat die rot-rote Freundschaft nämlich ein wenig gelitten die letzten Jahre und zuletzt bei den GPUs.

Man darf gespannt sein.

Und auf dem Notebookmarkt wird es sicher auch nochmal Staub aufwirbeln, da könnte eine effizientere CPU und Grafikeinheit des grünen Teams richtig Schwung rein bringen.

Zuletzt bearbeitet

:

Na wenn Ihr Euch da mal nicht zu große Hoffnungen macht. Eine NVIDIA-CPU dürfte eher weniger den Otto-Normalverbraucher als Zielgruppe haben, sondern das Server- bzw. allgemein AI-Maschinen bedienen sollen. Ob und von wem die sich nutzen lassen, kommt vor allem auf die Software-Landschaft an und für uns Gamer ist ARM mal einfach total uninteressant (bisher).

Mich würde es ja durchaus auch freuen, aber ich würde wetten, dass NVIDIA-CPUs erstmal nicht für den Consumer-Bereich relevant sein werden.

Mich würde es ja durchaus auch freuen, aber ich würde wetten, dass NVIDIA-CPUs erstmal nicht für den Consumer-Bereich relevant sein werden.

DigitalBlizzard

Urgestein

Erstmal nicht wirklich, wobei ganz klar für den Consumer Desktop Bereich mitentwickelt wird, Zielrichtung ist Windows Private User, der Einstand im Consumer Segment werden wohl eher Notebooks, und AIO oder Mini PCs machen, eben mit Ausrichtung auf KI, aber die wird im Desktopbereich und auch bei den Gamern in den nächsten Jahren massiv an Bedeutung gewinnen, OB die Klassische CPU Mittelfristig überhaupt so weiterleben wird, auch im Big-Little Konzept, ist fraglich. Die Verlagerung von der schieren Rechenleistung, hin zur energieeffizienteren Selbstoptimierung mittels KI ist längst in vollem Gange.Na wenn Ihr Euch da mal nicht zu große Hoffnungen macht. Eine NVIDIA-CPU dürfte eher weniger den Otto-Normalverbraucher als Zielgruppe haben, sondern das Server- bzw. allgemein AI-Maschinen bedienen sollen. Ob und von wem die sich nutzen lassen, kommt vor allem auf die Software-Landschaft an und für uns Gamer ist ARM mal einfach total uninteressant (bisher).

Mich würde es ja durchaus auch freuen, aber ich würde wetten, dass NVIDIA-CPUs erstmal nicht für den Consumer-Bereich relevant sein werden.

Ist auch nur logisch, das Geld für die Game Entwickler liegt längst nicht mehr auf dem Gaming PC Markt, der schrumpft stetig, mobile Geräte, kleine Gerät, AIO Lösungen, Handhelds und Konsolen werden immer wichtiger im Umsatz.

Entsprechend werden Games auf anderen Leistungsvoraussetzungen getrimmt wodurch die Bedeutung fetter CPUs und GPUs massiv abnehmen wird.

Eine klassische Desktop CPU werden wir wohl erstmal zu Beginn nicht erwarten dürfen, wie sich das weiter Entwickelt, wird klar die Marschrichtung des Gaming Marktes bestimmen.

DigitalBlizzard

Urgestein

Man Stelle sich vor, da kommt sowas wie eine ZOTAC Magnus Box in Klein, mit einer kräftigen Nvidia ARM CPU, kombiniert mit einer guten RTX50xx Mobillösung, sehr guter KI und Windows, die man sich an den Fernseher hängt, PC, Konsole, Streamingbox und co in einem, da kannste dann 4k zocken am Fernseher usw. Das wird die Zukunft, nicht mehr der riesen Kasten mit 600-1000Watt.

Der klassische Gaming PC wird sich klar zur Nerd Retro Kiste entwickeln.

Die Zukunft liegt da, wo das Geld verdient wird und da ist der Desktop PC Markt längst keine Melkkuh mehr.

Selbst Fernseher mit SlotIn Lösungen in die man ein solches PC System eines bestimmten Formfaktors einfach einstecken kann, sind längst in der Mache, etwas was man vom Public Display Bereich z.B. bei NEC schon seit Jahren kennt, wird in Zukunft für den Heimanwender kommen.

Der Fernseher als AIO

Auch die Konsolen werden da obsolet, was wiederum AMD nicht gefallen dürfte.

Der klassische Gaming PC wird sich klar zur Nerd Retro Kiste entwickeln.

Die Zukunft liegt da, wo das Geld verdient wird und da ist der Desktop PC Markt längst keine Melkkuh mehr.

Selbst Fernseher mit SlotIn Lösungen in die man ein solches PC System eines bestimmten Formfaktors einfach einstecken kann, sind längst in der Mache, etwas was man vom Public Display Bereich z.B. bei NEC schon seit Jahren kennt, wird in Zukunft für den Heimanwender kommen.

Der Fernseher als AIO

Auch die Konsolen werden da obsolet, was wiederum AMD nicht gefallen dürfte.

Ifalna

Veteran

- Mitglied seit

- Mrz 31, 2022

- Beiträge

- 362

- Bewertungspunkte

- 320

- Punkte

- 63

Da sind wir uns 150% einig. Ich finde es auch traurig, dass ein 14900K eine schlechtere Effizienz als mein kleiner 12700K hat. Ich mein wenn ich eh nur auf 60Hz daddel, dann braucht der 14900K dann MEHR Energie für die gleiche Leistung?!wir reden nicht davon, dass die jetzigen und in kürze kommenden CPUs schlecht sind, sondern, dass das was sie liefern, nur small Steps im Vergleich zu den Vorgängern sind. Kein echter Effizienzgewinn, Leistungszuwachs nur durch aufbohren

Aber auch meinen kleinen Racker hat Intel jämmerlich weit aus dem Optimum herausgeboxt.

Ich hab ihn inzwischen mit einem Untervolt laufen: 1,25V Global SVID @ -100mV Offset (restliche Settings auf Auto, läuft also stock)

Statt ~165W im Cinebench liegt er jetzt bei 127W. Für 99% der Punkte nur noch 75% der Leistungsaufnahme.

Einziger Nachteil: Prime95 genügt diese Spannung nicht. Von Videorendering über Blender hin zu gaming, alles läuft sonst stabil.

Das ist doch Affentheather.

Ich seh den gleichen Trend aber auch bei GPUs. Ja die 4090 ist effizienter als meine 3080 aber die brachiale Rechenleistung für 4K 120Hz wird nur durch einen starken Energieverbrauch realisiert. Ich werd immer dafür belächelt, dass ich im 60Hz camp sitz aber um ehrlich zu sein: Wenn GPUs 4K 120Hz+ mit weniger als 300W schaffen, dann bin ich interessiert. Sonst hab ich keine Lust mich bei 450W+ lebendig braten zu lassen. :<

Hast Du dafür evtl. ne Quelle für mich?Erstmal nicht wirklich, wobei ganz klar für den Consumer Desktop Bereich mitentwickelt wird, Zielrichtung ist Windows Private User

DigitalBlizzard

Urgestein

Genau das, klar hole ich aus dem V8 noch mehr raus wenn ich den Hub vergrößere, nen Kompressor oder Turbos raufsetze, aber an der Tanke wird es dadurch nicht günstiger.Da sind wir uns 150% einig. Ich finde es auch traurig, dass ein 14900K eine schlechtere Effizienz als mein kleiner 12700K hat. Ich mein wenn ich eh nur auf 60Hz daddel, dann braucht der 14900K dann MEHR Energie für die gleiche Leistung?!

Aber auch meinen kleinen Racker hat Intel jämmerlich weit aus dem Optimum herausgeboxt.

Ich hab ihn inzwischen mit einem Untervolt laufen: 1,25V Global SVID @ -100mV Offset (restliche Settings auf Auto, läuft also stock)

Statt ~165W im Cinebench liegt er jetzt bei 127W. Für 99% der Punkte nur noch 75% der Leistungsaufnahme.

Einziger Nachteil: Prime95 genügt diese Spannung nicht. Von Videorendering über Blender hin zu gaming, alles läuft sonst stabil.

Das ist doch Affentheather.

Ich seh den gleichen Trend aber auch bei GPUs. Ja die 4090 ist effizienter als meine 3080 aber die brachiale Rechenleistung für 4K 120Hz wird nur durch einen starken Energieverbrauch realisiert. Ich werd immer dafür belächelt, dass ich im 60Hz camp sitz aber um ehrlich zu sein: Wenn GPUs 4K 120Hz+ mit weniger als 300W schaffen, dann bin ich interessiert. Sonst hab ich keine Lust mich bei 450W+ lebendig braten zu lassen. :<

Die Effizienz ist der Pferdefuß.

Ich benötige selbst keine brachiale Grafik weil ich einfach kein Gamer bin, aber wenn ich sehe, das meine 4060ti16 die Gleiche FPS Leistung, teilweise sogar mehr bringt als die vorherige 3070OC, dabei feiner Grafik abliefert, und das bei 165 Watt statt vorher 265Watt, dann zeigt das klar, es geht richtig was in Effizienz.

Das wird sich bei den CPUs allerdings erst 2025 deutlich bemerkbar machen.

Intel gewinnt mit 16. Gen erstmalig an Leistung bei sinkender Energieaufnahme mit der Cougar Cove Architektur, bei AMD wird sich Big Little auch deutlich auf die Leistung auswirken bei guter Effizienz.

Bisher war die Devise einfach, Tuning statt Umdenken, aber das ändert sich

Zuletzt bearbeitet

:

DigitalBlizzard

Urgestein

Hast Du dafür evtl. ne Quelle für mich?

Die Zielrichtung ist ARM Windows Consumer, da wird der konstante Umsatz generiert.

DigitalBlizzard

Urgestein

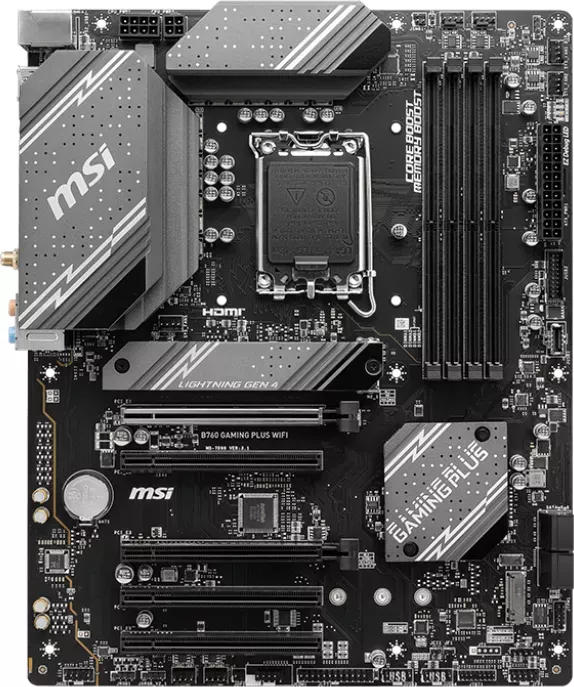

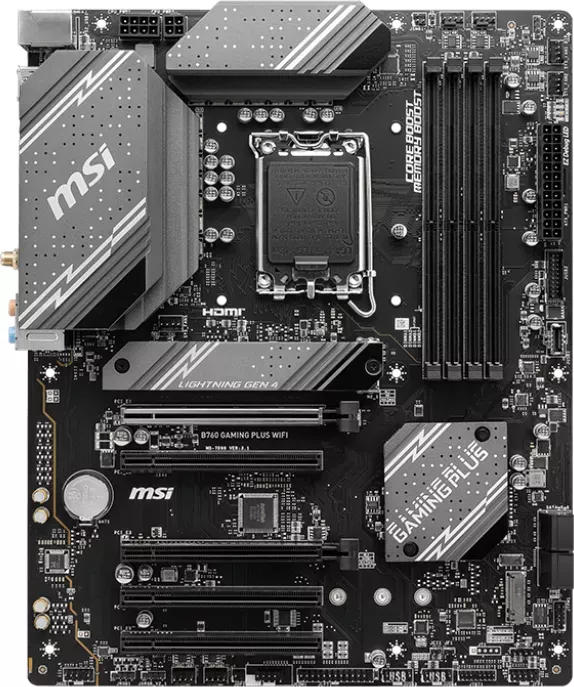

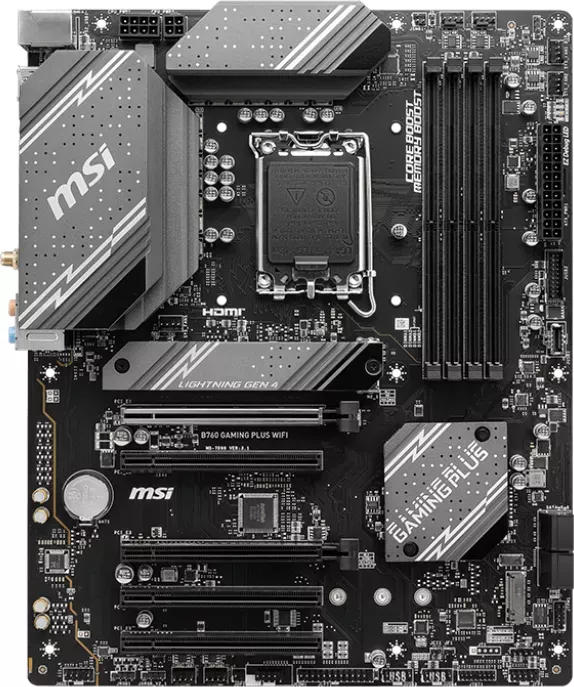

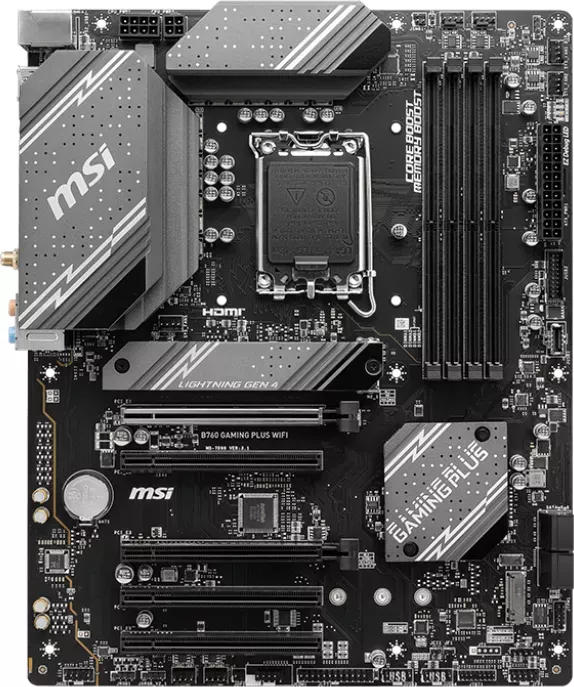

Hab gestern wieder mit erschrecken festgestellt, das kein einziges aktuelle Board eine Bootfunktion für 14. Gen CPUs hat, wer also erstmalig eine 14. Gen kauft und entsprechend ein Board dazu, der muss entweder dem Händler massig Kohle für ein BIOS Update extra zahlen oder eines dieser Boards kaufen, bei denen man das BIOS auch ohne CPU Flashen kann.

geizhals.de

Ansonsten hast eine CPU und ein Board da liegen und es wird nicht mal ins BIOS booten.

geizhals.de

Ansonsten hast eine CPU und ein Board da liegen und es wird nicht mal ins BIOS booten.

Da bringen auch die Online BIOS Updates wie bei ASRock usw nichts, weil diese alle zumindest einen Boot voraussetzen.

Auf gut Deutsch, bei Erstkauf 1700 mit 14. Gen bist gekniffen, entweder beschränkt man sich auf 152 von eigentlich 377 Sockel 1700 Boards, bzw bei 700er Chipsätzen die Einschränkung auf 29 B760 oder 48 Z790 Boards, statt eigentlich mehr als 185 700er Boards, oder man steckt MF und Co direkt 40€ mehr in den Hals um aktuelles BIOS zu bekommen.

Wenn man das weiter Einschränkt und z.B. ITX möchte, dann bleiben ganze 2 700er Boards von Gigabyte übrig, eins in DDR4 eins in DDR5, bist Chipsatzoffen, dann bleiben zumindest 7 Boards, bei mATX ganze 21 davon kein einziges mit Z790, bei ATX jeweils rund 40 in 600er und 700er Zu Chipsatz.

Damit ist der preislich identische 14.Gen nicht nur mit quasi null Mehrwert ausgestattet, sondern bringt auch noch Nachteile mit sich.

Wer schon einen 12. Gen besitzt kann natürlich upgraden, und hat das Problem nicht, sprich 14.Gen richtet sich eigentlich nur an 12.Gen Kunden die ein kleines Upgrade wollen.

Alle Neukunden dürften eher abgeschreckt werden, und ich bin mal gespannt wie die Foren jetzt wieder platzen mit Anfragen " Neue 14.900k gekauft, Rechner bootet nicht".

Wird wieder lustig

Ein entsprechender Hinweis auf den Händlerseiten der 14. Gen CPUs fehlt übrigens überall, da sollte man zumindest einen Hinweis direkt sichtbar setzen.

Das wird wieder ein Spaß

Die Boardhersteller dagegen haben sich abgesichert, da steht bei jedem Board der 1700er Serie im CPU Support " Intel 14. Gen BOOTFÄHIG ab BIOS ....." Und das ist jeweils ein ganz neues BIOS aus dem Oktober 23, also ab Werk zu 99,9% nicht drauf.

Mainboards Intel Sockel 1700 Preisvergleich Geizhals Deutschland

Preisvergleich für Mainboards Intel Sockel 1700 ✓ Bewertungen ✓ Produktinfos ⇒ Auswahl und Filtern der Produkte nach den besten Eigenschaften und dem billigsten Preis

Da bringen auch die Online BIOS Updates wie bei ASRock usw nichts, weil diese alle zumindest einen Boot voraussetzen.

Auf gut Deutsch, bei Erstkauf 1700 mit 14. Gen bist gekniffen, entweder beschränkt man sich auf 152 von eigentlich 377 Sockel 1700 Boards, bzw bei 700er Chipsätzen die Einschränkung auf 29 B760 oder 48 Z790 Boards, statt eigentlich mehr als 185 700er Boards, oder man steckt MF und Co direkt 40€ mehr in den Hals um aktuelles BIOS zu bekommen.

Wenn man das weiter Einschränkt und z.B. ITX möchte, dann bleiben ganze 2 700er Boards von Gigabyte übrig, eins in DDR4 eins in DDR5, bist Chipsatzoffen, dann bleiben zumindest 7 Boards, bei mATX ganze 21 davon kein einziges mit Z790, bei ATX jeweils rund 40 in 600er und 700er Zu Chipsatz.

Damit ist der preislich identische 14.Gen nicht nur mit quasi null Mehrwert ausgestattet, sondern bringt auch noch Nachteile mit sich.

Wer schon einen 12. Gen besitzt kann natürlich upgraden, und hat das Problem nicht, sprich 14.Gen richtet sich eigentlich nur an 12.Gen Kunden die ein kleines Upgrade wollen.

Alle Neukunden dürften eher abgeschreckt werden, und ich bin mal gespannt wie die Foren jetzt wieder platzen mit Anfragen " Neue 14.900k gekauft, Rechner bootet nicht".

Wird wieder lustig

Ein entsprechender Hinweis auf den Händlerseiten der 14. Gen CPUs fehlt übrigens überall, da sollte man zumindest einen Hinweis direkt sichtbar setzen.

Das wird wieder ein Spaß

Die Boardhersteller dagegen haben sich abgesichert, da steht bei jedem Board der 1700er Serie im CPU Support " Intel 14. Gen BOOTFÄHIG ab BIOS ....." Und das ist jeweils ein ganz neues BIOS aus dem Oktober 23, also ab Werk zu 99,9% nicht drauf.

Zuletzt bearbeitet

:

DigitalBlizzard

Urgestein

Ja, Du hast ja sicher gelesen was ich schrieb, nämlich genau das, deswegen habe ich ja die Liste gepostet, von Boards die USB Flash beherrschen, das ist weniger als die Hälfte aller 1700Boards und bei 700er Chipset sogar nur knapp 30% der Boards.Von USB flash hast du aber schon gehört?

Nur 152 von 377 1700 Boards beherrschen USB Flash.

Wenn man also eines 225 anderen Boards kaufst, hast ein Problem

DigitalBlizzard

Urgestein

Nimm mal ein sehr beliebtes Board der Mittelklasse

geizhals.de

geizhals.de

geizhals.de

geizhals.de

geizhals.de

geizhals.de

Geht schon nicht, kein Flashback

MSI B760 ab € 91,12 (2024) | Preisvergleich Geizhals Deutschland

✔ Preisvergleich für MSI B760 ✔ Bewertungen ✔ Produktinfo ⇒ Formfaktor: ATX • Sockel: Intel 1700 • Chipsatz: Intel B760 • CPU-Kompatibilität: Core i-14000 , Core i-1… ✔ Intel Sockel 1700 ✔ Testberichte ✔ Günstig kaufen

MSI B760 ab € 91,12 (2024) | Preisvergleich Geizhals Deutschland

✔ Preisvergleich für MSI B760 ✔ Bewertungen ✔ Produktinfo ⇒ Formfaktor: ATX • Sockel: Intel 1700 • Chipsatz: Intel B760 • CPU-Kompatibilität: Core i-14000 , Core i-1… ✔ Intel Sockel 1700 ✔ Testberichte ✔ Günstig kaufen

ASUS TUF Gaming B760-Plus WIFI ab € 173,89 (2024) | Preisvergleich Geizhals Deutschland

✔ Preisvergleich für ASUS TUF Gaming B760-Plus WIFI ✔ Produktinfo ⇒ Formfaktor: ATX • Sockel: Intel 1700 • Chipsatz: Intel B760 • CPU-Kompatibilität: Core i-14000 , Core i-1… ✔ Intel Sockel 1700 ✔ Testberichte ✔ Günstig kaufen

Geht schon nicht, kein Flashback