@fuchur86

Genau, im Test geht es darum, die Prozessoren von der Leistung und auch mit der Leistungsaufnahme dazu zu testen und je nach Test werden die Prozessoren auch eine Leistungsaufnahme erreichen, die später ggf. nicht anliegen wird. Daher sind solche Tests immer schön anzusehen, was der Prozessor so leisten kann, was dann mit eigenen Anwendungen wieder anders ausfallen wird.

Klar, dieses Vorgehen kannst mit jedem Prozessor übernehmen.

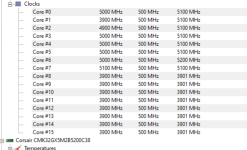

Mein 9900K läuft auch mit 5 GHz auf alle Kerne, trotzdem habe ich auch ein P2 von 241 Watt eingestellt und P1 auf 125 Watt. Bedeutet... der Rechner zieht für 56 Sekunden

bis zu 241 Watt (bedeutet nicht, dass diese Leistungsaufnahme überhaupt erreicht wird!) und geht dann auf 125 Watt runter. Dabei würde der Rechner dann natürlich keine 5 GHz auf alle Kerne mehr halten, denn der muss ja runter takten, damit diese Leistungsaufnahme nicht überschritten wird.

In Games sieht es dann meist so aus:

Anhang anzeigen 15768

Also 96 Watt hat der Prozessor anliegen und hierbei handelt es sich um BF5, was alle Kerne gut auslastet. Spiele nutzen aber nicht immer alle Kerne und so kann ich z.B. Overwatch bei nur noch 50-70 Watt liegen. Nur weil ein Prozessor viele Kerne hat, wird er diese ja nicht immer nutzen. Denn die Software, bzw. die Games bestimmen wie viel Kerne genutzt werden und Overwatch als Beispiel nutzt von mir nicht alle 8 Kerne.