Casi030

Urgestein

- Mitglied seit

- Sep 9, 2019

- Beiträge

- 11.923

- Bewertungspunkte

- 2.339

- Punkte

- 113

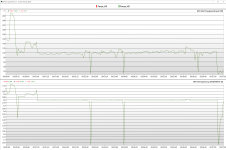

Das Power Limit begrenzt ja nur den Takt und damit kannst sehen wie weit die Spannung im niedrigen Taktbereich durch Änderung der Spannungskurve runter geht.Ja, aber das ist ja nun die Unterkante für diesen Benchmark. Im Alien vs Predator kommt dann das andere Extrem (Verbrauch) - meinst du nicht, dass man am Ende ungefähr da endet, wo das Framelimit (60 FPS) die Karte eingrenzt? Die Frage ist halt echt, ob sich der Aufwand lohnt.

Ich probier das mal aus...

Daten sammeln und auswerten,darum geht es erst mal in diesen Schnellen Benchmarks.

Wenn du dir die Daten in deinen Spielen anschaust und hast dann z.b. Ein Spiel was bei Deinen gewünschten Einstellungen max 280Watt und max 2,3GHz zieht,dann hast dein Min Takt.

Ein anderes Spiel zieht nur 180Watt und geht auf 2,7GHz,dann hast dein max Takt.

Alle anderen Spiele liegen dazwischen.

So kannst jetzt recht schnell über die Beiden Benchmarks die Optimale Spannungskurve finden.

Powerlimit auf 285Watt.

Takt auf 2,725GHz

Über die Spannung im Treiber stellst dir dann mit den 2 Benchmarks die Kurve ein,fertig.

Zur Sicherheit kannst noch Time Spy im Loop laufen lassen.

Demo=Starke Takt und Spannungsschwankungen

Grafiktest1 war mit etwas höherem Takt

Grafiktest2 mit etwas weniger Takt

oder anders rum......

Dadurch das Alien vs Predator recht kurz läuft schlägt es erst bei sehr geringer Spannung an wo Time Spy besonders im Loop dann doch gern mal Abstürzt........Dann musst die Spannung wieder um 10-15mV höher stellen.

EDIT:

Auch hier sind es bei 60FPS wieder min 25Watt weniger , dieses mal in Tom Clancy's The Division 2.

In Beiden Tests wird aber auch wieder am Powerlimit gekratzt.

Wenn du die FPS Begrenzung raus nimmst schaut es dann schon wieder anders aus,da kannst dann besser sehen was die Optimierung bring.

Beide laufen die gesamte Zeit im Powerlimit,aber die 230Watt mit Takt und Spannungsanpassung sind ein Ticken besser,wenn auch nur ein paar Punkte und 1FPS mehr.

Default.

Optimiert.

Zuletzt bearbeitet

: