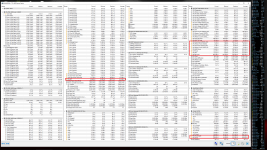

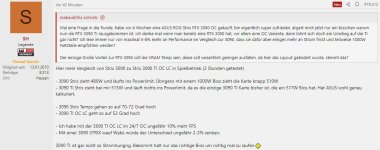

Das alleinige Absenken des Power-Limits ist hier witzlos, vor allem bei dieser Karte. Warum man das überhaupt so gemacht hat, keine Ahnung. Man muss sich einfach mal die RTX A6000 ansehen und begreifen, was NV da anders geplant hat. Der Takt muss manuell runter gesetzt werden, sonst spikt sich die Karte zu Tode. Nicht die Spannungen allein sind das Problem, sondern das verhalten des Arbitrators und von Boost. Wenn ich die Spannungen zu sehr absenke, dann schwankt der Takt wie bekloppt und die Karte wird nicht nur instabil, sondern sie läuft auch unrund. Das zu kompensieren schafft man nicht allein mit dem PL, da muss die Kurve wirklich manuell angepasst werden. Das PL ist ein harter Limiter, der alles runterdrückt, egal, ob es dann optimal ist, oder nicht.