D

Duality

Guest

Tatsächlich hat AMD jetzt in Dead Island 2 das gewohnte niveau nicht mehr 20% hinter der 3080 nur mehr 5% mit dem neuen Treiber. Warum CB testet ohne finalem Treiber.......weiß keiner.

Was stellst du in den Nvidia-Einstellungen schon groß ein, ab und zu GSync ausstellen für Benchmarks und noch schauen, ob RBAR aktiviert ist, sonst mache ich da nix. Das Overlay vielleicht aktivieren in Experience, sonst wird da auch nichts benötigt, den Rest stellt man im Spiel ein, PL über Inno3d Tuneit oder über eine der anderen kleinen Nvidia Apps. Der msi Afterburner ist mit zu aufgeblasen, mit dem Server der ständig im Hintergrund läuft.Freu mich schon auf die DOS-Ansicht, wenn ich die 4080 in Betrieb nehme

Bin natürlich kein insider so wie @Igor Wallossek aber ich könnte mir vorstellen, dass bei AMD irgendwas richtig schief gelaufen ist. Die können doch nicht NVIDIA über n halbes Jahr lang machen lassen was die wollen und sich nen Großteil potentieller Verkäufe abluxxen lassen, weil sie nix gegen die 4070 und 4060ti anzubieten haben. Was is da los?

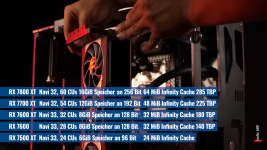

Man passt sich an NVIDIA an.aktuelle Gerüchteküche:

Anhang anzeigen 25143

Meh 7800Xt 285 Watt? Zwischen 3070 und 4070TI? Da sonst 7900Xt Obsolet? Überzeugt mich nicht falls es so kommt.

7700XT = rtx 4070. 12gb? ja ne dann bleib ich bei der 4070. Gib der 7700Xt 16gb

7800 ohne XT wäre interessant oder kommt die erst als refresh, wer weis.

Der Rest schrott 8gb ausschussware.

RX7800XT =RX6950XT nur mit 285Watt.RT um 45-55% schneller.Boah die sollen endlich die 7800xt rausbringen, damit ich die Benchmark Ergebnisse sehen / einschätzen kann, um mir dann endlich ne 7900xt zu holen ^^

Klingt fair für 699,- ..... gerne auch 599,-RX7800XT =RX6950XT nur mit 285Watt.RT um 45-55% schneller.

Für 699,- sollten die kommen wenn die Anfangsphase vorbei ist.Klingt fair für 699,- ..... gerne auch 599,-