Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Internetseiten nicht korrekt angezeigt werden.

Du solltest ein Update durchführen oder einen alternativen Browser verwenden.

Du solltest ein Update durchführen oder einen alternativen Browser verwenden.

Sapphire Radeon RX 7900 GRE Nitro+ 16 GB im Test - Auf der Jagd nach dem goldenen Hasen

- Themenstarter Redaktion

- Beginndatum

RX480

Urgestein

- Mitglied seit

- Feb 13, 2020

- Beiträge

- 1.877

- Bewertungspunkte

- 870

- Punkte

- 114

die Fighter@549€ im MS

@tuftuf meint zu Gears5:

In Gears könnte man auch mal ein extra-Profil nehmen ohne Vram-OCen und ohne Fast-Timing.

(ob außerdem CPU-UVen und scharfe Ram-Timings ebenfalls stören, who knows, ... oft liegts nicht an der Graka allein)

@tuftuf meint zu Gears5:

mit etwas Glück wäre der MBA-Gameclock schon stabiler:Selbst für lächerliche 2200mhz crasht mir 1050mv in dem spiel, das lastet richtig böse aus. Sonst gehen 2200mhz mit 900mv locker

In Gears könnte man auch mal ein extra-Profil nehmen ohne Vram-OCen und ohne Fast-Timing.

(ob außerdem CPU-UVen und scharfe Ram-Timings ebenfalls stören, who knows, ... oft liegts nicht an der Graka allein)

Anhänge

Zuletzt bearbeitet

:

Casi030

Urgestein

- Mitglied seit

- Sep 9, 2019

- Beiträge

- 11.923

- Bewertungspunkte

- 2.338

- Punkte

- 113

Wenn das PL zu hoch ist durch ein OC Bios,dann kommst leider nicht mehr weit genug runter.Warum? Wenn du willst kannst du ja ja zurückfahren wenn man will. Meine Tuf braucht Default 275 Watt, die Puzsle braucht 245 Watt. Unterschied 2300 mhz zu 2550-2600mhz. will ich die Tuf bei 245 Watt betreiben reduziere ich die MHz zu 2250mhz das sind 23-235 ghz genau wie die Pulse und verbauchen auch gleich viel dann.

Ich finde es gut das meine Karte Default schon so hoch taktet ist doch geil. Wo ist das Problem?

Das ist Quatsch, hast du das Selber getestet oder wo gelesen? Ich kann bei meiner 7800XT mit jedem Watt mehr Leistung rausholen, mit maximiertem PL das sind 315 Watt steht es aber an die erreiche ichoft auch nicht egal was ich mache bei 280-300 Watt ist oft schluss. Es gibt spiele die immer die 315 Watt ziehen aber sehr selten und aufwärts 260 Watt stribt die effizienz.

Meinr testerei zufolge hat man mit dem 250 Watt PL am meisten fps pro Watt wenn man eigenhändig optimiert. Ich muss bei der Default Karte nur die MV verringern und verbauche 20 watt weniger bei 5% mehr fps.^^

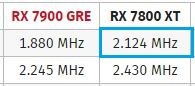

Du kannst die XTX nicht mit den kleinen Vergleichen die großen Karten laufen immer ins Powerlimit die 7800 nicht, daher ist das verhalten sehr unterschiedlich. Die GRE womöglich ist ja ein schlechter 7900 Chip mit 256 anbindung und Vram kastration. Sinnlose Karte meiner Meinung nach. Wurden wohl überproduziert für China und keiner kauft sie weil jeder die 7800 kauft. Deswegen weltweiter release laut meiner these.^^

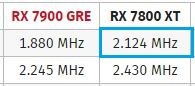

Im Triber habe ich 2714 mhz für 2700mhz vram drin bei der 7800xt. Hynix schafft mehr wie Samsung hier

Ob ich so oder so limitiert bin kommt aufs spiel drauf an aber mit 152 Watt max laufe ich extrem seltens ins Powerlimit. Der Chip kann da einfach nicht mehr. 2.7-29ghz je nach Spiel, außer so hardcore drücker wie Gears 5 da nur knapp 2.7ghz. Also definitiv Takt limit. 3ghz gehen in alten schinken aber das ist wertlos.

RDNA 3 steht bei max 2.9ghz im besten fall an in Spielen. Klar mit Hardcore OC und 1000 Watt bios mag es gehen aber wir reden hier von default Karten. Da ist meine Tuf schon am limit mit der Nitro+ was möglich ist.

Ich kann die Karte auch mit 80 Watt laufen lassen mit der ist alles möglich. Oder 2000mhz mit 170 Watt.das benutze ich in spielen wo es mir egal ist ob 80 oder 90 fps.

Oder 60 FPS Limit + Taktreduzierung ist extrem effizient. Das sind die gleichen Grafik Settings wie weiter oben. Nur halt in nicht maximal sondern 60 fps limit zu 99% halten mit möglichst geringem verbauch. Also gpu 90% auslastung, 10% als puffer. 145-170 Watt. Innenräume gar 100-120 Watt. Übertsrahlt wegen HDR...ignorieren.

Anhang anzeigen 31801

Je höher die Karte Taktet mit nem OC Bios um so schlechter ist die Hinterlegte Spannung nun mal.

Mein Wissen kommt vom Testen,Testberichte oder Foren User kannst vergessen weil die keine Ahnung haben.

Das Standard OC Bios der XFX ist einfach Müll weil der Chip viel zu hoch Taktet mit viel zu viel hinterlegter Spannung.

Damit kannst nicht anständig Optimieren.......

G

Gelöschtes Mitglied 26240

Guest

Gott sei dank ein 4k Video.^^ Sieht man wenigstens was.

Krass die XTX ist bei 2900mhz Default?

Würde für 2077 XESS empfehlen FSR ist nur in der Veriosn 2.1 und sieht nicht so gut aus(sponsored hust hust). Bietet dafür logischweise mehr FPS weil die Ausgangsbasis für auflösungen mit Xess wesentlich höher ist. Deswegen glauben die leute das FSR schlechter ist als XEss kein wunder wenn XESS performance höhere Auflösungen nutz als fsr balanced.

RT in einem nvidia sponsored game, mutig

avatar eignet sich sehr gut als Test. RT, ziemlich schwer und drückt und ist sofort instabil wenn man nicht richtig einstellt. Cyberpunk ist relativ genügsam was mv verringerung betrifft.

JA hast halt 100 mhz geopfert was eh nichts bringt dafür sparts halt gleich mal 50 watt wenn man PL und oder mv reduziert.

Meine 7800 braucht schon weniger Strom wenn ich nur die mv von 1150 auf 1080mv setzt. Bei einer XTX wäre ich mir da nicht so sicher weil einfach auf maximale peformance getrimmt und eigentlich immer Powerlimitiert. Aber Höherer Takt aka gratis perfromance dürften das ergebniss sein.

Daher bei der XTX PL -10% Takt 100-200 mhz weniger einstellen und mv verringern bis es instabil wird.

Krass die XTX ist bei 2900mhz Default?

Würde für 2077 XESS empfehlen FSR ist nur in der Veriosn 2.1 und sieht nicht so gut aus(sponsored hust hust). Bietet dafür logischweise mehr FPS weil die Ausgangsbasis für auflösungen mit Xess wesentlich höher ist. Deswegen glauben die leute das FSR schlechter ist als XEss kein wunder wenn XESS performance höhere Auflösungen nutz als fsr balanced.

RT in einem nvidia sponsored game, mutig

avatar eignet sich sehr gut als Test. RT, ziemlich schwer und drückt und ist sofort instabil wenn man nicht richtig einstellt. Cyberpunk ist relativ genügsam was mv verringerung betrifft.

JA hast halt 100 mhz geopfert was eh nichts bringt dafür sparts halt gleich mal 50 watt wenn man PL und oder mv reduziert.

Meine 7800 braucht schon weniger Strom wenn ich nur die mv von 1150 auf 1080mv setzt. Bei einer XTX wäre ich mir da nicht so sicher weil einfach auf maximale peformance getrimmt und eigentlich immer Powerlimitiert. Aber Höherer Takt aka gratis perfromance dürften das ergebniss sein.

Daher bei der XTX PL -10% Takt 100-200 mhz weniger einstellen und mv verringern bis es instabil wird.

Casi030

Urgestein

- Mitglied seit

- Sep 9, 2019

- Beiträge

- 11.923

- Bewertungspunkte

- 2.338

- Punkte

- 113

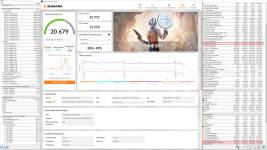

Für die 23K läuft meine XTX z.b. zu 99% mit unter 225Watt der gesamten Karte,1% geht auf 253Watt.Doch wenn du den Takt gleichezeitig dermaßen senkst wie es das gewünschte Leistungsprofil hat, aber ich kann hier nur von meiner 7800 sprechen deine XTX verhält sich bestimmt anders, die hätte ich auch wenn ich es mir leisten könnte^^.

Pulse hat 245 Watt, 2250-2400 mhz max.

Gehe mit meiner tuf auf -10PL bin ich schon bei 250 Watt und welch überraschung sie taktet genau in diesem bereich, der Rest ist Chipgüte.

In CB hat wer ne red devil 7800xt und das Teil ist ein Monster 23k timepsy gpu score lol. Der fährt auch 2450mhz mit 1035mv das schaffe ich niemals egal was für Powerlimit man hat. Die Chipgüte ist auch wichtig.

Ich komme nur auf 22k a bissl mehr und ich wäre in den top 100 er ist unter den besten^^

Habe gelesen mpt soll bald für rdna 3 auch möglich sein, wisst ihr darüber mehr? Weil amd gpu trieber offen legen will oder irgendsowas^^ Das es dann wieder möglich sein soll es zu benutzen. Dann gehtt sicher noch mehr. Wobei ich die 7800xt als ziemlich effizient betrachte. Die 4070 super ist nicht soviel effizienter. Die üblichen 30-50 Watt halt. Aber das ist doch pippifax. Das ist eine alte glühbirne schlimmer.^^

Anhang anzeigen 31805

PL auf deutlich unter 200Watt und die Karte würde die gleichen Punkte haben,geht nur leider nicht.

Wobei der Screen auch schon alt ist sehe ich gerade......0.899V bei unter 2000MHz.

2450MHz mit 1035mV ist schon verdammt heftig,das macht JEDE 7800XT locker mit +-825mV.

Ryzen 3600 steht neben mir und war auch einer der ersten......Womit soll der Takten?Nicht alle. Ich bin jetzt auch kein wisser aber ich weiß wann was limitiert und das reicht auch bei gpus^^.

Nur das halt Chipgüte die Schlampe ist die man nicht kaufen kann^^ die macht nämlch mehr aqus als man denken mag.

Kann sich wer an die launch Ryzen 3600 erinnern? Hast einen 2 jahre später gekauft hat der um ein paar hundert mhz mehr getaktet defualt weil die fertigung einfach besser wurde. Wie das bei Gpus läuft weiß ich aber leider nicht.

Casi030

Urgestein

- Mitglied seit

- Sep 9, 2019

- Beiträge

- 11.923

- Bewertungspunkte

- 2.338

- Punkte

- 113

Ja mit dem beschissenen OC Bios bei über 2,9GHz.Gott sei dank ein 4k Video.^^ Sieht man wenigstens was.

Krass die XTX ist bei 2900mhz Default?

Würde für 2077 XESS empfehlen FSR ist nur in der Veriosn 2.1 und sieht nicht so gut aus(sponsored hust hust). Bietet dafür logischweise mehr FPS weil die Ausgangsbasis für auflösungen mit Xess wesentlich höher ist. Deswegen glauben die leute das FSR schlechter ist als XEss kein wunder wenn XESS performance höhere Auflösungen nutz als fsr balanced.

RT in einem nvidia sponsored game, mutig

avatar eignet sich sehr gut als Test. RT, ziemlich schwer und drückt und ist sofort instabil wenn man nicht richtig einstellt. Cyberpunk ist relativ genügsam was mv verringerung betrifft.

JA hast halt 100 mhz geopfert was eh nichts bringt dafür sparts halt gleich mal 50 watt wenn man PL und oder mv reduziert.

Meine 7800 braucht schon weniger Strom wenn ich nur die mv von 1150 auf 1080mv setzt. Bei einer XTX wäre ich mir da nicht so sicher weil einfach auf maximale peformance getrimmt und eigentlich immer Powerlimitiert. Aber Höherer Takt aka gratis perfromance dürften das ergebniss sein.

Daher bei der XTX PL -10% Takt 100-200 mhz weniger einstellen und mv verringern bis es instabil wird.

XESS liefert weniger FPS dadurch und ja Nebel ist da deutlich besser mit.

Die Grundeinstellungen sind alle vorhanden

G

Gelöschtes Mitglied 26240

Guest

Nein ich meinte im treibersetting mir ist klar das die realen mv weit unter dem liegen. Aber wenn ichn das so einstelle crasht es auf der stelle.2450MHz mit 1035mV ist schon verdammt heftig,das macht JEDE 7800XT locker mit +-825mV.

Es ist auch ein unterschied ob man nur die Gpu Watt messt oder den gesamten Pc. Das sich andere komponenten auch anders verhalten wenn die Gpu weniger braucht, if that makes sense.^^

Glaube das MCM design in der ersten Gen fehlt es einfach noch am feinschliff gerade bei den big boys. Logisch es sind mehrere kleine chips das muss irgendwie versorgt werden. Auch ryzen ist deswegen im teillastbereich ineffizienter als intel das liegt nur an dem das intel monolithisch ist, zumindest noch.

Mit 225 watt schaffe ich gerade so 20k.

At release 3.9h-4ghz später easy 4.4ghz alles default.Womit soll der Takten?

Vega 56 custom release default 1300-1450mhz

Habe eine red dragon gekauft war einer der letzten vegas die man kaufen konnte 229€ machte, 1650-1700mhz default.

Selbes spiel selbes ergebnis. Nvidia haut gleich raus was man bekommt bekommt man.

Siehe launch amd rx 7800xt reviews 4070 level.

Heute ziehe ich das Teil oft um 20% und mehr ab in 2160p

Wäre zwar vermutlich besser für amd wenn die teile auch so releasen also mit voller power aber so kann man sich noch freuen das immer wieder was draufkommt^^ wenn man neue spielebenchmarks sieht

Casi030

Urgestein

- Mitglied seit

- Sep 9, 2019

- Beiträge

- 11.923

- Bewertungspunkte

- 2.338

- Punkte

- 113

Ist doch logisch weil je nach Bios die Chips auch andere hinterlegte Spannungen haben.Nein ich meinte im treibersetting mir ist klar das die realen mv weit unter dem liegen. Aber wenn ich das so einstelle crasht es auf der stelle.

Der OC Chip hat bei 2,7GHz z.b. 1V hinterlegt,somit stellst im Treiber die 1035 ein.

Der nicht OC hat bei 2,7GHz z.b. 950mV hinterlegt,somit musst für die Identische Reale Spannung nun mal 1075 im Treiber einstellen.

Mein 3600 der ersten Stunde lief schon immer mit rund 4,2GHz+.At release 3.9h-4ghz später easy 4.4ghz alles default.

G

Gelöschtes Mitglied 26240

Guest

Consumer gpus werden nicht gebinnt oder? das wäre doch sauteuer kingpin hof lässt grüßen^^OC Chip

mit default kühler? dann hast du einen guten chip erwischt der ersten gen. trotzdem sind die nachkame viel bsser sogar die schlechten sind besser als die besten alten. Ist doch supi wenn man ein besseres produkt billiger bekommt weil die fertigunf sich soweit bessert.Mein 3600 der ersten Stunde lief schon immer mit rund 4,2GHz+.

Launchkäufer sind immer die gearschten.

Kauf eine nvidja gpu zu launch für was? kommt eh eine billigere super version 1 jahr später.^^ Würde nur mehr von super version zu super version gehen bei nvidia, verarschen können die wenn anderen.

Amd gpu @ launch für was? 1 jahr später vielll billiger und schneller wegen treiber noprimierungen. 460€ zu 600+ in meinem fall + einer der besten customs.

ryzen @ launch für was zahlst das doppelte wie nach 1 jahr.

RX480

Urgestein

- Mitglied seit

- Feb 13, 2020

- Beiträge

- 1.877

- Bewertungspunkte

- 870

- Punkte

- 114

btw.

Der Gears5-Benchmark@UVen+Vram-OCen war glaube immer zickiger bei mir als das Spiel selbst.

und

Das neuere Hivebusters-AddOn ist vllt. nen Versuch wert, ... k.A. ob da automatisch auch die Engine vom Gears5-Original mit gepatched wird.

Der Gears5-Benchmark@UVen+Vram-OCen war glaube immer zickiger bei mir als das Spiel selbst.

und

Das neuere Hivebusters-AddOn ist vllt. nen Versuch wert, ... k.A. ob da automatisch auch die Engine vom Gears5-Original mit gepatched wird.

Anhänge

Casi030

Urgestein

- Mitglied seit

- Sep 9, 2019

- Beiträge

- 11.923

- Bewertungspunkte

- 2.338

- Punkte

- 113

Müssen doch nicht,die Spannung wird doch im Bios hinterlegt wie es im MPT auch gemacht wird.Consumer gpus werden nicht gebinnt oder? das wäre doch sauteuer kingpin hof lässt grüßen^^

Das kannst auch sehen wenn du die untere Spannungslinie verwendest.

Auf dem 3600er hatte ich bei Mir immer Wasserkühler drauf.mit default kühler? dann hast du einen guten chip erwischt der ersten gen. trotzdem sind die nachkame viel bsser sogar die schlechten sind besser als die besten alten. Ist doch supi wenn man ein besseres produkt billiger bekommt weil die fertigunf sich soweit bessert.

Launchkäufer sind immer die gearschten.

Kauf eine nvidja gpu zu launch für was? kommt eh eine billigere super version 1 jahr später.^^ Würde nur mehr von super version zu super version gehen bei nvidia, verarschen können die wenn anderen.

Amd gpu @ launch für was? 1 jahr später vielll billiger und schneller wegen treiber noprimierungen. 460€ zu 600+ in meinem fall + einer der besten customs.

ryzen @ launch für was zahlst das doppelte wie nach 1 jahr.

Aktuell hat der jetzt den drauf.

Ich bin mir nicht sicher ob ich damit mal Kühler getestet hatte.

Arctic Freezer 33 eSports ONE grün | Preisvergleich Geizhals Deutschland

✔ Preisvergleich für Arctic Freezer 33 eSports ONE grün ✔ Produktinfo ⇒ Bauart: Tower-Kühler • Abmessungen mit Lüfter: 123x150x88mm (BxHxT) • Lüfter: 1x 120x120x25mm, 200-1800rp… ✔ CPU-Kühler ✔ Testberichte ✔ Günstig kaufen

Das stimmt,nur willst mit Testen,musst recht früh kaufen.

Das die Reale Spannung immer niedriger ist als die Spannungskurve im Treiber stimmt auch nicht.

Betreibst dein Chip in der Ersten Spannungslinie die fest hinterlegt ist schaut es genau anders rum aus.

Im Treiber 700,damit ist die Spannungskurve im Treiber unwirksam und die Karte läuft nach vorgegebener Spannung.

Real liegen dann 780mV an.

Auch verbraucht die gesamte Karte im 3D Mark Test zu 96% rund 170-175Watt,3% um 180Watt und nur 1% geht auf die 290Watt hoch.

Die Neusten Treiber brauch Ich nicht,besonders zum Jahreswechsel sind dann gern mal alle Profile wieder weg.

Casi030

Urgestein

- Mitglied seit

- Sep 9, 2019

- Beiträge

- 11.923

- Bewertungspunkte

- 2.338

- Punkte

- 113

Braucht die GRE echt schon so viel Spannung?btw.

Der Gears5-Benchmark@UVen+Vram-OCen war glaube immer zickiger bei mir als das Spiel selbst.

und

Das neuere Hivebusters-AddOn ist vllt. nen Versuch wert, ... k.A. ob da automatisch auch die Engine vom Gears5-Original mit gepatched wird.

Hattest jetzt eigentlich schon mal die Spannungslinie getestet?

G

Gelöschtes Mitglied 26240

Guest

Gears 5 ist heavy egal wo ich zocke es gerade und als Stabilitätsest von den unreal engine göttern the coalition, ist es ideal(PS. die haben auch gesagt das die UE5 noch lange nicht soweit ist deswegen laufen alle ue5 games so kacke). Cyberpunk ist nichts dagegen.

Spielst du das echt mit afmf? Ich komme damit nicht zurecht weil es sich nicht gut anfühlt und wenn du die kamere gleichmässig schwenkst sieht man wie unsmooth das Bild ist. Da habe ich lieber die hälfte an fps aber dafür real smooth nicht fake gestottere. Aber bin da auch sensible offenbar^^

Aber gears 5 ist neben days gone das bestoptimierte ue spiel am markt. Die wissen was sie tun deswegen braucht gears 6 solange. Die testen erst die engine durch bevor sie sich an das Game machen wobei das natürlich schon jahre her ist. freu mich drauf. Sonst sehe ich schwarz mit dem gestotter ue.

freu mich drauf. Sonst sehe ich schwarz mit dem gestotter ue.

Die engine ist nicht gemacht für große welten. Das gestottere kann man wegoptimieren aber es braucht unglaublich viel zeit und dadurch auch geld deswegen spart man sich das. Weil die Gamer eh jeden mist kaufen.

Die engine wurde gemacht für arena shooter.....

Vorgestern durchgezockt. in 2160p ein Traum, Optik der Wahnsinn. 80-90 fps average läuft.Das neuere Hivebusters-AddOn ist vllt. nen Versuch wert,

Spielst du das echt mit afmf? Ich komme damit nicht zurecht weil es sich nicht gut anfühlt und wenn du die kamere gleichmässig schwenkst sieht man wie unsmooth das Bild ist. Da habe ich lieber die hälfte an fps aber dafür real smooth nicht fake gestottere. Aber bin da auch sensible offenbar^^

Aber gears 5 ist neben days gone das bestoptimierte ue spiel am markt. Die wissen was sie tun deswegen braucht gears 6 solange. Die testen erst die engine durch bevor sie sich an das Game machen wobei das natürlich schon jahre her ist.

Die engine ist nicht gemacht für große welten. Das gestottere kann man wegoptimieren aber es braucht unglaublich viel zeit und dadurch auch geld deswegen spart man sich das. Weil die Gamer eh jeden mist kaufen.

Die engine wurde gemacht für arena shooter.....

Zuletzt bearbeitet von einem Moderator

:

G

Gelöschtes Mitglied 26240

Guest

das erklärt es. ^^Auf dem 3600er hatte ich bei Mir immer Wasserkühler drauf.

das ist mir jetzt zu hoch also habe ich keine meinung dazu^^ solange ich meine cpu und gpu nach obenhin und unten hin optimieren kann bin ich zufrieden. Ram timings geteste war mir schon zu öde. also xmp and call it a day.^^Müssen doch nicht,die Spannung wird doch im Bios hinterlegt wie es im MPT auch gemacht wird.

Das kannst auch sehen wenn du die untere Spannungslinie verwendest.

Der Vorteil wenn man nicht soviel Geld hat.Das stimmt,nur willst mit Testen,musst recht früh kaufen.

Rdna 3 ist da sowieso ein bisserl komisch denke das ist dem multi chip design geschuldet. Aber amd wird sich schon was gedacht haben warum sie es so locken.Das die Reale Spannung immer niedriger ist als die Spannungskurve im Treiber stimmt auch nicht.

Betreibst dein Chip in der Ersten Spannungslinie die fest hinterlegt ist schaut es genau anders rum aus.

Im Treiber 700,damit ist die Spannungskurve im Treiber unwirksam und die Karte läuft nach vorgegebener Spannung.

Real liegen dann 780mV an.

Auch verbraucht die gesamte Karte im 3D Mark Test zu 96% rund 170-175Watt,3% um 180Watt und nur 1% geht auf die 290Watt hoch.

Die Neusten Treiber brauch Ich nicht,besonders zum Jahreswechsel sind dann gern mal alle Profile wieder weg.

Bei den 3d cpus hieß es weil der cache das nicht mitmacht daher gelocked. Oder um nicht zen 4 das wasser abzugraben mit einem zen 3 3d chip...wer weiß die Wahrheit liegt wohl in der Mitte. Bei Rdna 3 ergibt es aber keinen sinn außer wirklich vor schäden zu schützen usw. und oder weil es schlicht nicht möglich ist. Dann lieber stabil dafür saufen halt mehr.

So durstig sind sie eh nicht typische gen to gen weiterentwiklung. Nvidia hat halt gut draufgelegt weil sie von samsung 10nm auf 5nm runter sind.

Amd nur teilweise 5nm.

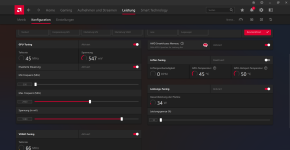

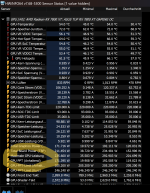

Was ist eiegntlich das Maximale Gpu Leistung? Hier ist mein alltagsprofil am laufen bei ark ascended. 250 Watt Limit. Ist das max power die spitzen von die Igor in der Netzteilberatung immer spricht? Was ist auch der front end takt? fast 3ghz? dabei habe ich ingame 2550-2650mhz

G

Gelöschtes Mitglied 26240

Guest

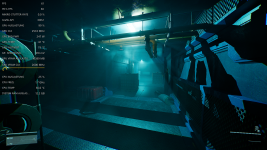

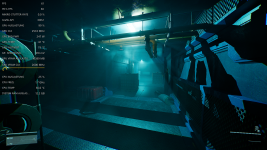

Level Zero Extraction UE5 inklusive Lumen und SSGI, A Symetrischer Multiplayer. Bin im closed Beta Test aber keine Upscaler. Vorhanden nur TSR zumidnest denke ich das es das ist.

Haut gut rein die 4090 dürfte 60 fps knapp verfehlen bei 100% render scale^^ ich habe es nur mit res scale auf 50% geschafft aber TSR siegt sehr gut aus

Haut gut rein die 4090 dürfte 60 fps knapp verfehlen bei 100% render scale^^ ich habe es nur mit res scale auf 50% geschafft aber TSR siegt sehr gut aus

RX480

Urgestein

- Mitglied seit

- Feb 13, 2020

- Beiträge

- 1.877

- Bewertungspunkte

- 870

- Punkte

- 114

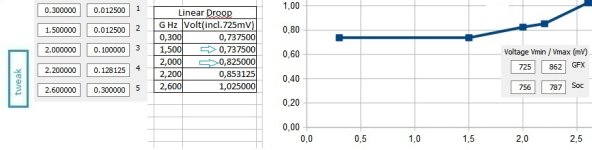

k.A. wieviel ne GRE brauchtBraucht die GRE echt schon so viel Spannung?

bei mir das ist immer noch die 6800nonXT

die angezeigte Spannung ist sogar falsch, = maxGFX im MPT-Setting, real eher so 845mV für den Takt

Anhänge

G

Gelöschtes Mitglied 26240

Guest

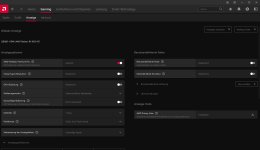

@Casi030Meinst du das ? Das hätte ich dir auch ohne Foto sagen können ^^ bin auf 1080mv rauf weil gears 5 sonst abkackt wegen 20 watt habe ich keinen bock rumzutwerken Anhang anzeigen 31818

waitingg.......

Casi030

Urgestein

- Mitglied seit

- Sep 9, 2019

- Beiträge

- 11.923

- Bewertungspunkte

- 2.338

- Punkte

- 113

Dem 3600 war und ist das egal ob mit Wasser oder Luft,der taktet immer gleich.das erklärt es. ^^

das ist mir jetzt zu hoch also habe ich keine meinung dazu^^ solange ich meine cpu und gpu nach obenhin und unten hin optimieren kann bin ich zufrieden. Ram timings geteste war mir schon zu öde. also xmp and call it a day.^^

Der Vorteil wenn man nicht soviel Geld hat.

Rdna 3 ist da sowieso ein bisserl komisch denke das ist dem multi chip design geschuldet. Aber amd wird sich schon was gedacht haben warum sie es so locken.

Bei den 3d cpus hieß es weil der cache das nicht mitmacht daher gelocked. Oder um nicht zen 4 das wasser abzugraben mit einem zen 3 3d chip...wer weiß die Wahrheit liegt wohl in der Mitte. Bei Rdna 3 ergibt es aber keinen sinn außer wirklich vor schäden zu schützen usw. und oder weil es schlicht nicht möglich ist. Dann lieber stabil dafür saufen halt mehr.

So durstig sind sie eh nicht typische gen to gen weiterentwiklung. Nvidia hat halt gut draufgelegt weil sie von samsung 10nm auf 5nm runter sind.

Amd nur teilweise 5nm.

Was ist eiegntlich das Maximale Gpu Leistung? Hier ist mein alltagsprofil am laufen bei ark ascended. 250 Watt Limit. Ist das max power die spitzen von die Igor in der Netzteilberatung immer spricht? Was ist auch der front end takt? fast 3ghz? dabei habe ich ingame 2550-2650mhz

Anhang anzeigen 31816

Man muss sich beim Optimieren auch mit AMD befassen,Daten sammeln,lernen und die richtige HW haben.

Naja du kannst auch mit wenig Geld Aktuell sein wenn du Testen willst.

Da hab ich noch nix zu gefunden......Der interessanteste von allen AM5.

AMD Ryzen 5 8500G, 2C+4c/12T, 3.50-5.00GHz, boxed ab € 178,39 (2024) | Preisvergleich Geizhals Deutschland

✔ Preisvergleich für AMD Ryzen 5 8500G, 2C+4c/12T, 3.50-5.00GHz, boxed ✔ Bewertungen ✔ Produktinfo ⇒ Kerne: 6 (2C+4c) • Threads: 12 (4+8) • Turbotakt: 5.00GHz (Zen 4), 3.70GHz (Zen 4c) • Basistakt: 3.50GHz … ✔ AMD ✔ Testberichte ✔ Günstig kaufen

RDNA3 ist nicht komisch,ist fast wie RDNA2 besonders vom Treiber her.

HWinfo64 ändert sich ständig,die Max GPU Leistung sehe Ich mittlerweile auch als Anzeige für die Spannungsspitzen an,das wird zwar nicht wie bei Igor erfasst,aber grob ist besser als garnix.Bei meinem Netzteil wird das z.b. auch nicht erfasst.

Der Front End Takt ist wie bei den AMD CPUs der Effektive Takt,das ist der Takt womit die Grafikkarte oder die CPU wirklich Taktet/Rechnet.

Womit man zu deinem Screen kommt.Du hast 2,9GHz im Treiber eingestellt,dein Spieletakt liegt bei 2550-2650MHz,nur irgend wann beim Laden,wenn das Spiel anfängt...........schießt die Karte in den Turbotakt und so kommen die 3GHz zustande.

Deswegen läuft deine Karte auch so schlecht,weil der Treibertakt viel zu hoch ist.

Meinst du das ? Das hätte ich dir auch ohne Foto sagen können ^^ bin auf 1080mv rauf weil gears 5 sonst abkackt wegen 20 watt habe ich keinen bock rumzutwerken Anhang anzeigen 31818

Wenn du im Spiel um die 2,6GHz hast,dann solltest auch nur MAX 2,6GHz einstellen im Treiber.Mit der Spannungskurve musst dann logischerweise bei rund 1125 anfangen und dich dann runter arbeiten.Durch den hohen Treibertakt von 2,9GHz und Turbo bis über 3GHz ist es logisch das die Spannung so hoch sein muss.

Level Zero Extraction UE5 hat im Screen um 2,53GHz bei 0,918V.

Stellst jetzt im Treiber die 2,6GHz ein bei 1125,dann schaust wie hoch die Spannung wieder an deiner Screenstelle ist,ist sie höher gehst immer weiter runter mit der Spannungskurve.

Dadurch das die GPU jetzt nur noch bis MAX 2,8GHz Takten kann,dürfte die Spannung sogar weiter runter gehen weil du noch nicht in dem Bereich landest wo der Chip deutlich mehr Spannung braucht und dir untenrum die Spannung versaut.

Gut möglich das du am Ende bei rund 2,7GHz landest mit 910-920mV.