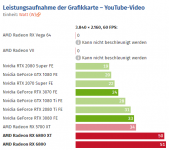

Laut Computerbase zieht die GPU beim Schauen von YouTube Videos alleine schon 50W,

Die Tests kannst bei solchen Angaben eh meistens vergessen. Die haben da ein 1500W Netzteil dran hängen, was diese Werte schon mal Ad Absurdum führt. Nebenbei haben die je nach Redakteur nicht selten auch mal ein "Geschmäckle".

Erinnert mich gerade daran, wie z.B. damals das Digifanless 550 Netzteil "kaputt geschrieben" worden ist. Das zieht sich bei denen oft wie ein roter Faden.

Rechnen wir mal:

Cpu-Lastspitzen im 10 ms Bereich = ca 200 Watt

GPU Lastspitzen 400 Watt

= 600 Watt

+ das Gedöns 60 Watt

——————————

660 Watt

Finde ich jetzt mal ein bisschen hoch kalkuliert. Insbesondere Mainboard, SSD Lüfter etc.

Wenn man das ganze noch frisiert OK, könnte man vielleicht so Rechnen, wenn das auf X570 Basis wäre.

Ich lote meine Sachen da etwas feiner aus.

Ist aber auch persönliche Geschmackssache.

@Igor Wallossek

Wäre es eigentlich nicht mal ein schönes Bauprojekt den Spannungsspitzen der Grakas mittels zwischengeschalteter Elkos den Zahn zu ziehen?

Oft sind es doch nur wirklich kurze Spitzenpegel. Könnte man die damit nicht wegpuffern?

Ich frage, weil ich ungern in der näheren Zukunft (wenn ich Pech habe) mein Digifanless weg schmeißen möchte. Das ist zwar ein verkapptes ~650W Netzteil, könnte in Zukunft mit einer 6800XT und anderer CPU aber evtl. durchaus mal knapp werden.

Ich könnte mir das, wenn Du keine Zeit und oder Lust hast zuviel Zeit da rein zu stecken zumindest teilweise, falls das irgendwie realistisch ist, auch in irgendeiner Form als Community Projekt vorstellen, sofern überhaupt techn. machbar. Nicht weil es unbedingt sehr viel Sinn macht, sondern weil man es (vielleicht) machen kann!

Die techn. Auslegung von dir, Platinendesign zum Ätzen meinetwegen von jmd anderem, der das auch kann. Gehäuse zum ausdrucken wiederum von anderen?

Und Du mit hoheitlichem Blick über das Ganze, damit sich niemand damit umbringen kann.

Nur mal so als Idee.

Jetzt in der Coronazeit ist man ja eh die meiste Zeit zuhause eingesperrt.

Wenn das Unrealistisch ist, oder gab es das gar schon mal?, dann bitte auch sofort den Zahn ziehen.

Kurz und Schmerzlos