Jesus, scheint ja eine hitzige Debatte zu werden. Dies ist kein persönlich Angriff auf die Qualität des Artikels, nur mein fehlenden Verständnis. Muss ehrlicherweise zugeben, DLSS halte ich für Unfug und habe mich darum nur sehr oberflächlich damit beschäftigt.

Vielleicht schaffen wir es der Reihe nach ohne uns anzugreifen?

Für einen fairen Vergleich (egal ob DLSS 2.3 oder nativ) müsste doch bei DLSS 3.0 das generierte Frame verwendet werden? Sind wir in dem Punkt einer Meinung?

Wäre nicht genau dies spannend, wenn FG das grosse neue Feature der 4090 ist?

Naja, CB schreib zu den Artefakten:

und weiter

Finde das hat überhaupt nichts mit "alles schlecht reden" zu tun. Ist einfach eine sachliche saubere Einordnung.

DLSS 3.0 ist das falsche Wort, FG kostet Input Lag oder? Laut Nvidia selbst 10ms? Oder verwechsle ich da was?

Habe ich tatsächlich, ist ja auch im anderen Artikel

Mit staunen und Unverständnis stelle ich fest, dass DLSS mit FG sogar die Latenz verringert. Woran liegt das?

Gehe ich dennoch richtig in der Annahme, dass eSport durch FG 10ms dazukommt?

Verstanden! Fake news Propaganda von meiner Seite wird ab sofort eingestellt!

Sorry wenn ich etwas ungehalten reagiert habe. Das Problem ist, dass du dich verallgemeinert ausgedrückt hast.

Ja, man kann auf die Artefakt Hinweisen, CB schreibt doch selbst, dass man diese im Grunde gar nicht wahrnehmen kann. Durch die explizite Darstellung der einzelnen Framebilder bleibt aber bei den meisten Lesern am Ende was hängen?

Oh, DLSS 3 verursacht Artefakte. Also wird wieder in der Welt herum erzählt, dass alles schlecht ist. Ich habe doch selbst einen Bug im Spiel entdeckt. Alle Spiele mit DLSS 3 waren im Beta Stadium und konnten nur via Testzugang überhaupt für uns Tester genutzt werden. Das muss man auch mit betrachten.

Ja, die FG kostet im Vergleich zu DLSS 2.3 mit Reflex on Latenz. Ich schreibe ja auch, dass der Nutzer die Wahl hat. Wenn ich ein eSports Game mit DLSS 2.3 und jenseits der 200 FPS spiele, dann nutzt man nur Reflex (bringt auch nur im GPU limit was) und lässt FG lieber aus.

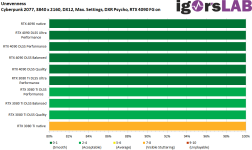

Im heutigen Artikel wird deutlich dass du mit der 4090 und DLSS + FG on quasi die gleichen Latenzen hast wie mit der 3080 Ti DLSS + Reflex und bei der 4090 quasi mit DLSS + FG on die gleichen Latenzen wie mit Reflex off und DLSS 2.3 on. Ausnahme nativ ohne Reflex vs DLSS 3, da bist du besser mit DLSS 3 - sonst gleich. (fast gleich) für ein Story Game ist das kein Problem. eSports is was anderes… das muss ich mir aber alles noch in Ruhe anschauen. Lass mal die Spiele ohne Beta mit DLSS 3 kommen, dann schauen wir nochmal.

Latenzen skalieren grundsätzlich mit den FPS je höher die FPS, desto niedriger die Latenz. Im Detail sind es aber die Frametimes die den Unterschied machen. Je niedriger die Frametime und insbesondere die Varianzen, desto niedriger und vor allem konstanter sind die Latenzen.

Der Mittelwert einer Latenz sagt noch nix über die Konstanz. Dazu benötigt man die Standardabweichung. Die sagt, wie hoch im Grunde die Streuung der Messungen ausfällt.

Beispiel:

30 ms im Schnitt bei einer Standardabweichung von 8ms

oder

30 ms im Schnitt bei einer Standardabweichung von 2ms

Was is wohl besser?

Das alles in einen solchen Artikel zu packen, ist schwierig. Vielleicht mache ich mal einen gesonderten Artikel nur zu dem Thema und erkläre mal, was wirklich hinter den Latenzen und der Statistik steht.

Warum ist mit DLSS 3 jetzt die Latenz dennoch niedriger bzw wird mit steigender FPS niedriger? (Das zeigen auch die Messungen von CB)

Die Antwort steht in meiner Erklärung. Das problem von DLSS 3 ist dennoch einfach erklärt. FG off und nur Upscaling + Reflex im GPU Limit ist: hohe Framerate + niedrigere Frametime und niedrigere Varianzen + Reflex (knoten in der GPU render Pipeline auflösen) = niedrigste Latenz

FG on ist: Spiel engine rendert mit z.B. 100 FPS, die GPU haut jetzt Frames raus, die im Grunde nicht da sind. Somit hast du zwar 200 FPS, aber die Latenz von 100. Reflex kill im Grunde nur die 10 ms + X (je nach Spiel). Deshalb landest du auf dem gleichen Niveau wie Nativ + DLSS ohne Reflex.

Ich muss echt einen Artikel dazu machen… das schein wahrscheinlich doch komplexer zu sein als es eigentlich ist. Oder?

www.nexusmods.com

www.nexusmods.com