E

EnglishMan

Guest

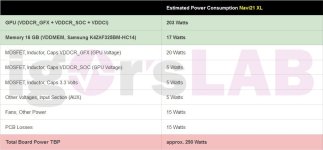

Sandwich, die 12GB wird drunter liegen, die 16 GB wohl drüber. Bilderrahmenprinzip.

Dass AMD die Preise dumpt, ist eine Urban Legend. Wir werden sehen

Die Folien sind auch sicher nicht mit den finalen Versionen gemacht worden

So If a Navi31 is in between 4080 12GB and 4080 16GB this meant that the 7900xt/7950xt will be only +15-25% performance than a 6950xt ? That is a little bit disapointing