Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Internetseiten nicht korrekt angezeigt werden.

Du solltest ein Update durchführen oder einen alternativen Browser verwenden.

Du solltest ein Update durchführen oder einen alternativen Browser verwenden.

Intel Arc A380 6GB im Test: Gunnir Photon samt Benchmarks, Detailanalysen und ausführlichem Teardown

- Themenstarter Redaktion

- Beginndatum

Wenn man bedenkt das sich hier eine 128 Shader Karte (sofern das Technisch auch so stimmt) mit einer 768 Shader Karte anlegt, finde ich das Ergebnis trotzdem SEHR interessant.

Auch WENN mehr Strom verbraten wird : Intel hat es geschaft (trotzt der ganzen Begleitprobleme) aus einer einzigen Shader-Einheit praktisch die 6 Fache Leistung gegenüber AMD (und ähnlichens auch ggü. NVidia) raus zu quetschen. Das ist dann doch auf gewisse Art WEIT Effizienter als alles was bisher am Markt zu haben ist, eben aus diesem einen Blickwinkel.

Wenn sie es schaffen mehr Slices problemlos zusammen laufen zu lassen UND den Strombedarf etwas zu senken ..... könnte das durchaus was mit KOnkurenzfähigem HighEnd werden.

Auch WENN mehr Strom verbraten wird : Intel hat es geschaft (trotzt der ganzen Begleitprobleme) aus einer einzigen Shader-Einheit praktisch die 6 Fache Leistung gegenüber AMD (und ähnlichens auch ggü. NVidia) raus zu quetschen. Das ist dann doch auf gewisse Art WEIT Effizienter als alles was bisher am Markt zu haben ist, eben aus diesem einen Blickwinkel.

Wenn sie es schaffen mehr Slices problemlos zusammen laufen zu lassen UND den Strombedarf etwas zu senken ..... könnte das durchaus was mit KOnkurenzfähigem HighEnd werden.

Nein, es sind 128 Vector Engines und jede Vector Engine besteht aus 8 ALUs/Shader und damit gesamt 1024 Shader.

Und selbst wenns nur 128 wären, wären sie dann absolut riesig und ineffizient, denn der Chip ist am Ende trotzdem 50% größer als Navi24 und nicht einmal teildeaktiviert

Und selbst wenns nur 128 wären, wären sie dann absolut riesig und ineffizient, denn der Chip ist am Ende trotzdem 50% größer als Navi24 und nicht einmal teildeaktiviert

RX480

Urgestein

- Mitglied seit

- Feb 13, 2020

- Beiträge

- 1.877

- Bewertungspunkte

- 871

- Punkte

- 114

Das Einfrieren beim OCen+EintragAutostart ist natürlich böse.

Lässt sich der Inteltreiber net mit DDU im abgesicherten Modus deinstallieren?

Was passiert eigentlich an nem 60 oder 72Hz-Moni mit Vsync?

Kann man mit Triplebuffer die Ruckler glätten?

und

Kann Intel auch mit Freesync umgehen?

Lässt sich der Inteltreiber net mit DDU im abgesicherten Modus deinstallieren?

Was passiert eigentlich an nem 60 oder 72Hz-Moni mit Vsync?

Kann man mit Triplebuffer die Ruckler glätten?

und

Kann Intel auch mit Freesync umgehen?

Zuletzt bearbeitet

:

RawMangoJuli

Veteran

- Mitglied seit

- Aug 21, 2020

- Beiträge

- 253

- Bewertungspunkte

- 146

- Punkte

- 44

Ohje, Witcher 3 scheint auf Arc ja unspielbar zu sein.

Na dann ... will jemand meine A770LE kaufen? xD

Na dann ... will jemand meine A770LE kaufen? xD

ArcusX

Urgestein

- Mitglied seit

- Okt 23, 2019

- Beiträge

- 867

- Bewertungspunkte

- 501

- Punkte

- 94

Natürlich erwarte ich nicht, dass das Produkt AMD und nVidia sofort schlägt. Was ich aber schon erwarte ist ein Produkt, dass erstmal klaglos Standardanwendungen laufen ohne abzustürzen. So mutet das eher einem fortgeschrittenem Prototypendasein an, denn einem fertigen Endprodukt.Habt ihr wirklich erwartet, daß Intel beim ersten ernsthaften Versuch, eine defizierte Grafikkarte mit in den Markt zu werfen, gleich den Versuch unternimmt, sich am oberen Ende der Messlatte gegen AMD und NVidia zu behaupten?

Ich finde das Vorgehen vollkommen nachvollziehbar, daß man sich erstmal mit kleinen Schritten rantastet, und die ersten Modelle eher im Preissegment um 200€ mitspielen sollen.

Da wird auch kein Treiber je was ändern können, auch oder grade weil Intel beim Thema Treiber nun zugegebenermaßen am meisten dazulernen muss.

Wenns man dann irgendwann mal beim vom Alchemisten beim Druiden angekommen ist, und die Dinge dann noch immer so sind, dann kann man berechtigt lästern.

In kleine Schritten herangetastet wäre für micht:

Leistung und FPS/Watt sind noch verbesserbar. Ein paar Features im Treiber fehlen, aber die Karte ist leise und stabil und hat im Videoencoding / -decoding Bereich ein Alleinstellungsmerkmal. Dafür kostet die Karte dann die Summe x, das ist für ein solides Produkt vertretbar.

Hier haben wir Ware die für mich eindeutig noch nicht fertig ist, die aber -wahrscheinlich begründet in den bald kommenden neuen Karten- jetzt unbedingt auf dem Markt muss.

Und so ist das Produkt erstmal nix und wird wahrscheinlich so schnell auch nix, daher Satz mit x.

Kleine-Eule73

Mitglied

Ohjee ohjeee weiß garned wo ich anfangen soll..... Erstmal wieder ein echt super ausführlicher Test der bestimmt sehr viel Zeit und Mühe gekostet hat...Danke dir Igor und deiner Familie Ich muß zugeben das ich nicht alles gelesen habe, aber meine Begeisterung und Spannung ist doch recht schnell verflogen

Ich muß zugeben das ich nicht alles gelesen habe, aber meine Begeisterung und Spannung ist doch recht schnell verflogen Möchte mal gerne wissen was so hochbezahlte Leute im Kopf umhergeht um so einen Elektroschrott zu konzipieren und danach auch noch mit riesigem Tamtam den Müll zu vermarkten. Die verwendeten Chips ect hätten besser investiert werden sollen. In der heutigen Zeit wo alles echt knapp von den Materialien her ist....unbegreiflich. Karten die schon über zig Jahre am Markt sind schlagen so einen Schrott um längen. Aber Intel ist ja nicht ganz allein um so ein Käse zu produzieren...Nvidia und AMD bekleckern sich ja auch nicht grad mit Ruhm was die letzten Karten angeht (Also die kleinen)

Möchte mal gerne wissen was so hochbezahlte Leute im Kopf umhergeht um so einen Elektroschrott zu konzipieren und danach auch noch mit riesigem Tamtam den Müll zu vermarkten. Die verwendeten Chips ect hätten besser investiert werden sollen. In der heutigen Zeit wo alles echt knapp von den Materialien her ist....unbegreiflich. Karten die schon über zig Jahre am Markt sind schlagen so einen Schrott um längen. Aber Intel ist ja nicht ganz allein um so ein Käse zu produzieren...Nvidia und AMD bekleckern sich ja auch nicht grad mit Ruhm was die letzten Karten angeht (Also die kleinen)

eastcoast_pete

Urgestein

- Mitglied seit

- Jun 25, 2020

- Beiträge

- 1.481

- Bewertungspunkte

- 837

- Punkte

- 112

Autsch! Wie erwartet (befürchtet) krankt es sehr bei den Treibern, und ohne die geht's nun nicht, oder nicht so gut. Ich hoffe ja immer noch, daß Intel die vielleicht doch noch soweit hinkriegt, daß die 380 Team Grün und Rot im Einsteiger Bereich etwas Dampf machen kann.

Die im Test von Igor gefundene Unfähigkeit der Karte, passabel und schnell mit Leistungsspitzen umzugehen, ist allerdings noch ein weiterer Grund zur Sorge. Kann sowas in Software/Firmware verbessert werden, oder ist das in der Hardware verbacken?

Zum Thema Treiber Entwicklung: Was hört man denn so von den großen Spiele Studios, bemüht sich Intel da, oder warten die auf Godot? Viele Fragen, auch zu viele Fragen, bei einer Karte die ja schon in Serie gefertigt wird.

Die im Test von Igor gefundene Unfähigkeit der Karte, passabel und schnell mit Leistungsspitzen umzugehen, ist allerdings noch ein weiterer Grund zur Sorge. Kann sowas in Software/Firmware verbessert werden, oder ist das in der Hardware verbacken?

Zum Thema Treiber Entwicklung: Was hört man denn so von den großen Spiele Studios, bemüht sich Intel da, oder warten die auf Godot? Viele Fragen, auch zu viele Fragen, bei einer Karte die ja schon in Serie gefertigt wird.

Zuletzt bearbeitet

:

- Mitglied seit

- Jun 1, 2018

- Beiträge

- 10.204

- Bewertungspunkte

- 18.837

- Punkte

- 114

- Alter

- 59

- Standort

- Labor

Das sind nicht nur die Treiber, lies mal Seite 4. Sieht doch sehr nach broken silicon aus

RX480

Urgestein

- Mitglied seit

- Feb 13, 2020

- Beiträge

- 1.877

- Bewertungspunkte

- 871

- Punkte

- 114

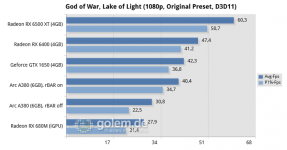

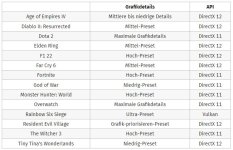

Sichtweise = ist ne reine Frage der Settings, ... aber wenn man zu faul ist Regler zu bedienen, dann ...Nvidia und AMD bekleckern sich ja auch nicht grad mit Ruhm was die letzten Karten angeht (Also die kleinen)

Ob jetzt Low ala Igor oder doch ein mue mehr ala Golem bzw. CB noch passt, ... kann Jeder selbst herausfinden.

(weiss net ob CB auf die 4GB vom Vram bei den RDNA2+GTX Rücksicht genommen hat)

Anhänge

-

[email protected]128,4 KB · Aufrufe : 19

[email protected]128,4 KB · Aufrufe : 19 -

Gamesettings.JPG63,3 KB · Aufrufe : 18

Gamesettings.JPG63,3 KB · Aufrufe : 18

Zuletzt bearbeitet

:

christoph1717

Mitglied

- Mitglied seit

- Aug 20, 2018

- Beiträge

- 39

- Bewertungspunkte

- 10

- Punkte

- 8

Auf dem Bild steht "into the unknow" das wollte ich vermeiden und habe jetzt meine gut 5 Jahre alte geforce 1060 6GB einem Kollegen überlassen und die gerade günstigen GPU Preise genutzt und eine geforce 2060 super 8GB besorgt. Das ist das gegenTeil von unknow - ich wusste genau was ich für mein Geld bekomme und das die Treiber "ganz ok" sind.

Gregor Kacknoob

Urgestein

W.T.F?! Ich kann mir nicht vorstellen, dass das Intel zuzuschreiben ist. Bei aller Hassliebe. Nein!Dieser NOR-Flash wird über das Bus-System angebunden und kann auch mit Inhalten aus dem UEFI des Motherboards gefüllt werden. Das könnte einer der Gründe sein, warum Resizeable Bar stets aktiviert sein muss und auf AMD-Systemen nicht funktioniert, weil man auf Microcode aus dem BIOS angewiesen ist. Es ist natürlich nur eine Vermutung, aber naheliegend.

Auf der anderen Seite ist es schon ulkig, wenn bei dem Gefälle selbst eine 6400 plötzlich wie ein Sportwagen wirkt

Ein bisschen Häme muss sein. Hoffentlich wird Intel der dritte (große) Player im HighEnd-Gaming-GPU Markt. Wirklich!

RedF

Urgestein

Genau das ^^. Eine 6400 schaut so nach nem guten kauf aus.Auf der anderen Seite ist es schon ulkig, wenn bei dem Gefälle selbst eine 6400 plötzlich wie ein Sportwagen wirkt

- Mitglied seit

- Jun 1, 2018

- Beiträge

- 10.204

- Bewertungspunkte

- 18.837

- Punkte

- 114

- Alter

- 59

- Standort

- Labor

Eine bessere Werbung hätte AMD nicht kriegen können

Flutters

Mitglied

- Mitglied seit

- Dez 20, 2020

- Beiträge

- 61

- Bewertungspunkte

- 22

- Punkte

- 8

Wow

Da sieht die RX 6400 aus wie ein Technikwunder.

Habe übrigens eine RX 6400 gekauft da sie wie ich finde die Ideale Diagnose/Notfallkarte ist. Braucht kein Stromanschluss, reinstecken und sehen ob das System Bootet, tolles Teil. Hatte sie schon 2 mal gebraucht. Und zur Überbrückung bis die alte Karte Repariert wird oder die neue Kommt reicht sie

Und wenn ich sehe was Intel braucht um die selbe Leistung zu erzielen, frage ich mich was die RX 6400 leisten könnte wenn sie die 75 Watt ausreizen würde, das wäre ja dann echt Deklassierend.

Da sieht die RX 6400 aus wie ein Technikwunder.

Habe übrigens eine RX 6400 gekauft da sie wie ich finde die Ideale Diagnose/Notfallkarte ist. Braucht kein Stromanschluss, reinstecken und sehen ob das System Bootet, tolles Teil. Hatte sie schon 2 mal gebraucht. Und zur Überbrückung bis die alte Karte Repariert wird oder die neue Kommt reicht sie

Und wenn ich sehe was Intel braucht um die selbe Leistung zu erzielen, frage ich mich was die RX 6400 leisten könnte wenn sie die 75 Watt ausreizen würde, das wäre ja dann echt Deklassierend.

Hmmm... Ein nicht sehr hübscher Hoppelhase mit großem Durst und wackligen Beinen, der sich nicht auf jeder Flur wohl fühlt. Das Ding überhaupt irgendwo auf den Markt zu bringen, verdient den "Balls of Steal"-Award.

- Mitglied seit

- Jun 1, 2018

- Beiträge

- 10.204

- Bewertungspunkte

- 18.837

- Punkte

- 114

- Alter

- 59

- Standort

- Labor

Meine Notfallkarte ist eine passive, low-profile 1030. Vorteil: kein UEFI, läuft ohne extra Anschluss und hat HDMI, DP und DVI. Dabei ist alles

Traurig an der Geschichte ist, dass so die total überteuerten Krüppelkarten von AMD und Nvidia als super toll hingestellt werden und Team red's und green's Arroganz beflügeln.

Und wer glaubt, dass Intel als Dritter im Spiel der lang erwartete Messias sei, täuscht gewaltig, die wollen genauso abkassieren, nur fehlt dazu offensichtlich das Produkt.

Danke für die Mühe für den Test.

Edit: die Namensgebung A380 etc ist Airbus, toll gemacht Intel *fail*.

Und wer glaubt, dass Intel als Dritter im Spiel der lang erwartete Messias sei, täuscht gewaltig, die wollen genauso abkassieren, nur fehlt dazu offensichtlich das Produkt.

Danke für die Mühe für den Test.

Edit: die Namensgebung A380 etc ist Airbus, toll gemacht Intel *fail*.