Das stimmt natürlich, aber selbst auf UHD isoliert betrachtet ist eine 28% Performancesteigerung bei 33% mehr Rohleistung bei so großen Chips eine ziemlich gute Skalierung, für mich spricht da wenig für eine Bandbreitenlimitierung.Naja, es gibt ja auch noch CPU-Limit & Co., das für diese Unterschiede sorgt

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Internetseiten nicht korrekt angezeigt werden.

Du solltest ein Update durchführen oder einen alternativen Browser verwenden.

Du solltest ein Update durchführen oder einen alternativen Browser verwenden.

News Die GeForce RTX 3080 Ti kommt später, die RTX 3060 eher und die GTX 1060 3GB bekommt eine beschnittene Nachfolgerin | Exklusiv

- Themenstarter Igor Wallossek

- Beginndatum

Einerseits sagst du, dass das doch nichts mit Ampere zu tun haben muss, bzw. dass man Ampere bei einer derartigen Betrachtung rauslassen sollte; im quasi gleichem Atemzug sagst du jedoch, dass "solange man nicht weiß, wie gut/schlecht Ampere mit der Auflösung skaliert ..."

Du solltest dich schon entscheiden ... und da fragst du dich bei dieser Art der Argumentation, warum ich hier u. U. eine andere Motivation hinter deiner Forderung eines "Vergleichsverbots" vermute?

... und da fragst du dich bei dieser Art der Argumentation, warum ich hier u. U. eine andere Motivation hinter deiner Forderung eines "Vergleichsverbots" vermute?

Wie schon erklärt kann man das selbstredend und vollkommen legitim vergleichen. Darüber hinaus würde ich dir auch einen Logikfehler unterstellen, denn welche überraschenden Erkenntnisse erwartest du bei einem Vergleich innerhalb der gleichen Architektur? Wie ich dir schon dargelegt habe, verhalten sich die RX 6800 XT und 6900 XT beide in der gleichen Art (relativ zu Ampere) was auch nicht vewundern sollte, denn es sind beides RDNA2-Architekturen, die auf exakt dem gleichen Chipdesign basieren, lediglich mit ein paar deaktivierten CUs (und damit TMUs, ROPs, etc.) aber mit dem gleichen GDDR/IC-Design., also verhalten die sich naheliegenderweise auch sehr ähnlich.

Ich habe eher den Eindruck, dass du hier irgendwie (völlig unbegründet) zwischen den Zeilen zu lesen versuchst, dass man (oder auch konkret ich) AMD möglicherweise "(design)technisches Versagen" o. Ä. vorwerfen würde und dass du deshalb das Offensichtliche zu verneinen suchst. *). Um das vorweg zu nehmen: Derartige Überlegungen sind absurd. AMD hat (wie nVidia auch) gewisse Designentscheidungen treffen müssen und wie das meiste im Leben sind diese mit einigen Vorteilen, aber auch jeweils mit einigen Nachteilen behaftet und AMD hat sich hier für die Lösung entschieden, die zu der gegeben Zeit und unter ihren gegebenen Umständen für sie (persönlich) die bestmögliche Lösung darstellte, also eine aus ihrer Sicht präferierte Balance zwischen Leistung, Konkurrenzfähigkeit, Entwicklungs- und Fertigungskosten und Profit.

Ich habe den Eindruck du liest hier heraus, als würde ich sagen, dass RDNA2 "schlecht" ist (was immer das auch bei dir in diesem Kontext bedeuten mag) und um dieses Stigmata von AMD fernzuhalten bietest du nun als alternativen Erklärungsansatz an, dass nVidia stattdessen so unglaublich gut und effizient bei kleineren Auflösung ist und hier deshalb "besser" (?) dasteht.

Um eine derartige Sichweise hat sich meine Diskussion jedoch nie gedreht. Ich schaue hier einfach nüchtern auf eine Messserie und dabei fällt eine Besonderheit auf und die Frage ist nun worauf diese zurückzuführen ist und hier ist schlicht das GDDR/IC-Design die plausibelste Erklärung, denn das ist der wesentliche Unterschied und tendenziell könnte RDNA2 gar noch besser dastehen denn während nVidia die CUDA Cores "verbreitert" hat, dafür aber bei einem vergleicbaren Takt zur Vorgeneration geblieben ist, hat AMD die Leistungssteigerung zu einem wesentlichem Teil aus dem höheren Takt gezogen, der jedoch den gesamten Chip mit allen weiteren Funktionseinheiten beschleunigt (ROPs, TMUs, etc.), also sollte sich doch die Frage stellen, warum dieser Vorteil in 4K, zwar nicht verloren, aber zumindest rückläufig sein sollte?

Noch mal als Recap: Die Effizienz eines Caches sinkt mit einer sinkenden Hitrate, d. h. es müssen zunehmend mehr Anfragen auf das dahinterliegende Speichersubsystem weitergeleitet werden, das überlicherweise bandbreitenbeschränkter ist und dieses Vorgehen schlägt zwangsweise zusätzliche Latenzen auf den Prozess auf.

Darüber hinaus: Die Bandbreitenanforderungen der GPUs nehmen mit zunehmender Bildauflösung zu (und nicht etwa ab) ebenso wie sie bspw. mit höheren grafischen Einstellungen zunehmen.

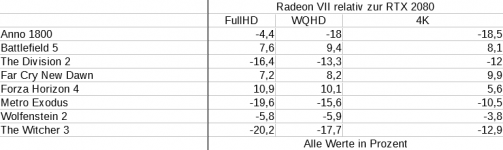

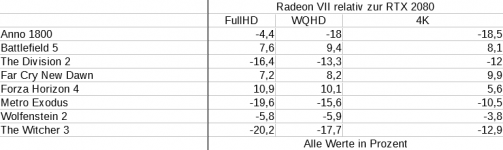

Darüber hinaus als letztes "Angebot" meinerseits ein Blick auf die Radeon VII (Vega 20), die zweifelsfrei nicht Bandbreitenlimitert ist, sondern hier eher durch ihre alte Architektur limitert wird (Vega 10 als Vega 64 musste damals noch mit "gerade mal" 484 GiB/s auskommen ).

).

Zu beachten ist, dass es sich hier um einen etwas älteren PCGH-Benchmark handelt, daher sind die Werte nicht mit den vorausgegangenen vergleichbar, auch wenn einige Titel hier ebenso genutzt werden. Hier treffen diesmal 46 SMs mit 448 GiB/s auf 60 CUs mit 1 TiB/s. Wie zu sehen ist, ist hier dieser Effekt nicht zu beobachten, bzw. im Gegenteil, die Radeon VII gewinnt gar tendenziell leicht hinzu in 4K, was dem mehr als doppelt so durchsatzstarken Speicherinterface zuzuschreiben ist, während jedoch die Vega-Architektur dem Ganzen voraussichtlich leicht entgegenarbeitet, sodass die Karte zu keinem "Turing-Killer" wurde.

Vergleicht man gegen die Titan RTX mit ihren 672 GiB/s bleiben die Leistungsverhältnisse der Radeon über die drei Auflösungen dagegen relativ stabil.

*) Einzig Anno 1800 schlägt hier aus dem Rahmen (in der gleichen Art damals auch bei der RX 5700 XT), was aber auch möglicherweise daran liegen kann, dass das Spiel zu der Zeit noch nicht ausreichend auf AMD optimiert war. Beispielsweise im aktuellen PCGH-Benchmark sieht man hier bspw. eine deutliche Veränderung in dem Titel und die RX 5700 XT und Radeon VII fallen in Auflösungen größer FullHD nicht mehr deutlich stärker zurück, so bspw. i. V. z. einer RTX 2080 Super, d. h. hier hat sich anscheinend einiges an dem Titel über die Zeit geändert (wobei aber auch zu beachten ist, dass der aktuelle Benchmark-Parkour rigoros maxed-out Settings nutzt).

Du solltest dich schon entscheiden

Wie schon erklärt kann man das selbstredend und vollkommen legitim vergleichen. Darüber hinaus würde ich dir auch einen Logikfehler unterstellen, denn welche überraschenden Erkenntnisse erwartest du bei einem Vergleich innerhalb der gleichen Architektur? Wie ich dir schon dargelegt habe, verhalten sich die RX 6800 XT und 6900 XT beide in der gleichen Art (relativ zu Ampere) was auch nicht vewundern sollte, denn es sind beides RDNA2-Architekturen, die auf exakt dem gleichen Chipdesign basieren, lediglich mit ein paar deaktivierten CUs (und damit TMUs, ROPs, etc.) aber mit dem gleichen GDDR/IC-Design., also verhalten die sich naheliegenderweise auch sehr ähnlich.

Ich habe eher den Eindruck, dass du hier irgendwie (völlig unbegründet) zwischen den Zeilen zu lesen versuchst, dass man (oder auch konkret ich) AMD möglicherweise "(design)technisches Versagen" o. Ä. vorwerfen würde und dass du deshalb das Offensichtliche zu verneinen suchst. *). Um das vorweg zu nehmen: Derartige Überlegungen sind absurd. AMD hat (wie nVidia auch) gewisse Designentscheidungen treffen müssen und wie das meiste im Leben sind diese mit einigen Vorteilen, aber auch jeweils mit einigen Nachteilen behaftet und AMD hat sich hier für die Lösung entschieden, die zu der gegeben Zeit und unter ihren gegebenen Umständen für sie (persönlich) die bestmögliche Lösung darstellte, also eine aus ihrer Sicht präferierte Balance zwischen Leistung, Konkurrenzfähigkeit, Entwicklungs- und Fertigungskosten und Profit.

Ich habe den Eindruck du liest hier heraus, als würde ich sagen, dass RDNA2 "schlecht" ist (was immer das auch bei dir in diesem Kontext bedeuten mag) und um dieses Stigmata von AMD fernzuhalten bietest du nun als alternativen Erklärungsansatz an, dass nVidia stattdessen so unglaublich gut und effizient bei kleineren Auflösung ist und hier deshalb "besser" (?) dasteht.

Um eine derartige Sichweise hat sich meine Diskussion jedoch nie gedreht. Ich schaue hier einfach nüchtern auf eine Messserie und dabei fällt eine Besonderheit auf und die Frage ist nun worauf diese zurückzuführen ist und hier ist schlicht das GDDR/IC-Design die plausibelste Erklärung, denn das ist der wesentliche Unterschied und tendenziell könnte RDNA2 gar noch besser dastehen denn während nVidia die CUDA Cores "verbreitert" hat, dafür aber bei einem vergleicbaren Takt zur Vorgeneration geblieben ist, hat AMD die Leistungssteigerung zu einem wesentlichem Teil aus dem höheren Takt gezogen, der jedoch den gesamten Chip mit allen weiteren Funktionseinheiten beschleunigt (ROPs, TMUs, etc.), also sollte sich doch die Frage stellen, warum dieser Vorteil in 4K, zwar nicht verloren, aber zumindest rückläufig sein sollte?

Noch mal als Recap: Die Effizienz eines Caches sinkt mit einer sinkenden Hitrate, d. h. es müssen zunehmend mehr Anfragen auf das dahinterliegende Speichersubsystem weitergeleitet werden, das überlicherweise bandbreitenbeschränkter ist und dieses Vorgehen schlägt zwangsweise zusätzliche Latenzen auf den Prozess auf.

Darüber hinaus: Die Bandbreitenanforderungen der GPUs nehmen mit zunehmender Bildauflösung zu (und nicht etwa ab) ebenso wie sie bspw. mit höheren grafischen Einstellungen zunehmen.

Darüber hinaus als letztes "Angebot" meinerseits ein Blick auf die Radeon VII (Vega 20), die zweifelsfrei nicht Bandbreitenlimitert ist, sondern hier eher durch ihre alte Architektur limitert wird (Vega 10 als Vega 64 musste damals noch mit "gerade mal" 484 GiB/s auskommen

Zu beachten ist, dass es sich hier um einen etwas älteren PCGH-Benchmark handelt, daher sind die Werte nicht mit den vorausgegangenen vergleichbar, auch wenn einige Titel hier ebenso genutzt werden. Hier treffen diesmal 46 SMs mit 448 GiB/s auf 60 CUs mit 1 TiB/s. Wie zu sehen ist, ist hier dieser Effekt nicht zu beobachten, bzw. im Gegenteil, die Radeon VII gewinnt gar tendenziell leicht hinzu in 4K, was dem mehr als doppelt so durchsatzstarken Speicherinterface zuzuschreiben ist, während jedoch die Vega-Architektur dem Ganzen voraussichtlich leicht entgegenarbeitet, sodass die Karte zu keinem "Turing-Killer" wurde.

Vergleicht man gegen die Titan RTX mit ihren 672 GiB/s bleiben die Leistungsverhältnisse der Radeon über die drei Auflösungen dagegen relativ stabil.

*) Einzig Anno 1800 schlägt hier aus dem Rahmen (in der gleichen Art damals auch bei der RX 5700 XT), was aber auch möglicherweise daran liegen kann, dass das Spiel zu der Zeit noch nicht ausreichend auf AMD optimiert war. Beispielsweise im aktuellen PCGH-Benchmark sieht man hier bspw. eine deutliche Veränderung in dem Titel und die RX 5700 XT und Radeon VII fallen in Auflösungen größer FullHD nicht mehr deutlich stärker zurück, so bspw. i. V. z. einer RTX 2080 Super, d. h. hier hat sich anscheinend einiges an dem Titel über die Zeit geändert (wobei aber auch zu beachten ist, dass der aktuelle Benchmark-Parkour rigoros maxed-out Settings nutzt).

HerrRossi

Urgestein

- Mitglied seit

- Jul 25, 2018

- Beiträge

- 6.778

- Bewertungspunkte

- 2.243

- Punkte

- 113

Hat AMD nicht selber schon gesagt, dass sich der Infinity Cache in UHD nicht so besonders gut schlägt? Das würde ja dann bedeuten, dass die Speicherbandbreite für UHD zu gering ist. Kann man da noch etwas mit dem Treiber tunen?

AMD spricht von mehr als 1,6TB/s effektiver Bandbreite bei 4K-Gaming:

In den Endnotes wird der Wert noch erklärt, über die 58% Hitrate in 4K.

Deswegen meine Frage: Wo ist da das Bandbreiten-Bottleneck bzw. ist es wirklich eines? Hat das irgendjemand mal irgendwo gemessen oder gesehen? Gibt es dazu Daten?

NVidia hat bei der 3090 "gerade mal" 936GB/s Bandbreite.

Was ich nicht wissen will, ist, ob NVidia in 4K besser da steht als in niedrigeren Auflösungen. Denn das weiß ich schon seit den Tests, die auch ich mir angeschaut habe.

Aber wieso ist die 4K-Superiority nicht mit NVidias höhere TFLOPS erklärbar?

Deswegen meine Frage: Wo ist da das Bandbreiten-Bottleneck bzw. ist es wirklich eines? Hat das irgendjemand mal irgendwo gemessen oder gesehen? Gibt es dazu Daten?

NVidia hat bei der 3090 "gerade mal" 936GB/s Bandbreite.

Was ich nicht wissen will, ist, ob NVidia in 4K besser da steht als in niedrigeren Auflösungen. Denn das weiß ich schon seit den Tests, die auch ich mir angeschaut habe.

Aber wieso ist die 4K-Superiority nicht mit NVidias höhere TFLOPS erklärbar?

Und wo genau ist hier der Widerspruch wenn man den ganzen Satz liest? Entweder du schaffst es nicht zu verstehen was ich schreibe oder du pickst dir absichtlich nur Bruchteile von Sätzen raus.Einerseits sagst du, dass das doch nichts mit Ampere zu tun haben muss, bzw. dass man Ampere bei einer derartigen Betrachtung rauslassen sollte; im quasi gleichem Atemzug sagst du jedoch, dass "solange man nicht weiß, wie gut/schlecht Ampere mit der Auflösung skaliert ..."

Aber reicht mir hier auch wieder, deine ständigen Vorwürfe, ich würde hier irgendwas verteidigen wollen, gehen mir gehörig gegen den Strich. Wenn du nicht verstehen willst, warum ich den ebenso unbekannten Faktor nVidia bei einer Betrachtung einer möglichen Bandbreitenlimitierung bei AMD außen vor lassen will, dann belassen wir es dabei.

Andy

Veteran

@Capsaicin Wenn ich mal @gerTHW84 zitieren darf:

Die hohe Bandbreite des Infinity Cache hilft dir nichts, wenn dessen Größe in 4k nicht mehr ausreicht. Dann werden die Anfragen auf den normalen Grafikkartenspeicher weitergeleitet, der nur noch eine Bandbreite von 512 GB/s hat, und damit weniger als die Hälfte des IC.Noch mal als Recap: Die Effizienz eines Caches sinkt mit einer sinkenden Hitrate, d. h. es müssen zunehmend mehr Anfragen auf das dahinterliegende Speichersubsystem weitergeleitet werden, das überlicherweise bandbreitenbeschränkter ist und dieses Vorgehen schlägt zwangsweise zusätzliche Latenzen auf den Prozess auf.

Das habe ich schon verstanden. Doch wo ist der Beweis, oder ein Indiz, dass die Bandbreite zum Speicher der Flaschenhals ist? Ist denn der IC wirklich zu klein, oder die gestiegene Latenz zum VRAM tatsächlich kritisch? Meine Vergleiche von der 6900XT zur 6800 und 5700XT geben das nämlich nicht her. Der Vergleich mit NVidia ist meiner Meinung nach nicht ausreichend, weil das auch anders erklärbar ist, wie schon geschrieben.@Capsaicin Wenn ich mal @gerTHW84 zitieren darf:

Die hohe Bandbreite des Infinity Cache hilft dir nichts, wenn dessen Größe in 4k nicht mehr ausreicht. Dann werden die Anfragen auf den normalen Grafikkartenspeicher weitergeleitet, der nur noch eine Bandbreite von 512 GB/s hat, und damit weniger als die Hälfte des IC.

Ich sage ja nicht, dass es nicht so ist, ich kann ja auch Unrecht haben. Es kann aber eben auch anders sein, und dafür habe ich Indizien ja bereits dargelegt.

Andy

Veteran

Dein Vergleich von RDNA2 zu RDNA ist nach deiner Logik aber auch nicht zulässig, da du hier auch zwei verschiedene Architekturen vergleichst

Schlussendlich wird es wohl nur AMD beantworten können woran das liegt.

Schlussendlich wird es wohl nur AMD beantworten können woran das liegt.

@Besterino

Einer der es kapiert hat

Wir wissen letztlich nur, dass RDNA anscheinend laut einigen Messungen mehr FPS bei höheren Auflösungen einbüßt, als Ampere. Über das Warum können wir eigentlich nur mutmaßen.

Btw: Meines Wissens nach hat Computerbase den RAM übertaktet und dabei kaum Leistungsplus erzielt. Das spricht auch gegen die Speicherschnittstelle als Bottleneck.

Einer der es kapiert hat

Wir wissen letztlich nur, dass RDNA anscheinend laut einigen Messungen mehr FPS bei höheren Auflösungen einbüßt, als Ampere. Über das Warum können wir eigentlich nur mutmaßen.

Btw: Meines Wissens nach hat Computerbase den RAM übertaktet und dabei kaum Leistungsplus erzielt. Das spricht auch gegen die Speicherschnittstelle als Bottleneck.

Ich versteh' die Diskussion nicht. AMD hat schon eine Aussage zur Hitrate getroffen: Wenn zum Beispiel die Hitrate nur bei 50% liegt, dann bringt selbst die dickste Bandbreite in 50% der Fälle GENAU ABSOLUT GAR NICHTS.

Es ist also im Ergebnis - wenn denn der Cache überhaupt so krass ausschlaggebend ist (was ich einfach nicht weiß) - vom Grundkonzept VIEL VIEL wichtiger, die Hitrate zu verbessern - ob das nachträglich durch Treiber- oder Bios-Updates geht, keine Ahnung.

Blödes Bild: Was bringt es, eine direkte Monster-Pipeline zur nächstgelegenen Brauerei zu haben, wenn ich doch auf der Suche nach heißem Kaffee bin? Die Brauerei sollte dann zumindest irgendwo heißen Kaffee haben, damit irgendwas für mich Sinnvolles durchkommen kann.

Es ist also im Ergebnis - wenn denn der Cache überhaupt so krass ausschlaggebend ist (was ich einfach nicht weiß) - vom Grundkonzept VIEL VIEL wichtiger, die Hitrate zu verbessern - ob das nachträglich durch Treiber- oder Bios-Updates geht, keine Ahnung.

Blödes Bild: Was bringt es, eine direkte Monster-Pipeline zur nächstgelegenen Brauerei zu haben, wenn ich doch auf der Suche nach heißem Kaffee bin? Die Brauerei sollte dann zumindest irgendwo heißen Kaffee haben, damit irgendwas für mich Sinnvolles durchkommen kann.

Die 3060 könnte mit 12GB doch nicht sinnloser sein, oder?

Die Leistung reicht doch gerade für FullHD in den neuen Spielen. (bspw. Cyberpunk)

Auch die 6700 wird wohl fast nie ihre 12GB brauchen.

Die 3060 12G scheint nur dazu zu dienen die 6700 zu kontern, ob sinnvoll oder nicht.

Meiner Meinung nach macht die 3060 Ti noch am meisten Sinn.

Bin mal gespannt wie die Preisgestaltung der 3060 12G sein soll.

Da müsste man die 3060Ti doch EOL laufen lassen...

Die 3080 20G ist absolut sinnvoll. Der Preis wird sich dann aber sehr wahrscheinlich an der 6900 XT orientieren, plus nVidia-Gebühr...

Die Leistung reicht doch gerade für FullHD in den neuen Spielen. (bspw. Cyberpunk)

Auch die 6700 wird wohl fast nie ihre 12GB brauchen.

Die 3060 12G scheint nur dazu zu dienen die 6700 zu kontern, ob sinnvoll oder nicht.

Meiner Meinung nach macht die 3060 Ti noch am meisten Sinn.

Bin mal gespannt wie die Preisgestaltung der 3060 12G sein soll.

Da müsste man die 3060Ti doch EOL laufen lassen...

Die 3080 20G ist absolut sinnvoll. Der Preis wird sich dann aber sehr wahrscheinlich an der 6900 XT orientieren, plus nVidia-Gebühr...

dampflokfreund

Mitglied

- Mitglied seit

- Apr 29, 2020

- Beiträge

- 10

- Bewertungspunkte

- 6

- Punkte

- 3

Hm, schade dass keine RTX 3050 kommt. Hoffentlich wird dann der Preis der 3060 6 GB deutlich geringer sein.

Habe ja unter anderem auch die 6800 mit der 6900XT verglichen, mit dem gleichen Ergebnis. Davon abgesehen unterscheidet RDNA1 und RDNA2 lange nicht so viel wie RDNA2 und Ampere.Dein Vergleich von RDNA2 zu RDNA ist nach deiner Logik aber auch nicht zulässig, da du hier auch zwei verschiedene Architekturen vergleichst

Danke! Das ist mal ein guter HinweisBtw: Meines Wissens nach hat Computerbase den RAM übertaktet und dabei kaum Leistungsplus erzielt. Das spricht auch gegen die Speicherschnittstelle als Bottleneck.

Schon richtig. Da in der GPU aber vieles parallel läuft (mehrere Tausend Kerne), zählt nicht mehr so sehr der einzelne Zugriff mit Hit oder Miss, sondern mehr die Statistik. Das ist bei allen anderen Caches genauso, weshalb sich selbst ein mini L1 mit geringerer Hitrate lohnt.Ich versteh' die Diskussion nicht. AMD hat schon eine Aussage zur Hitrate getroffen: Wenn zum Beispiel die Hitrate nur bei 50% liegt, dann bringt selbst die dickste Bandbreite in 50% der Fälle GENAU ABSOLUT GAR NICHTS.

Gibt etliche Texturmods, die 6 GB Vram bei 1080p in die Knie schicken. Bei 12 GB kann man sich da austoben. Weiß jetzt nicht, wie viele Spieler so etwas nutzen, sich mit mods und modding beschäftigen, aber als völlig sinnlos würde ich das nicht bezeichnen. Darüber hinaus hat AMD die 5700 XT in einer 16 GB Variante exklusiv an Apple verkauft, es wird sicher auf dem PC einen ähnlichen, wenn nicht sogar größeren Kundenkreis geben, der etwas mit dem VRam anfangen kann. Bisher bot bei nVidia nur die Oberklasse >8GB, was sich nicht jeder leisten kann.Die 3060 könnte mit 12GB doch nicht sinnloser sein, oder?

Die Leistung reicht doch gerade für FullHD in den neuen Spielen. (bspw. Cyberpunk)

Matthias80

Mitglied

- Mitglied seit

- Dez 24, 2018

- Beiträge

- 40

- Bewertungspunkte

- 9

- Punkte

- 8

Geht um das ganze namensschema.völlig

Ne 3060 ti mit 8gb. Jetzt wohl ne 3060 mit 12gb. What?? Langsamer aber mehr vram? Also quasi sinnlos weil ein Spiel was so viel RAM braucht, braucht zukünftig keinen schnellen Chip mehr??

Die 3060 mit 6gb voll i. O.

Wenn ne 3070 ti mit 16gb kommt... Ok.

Ist nur jeder 3080 10gb Käufer verarscht worden. War noch nie das namensschema, kaufzeitpunkt und Leistung so unnsig waren.

Mfg

@Besterino

Das mit dem Cache scheint schon richtig zu sein. Aber daraus gleich den Schluss zu ziehen, dass das Speicherinterface bei 4K das Problem ist, geht ohne weiteres Wissen zu weit.

Das mit dem Cache scheint schon richtig zu sein. Aber daraus gleich den Schluss zu ziehen, dass das Speicherinterface bei 4K das Problem ist, geht ohne weiteres Wissen zu weit.

Erstmal danke für den Artikel - sorgt ja wieder für ordentlich Diskussionsstoff.

Bezogen auf das Ausgangsthema, nämlich welche Gerüchte es über mögliche Zukunftsmodelle gibt:

Wird es auch mal einen Artikel geben, der sich weniger im zukünftigen Konjunktiv bewegt sondern Antworten auf unsere aktuellen Fragen recherchiert, wie z.B.

- Wie ist die aktuelle Situation in Bezug auf Verfügbarkeit und Preisgestaltung?

- Wann wird es FE-Karten im NVidia-Shop zur UVP ganz normal zum kaufen geben?

- Wie ist die Entwicklung bei den Liefermengen? Erhöhen sich die Zahlen endlich mal?

- Die Vorstellung der ersten Karten war Anfang September, der offizielle Verkauf startete Mitte September. Das ist jetz 3 Monate her - was hat sich seitdem getan?

- Wie ist die offizielle Stellungnahme seitens AMD und NVidia zu den optimistisch getroffenen Aussagen zur Verfügbarkeit beim Launch im Verhältnis zur realen Situation?

- Ist die Chipausbeute so scheiße oder eigentlich gut aber die Chips versacken in anderen Kanälen (Mining, Konsolen, Apple...)?

- Wenn die Chipausbeute tatsächlich so mies sein sollte und sich über die letzten Monate auch nicht signifikant verbessert hat, wovon lebt dann eigentlich z.B. NVidia zur Zeit, wenn die täglich nur 'ne Kofferraumladung voll aus dem Werk kriegen?

Bitte nicht falsch verstehen! Anscheinend bin ich der Einzige, der die Schnauze voll hat von zahllosen Artikeln, die sich mit kryptischen Datenbankeinträgen zu frei interpretierbaren Modellbezeichnungen beschäftigen. Oder mit Insiderinformationen von Experten, die von anderen Experten gehört haben, daß irgendein weltbekannter Blogger am Arsch der Welt irgendeinen 3D-Mark gepostet hat, der auf ein Modell hindeuten könnte. Also von daher, gerne mehr davon!

Aber zwischendurch darf gerne auch mal wieder ein Artikel mit echtem, verwertbaren Informationsgehalt eingestreut werden... Danke!

Bezogen auf das Ausgangsthema, nämlich welche Gerüchte es über mögliche Zukunftsmodelle gibt:

Wird es auch mal einen Artikel geben, der sich weniger im zukünftigen Konjunktiv bewegt sondern Antworten auf unsere aktuellen Fragen recherchiert, wie z.B.

- Wie ist die aktuelle Situation in Bezug auf Verfügbarkeit und Preisgestaltung?

- Wann wird es FE-Karten im NVidia-Shop zur UVP ganz normal zum kaufen geben?

- Wie ist die Entwicklung bei den Liefermengen? Erhöhen sich die Zahlen endlich mal?

- Die Vorstellung der ersten Karten war Anfang September, der offizielle Verkauf startete Mitte September. Das ist jetz 3 Monate her - was hat sich seitdem getan?

- Wie ist die offizielle Stellungnahme seitens AMD und NVidia zu den optimistisch getroffenen Aussagen zur Verfügbarkeit beim Launch im Verhältnis zur realen Situation?

- Ist die Chipausbeute so scheiße oder eigentlich gut aber die Chips versacken in anderen Kanälen (Mining, Konsolen, Apple...)?

- Wenn die Chipausbeute tatsächlich so mies sein sollte und sich über die letzten Monate auch nicht signifikant verbessert hat, wovon lebt dann eigentlich z.B. NVidia zur Zeit, wenn die täglich nur 'ne Kofferraumladung voll aus dem Werk kriegen?

Bitte nicht falsch verstehen! Anscheinend bin ich der Einzige, der die Schnauze voll hat von zahllosen Artikeln, die sich mit kryptischen Datenbankeinträgen zu frei interpretierbaren Modellbezeichnungen beschäftigen. Oder mit Insiderinformationen von Experten, die von anderen Experten gehört haben, daß irgendein weltbekannter Blogger am Arsch der Welt irgendeinen 3D-Mark gepostet hat, der auf ein Modell hindeuten könnte. Also von daher, gerne mehr davon!

Aber zwischendurch darf gerne auch mal wieder ein Artikel mit echtem, verwertbaren Informationsgehalt eingestreut werden... Danke!

Zuletzt bearbeitet

:

Korrekt, 6GB machen in der aktuellen Zeit überhaupt keinen Sinn. 8GB sind bei der Architektur nicht möglich.Gibt etliche Texturmods, die 6 GB Vram bei 1080p in die Knie schicken. Bei 12 GB kann man sich da austoben. Weiß jetzt nicht, wie viele Spieler so etwas nutzen, sich mit mods und modding beschäftigen, aber als völlig sinnlos würde ich das nicht bezeichnen. Darüber hinaus hat AMD die 5700 XT in einer 16 GB Variante exklusiv an Apple verkauft, es wird sicher auf dem PC einen ähnlichen, wenn nicht sogar größeren Kundenkreis geben, der etwas mit dem VRam anfangen kann. Bisher bot bei nVidia nur die Oberklasse >8GB, was sich nicht jeder leisten kann.

Für normale Texturmods reichen 8GB. Nur extrem übertriebene Texturen in Verbindung mit 2k/4k fordern manchmal mehr.

Wer solche Ansprüche an Texturqualität hat, holt sich keine 3060. Das sind Enthusiasten.

Die Leistung dürfte noch einmal 20-25%(Shader, 192-Bit Interface) geringer sein als bei der 3060Ti.

Das ist quasi eine 2070(evtl. Super). Da ist nur noch vernünftiges FullHD möglich. Da braucht keiner 4K Texturen.

Die RX5700 XT 16G war für Video-Schnitt und Bildbearbeitung gedacht.

Die RTX 3060 12G könnte in diesem Bereich natürlich punkten, ist aber eigentlich nicht die Zielgruppe.

Nur der Preis wird mit den 12GB evtl. zu hoch.

Da wird irgendwie kein Schuh draus, egal wie man es dreht und wendet...

@Matthias80

Das Namensschema steht noch nicht fest und das ist mir auch egal. Wer technische Produkte nach Namen kauft, ohne sich mit P/L zu beschäftigen, handelt in Eigenverantwortung.

@sly123

Das kann man so und so sehen. Es gibt auch Leute, die 4k Texturmods laden und auf 1080p spielen. Die Texturen verbessern sich dann zwar nur, wenn man sie aus der Nähe betrachtet, aber Enthusiast zu sein, bedeutet nicht unbedingt sich auch einen guten PC leisten zu können, sondern oft auch, aus der vorhandenen Hardware das Optimum herauszuholen. Es handelt sich da auch öfter um ältere Spiele wie Skyrim, Bethesda ist ja dafür bekannt, einen Sandbox Editor zur Verfügung zu stellen.

Wie die Rtx 3060 12GB vermarktet wird, ist das eine, der Kunde das andere, unbekannte Wesen. Anwender mit schmalem Geldbeutel werden die Karte mögen und mit etwas Glück kommt da noch eine mobile Variante.

Grundsätzlich finde ich es gut, das nVidia anfängt, seine Karten mit einfacher und doppelter VRam Bestückung anzubieten und es dem Kunden zu überlassen, sich zu entscheiden. Mich hat die vergleichsweise geringe Speicherausstattung immer gestört. Nun bekommt man über die ganze Produktpalette die Wahl.

Das Namensschema steht noch nicht fest und das ist mir auch egal. Wer technische Produkte nach Namen kauft, ohne sich mit P/L zu beschäftigen, handelt in Eigenverantwortung.

@sly123

Das kann man so und so sehen. Es gibt auch Leute, die 4k Texturmods laden und auf 1080p spielen. Die Texturen verbessern sich dann zwar nur, wenn man sie aus der Nähe betrachtet, aber Enthusiast zu sein, bedeutet nicht unbedingt sich auch einen guten PC leisten zu können, sondern oft auch, aus der vorhandenen Hardware das Optimum herauszuholen. Es handelt sich da auch öfter um ältere Spiele wie Skyrim, Bethesda ist ja dafür bekannt, einen Sandbox Editor zur Verfügung zu stellen.

Wie die Rtx 3060 12GB vermarktet wird, ist das eine, der Kunde das andere, unbekannte Wesen. Anwender mit schmalem Geldbeutel werden die Karte mögen und mit etwas Glück kommt da noch eine mobile Variante.

Grundsätzlich finde ich es gut, das nVidia anfängt, seine Karten mit einfacher und doppelter VRam Bestückung anzubieten und es dem Kunden zu überlassen, sich zu entscheiden. Mich hat die vergleichsweise geringe Speicherausstattung immer gestört. Nun bekommt man über die ganze Produktpalette die Wahl.

Zuletzt bearbeitet

: