Igor schreibt hier sicherlich nicht ohne Grund: "

Geht man auf Ultra-HD, dann sieht man erstaunliche Dinge, denn die Radeon RX 6800XT fällt auch ohne SAM hinter eine GeForce RTX 3080 FE zurück." Das habe ich einfach mal unvalidiert übernommen, da ich bspw. in diesem Jahr durchgehend den Eindruck hatte (

zumindest bei dem was ich von ihm gelesen habe), dass er hier immer faktenbasiert argumentiert und wohlüberlegt schreibt.

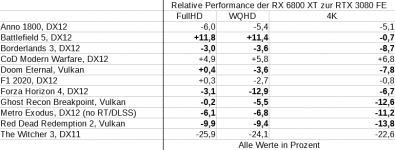

Ich habe mir aber zusätzlich dann doch noch mal einige PCGH-Ergebnisse hinzugenommen, die hier in mehreren Auflösungen mit maximalen Settings vermaßen und da zeigte sich folgendes bei den Titeln (

die ich rein zufällig rausgepickt habe, weil ich nicht alles "abschreiben" wollte):

Anhang anzeigen 8596

Wie zu sehen ist, passiert es relativ häufig, dass bei der RDNA2-Karte der Abstand zur Konkurrenz bei höheren Auflösungen größer wird. Bei den fettmarkierten Titeln verliert die Karte deutlich ggü. FullHD und stellenweise selbst ggü. WQHD, bei den übrigen Titeln bleibt das Leistungsverhältnis zur RTX 3080 dagegen relativ stabil. Vermutlich beobachtete Igor auch entsprechendes in seinen Tests und kam daher zu einer derartigen Aussage.

Und diese ließe sich bspw. durch eine schlechtere Hitrate des IC bei hohen Auflösungen erklären (

die ZRUF ins Spiel brachte), der für eine hohe Speicherbandbreite unverzichtbar ist, da das SI auf gerade mal 256 Bit eingedampft wurde und damit auf lediglich 448 GiB/s.

Zu HBM: Vergleichbares erklärte ich ja bereits zuvor. Ich erwähnte das nur, weil es immer wieder Gesellen gibt, die noch die Hoffnung hegen, dass AMD doch noch den "

ultimativen nVidia-Killer" auspacken wird. Und den könnte AMD selbstredend auch etwas später bringen, denn die müssen keinesfalls gleich vorweg "mit dem Kopf durch die Wand" (

und haben nicht umsonst mindestens so geheimniskrämerisch wie nVidia getan wärend der Entwicklung ggü. den Boardpartnern). nVidia hat sich hier auch Zeit gelassen und vorerst auf das erste Release von AMD gewartet, was schlicht vertriebsstrategische Gründe hat.

Darüber hinaus machen HBM und der IC zusammen keinen Sinn und deshalb schrieb ich ja bereits zuvor explizit "

HBM2-Variante (ohne IC)", denn der IC kostet beträchtliche Wafer-Fläche und würde in einem HBM-Design nur noch einen sehr geringen Mehrwert bieten, insbesondere bei hohen Auflösungen, wie es nun scheint, wo die Hitrate beträchtlich niedriger zu liegen scheint gemäß der bereitgestellten Werte von ZRUF, d. h. selbst Latenzvorteile würden sich hier weitestgehend nivellieren.

AMD hat zurzeit schlicht nicht den Marktanteil und die Akzeptanz um die zusätzlichen Kosten für ein derartiges Produkt zu rechtfertigen, auch wenn sich einige AMD-Fans das sehnlichst herbeiwünschen (zumal einige dem HBM gar stellenweise mystische Fähigkeiten anzudichten scheinen.

). Dabei übersehen diese Fans jedoch, dass ein derartiges Produkt nur einen extrem kleinen Teil des Marktes bedienen würden und da AMD hier primär höhere Margen, mehr Gewinn und Wachstrum anstrebt, wäre das vorschnelle In-den-Markt-bringen eines derartigen Produktes schlicht kontraproduktiv für ihre geschäftliche Entwicklung.