@Casi030 Hier hat der User wohl einfach nicht verstanden, dass Referenzkarten und Custom Karten unterschiedliche Verbräuche haben.

Das was AMD dort in dem Twitter Post angegeben hat, ist klar die TBP und nicht das, wass dir HWInfo ausgibt.(wobei sie hier bei der 6800XT gelogen haben, die hat 300W und nicht 280W, die restlichen Karten passen aber alle)

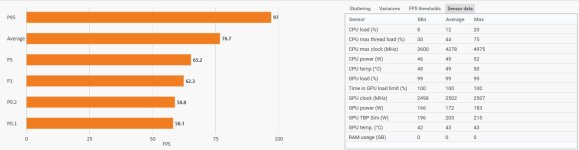

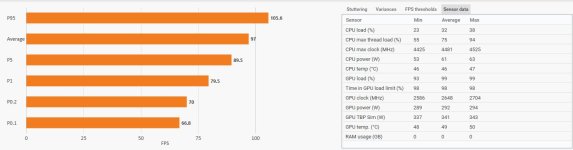

Das liegt bei der 6950XT bei 335W, die TGP sollte somit irgendwo bei 280W liegen.

Das was Igor hier gemessen hat, war ein Custom Design, natürlich verbraucht dieses auch deutlich mehr.

Und ich habe auch noch kein Review gesehen, bei dem die TGP als TDP genutzt wurde. Oder man verlinke mir ein einen Test eines namenhaften Reviewers, in dem steht, dass die 6900XT 255W verbraucht.

Und auch der zweite User hat es nicht verstanden. Wenn er sich ne 6900XT gekauft hat, die mit 300W TBP angegeben ist, dann verbraucht diese auch 300W und nicht +30% mehr, denn dass sich diese +30% auf die Differenz zwischen dem was der Treiber ausgibt und dem Kartenverbrauch beziehen, ist im Artikel mehr als deutlich beschrieben.

Eben nicht. Das beste was man tun kann ist, einen annähernd passenden Wert zusammenzurechnen, der mal passen kann, aber mal auch nicht.

Siehe unsere Formel. Die passt ganz gut für Karten unterhalb der 250W TGP.

Wenn ich mir Igors Testkarte nehme mit 330W TGP, dann kämen wir mit der Formel nur bei 385W raus und nicht bei über 400W, weil wir mit der Formel darauf bedacht waren, den Standardbereich von 50-250W TGP möglichst genau abzudecken. Wenn wir so eine 330W TGP Karte mit unserer Formel kompatibel machen würden, dann würde sie für alle Karten mit 200W oder weniger deutlich zu hohe Werte ausgeben.

Du bräuchtest also im Grunde, wenn du es genau haben möchtest, für jedes einzelne Modell eine eigene Formel und selbst die kann nicht alle Einflüsse abdecken, die die TBP verändern könnten.

Und wenn ich gerade im Spiel bin und im Overlay meinen GPU Verbrauch sehen möchte, soll ich mir dann immer den Taschenrechner auf den Tisch legen und umrechnen?

Bei Nvidia ist das kein Problem, die bessere Frage ist also warum nicht einfach den kompletten Kartenverbrauch auslesen, statt rechnen zu müssen?