@Victorbush in der Regel entfernt man die Treiber mit allem drum und dran, bevor man die Hardware tauscht.

Würde dir empfehlen, dass einfach nachzuholen. Wen mit was auch immer du noch hast und dann das frischste von der amd.com Seite ziehen.

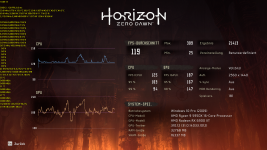

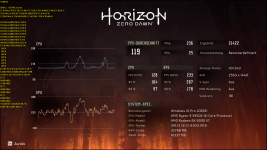

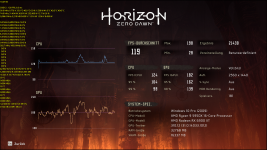

Was den Rest des Gejammeres angeht, meine 6900XT läuft gerne mal mit 120~140W in 4K im 90FPS Limit. Im 160~180W fürs 120FPS Limit. Full Power (2.7ghz Timings Fast) packt sie noch im 230W Korsett. Kann mich nicht beklagen.

Hab im Grunde 3 Profile: Desktop, welches ebenfalls die einfacheren Titel mehr als ausreicht (1,8ghz), ein Effiziensprofil (2,25ghz) und Vollgas (2,7ghz).

Paar Watt müsste man natürlich noch drauflegen für das Drumherum, aber da geht schon einiges

RDNA2 war schon ordentlich.