RX480

Urgestein

- Mitglied seit

- Feb 13, 2020

- Beiträge

- 1.883

- Bewertungspunkte

- 873

- Punkte

- 114

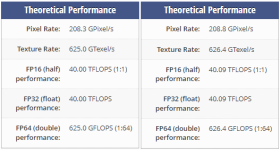

Eher wäre dann die 4080-16 effizient.

aber auch viiiel zu teuer

Die Leute, die sagen das nur die 4090 nen realen Preis hat, haben wohl Recht.(zumindestens die Ex. für 1950€)

Daher dürfte ne 4080-12 nur die Hälfte der 4090 kosten.

aber auch viiiel zu teuer

Die Leute, die sagen das nur die 4090 nen realen Preis hat, haben wohl Recht.(zumindestens die Ex. für 1950€)

Daher dürfte ne 4080-12 nur die Hälfte der 4090 kosten.