IloveTattoo

Veteran

- Mitglied seit

- Feb 21, 2019

- Beiträge

- 222

- Bewertungspunkte

- 129

- Punkte

- 44

Hält sie auch nicht . Den zu dem Powerlimit , kommt ontop Soc und Speicher .

Das mag bei nVidia der Fall sein,bei AMD ist es mit drin.Keine Ahnung was Du da für ein Mist misst.Hält sie auch nicht . Den zu dem Powerlimit , kommt ontop Soc und Speicher .

Dann belege das mal,@RX480 hat es im Beitrag #57 schon gemacht.Nein ist es nicht . Vielleicht solltest Du dich mal richtig schlau machen. Und das sagt jetzt nicht ein Nv Fanboy sondern ein Amd Only System User

Ich weiß nicht wie du darauf kommst, aber das ist schlicht falsch. Die ASIC beinhaltet GPU+SOC+Speicher.Nein ist es nicht . Vielleicht solltest Du dich mal richtig schlau machen. Und das sagt jetzt nicht ein Nv Fanboy sondern ein Amd Only System User

Die Ref scheint ja mal wieder sehr gelungen zu sein.btw.

Neues Review bei TPU mit der 6950ref.@350W:

AMD Radeon RX 6950 XT Reference Design Review

The AMD Radeon RX 6950 XT Reference Design card not only looks great, but also achieves excellent performance, matching the GeForce RTX 3090, but at much better pricing. Because of good optimization and surprisingly good energy efficiency, AMD's thermal solution works very well, too.www.techpowerup.com

Ich würde mir mal noch wünschen, das die Reviewer die ASIC-qualität der jeweiligen Samples zeigen!

(net das Igor ne Gurke<85% hat und TPU ein Nugget>87%)

Was hast Du dann bei der Messung hier im Launchreview gemacht?

Das war eine 2min Einzelmessung! (so gibts auch nen vernünftigen avg. Verbrauch am NT ohne Spikes, die über Kondensatoren gehen)

man kann sich natürlich auch nen Spike-20ms-Bereich rausgreifen, wo dann durch Spikes die Werte viel zu hoch sind, ... ist halt dem

"schlechteren" Regeln bei AMD geschuldet, aber zeigt net wirklich den Durchschnitt an der Steckdose sondern nur die Belastung der

Kondensatoren am NT

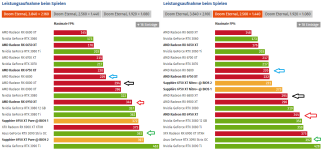

Dann gibts bei besonders schlechten Samples kuriose Werte, wie bei der 6900 von TPU: siehe Anhang 2

1000 ms / 40 = 25. Wie wollen die damit bitte 20 ms Spikes messen? Das ist schon theoretisch komplett unmöglich. Außerdem misst man IMMER mit der höchstmöglichen Auflösung und rechnet dann runter, um Fehler auszuschließen. Bei den 20 ms Schritten messe ich über 2 Minuten mit 500 Samples pro Sekunde und bilde dort einen RMS Mittelwert."With 40 samples per second"

Da AMD diesmal für den Launch auf Boardpartner-Karten setzt, habe ich natürlich sowohl für die entsprechenden AMD- als auch die NVIDIA-Karten auf MSIs Gaming-X- bzw. SUPRIM-X-Reihe zurückgegriffen, um vor allem beim Vergleich zwischen Alt und Neu einen fairen Vergleich rein mit Boardpartnerkarten eines Herstellers zu garantieren. Denn alle Karten kommen auch mit einer gehörigen Portion Werks-OC zum Kunden und es wäre nur unfair, hier die langsameren (und auch sparsameren) Referenzkarten zu nutzen.

Synthetics, machen keinen Sinn, weil sie zu Fokussiert sind.ich teste keine Synthetics wo sich die Hersteller die Eier blutig optimieren. Spiele ja, aber nicht sowas