Was ist grün und kann vor Kraft kaum laufen? Der Hulk der Pixel-geprägten Neuzeit heißt GeForce RTX 4090 und macht vor allem auch durch sein hochenergetisches Auftreten seit Wochen, ja Monaten schon, ordentlich von sich reden. Und wo der Hulk einmal zuschlägt, da wächst auch kein Gras mehr und der Strom fließt plötzlich (dank DLSS (read full article...)

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Internetseiten nicht korrekt angezeigt werden.

Du solltest ein Update durchführen oder einen alternativen Browser verwenden.

Du solltest ein Update durchführen oder einen alternativen Browser verwenden.

Grüne Sonntagsgedanken: Ein doppeltes Lottchen aus den 80ern und dahinschmelzende Stecker

- Themenstarter Redaktion

- Beginndatum

Wenn man die Shaderanteile prozentual mit der 3000er Reihe vergleicht und jeweils von der xx90 als 100% ausgeht, ist die 4080 16GB genau genommen eine 4070 Ti und die 4080 12GB eine 4060 Ti.

Hat schon ein starkes Gschmäckle diese Gen.

Die 4090 finde ich preislich im Vergleich zur 3090 bei Launch sogar noch ok für die vermutlich gebotene Leistung. Allerdings sind für mich mittlerweile beide 4080er Modelle Mogelpackungen. Speziell aber die 12 GB Version suggeriert dem Kunden hier eine Leistungsklasse, welcher die Karte aber nicht angehört.

Hier tragen sicherlich die nach wie vor hohen Lagerbestände der 3000er Reihe ihren Teil dazu bei. Wie du richtig schreibst Igor, hätte man für eine xx70 sicherlich keinen vierstelligen Betrag rechtfertigen können. Hätte man allerdings eine 4070 für für weniger Geld gebracht, wären die alten Karten (wie die 3080, 3080 Ti) in den Regalen liegen geblieben. Richtige Abverkäufe gibt es ja sowieso nicht mehr.

Ich habe ja mittlerweile die Theorie, dass es gar keine kleineren 4000er Karten mehr geben wird und die 3000er Gen bis zur 3080 rauf über die gesamte 4000er Reihe als Einsteiger- und Mittelklasse mitlaufen wird.

LG Manu

Hat schon ein starkes Gschmäckle diese Gen.

Die 4090 finde ich preislich im Vergleich zur 3090 bei Launch sogar noch ok für die vermutlich gebotene Leistung. Allerdings sind für mich mittlerweile beide 4080er Modelle Mogelpackungen. Speziell aber die 12 GB Version suggeriert dem Kunden hier eine Leistungsklasse, welcher die Karte aber nicht angehört.

Hier tragen sicherlich die nach wie vor hohen Lagerbestände der 3000er Reihe ihren Teil dazu bei. Wie du richtig schreibst Igor, hätte man für eine xx70 sicherlich keinen vierstelligen Betrag rechtfertigen können. Hätte man allerdings eine 4070 für für weniger Geld gebracht, wären die alten Karten (wie die 3080, 3080 Ti) in den Regalen liegen geblieben. Richtige Abverkäufe gibt es ja sowieso nicht mehr.

Ich habe ja mittlerweile die Theorie, dass es gar keine kleineren 4000er Karten mehr geben wird und die 3000er Gen bis zur 3080 rauf über die gesamte 4000er Reihe als Einsteiger- und Mittelklasse mitlaufen wird.

LG Manu

ipat66

Urgestein

- Mitglied seit

- Sep 16, 2019

- Beiträge

- 1.357

- Bewertungspunkte

- 1.355

- Punkte

- 115

Da war ich doch auf der Suche nach « meinen » lustigen Bildern und fand « nur » Deinen Text.

Bei den vielen Metaphern und Vergleichen,musste ich dann doch einige Male herzlich grinsen und lachen.

Danke Igor für die nette Begleitung meines morgendlichen Milchkaffees und den Start in diesen Sonntag.

Technik-Prosa vom Feinsten !

Bei den vielen Metaphern und Vergleichen,musste ich dann doch einige Male herzlich grinsen und lachen.

Danke Igor für die nette Begleitung meines morgendlichen Milchkaffees und den Start in diesen Sonntag.

Technik-Prosa vom Feinsten !

DrWandel

Mitglied

- Mitglied seit

- Jul 12, 2021

- Beiträge

- 80

- Bewertungspunkte

- 61

- Punkte

- 17

Danke für den Kommentar! Ist sicher angebracht, und mir graut auch vor den Preisen und dem Stromverbrauch der neuesten Nvidia-Generation. Was die Namensgebung anbelangt, ist mir das ziemlich egal, Hauptsache die Daten passen. Ich werde die Tests und Reviews auf mich zukommen lassen, und ich vermute mehr Potential bei der kommenden AMD-Generation, zumindest in dem (Preis-/Leistungs-/Stromverbrauchs-) Bereich, der mir als Ersatz für meine jetzt fünf Jahre alte 1080 vorschwebt. Ich kann warten; abwarten und Tee trinken.

Wobei man auch ehrlich sein muss und festellen, dass da eher die 3080 der Ausreisser war.Wenn man die Shaderanteile prozentual mit der 3000er Reihe vergleicht und jeweils von der xx90 als 100% ausgeht, ist die 4080 16GB genau genommen eine 4070 Ti und die 4080 12GB eine 4060 Ti.

Hat schon ein starkes Gschmäckle diese Gen.

Die echte 4080 (16 G) reiht sich mit ihren 59% zur 4090 etwa gleich ein, wie die 2080 (67%) und 1080 (71%) zur jeweiligen Titan.

Nur vom Preis her fehlt jeder historische Präzedenzfall für die aktuelle Generation...

Edit: hatte bei der 4080 den falschen Wert verglichen...

Zuletzt bearbeitet

:

Thy

Urgestein

- Mitglied seit

- Jul 23, 2018

- Beiträge

- 1.843

- Bewertungspunkte

- 744

- Punkte

- 115

- Alter

- 46

- Standort

- Bergstraße

Danke für das erheiternde Pamphlet, was die Forendiskussionen treffend zusammen fasst. Eine Frage, die du hoffentlich in Zukunft beantworten wirst, ist, wie es sich aus der letzten Reihe sieht.

Ocastiâ

Veteran

- Mitglied seit

- Apr 20, 2022

- Beiträge

- 106

- Bewertungspunkte

- 49

- Punkte

- 28

Oha das ist heute ja sehr poetisch geworden.

Meine frage ist jetzt natürlich: ist das alles spekulatius oder weisst du schon etwas was wir nicht wissen?

Die 4080 12gb finde ich auch unverschämt, eigentlich kann ich da nur auf eine ordentliche 4080ti hoffen, oder AMD schafft es Nvida die Butter vom brot zu klauen, damit rechne ich aber eher nicht, auch wenn ich es begrüssen würde.

verdammt hätte ich nur damals eine 2080ti gekauft anstatt meiner 2070, dann würde ich jetzt zufrieden in 4k spielen anstatt in so einer scheiss situation zu stecken, Ampere wollte ich ja sowieso überspringen weil ich es irgendwie bescheuert finde innerhalb von einer generation aufzurüsten, aber das ist echt scheisse.

PS: ich fänd es super wenn du >300W GPU's noch auf 300W gedrosselt testest, diesen wahnsinns verbrauch will ja keiner wegkühlen.

Meine frage ist jetzt natürlich: ist das alles spekulatius oder weisst du schon etwas was wir nicht wissen?

Die 4080 12gb finde ich auch unverschämt, eigentlich kann ich da nur auf eine ordentliche 4080ti hoffen, oder AMD schafft es Nvida die Butter vom brot zu klauen, damit rechne ich aber eher nicht, auch wenn ich es begrüssen würde.

verdammt hätte ich nur damals eine 2080ti gekauft anstatt meiner 2070, dann würde ich jetzt zufrieden in 4k spielen anstatt in so einer scheiss situation zu stecken, Ampere wollte ich ja sowieso überspringen weil ich es irgendwie bescheuert finde innerhalb von einer generation aufzurüsten, aber das ist echt scheisse.

PS: ich fänd es super wenn du >300W GPU's noch auf 300W gedrosselt testest, diesen wahnsinns verbrauch will ja keiner wegkühlen.

Thy

Urgestein

- Mitglied seit

- Jul 23, 2018

- Beiträge

- 1.843

- Bewertungspunkte

- 744

- Punkte

- 115

- Alter

- 46

- Standort

- Bergstraße

1080 hatte 67% der ALUs vom Vollausbau (Titan X), 2080 hatte 64% der ALUs von Titan RTX, 3080 sogar 80%. Und nun: 4080 (16 G) hat nur 53% vom Vollausbau AD102 (ich vergleiche hier explizit nicht mit 4090, was 59% entsprechen würde, da Äpfel und Birnen nicht zusammen passen).Die echte 4080 (16 G) reiht sich zur 4090 etwa gleich ein, wie die 2080 und 1080 zur jeweiligen Titan.

Richtig frech wird es bei der 12 G-Version der sogenannten 4080, die 41,67% des Vollausbaus entspricht, was mit dem bisherigen Klassifizierungsschema einfach nicht mehr übereinstimmt. Hier sehe ich schon das Problem, dass Viele eben nicht nachrechnen, sondern nur auf die Nummer hinter der 40 schauen und dann eine oder zwei Klassen schlechter kaufen (3060 Ti: 45% Vollausbau oder 2060 mit exakt 41,67%, also dem gleichen Verhältnis wie 4080 (12 G) zu AD102).

Zuletzt bearbeitet

:

Den Monsterkühler, der bei mir etwa mit seinem dicken Hintern drei PCIe Slots besetzen würde, hat man leider trotzdem an der Backe.PS: ich fänd es super wenn du >300W GPU's noch auf 300W gedrosselt testest, diesen wahnsinns verbrauch will ja keiner wegkühlen.

Vernunft zieht leider nur bei den Workstation-Karten ein.

Bei dem Stecker bin ich ja mal gespannt. Wobei mein Netzteil das schaffen sollte mit Adapter bzw. mit Cablemod 4x8-Pin zu 12 Pin. Gestern kam ja bereits das Video von JayzTwoCents dazu. Er hat ja auch gewünscht ein größeren Stecker zu nutzen, anstatt die kleinen Pins. Wir reden hier von 600W Nennleistung. Peak ist ja evtl noch etwas zu vernachlässigen, da im ms bereich vermutlich kaum zusätzliche Wärmeentwicklung.

Aber kann mich bitte jemand aufklären worum es morgen Nachmittag geht? Dieses Jahr steige ich irgendwie überhaupt nicht durch wann die Test Embargos fallen?! Ryzen (ein Tag vor Release) oder NVIDIA 4090?

Aber kann mich bitte jemand aufklären worum es morgen Nachmittag geht? Dieses Jahr steige ich irgendwie überhaupt nicht durch wann die Test Embargos fallen?! Ryzen (ein Tag vor Release) oder NVIDIA 4090?

Das mit den Steckzyklen ist aus meiner Sicht relativ normal. Dennoch bin ich nicht glücklich mit diesen Steckverbindern. Es gibt z. B. Steckverbinder mit Verriegelungshebel von TE.

Obendrein sehe ich nach wie vor ein Problem mit der Absicherung der einzelnen Leitungen. Mich wundert es ehrlich gesagt sogar, dass das nach wie vor toleriert wird.

Obendrein sehe ich nach wie vor ein Problem mit der Absicherung der einzelnen Leitungen. Mich wundert es ehrlich gesagt sogar, dass das nach wie vor toleriert wird.

- Mitglied seit

- Jun 1, 2018

- Beiträge

- 10.198

- Bewertungspunkte

- 18.814

- Punkte

- 114

- Alter

- 59

- Standort

- Labor

Wobei man auch ehrlich sein muss und festellen, dass da eher die 3080 der Ausreisser war.

Die echte 4080 (16 G) reiht sich mit ihren 67% zur 4090 etwa gleich ein, wie die 2080 (67%) und 1080 (71%) zur jeweiligen Titan.

Nur vom Preis her fehlt jeder historische Präzedenzfall für die aktuelle Generation....

Die 4080 16 GB liegt aber bei 59% der 4090. Die 4080 12 GB bei 48% der 4090. Wie gesagt, alles shaderseitig, natürlich gibts noch andere Performanceindikatoren.

Bei der 1000er und 2000er gabs ja keine xx90er zum Vergleich.

Aber selbst wenn man hier den Vergleich zum Vollausbau der jeweiligen Titans zieht, kommt man bei der 2080 auf 64% und bei der 1080 auf 67%. Also prozentual bereits mehr, als bei der 4080.

Geht man jetz von den kolpotierten 18.432 Shadern des Lovelace-Vollausbaus aus, wärn wir bei der 4080 16GB gar nur bei 53% und bei der 4080 12 GB bei 42% zum Vollausbau. Das ist schon extrem krass.

Deswegen ist der Abstand zwischen 4090 und 4080 16 GB auch so riesig. Eine 4080 Ti sollte ja gesetzt sein, aber selbst da ist noch locker Platz für weitere Super-Varianten der jeweiligen Karte.

Überteuert sind alle Karten, da brauchen wir nicht drüber reden. Die beiden 4080er finde ich hier aber einfach dreist. Die 4090 kann ich noch so halbwegs nachvollziehen, zumindest im Vergleich zu den Preisen der 3000er.

- Mitglied seit

- Jun 1, 2018

- Beiträge

- 10.198

- Bewertungspunkte

- 18.814

- Punkte

- 114

- Alter

- 59

- Standort

- Labor

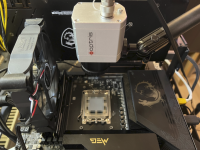

BTW: Das Motherboard ist von DEW

Thy

Urgestein

- Mitglied seit

- Jul 23, 2018

- Beiträge

- 1.843

- Bewertungspunkte

- 744

- Punkte

- 115

- Alter

- 46

- Standort

- Bergstraße

Würde mich nicht wundern, wenn eine 4080 Ti (12 G) und eine 4080 Ti (16 G) nachgeschoben würden. Platz genug wäre ja.

Was mich ein wenig wundert, ist der relativ große Abstand von 4090 zum Vollausbau (unter 89%). Zum Vergleich: 3090 (98%) und 2080 Ti (94%). Ausbeuteprobleme?

Was mich ein wenig wundert, ist der relativ große Abstand von 4090 zum Vollausbau (unter 89%). Zum Vergleich: 3090 (98%) und 2080 Ti (94%). Ausbeuteprobleme?

Natürlich! Hat jeder sofort am Hersteller Typischen DEW Drachen erkanntBTW: Das Motherboard ist von DEW

Chismon

Veteran

- Mitglied seit

- Dez 27, 2020

- Beiträge

- 131

- Bewertungspunkte

- 93

- Punkte

- 28

Das sehe ich ähnlich, der Probelauf für solch massive Preiserhöhungen war aber nicht Ampere, sondern die Preiserhöhung von Pascal auf Turing (insbesondere von der GTX 1080Ti zur RTX 2080Ti), die damals jede Menge Leute (Gamer, nicht Kryptominer) mitgemacht haben und wohl auch weil diese gehyped waren, auch wenn RT-Raytracing in Erstgeneration auch bei einer RTX 2080Ti noch durchwachsen/rudimentär war (natürlich auch mangels Spieletiteln noch lange nach Marktstart).Die 4090 finde ich preislich im Vergleich zur 3090 bei Launch sogar noch ok für die vermutlich gebotene Leistung. Allerdings sind für mich mittlerweile beide 4080er Modelle Mogelpackungen.

So gesehen hat man sich darauf vielleicht zurück besinnt und testet jetzt eine Stufe niedriger (in den non-Ti 80er Serie), wie viel dort monetär möglich ist (nachdem man schon kräftig am letzten Miningboom verdient hat, vor lauter Gier sich aber die Lagerhäuser voll gemacht hat, wofür jetzt die vorher als Konsumenten eher irgnorierten Gamer für die alte Restware als Abnehmer einspringen sollen).

Meine Entscheidung steht eigentlich schon fest und die kommende Grafikkarte wird aus Prinzip keine von nVidia werden, auch wenn die Produktdaten - besonders bei der RTX 4090 - durchaus beeindruckend sind, aber mir ist der Laden mittlerweile viel zu abgehoben und selbst wenn AMD/RTG wie in den vergangenen Jahren sich an den Preisen nVidas orientiert und Trittbrett fährt, ist mir das immer noch lieber als Jen-Hsuns Lederjackenkollektion mitzufinanzieren und durch mein Kaufverhalten kein Zeichen zu setzen (dass ein gesundes Maß bei Gaming-Grafikkartenpreisen längst überschritten ist und immer mehr Leute abspringen).

Es bleibt die Hoffnung, dass AMD/RTG mit einer RX 7800(XT) Kampfpreise fahren könnte, um massiv nVidia Marktanteile im Gaming-GPU-Markt abzunehmen, zumal die Lagerbestände alter Karten deutlich kleiner als bei nVidia (die bisher auch meist weniger die Preise abgesenkt haben) sein dürften, die Produktionskosten von RDNA3 geringer als bei Ada Lovelace sind basierend auf Fertigungskosten/Node und Architektur und es eben schon deutlich niedrigeres Preisgefüge (mit dem RX 6950XT Spitzenmodell knapp über 900 Euro) gibt, so dass eine High-End/Navi 31 Einsteigerkarte ab 850 Euro realistisch sein könnte ohne den weiteren Abverkauf älterer RDNA2 Lagerbestände damit zu konterkarieren.

Nur, ob AMD/RTG das auch machen werden, das steht in den Sternen und ich bin da auch eher pessimistisch, lasse mich aber gerne überraschen (was nicht heisst, dass ich zum Marktstart dann gleich eine RX 7800(XT) für ca. 850 Euro ordern würde, zumal die Karten zu dem Preis wahrscheinlich weltweit ratzfatz ausverkauft wären (durch Bots/Scalper, usw.) mit kaum einer Chance für normale Käufer wie meine Wenigkeit

Auch bei der 4090 hat Nvidia in seiner Umnenennungswut nicht Halt gemacht.Die 4090 finde ich preislich im Vergleich zur 3090 bei Launch sogar noch ok für die vermutlich gebotene Leistung. Allerdings sind für mich mittlerweile beide 4080er Modelle Mogelpackungen. Speziell aber die 12 GB Version suggeriert dem Kunden hier eine Leistungsklasse, welcher die Karte aber nicht angehört.

So beschnitten wie die 4090 ist kann man sie lediglich mit einer (angeblich) 700$ 3080 vergleichen. So gesehen hat diese dieselbe Preisverdopplung erfahren wie von 3070 auf 4080 16GB und von 3060 Ti auf 4080 12GB.

HerrRossi

Urgestein

- Mitglied seit

- Jul 25, 2018

- Beiträge

- 6.778

- Bewertungspunkte

- 2.243

- Punkte

- 113

Zwischen 4080 16GB und 4090 sehe ich noch Platz für zwei Modelle: 4080 Super mit ca. 11.000 Shadern und 4080 ti mit ca. 14.500 Shadern, beide mit AD102, sobald der Yield stimmt und Nvidia ausreichend binnen kann. Am Speicherinterface kann Nvidia auch noch basteln, die 4080S könnte 320 Bit wie die 3080 bekommen, die 4080 ti 352 Bit, so wie die 2080 ti.