Casi030

Urgestein

- Mitglied seit

- Sep 9, 2019

- Beiträge

- 11.923

- Bewertungspunkte

- 2.338

- Punkte

- 113

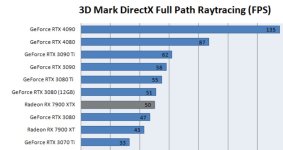

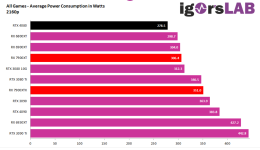

Nur sind die Custom wieder Übertaktet und schneller womit die 4080 dann auch wieder langsamer wird.Da muss man dann wieder Rechnen welche Karte mehr FPS pro EU hat.Klar, wenn die 4080 noch günstiger wird und auf einem Niveau mit Customkarten der 7900XTX liegt - dann hat nVidia die Nase vorn, das muss man einfach auch zugeben können. Zumindest, wenn man RT nutzen will.

Und die Custom-Designs dürften schon 100-200 € über dem Referenzdesign liegen und dann ist man schon bei mindestens 1250 €, da ist eine 4080 im Custom-Design mit (aktuell) 1350 € dann nicht mehr so weit weg, wenn sie noch billiger wird ohnehin nicht.