Martin Gut

Urgestein

- Mitglied seit

- Sep 5, 2020

- Beiträge

- 7.833

- Bewertungspunkte

- 3.605

- Punkte

- 113

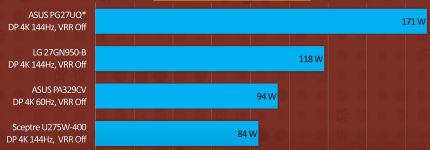

Ich ärgere mich schon, dass meine GTX 1650 Super mit 2 Bildschirmen im Idle 30 Watt statt 7 Watt versäuft. Wenn ich da die Werte dieser neuen Karten höre, kann ich ja froh sein. Dank Intel-Prozessor konnte ich den zweiten Bildschirm an die interne Grafikeinheit hängen, die dafür nichts verbraucht.Erbärmlich ist leider (wieder) der schlechte idle+multi monitor+video playback Wattverbrauch, das ist kein Problem der neuen Karten, das ist ein Problem der gesamten Navi Reihe.

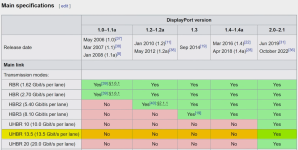

Ich hatte da etwas im Netz gesucht und festgestellt, dass das Problem da schon seit einigen Generationen bekannt war und Karten von AMD und Nvidia betroffen hat. Eine Lösung dafür scheint es aber nie richtig gegeben zu haben, ausser Basteln mit eigenen Bildschirmauflösungen und so. Es würde mich freuen, wenn die Hersteller sich mal richtig darum kümmern würden. Mehrere Bildschirme sind ja keine Seltenheit und die meiste Zeit laufen die meisten PCs im Idle. Also ist der Idle-verbrauch durchaus entscheidend.