Casi030

Urgestein

- Mitglied seit

- Sep 9, 2019

- Beiträge

- 11.923

- Bewertungspunkte

- 2.339

- Punkte

- 113

Das war ja auch nur ein Beispiel für einen Festen Wert.Das sind schon sehr seltene Werte, die es evtl. nur bei Air mit LM bei <<300W gibt!

95°C VR-Temp gäbe es ungefähr zusammen mit 90°C GPU-Edge, was selten geht, weil dann vorher schon der Hotspot abregelt.

Hab gerad mal Screens gesucht mit Luftkühlung und da war das MAX bei 65°C.

Dabei war aber auch noch Luft nach Oben.

Dann nimmt man feste 75°C.........Es geht ja um die Verluste bei hoher Temperatur und je Höher um so besser.

Wobei ich zwischen 45 und 55°C max auf 1-2Watt Unterschied komme.

Ich habe aber gerade noch mal genauer gemessen,Lüfter Aus bis auf an einem 240er Radi und die Fest auf sehr gering.

RGB aus.

Windows SSD und Spiele SSD gemessen,Abzüglich der höheren CPU Last waren min 7Watt und max 12Watt,somit hab ich mit 9Watt gerechnet fürs "Mainboard" unter Last.

Durch den Wasserblock brauchte ich die Lüfter und RGB nicht ausrechnen,so das ich Rein die Grafikkarte messen konnte für den Multi.

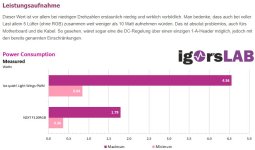

So sind dann TBP 296Watt raus gekommen und das macht Multi 1.165.

Dann zeigt mir HWinfo64 zwischen 230Watt und 294Watt zur TBP auch einen Unterschied von 10Watt an,es bleibt somit kein Fester Wert mit Änderung des PowerLimit.

Ich hab jetzt noch nie geschaut was Grafikkarten Lüfter brauchen,aber ich würde einfach mal sagen bei 100% je Lüfter 1,5W was dann bei 3 Lüftern 4,5W sind und in das Feld Hinzufügen kommt dann +5.

Damit würde TBP dann mit 301Watt angezeigt.

Einfache LED Logo Funzel würd mit 2Watt dazu kommen.

RGB.......Hmmmm um 8Watt?!

Somit würde MEINE PowerColor Radeon RX 6900 XT Red Devil mit 3 Lüftern und RGB auf ~TBP 309Watt kommen.

Zuletzt bearbeitet

: