Auch die ehrlichen Worte zum Preis und zu den Erwartungen der Preise von der Konkurrenz, waren sehr erfrischend. Natürlich möchte man schlechte Nachrichten nicht gerne hören und Schuld ist immer der Überbringer.

Das ist es eben.

Wenn man mal auf CB und Co die Kommentare verfolgt, wird oft auf dem "Abzockpreis" rumgeritten und gesagt, dass die Karte höchstens 499 oder 549€ wert sei.

Das passiert so häufig, dass man meinen könnte, es gebe zig verschiedene Konkurrenzprodukte mit vergleichbarer Leistung und ähnlichem Featureset für 25% weniger und Nvidia würden die Kunden in Scharen zur Konkurrenz weglaufen.

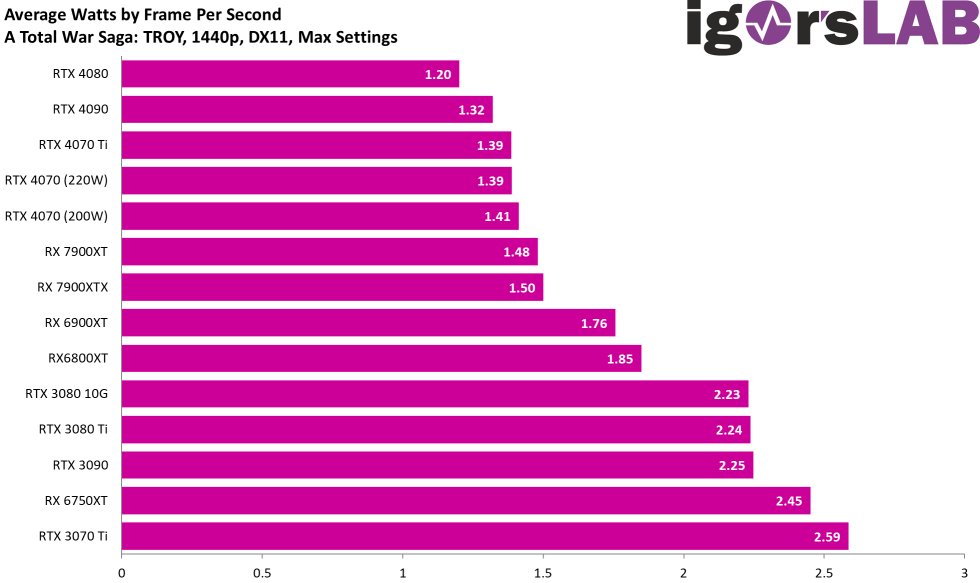

Stattdessen ist die Karte selbst gegen RDNA2 zu Abverkaufspreisen durchaus attraktiv. Ist die preisliche Entwicklung schön? Sicher nicht. Aber man sollte schon bei der Wahrheit bleiben.